|

СПЕЦІАЛЬНІ

ПАРТНЕРИ

ПРОЕКТУ

Определение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях

Кто внес наибольший вклад в развитие украинского ИТ-рынка.

Награды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары

|

|

6 февраля 2026 г., 19:41

Сьогоднішні дискусії про майбутнє телекомунікацій дедалі частіше зосереджуються на терагерцовому діапазоні, який обіцяє стати фундаментом для мереж шостого покоління. Проте перехід від теорії до практичного впровадження ТГц-технологій стикається з фундаментальними фізичними обмеженнями.

Традиційні мікросхеми у цьому частотному спектрі виявляються надзвичайно вразливими до найменших дефектів виробництва, а втрати енергії при вигинах хвилеводів роблять створення ефективних пристроїв складним та дорогим завданням. Розробка дослідників з Наньянського технологічного університету (Сінгапур) та Осакського університету (Японія) пропонує вихід із цього глухого кута за допомогою концепції топологічної ізоляції, реалізованої безпосередньо на кремнієвому чіпі.

Терагерцові хвилі (між мікрохвилями та інфрачервоним світлом) мають колосальну пропускну здатність, але вони надзвичайно примхливі. Традиційні хвилеводи та антени страждають від розсіювання сигналу на будь-яких нерівностях чи вигинах структури чіпа. Найменший дефект під час літографії перетворює високоефективний пристрій на «цеглину».

Тут на сцену виходить топологічна ізоляція — концепція, за яку у 2016 році було присуджено Нобелівську премію з фізики. Вона описує матеріали, що є ізоляторами всередині, але проводять енергію по своїх краях. Що найважливіше — цей рух є «топологічно захищеним»: хвиля огинає перешкоди та дефекти, не відбиваючись назад і не втрачаючи потужності.

Дослідники з Сінгапуру та Японії реалізували цей принцип на звичайній кремнієвій підкладці, що є критично важливим для комерціалізації (сумісність із CMOS-процесами).

На кремнієвій пластині витравлено масив гексагональних (шестикутних) отворів. Зміна розміру та розташування цих отворів створює межу між двома різними топологічними фазами. Електромагнітні хвилі ТГц-діапазону змушені рухатися суворо вздовж цієї межі. Навіть якщо шлях має гострі кути або виробничі дефекти, хвиля проходить крізь них без розсіювання.

Як зазначається, нова антена демонструє значно вищу спрямованість та нижчий рівень шуму порівняно зі стандартними рішеннями.

Під час експериментів чип продемонстрував здатність передавати дані на частоті 0,3 ТГц зі швидкістю 11 Гбіт/с. Це вже перевищує можливості більшості сучасних систем зв'язку, але автори стверджують, що це лише початок. Потенціал технології дозволяє досягти 1 Тбіт/с і вище.

Майбутні мережі стандарту 6G потребуватимуть саме таких стабільних ТГц-компонентів для забезпечення роботи голографічного зв'язку та систем доповненої реальності (AR) у реальному часі.

Технологія на базі нової розробки може бути використана для створення надшвидкісних ліній зв'язку всередині центрів обробки даних та між процесорами в суперкомп'ютерах, де традиційні мідні або навіть оптичні рішення стикаються з обмеженнями енергоефективності та щільності.

Топологічний захист дозволяє знизити вимоги до точності виготовлення чіпів, що потенційно зменшує відсоток браку та вартість кінцевих пристроїв.

23 января 2026 г., 19:02

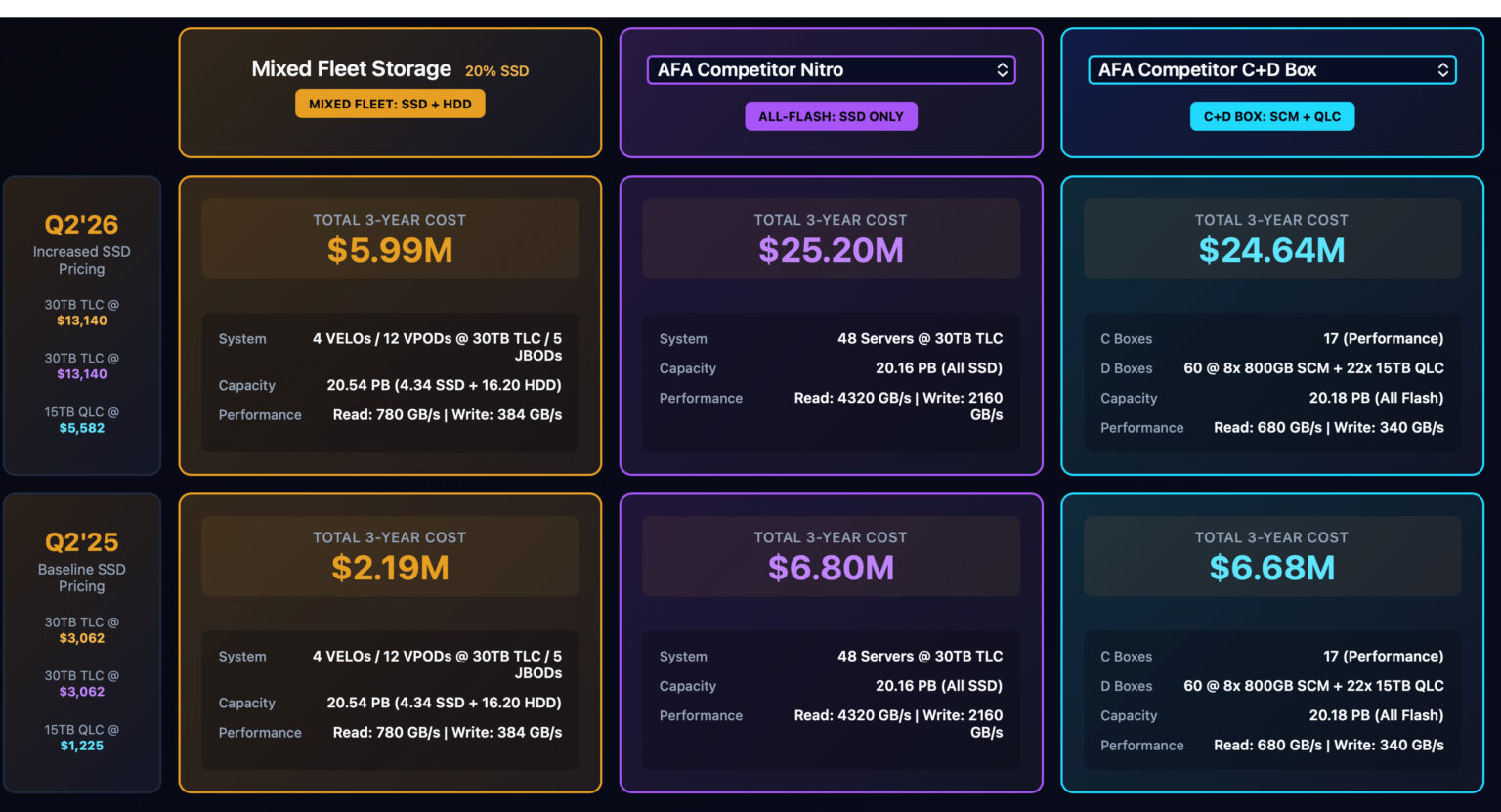

Пам’ятаєте прогнози про те, що SSD ось-ось остаточно «поховають» старі добрі жорсткі диски (HDD)? Схоже, ці похорони доведеться відкласти на невизначений термін.

Компанія VDURA, постачальник рішень для високопродуктивних обчислень (HPC) та AI, оприлюднила приголомшливі дані: ціновий розрив між SSD та HDD не просто зростає — він перетворився на справжню прірву.

Ось короткий розбір того, що відбувається на ринку пам’яті станом на початок 2026 року і чому ваші бюджети на залізо можуть «тріщати по швах».

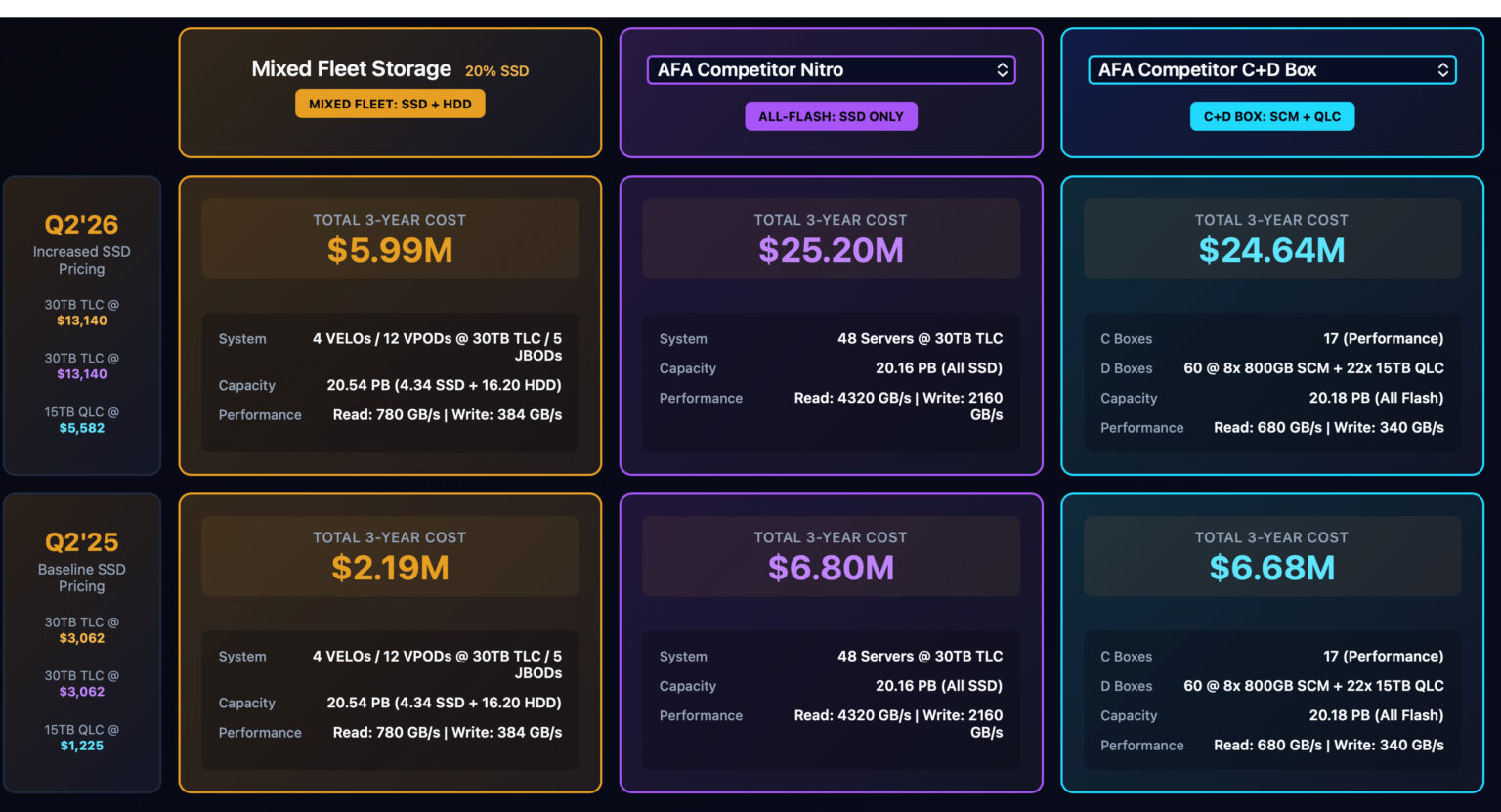

Згідно з новим звітом Flash Volatility Index (FVI) від VDURA, за період з другого кварталу 2025 року по перший квартал 2026-го ринок охопило справжнє божевілля:

Для корпоративних SSD (30 TB TLC) ціна злетіла на 257%! Якщо раніше такий диск коштував близько $3062, то тепер за нього просять $10950.

В той же час жорсткі диски (HDD) подолали цей шлях значно спокійніше — ціна зросла лише на 35%.

В результаті, якщо у 2025 році SSD був дорожчим за HDD у 6,2 раза, то сьогодні цей показник становить 16,4 раза. Економіка побудови сховищ «тільки на флеш-пам’яті» (all-flash) раптово стала фінансовим екстримом.

Ерік Сало, віцепрезидент VDURA, каже прямо: «Правила гри змінилися». Й на то є кілька причин дефіциту та космічних цін. По-перше, великі хмарні провайдери викупили левову частку виробничих потужностей SSD аж до кінця 2026 року. Крім того, нейромережі «пожирають» пам'ять у неймовірних масштабах. Це стосується не лише дисків: ціни на DRAM за той самий період підскочили на 205%. Та й швидкісні комутатори та адаптери також у дефіциті, що тягне вгору загальну вартість систем.

VDURA наводить показовий приклад: розгортання сховища на 25 ПБ. У 2025 році All-Flash архітектура коштувала б 8,5 млн дол. на рік, тоді як у 2026 році та сама конфігурація обійдеться вже у 24,5 млн дол.

Чи є рішення? Гібридні архітектури. Комбінування швидких SSD для критичних обчислень та містких HDD для зберігання основних масивів даних дозволяє зберегти продуктивність, не оголошуючи компанію банкрутом. Гібридні системи показали значно менше зростання вартості за цей період.

Прогнози невтішні: тиск на ціни може зберігатися протягом усього 2027 року. Епоха стабільно дешевої NAND-пам’яті закінчилася. Тепер інфраструктурним командам доводиться ставати справжніми фінансовими стратегами, щоб балансувати між швидкістю та реальністю.

13 января 2026 г., 17:50

Світ великих мовних моделей стрімко трансформується: від простих текстових генераторів ми переходимо до багатокомпонентних автономних агентів, здатних оперувати контекстом у мільйони токенів.

Це ставить перед IT-інфраструктурою виклик зовсім іншого масштабу — проблему збереження та швидкого доступу до KV-кешу (Key-Value cache), обсяги якого вже не вкладаються у традиційну ієрархію пам'яті. NVIDIA запропонувала своє бачення розв'язання цієї проблеми, представивши на CES 2026 платформу Inference Context Memory Storage Platform (ICMSP), що фактично запроваджує новий стандарт AI-орієнтованих сховищ.

Традиційна архітектура серверів, де дані мігрують між швидкою пам'яттю HBM на GPU та системною DRAM, стала вузьким місцем для сучасних інференс-навантажень. У новій структурі Vera Rubin SuperPod компанія NVIDIA виділяє окремий рівень G3.5 — спеціалізований ярус флешпам'яті з Ethernet-підключенням, що виступає «довготривалою пам'яттю» для AI-агентів. Центральним елементом цієї системи є процесор обробки даних BlueField-4 (BF4), який бере на себе функції управління введенням-виведенням KV-кешу, розвантажуючи при цьому основні обчислювальні ресурси Grace- та Vera-процесорів.

Технічна реалізація ICMSP в архітектурі Vera Rubin вражає масштабами: окрема стійка з BF4-вузлами містить 16 спеціалізованих шасі, кожне з яких об'єднує чотири блоки BlueField-4. За кожним таким DPU закріплено до 150 ТБ NVMe-місткості, що в сукупності дає майже 10 ПБ виділеної контекстної пам'яті на один SuperPod. Згідно з розрахунками NVIDIA, така інфраструктура здатна забезпечити до 16 ТБ контекстної пам'яті на кожен окремий графічний процесор Rubin. Це дозволяє утримувати історію тисяч одночасних діалогів та складних багатокрокових операцій у безпосередній близькості до обчислювальних ядер, мінімізуючи затримки при повторному зверненні до контексту.

Особливістю ICMSP є її вузька спеціалізація. На відміну від класичних корпоративних сховищ, ці масиви JBOF (Just a Bunch of Flash) не обтяжені сервісами дедуплікації, миттєвих знімків або реплікації. Їхня єдина мета — максимально швидке обслуговування запитів до KV-кешу. Керування даними здійснюється на рівні програмного стека NVIDIA Dynamo та бібліотеки NIXL (Inference Transfer Library), які дозволяють асинхронно переміщувати блоки контексту між HBM, пам’яттю хоста та рівнем ICMSP. Завдяки використанню протоколів RDMA та мережі Spectrum-X Ethernet забезпечується стабільно низька затримка, що дозволяє «підкачувати» потрібні блоки пам’яті ще до початку фази декодування токенів.

Важливим аспектом стратегії NVIDIA є відкритість цієї архітектури для партнерів. Хоча еталонний дизайн розроблено самою компанією, кінцеві рішення будуть постачатися такими лідерами ринку, як Dell, HPE, Pure Storage, VAST Data та WEKA. Це створює нову екосистему, де традиційні постачальники систем збереження даних трансформують свої продукти в інтегровані компоненти AI-фабрик. Для бізнесу це означає можливість отримати п'ятикратне зростання швидкості генерації токенів (TPS) та аналогічне підвищення енергоефективності порівняно зі стандартними мережевими сховищами.

У підсумку можна зазначити, ICMSP є логічним кроком NVIDIA у спробі повністю контролювати не лише обчислювальний цикл AI, а й життєвий цикл контекстних даних. Перетворення контексту на «ресурс першого класу» дозволяє будувати масштабовані системи для багатопотокових агентів, де кожна деталь інфраструктури — від DPU до спеціалізованих бібліотек DOCA — працює на мінімізацію простою GPU. Це перехід від простого зберігання файлів до створення динамічного середовища пам’яті, яке здатне підтримувати інтелектуальні системи наступного покоління.

29 декабря 2025 г., 17:33

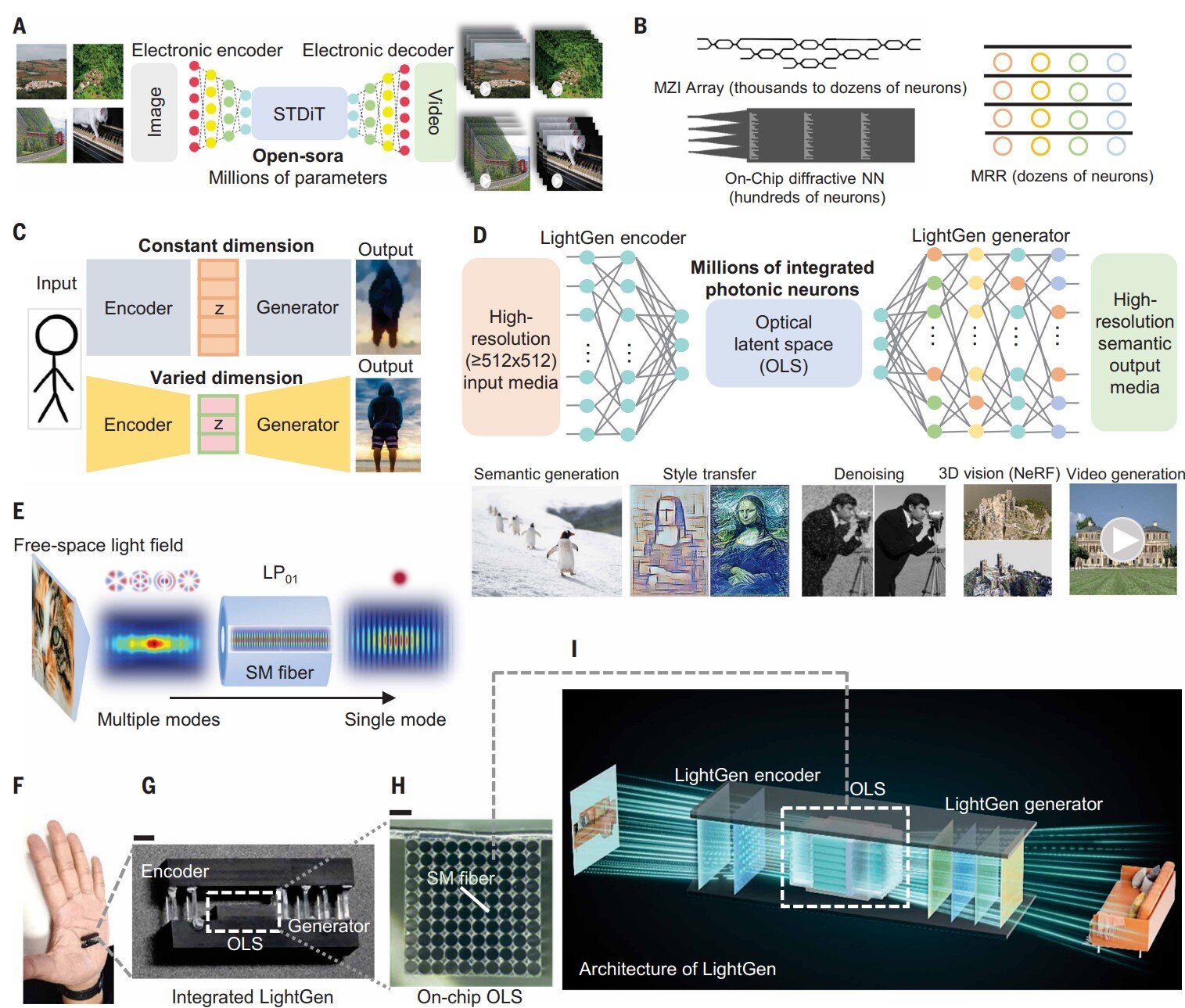

Можливості сучасних GPU при обробці завдані AI, хоч і вражають, але поступово впираються у фізичні обмеження кремнієвої електроніки. Колосальні потреби в енергії, перегрів та затримки при передачі сигналів стають «вузьким місцем» для подальшого масштабування великих моделей.

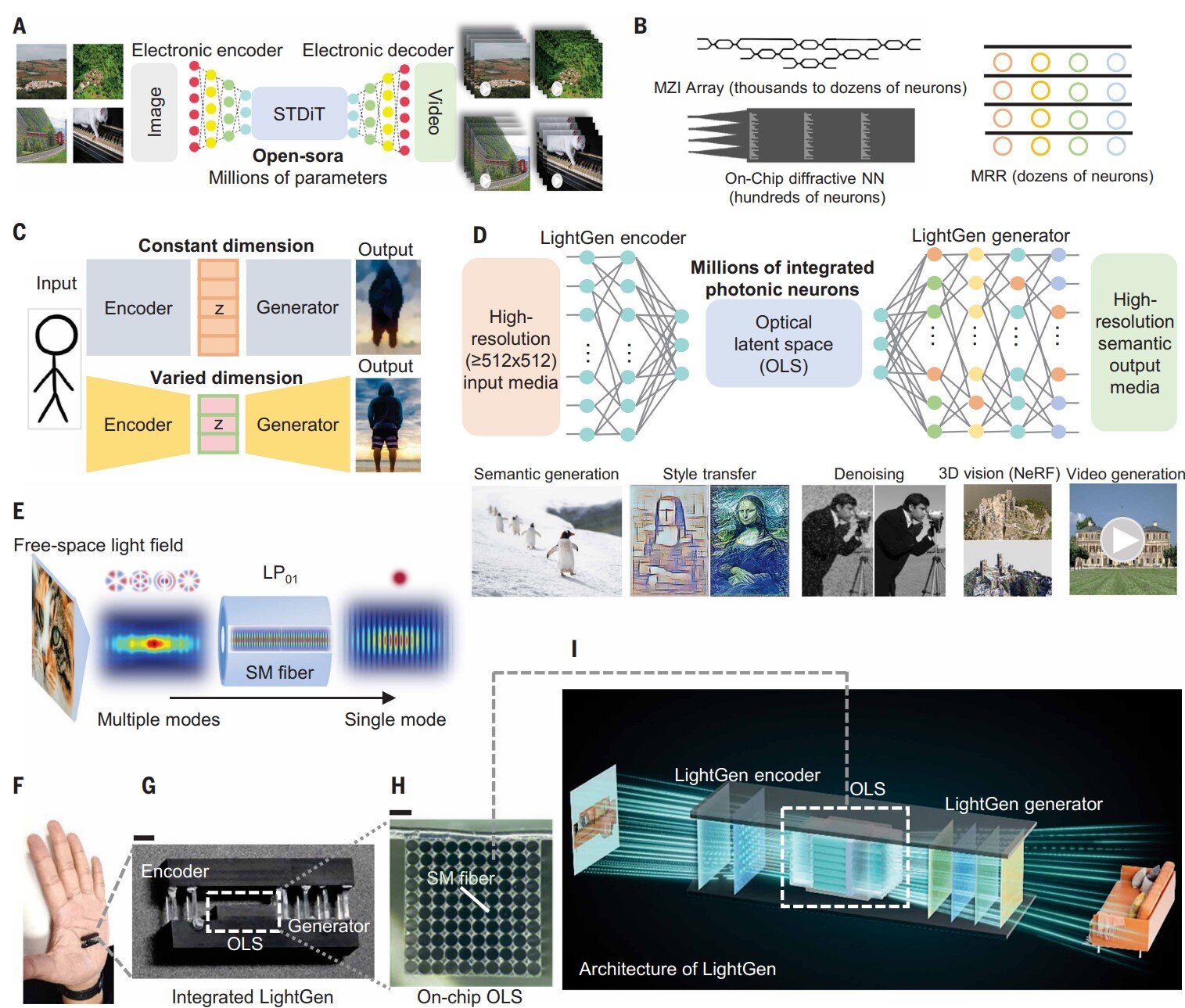

На цьому тлі розробка чипа LightGen групою дослідників під керівництвом Ітона Ченя (Yitong Chen) з Shanghai Jiao Tong University, виглядає як спроба радикальної зміни архітектурної парадигми. Це перший повністю оптичний процесор, здатний виконувати складні завдання передового Generative AI зі швидкістю, що на порядки перевищує показники традиційних рішень.

Головна складність перенесення генеративних алгоритмів на фотонні рейки завжди полягала у фундаментальних обмеженнях конструкції ранніх систем, які не були пристосовані до ітераційної природи нейромереж. У LightGen цю проблему вирішили через створення спеціального оптичного латентного простору. Це дозволяє обробляти дані у стислому вигляді безпосередньо в оптичному домені, уникаючи енерговитратних циклів конвертації світла в електрику і назад. Такий підхід у поєднанні з алгоритмами навчання на основі методу Байєса дає змогу динамічно змінювати розмірність оптичної мережі, використовуючи виключно світлові процеси.

Масштаб розробки вражає навіть за мірками напівпровідникової індустрії: чип містить понад 2 мільйони фотонних «нейронів». Така щільність обчислювальних елементів дозволяє LightGen брати на себе завдання, які раніше були прерогативою потужних серверних кластерів. Йдеться про синтез зображень високої роздільної здатності, складні маніпуляції з відео та професійну стилізацію контенту. При цьому автори дослідження підкреслюють, що ці операції виконуються не просто швидше, а з принципово іншим рівнем енергоефективності, що є критичним для майбутніх дата-центрів.

Фактично, поява LightGen маркує перехід від експериментальних прототипів до життєздатного фотонного заліза, здатного працювати з найскладнішими моделями сучасності. Якщо раніше оптичні обчислення розглядалися як нішева технологія для вузьких математичних задач, то тепер вони стають реальним претендентом на роль фундаменту для надшвидкого AI наступного покоління. Подальша доля проєкту залежатиме від того, наскільки швидко вдасться інтегрувати такі чипи в наявну інфраструктуру та подолати технологічний розрив між лабораторними зразками та масовим виробництвом

18 декабря 2025 г., 14:45

2D-транзистори на основі двовимірних матеріалів демонструвалися в академічних колах та дослідницьких лабораторіях понад десять років, проте жодна з цих демонстрацій не була сумісна з великосерійним виробництвом напівпровідників.

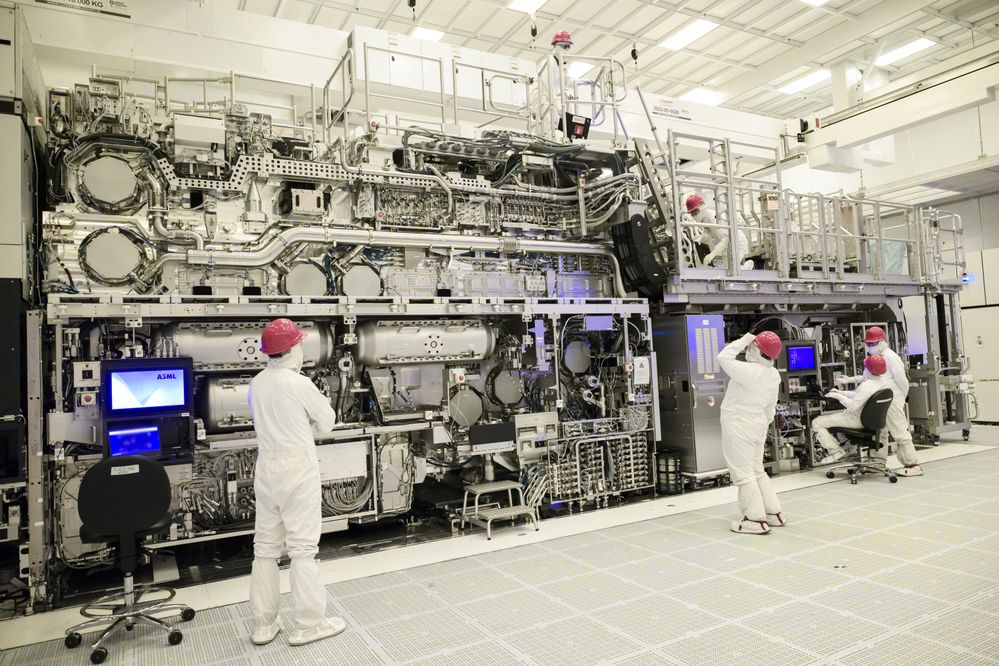

Вони спиралися на малі пластини, кастомні дослідницькі інструменти та крихкі технологічні етапи. Проте цього тижня Intel Foundry та imec продемонстрували готову до 300-міліметрових пластин інтеграцію критичних технологічних модулів для 2D-польових транзисторів (2DFET). Це свідчить про те, що 2D-матеріали та 2DFET стають реальністю.

Навіщо потрібні 2D-матеріали? Сучасні передові логічні технології — такі як Intel 18A, Samsung SF3E, TSMC N2 — базуються на пристроях із всеохоплюючим затвором (GAA). Провідні чипмейкери також розробляють комплементарні FET (CFET), щоб вертикально штабелювати транзистори для збільшення щільності.

Однак Intel та інші виробники стверджують, що подальше масштабування зрештою підштовхне кремнієві канали до їхніх фізичних меж, де електростатичний контроль і рухливість носіїв погіршуються через екстремально малі розміри. Для розв'язання цієї проблеми галузь все частіше оцінює 2D-матеріали, які можуть формувати канали товщиною всього в кілька атомів, зберігаючи при цьому сильний контроль струму.

Intel та imec представили на конференції IEDM статтю, де детально описали роботу з сімейством дихалькогенідів перехідних металів (TMD). В продемонстрованих структурах:WS₂ та MoS₂ використовувалися для транзисторів n-типу. WSe₂ слугував матеріалом каналу p-типу.

Головним досягненням стала сумісна з масовим виробництвом схема інтеграції контактів та затворного стека. Intel виростила високоякісні 2D-шари та покрила їх багатошаровим стеком з AlOx, HfO2 та SiO2. Потім ретельно контрольоване селективне травлення оксиду дозволило сформувати верхні контакти за дамаською технологією. Цей крок зберіг цілісність підкладкових 2D-каналів, які надзвичайно чутливі до забруднення та фізичних пошкоджень.

Важливість цієї спільної роботи Intel та imec полягає не в негайному випуску продукту. 2D-транзистори — це перспектива довгострокового майбутнього, можливо, другої половини 2030-х або навіть 2040-х років. Цінність роботи полягає в мінімізації ризиків розробки. Валідуючи модулі контактів і затворів у середовищі виробничого класу, Intel Foundry дозволяє замовникам і внутрішнім командам оцінювати 2D-канали, використовуючи реалістичні сценарії масштабування, а не ідеалізовані лабораторні умови.

Наразі стратегія Intel полягає в тому, щоб розглядати 2D-матеріали як опцію майбутнього, яку можна оцінити задовго до того, як кремній досягне своїх остаточних меж. Спільно розробляючи процеси з такими партнерами, як imec, Intel сподівається завчасно розв'язати проблеми виробництва та уникнути "сюрпризів" на пізніх стадіях, коли нові матеріали нарешті стануть необхідними.

3 декабря 2025 г., 20:44

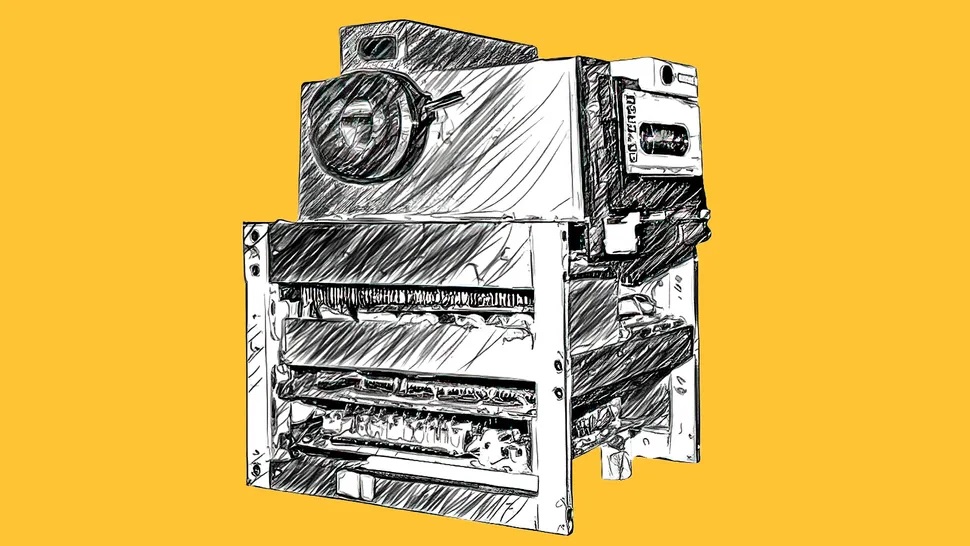

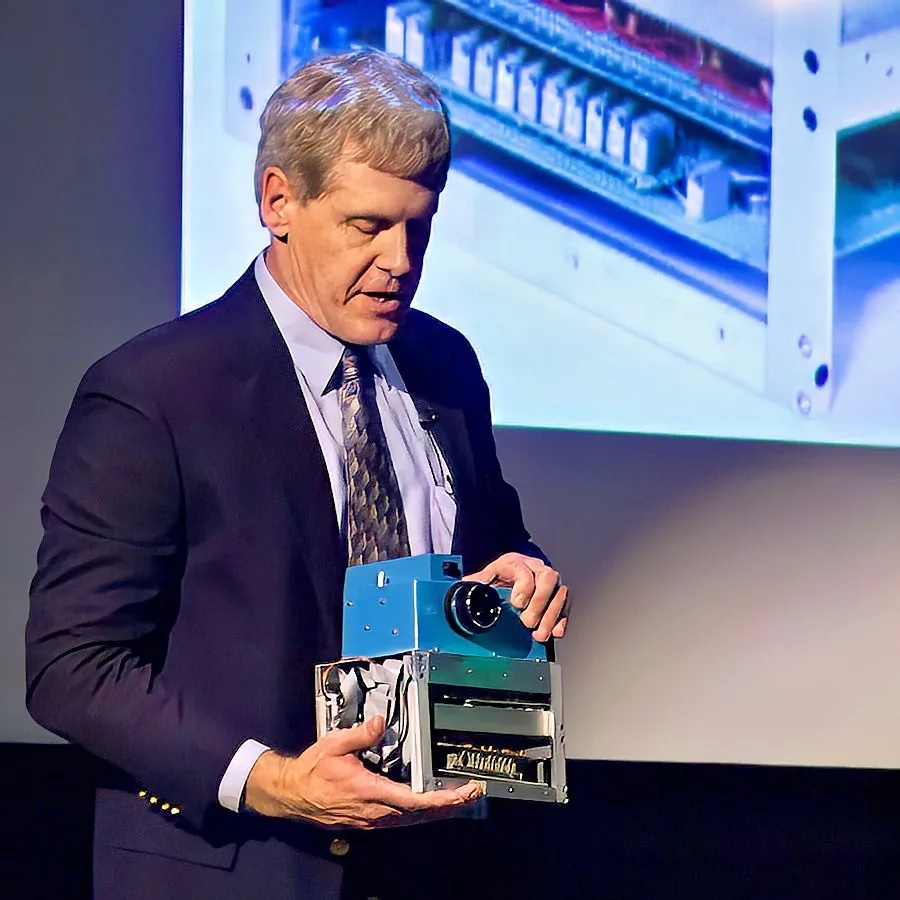

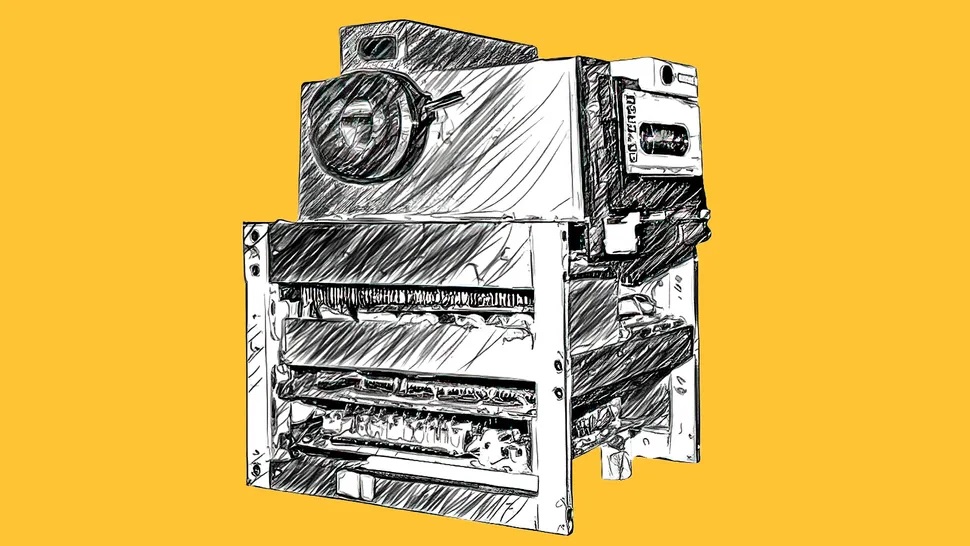

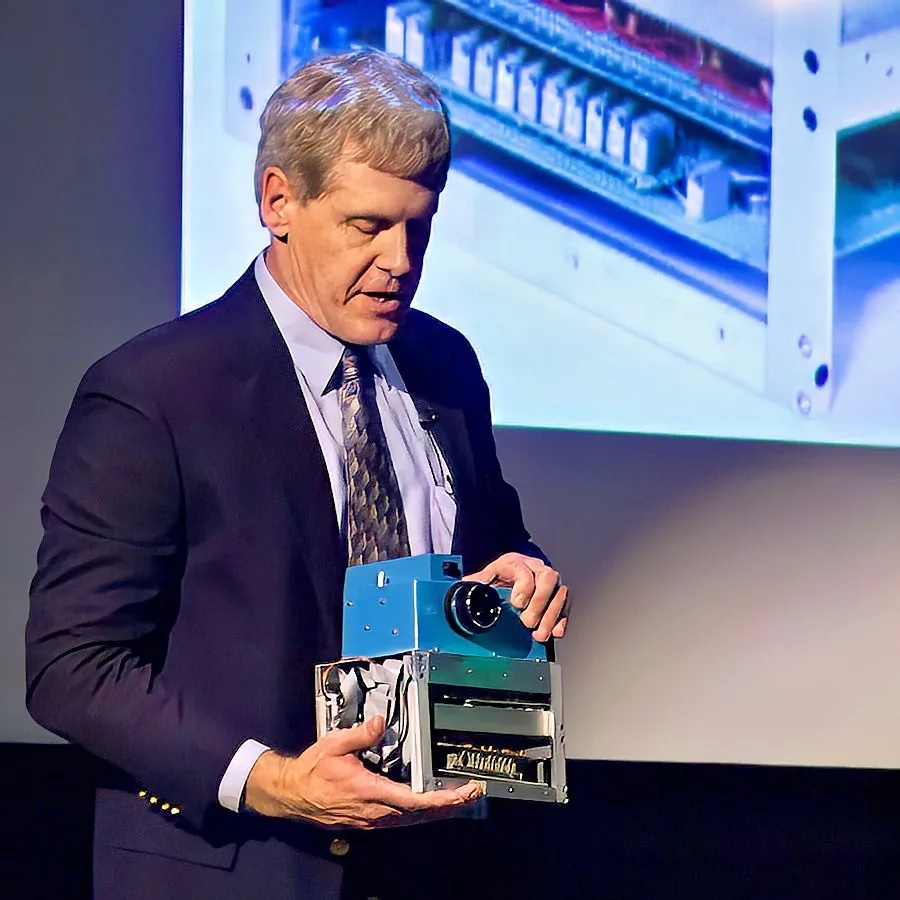

За іронією долі ця розробка з'явилася в компанії, яка не повірила в перспективність ідеї «безплівкової фотографії» і на багато років оточила її стіною секретності.

На початку 1975 року 24-річний інженер-електрик Kodak, Стівен Сассон (Steven Sasson), отримав від свого керівника щойно розроблений ПЗЗ-сенсор і прохання "подивитися, що він може з ним зробити".

Ця розмова, ймовірно, тривала менш як хвилину, і слово "цифровий" жодного разу не згадувалося. Але за допомогою двох дуже талановитих техніків, Боба ДеЯгера (Bob DeYager) та Джима Шуклера (Jim Schueckler), менш ніж за рік він спроєктував та створив першу у світі робочу, автономну цифрову камеру.

Це було непросте завдання, оскільки ПЗЗ-сенсор від Fairchild Semiconductor вимагав дванадцяти різних напруг і постачався з рукописним аркушем, де детально описувалася напруга, необхідна для кожного контакту. Внизу була записка від інженера, який калібрував чіп. Там просто було написано: "Хай щастить!"

Необхідну потужність забезпечували 16 батарейок типу АА, але споживання енергії було високим, тому час роботи від батарей був коротким.

Об'єктив був узятий від вживаної кінокамери Kodak Super 8, оскільки весь проєкт був низькобюджетним.

Камеру пофарбували у синій колір просто для того, щоб запобігти появі відбитків пальців на алюмінієвому корпусі, а також тому, що під рукою була банка синьої фарби.

Камера важила 3,6 кг і записувала 0,01 мегапікселя (100x100 пікселів) чорно-білого зображення на касету для даних типу Philips.

Камера мала простий оптичний видошукач (без заднього екрана, як ми маємо сьогодні) та електронний затвор лише з однією швидкістю (1/20 секунди або 50 мілісекунд). Світлочутливість становила приблизно ISO 100. Чорно-біле зображення записувалося в пам'ять лише за 150 мілісекунд, але для його постійного зберігання на цифровій касетній стрічці потрібно було ще 23 секунди. Потім його потрібно було зчитувати в мікрокомп'ютер для відтворення на екрані телевізора. Слід зазначити, це була суто технічна вправа, не призначена для виробництва, а лише для того, щоб перевірити, чи можлива цифрова фотографія в принципі.

9 грудня 1975 року розробники зробили першу фотографію камерою — простий знімок чередування чорних і білих смуг. Вона спрацювала! Тоді Сассон переконав лаборантку Джой Маршалл позувати для фото. Вона пішла за ними коридором, щоб побачити результат. Сассон розповідав, що коли зображення з’явилося на екрані, "було видно силует її волосся", але обличчя було суцільною масою статичних перешкод. Вона була не надто задоволена результатом і пішла зі словами: "Над цим треба попрацювати!"

Але Сассон швидко зрозумів, у чому проблема, і, помінявши місцями набір дротів, зображення молодої жінки було відновлено, і цифрова фотографія народилася. На жаль, він не зберіг це фото, оскільки касета часто використовувалася повторно.

Сассон встановив місткість цифрової касети на 30 фотографій, число, обране для зручності — воно було посередині між 24 і 36, кількістю знімків на 35-мм плівці. Він міг би сказати, що вона може записати лише один-два, але знав, що його керівництво скаже, що це непрактично. Він так само легко міг вибрати 100 або навіть 1000, але також знав, що на той час ніхто не зможе осягнути таку концепцію. Коли він вперше показав своє творіння керівництву на презентації, яку назвав "Безплівкова фотографія", вони були не в захваті.

Сассону заборонялося розповідати про камеру за межами компанії до 2001 року, коли він написав статтю для видання "Rochester Democrat and Chronicle", в якій також було опубліковано перше публічне фото оригінального прототипу. Коли новина просочилася, на Сассона чекала нагорода: "Протягом 10 хвилин мої діти дійсно вважали мене крутим".

Був побудований лише один прототип. Він досі існує, незмінний з моменту, коли зробив останній знімок десь у 1976 році. Він більше не працює, оскільки з'єднання методом накрутки дротів, що використовувалися для цифрових схем, були призначені лише для тимчасового прототипування. Камера не мала офіційної назви, хоча Сассон зізнається, що називав її досить неприємними словами, коли вона переставала працювати. Що траплялося часто.

Сассон тримав камеру вдома близько 30 років. Але після того, як її існування стало публічним, Смітсонівський інститут попросив виставити її у своєму Музеї американської історії у Вашингтоні, де вона залишалася протягом кількох років. Сьогодні його творіння можна побачити в музеї George Eastman House у Рочестері, штат Нью-Йорк.

Сассон розповідав, що коли він подорожує з нею літаком, щоб виступити з доповідями, він несе її на колінах. Зайве говорити, що вона привертає значну увагу як на контролі безпеки в аеропорту, так і в польоті!

Стівен Сассон пішов з Kodak у 2009 році, а у 2010 році отримав Національну медаль технологій та інновацій від Президента Обами.

18 ноября 2025 г., 19:19

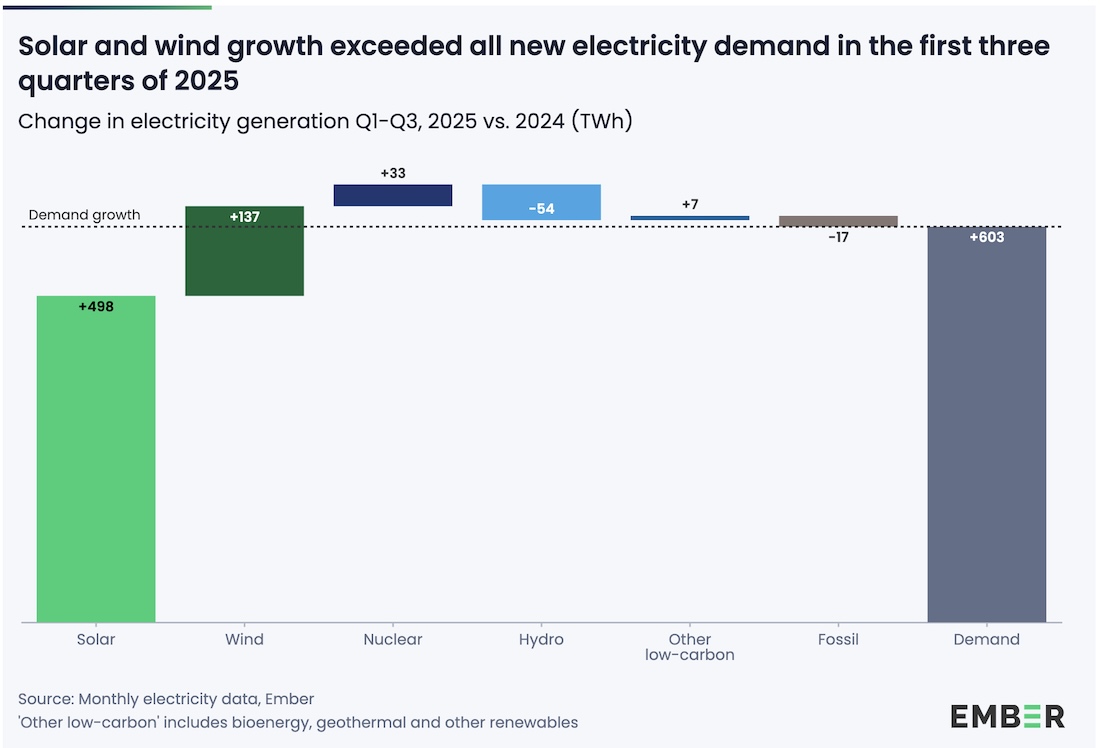

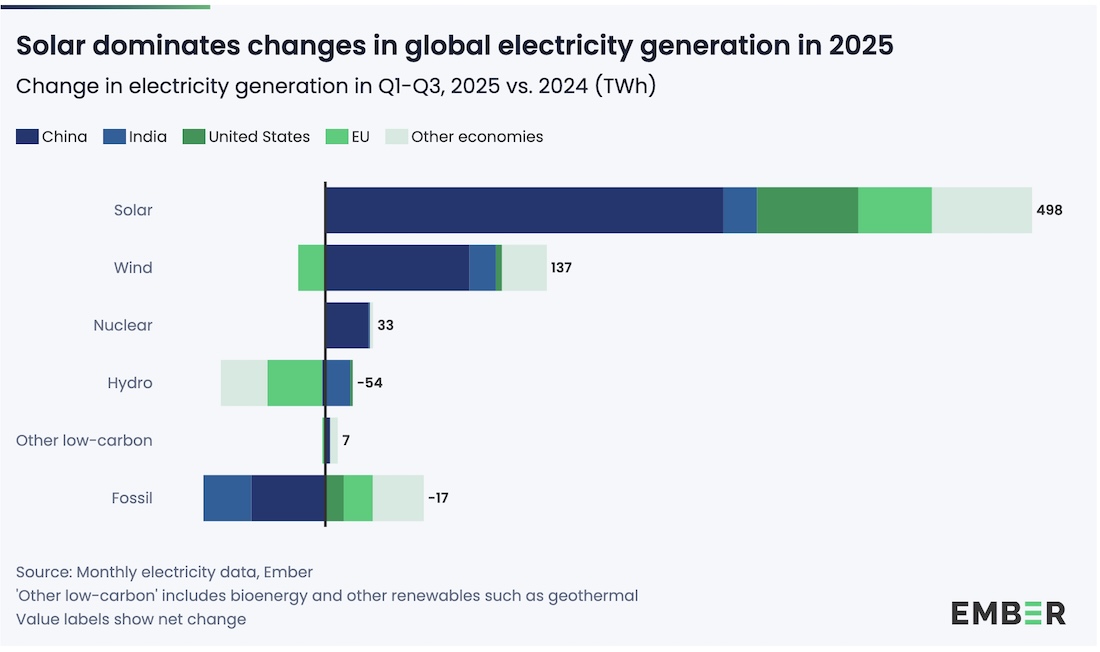

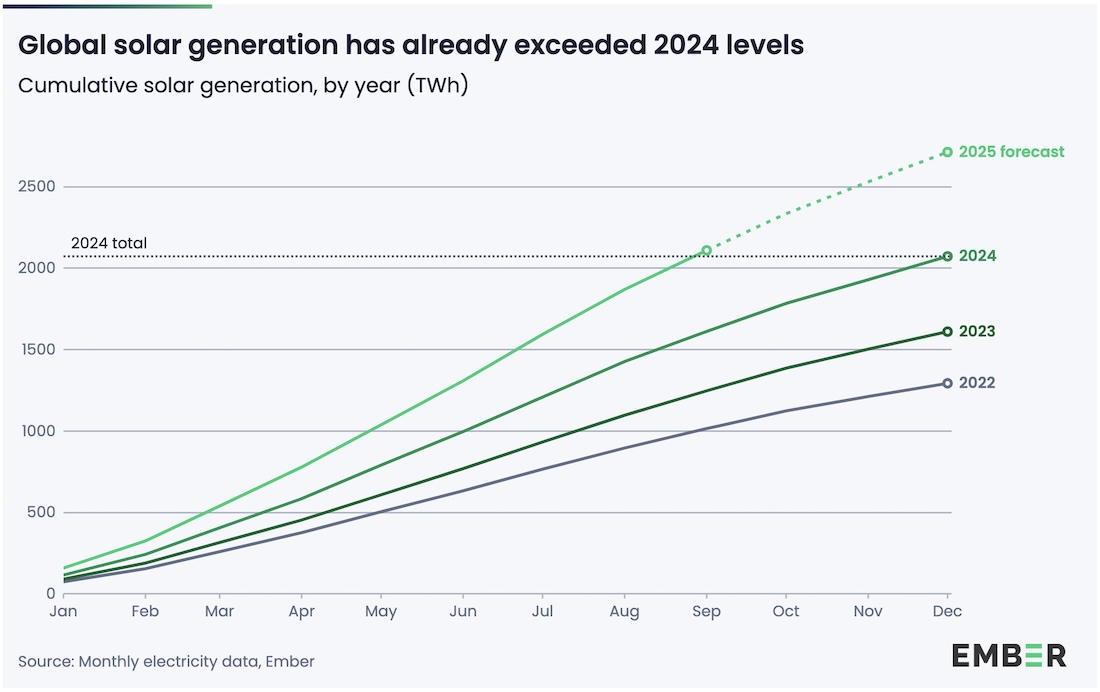

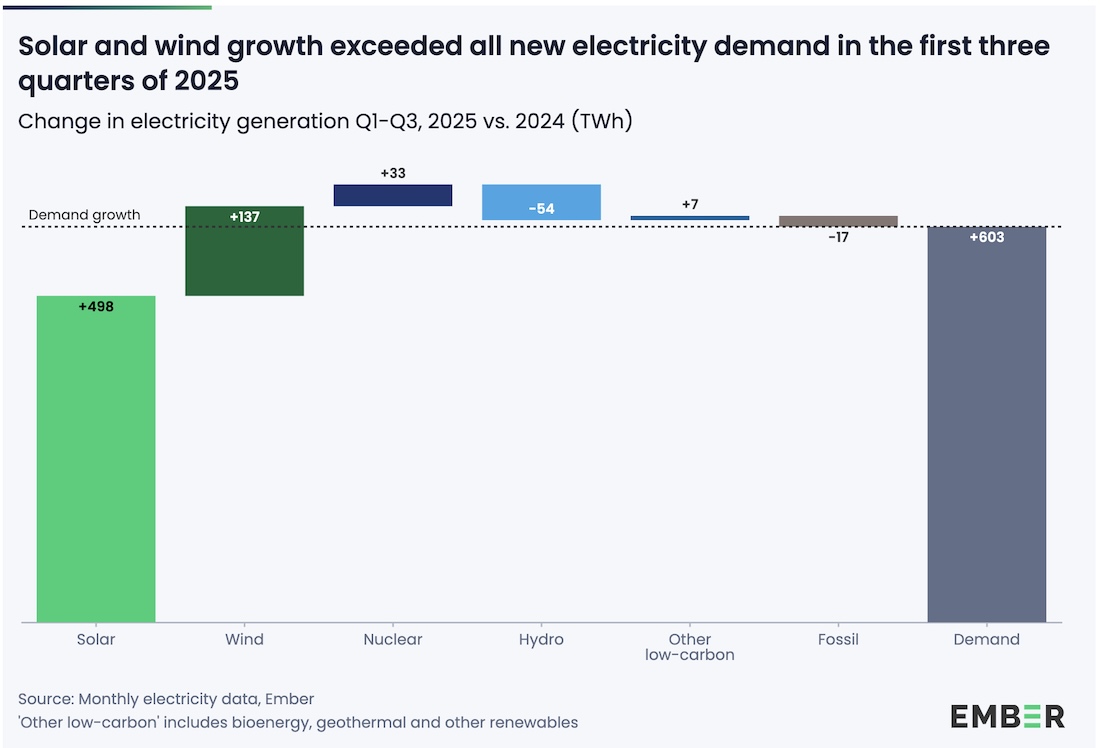

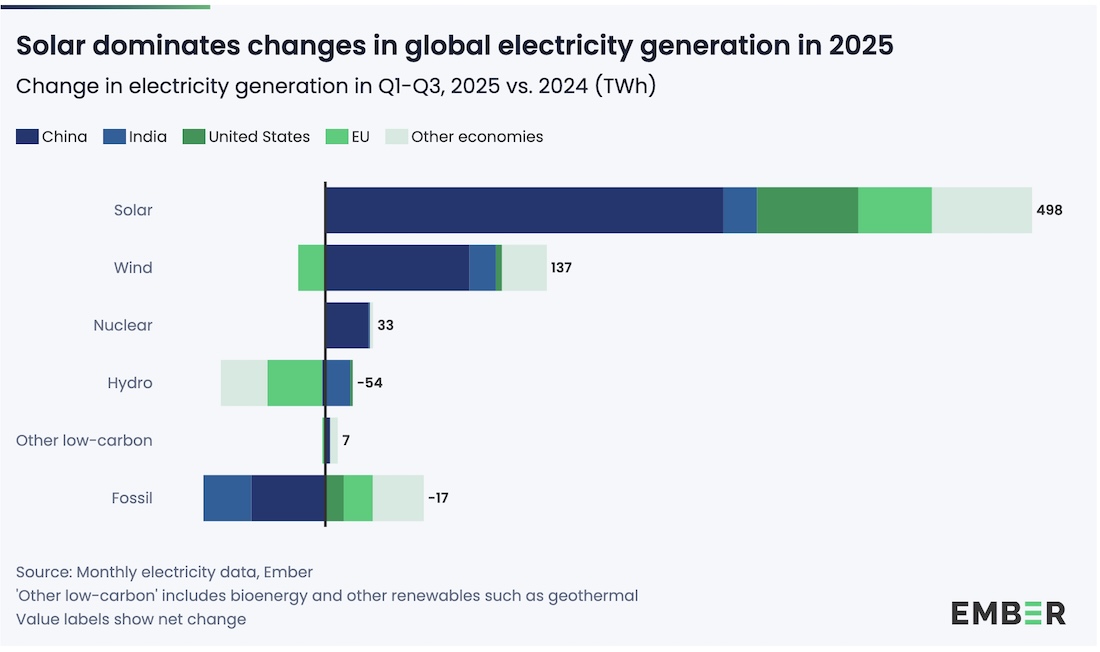

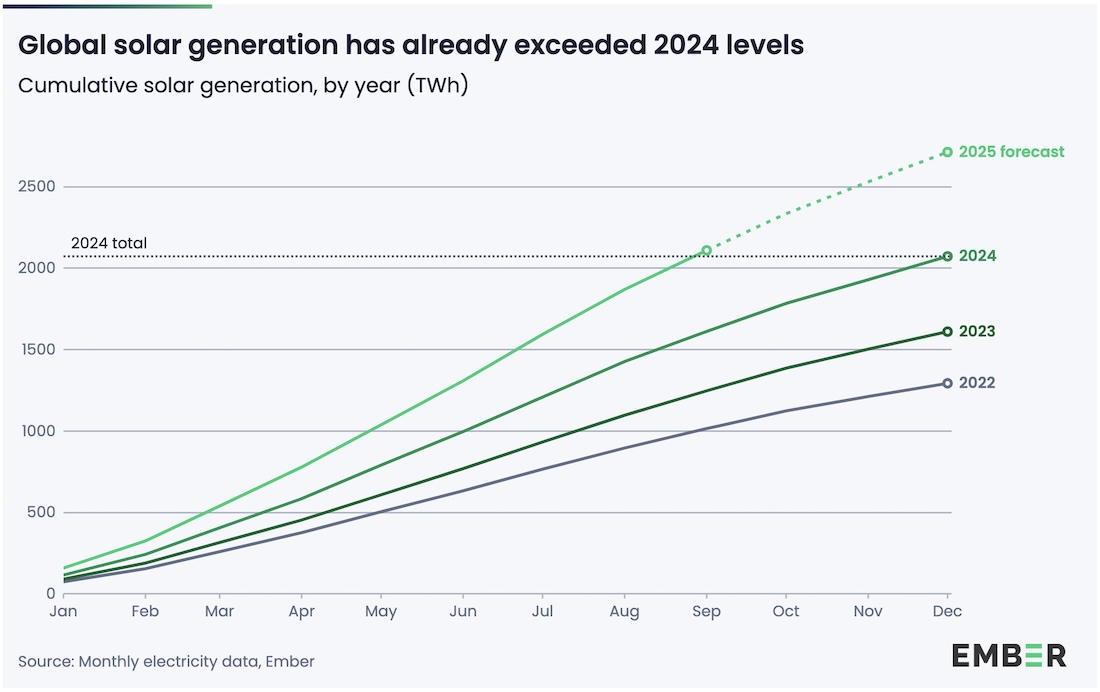

Як свідчать нові дані від Ember Energy Research, сонячна та вітрова енергетика зростають настільки швидко, що покрили весь новий світовий попит на електроенергію протягом перших трьох кварталів 2025 року. Тепер очікується, що виробництво енергії з викопного палива залишиться на тому ж рівні протягом усього року - вперше з часів пандемії генерація цього типу не зросте.

Сонячна та вітрова енергія не просто розширюються; вони випереджають зростання глобального попиту на електроенергію. Зокрема, сонячна генерація підскочила на 498 ТВт⋅год (+31%) порівняно з аналогічним періодом минулого року, вже перевищивши обсяг сонячної енергії, виробленої за весь 2024 рік. Вітрогенерація додала ще 137 ТВт⋅год (+7.6%). Разом ці джерела постачили 635 ТВт⋅год нової чистої електроенергії, що перевищило зростання глобального попиту на 603 ТВт⋅год (+2.7%). Це підвищило частку сонячної та вітрової енергії у світовій електроенергетиці до 17.6% за перші три квартали року (порівняно з 15.2% минулого року), а загальна частка всіх відновлюваних джерел сягнула 43%.

Вперше у 2025 році відновлювані джерела енергії колективно згенерували більше електроенергії, ніж вугілля. Генерація викопного палива в цілому застопорилася, навіть трохи знизившись на 0.1% до кінця третього кварталу. Ember очікує відсутності зростання викопного палива за весь рік завдяки тому, що зростання чистої енергії випереджає попит. Цей зсув частково обумовлений Китаєм та Індією. У Піднебесні викопна генерація впала на 1.1%, оскільки чиста енергія покрила весь новий попит, що стало результатом структурних змін. Індія побачила падіння викопної генерації на 3.3% завдяки рекордному зростанню сонячної та вітрової енергії та м'якшій погоді.

Саме сонячна енергія виконує основну роботу. Вона тепер є найбільшим рушієм змін у світовому енергетичному секторі, із зростанням у понад три рази більшим, ніж будь-яке інше джерело електроенергії. Як зазначає Ніколас Фулгум (Nicolas Fulghum), старший аналітик даних Ember, рекордне зростання сонячної енергії та стагнація генерації з викопного палива показують, як відновлювана енергетика стала рушійною силою в глобальній економіці. Викопне паливо, яке історично було сегментом зростання, тепер, схоже, входить у період стагнації та контрольованого занепаду. Навіть Китай, який був найбільшим джерелом зростання у використанні викопного палива, досяг поворотного моменту, що свідчить про те, що залежність від цього типу енергогенерації для задоволення зростаючого попиту спадає все більше.

Зростання попиту на електроенергію склало 2.7% за перші три квартали 2025 року, що значно повільніше, ніж стрибок на 4.9%, зафіксований минулого року, коли екстремальна спека спричинила підвищення попиту на охолодження в Китаї, Індії та США. Цьогорічна м'якша погода допомогла зменшити навантаження на мережу, полегшивши чистій енергії закриття розриву.

Загалом, уперше поза межами великих криз, як-от пандемія чи світова фінансова криза, зростання чистої енергії не лише наздогнало попит, а й перевищило його. Наступне велике питання: чи зможуть сонячна, вітрова та інші джерела чистої енергії постійно підтримувати цей темп? Якщо так, то 2025 рік може стати роком, коли світова генерація викопного палива досягла свого плато. Цей перехід також матиме глибокі геополітичні наслідки, розділяючи країни на ті, що покривають свої потреби дешевою, чистою енергією власного виробництва, і ті, що залишаються залежними від дорогого імпорту викопного палива.

7 ноября 2025 г., 19:27

Collins English Dictionary назвав "Vibe coding" Словом року 2025. Ця подія сигналізує: ера, коли розробники годинами писали код вручну, видається, добігає кінця.

Термін, який насправді складається з двох слів, був обраний на тлі того, як штучний інтелект відіграє дедалі більшу роль у нашому житті, фундаментально змінюючи взаємодію людини з комп'ютерами.

Нагадаємо, "Vibe coding" – це форма розробки програмного забезпечення, що передбачає перетворення природної людської мови на комп'ютерний код за допомогою АІ. Дослівно у перекладі можна трактувати як "програмування на вібраціях" або "кодування за настроєм".

Як пояснюють лексикографи Collins, це "використання штучного інтелекту, що керується природною мовою, для допомоги у написанні комп'ютерного коду". Простіше кажучи: "Ви просто говорите машині, що ви хочете, замість того, щоб копітко кодувати це самостійно".

Автором терміну є колишній директор АІ у Tesla та інженер-засновник OpenAI Андрій Карпатий (Andrej Karpathy). Він описав цей процес як створення програми за допомогою АІ, коли людина може "забути, що код взагалі існує".

Керувальний директор Collins Алекс Бікрофт (Alex Beecroft) підкреслив, що вибір "vibe coding" "ідеально відображає, як мова розвивається разом із технологіями". Він сказав, що це "сигналізує про велику зміну в розробці ПЗ, де АІ робить кодування більш доступним. Безшовна інтеграція людської творчості та машинного інтелекту докорінно змінює нашу взаємодію з комп’ютерами." (“The selection of ‘vibe coding’ as Collins’ Word of the Year perfectly captures how language is evolving alongside technology... It signals a major shift in software development, where AI is making coding more accessible. The seamless integration of human creativity and machine intelligence demonstrates how natural language is fundamentally changing our interaction with computers.”)

Для моніторингу нових і помітних слів, Collins Dictionary використовує базу Collins Corpus, що містить 24 млрд слів з різних джерел, включно із соціальними мережами.

Терміни, що описують стосунки людей з технологіями, цього року зайняли чільне місце у списку.

"Clanker" - інше слово у шорт-листі, але воно має негативне забарвлення. Це зневажливий британський термін для робота, комп'ютера або певного типу АІ. "Broligarchy" - посилається на невелику кліку дуже багатих чоловіків, які мають політичний вплив. Collins наводить як приклади Марка Цукерберга, Джеффа Безоса, Ілона Маска та Сундара Пічаї, які були високопоставленими гостями на інаугурації президента США Дональда Трампа цього року.

"Henry" - абревіатура від "High Earner, Not Rich Yet" (Високооплачуваний, але ще не багатий).

Також до списку увійшли терміни, пов'язані з якістю життя та роботою: "Taskmasking" (створення помилкового враження продуктивності на робочому місці), "Micro-retirement" (перерва між періодами зайнятості для реалізації особистих інтересів) та "Biohacking" (зміна природних процесів тіла для покращення здоров'я та довголіття).

Примітно, Словом 2024 року був названий термін "Brat". А у 2023 році, за версією Collins English Dictionary, Словом року стала абревіатура АІ, яка означає "моделювання розумових функцій людини за допомогою комп'ютерних програм".

27 октября 2025 г., 18:16

Минулими днями світ ІТ-інфраструктури отримав гучне нагадування: навіть технологічні гіганти, які здаються непохитними, не застраховані від фатальних помилок. Amazon Web Services (AWS) визнала, що масштабний збій, який вивів з ладу частину Інтернету на кілька днів, був спричинений конфліктом у системі автоматизації DNS (Domain Name System). Проблема торкнулася величезної кількості сервісів — від сайтів і хмарних застосунків до онлайн-ігор і «розумних» пристроїв.

Почалося все з того, що конфігурація DNS для бази даних Amazon DynamoDB у регіоні us-east-1 була пошкоджена й опублікована через сервіс Amazon Route 53. Це запустило ефект доміно: сервіси, які залежали від DynamoDB, перестали працювати, а нові екземпляри в Amazon EC2 не могли створюватись. Черги запитів почали накопичуватись, і навіть внутрішні системи AWS відчули наслідки. Ключова технічна причина — класична race condition: два компоненти — «DNS Planner» і «DNS Enactors» — одночасно обробляли оновлення. Один із них почав виконувати старий «план» змін, тоді як інший вже перейшов до нового. У результаті система отримала суперечливий стан: старі записи були застосовані поверх нових, а в деяких випадках DNS-таблиці опинились у стані «порожніх записів». Саме це й призвело до того, що частина хмарної інфраструктури «осліпла», не розуміючи, куди спрямовувати трафік.

AWS підкреслила, що автоматизовані системи — це необхідність для управління мільйонами ресурсів, але вони потребують надзвичайно ретельного проєктування. Цей випадок став ілюстрацією того, що навіть найкраща автоматизація може накопичувати технічний борг. Помилка в одній підсистемі здатна перетворитись на каскадну кризу, якщо не передбачені захисні механізми. Ситуація також показала межі масштабування: коли один ключовий елемент хмарної архітектури падає, ланцюгова реакція охоплює десятки інших сервісів. Балансувальники навантаження почали позначати робочі ноди як «мертві» через некоректні DNS-відповіді, що лише поглиблювало колапс. AWS заявила, що основний збій тривав близько трьох годин — із 19 жовтня 23:48 до 20 жовтня 02:40 — однак наслідки користувачі відчували ще протягом декількох днів.

Аналіз The Register виявив більше нюансів. По-перше, збій не мав жодного стосунку до АІ: автоматизація, яка керує хмарними системами, — це далеко не «штучний інтелект» у сенсі популярних уявлень. Автор підкреслив, що сценарій «це через АІ» — це міф. По-друге, ідея про те, що «багато-хмарність» (multi-cloud) є панацеєю на всі випадки відмови — теж міф. Переходячи до ще однієї платформи, організації часто отримують не другу точку відмови, а ще одну повноцінну точку провалу, що дає багато більше складнощів, ніж резерв. Третє: проблема «довгого хвоста» (long tail) — тобто, що якщо все ще не працює через тиждень-два, це вже не наслідок тієї аварії. Як зазначено: «Якщо ви досі маєте проблеми через тиждень — це не про цей інцидент».

Для українського ІТ-середовища ця історія має особливу вагу. Вона нагадує, що навіть найпотужніша «хмара» не може гарантувати абсолютної стабільності. Компаніям варто враховувати, що навіть глобальний провайдер хмари може упасти, і тому потрібно мати власні сценарії відмовостійкості. Важливо розділяти критичні елементи архітектури, проєктувати резервні канали доступу та регулярно перевіряти сценарії аварійного відновлення. Крім того, моніторинг і «health checks» мають бути гнучкими: якщо система автоматично виводить вузли з балансу лише через те, що не може коректно прочитати DNS-записи — це сигнал про слабкість самої архітектури. Гнучкі механізми ручного втручання мають бути обов’язковими у будь-якому середовищі, де від доступності залежить бізнес.

І нарешті, цей випадок ще раз доводить, що фраза «це просто DNS» часто означає набагато більше. Один незначний збій у фоновому процесі може перетворитися на глобальну кризу. У світі, де «хмара» означає тисячі взаємопов’язаних компонентів, ключовими стають не лише масштаб і швидкість автоматизації, а й уважність до деталей, ретельне тестування й готовність до непередбачуваного.

15 октября 2025 г., 15:42

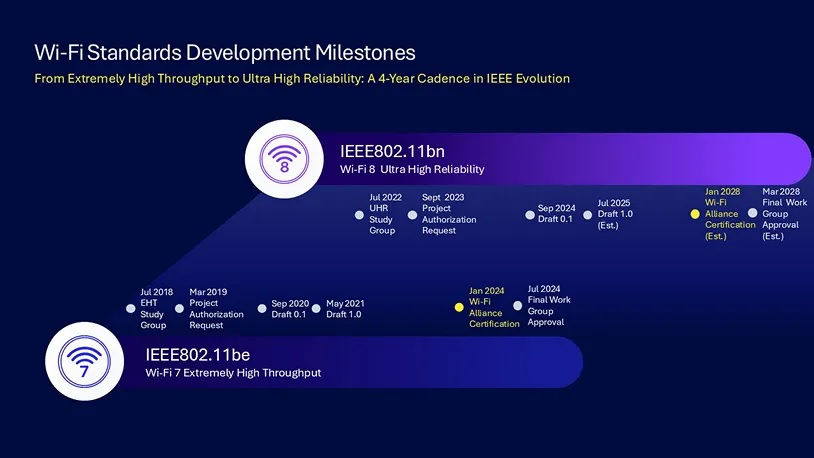

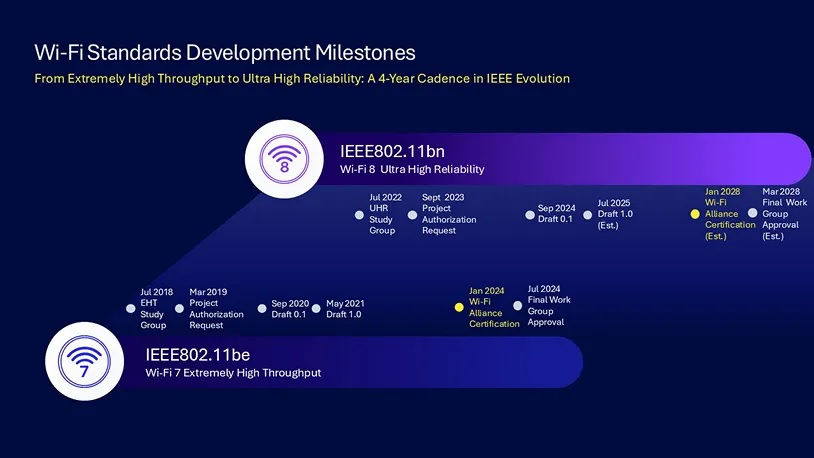

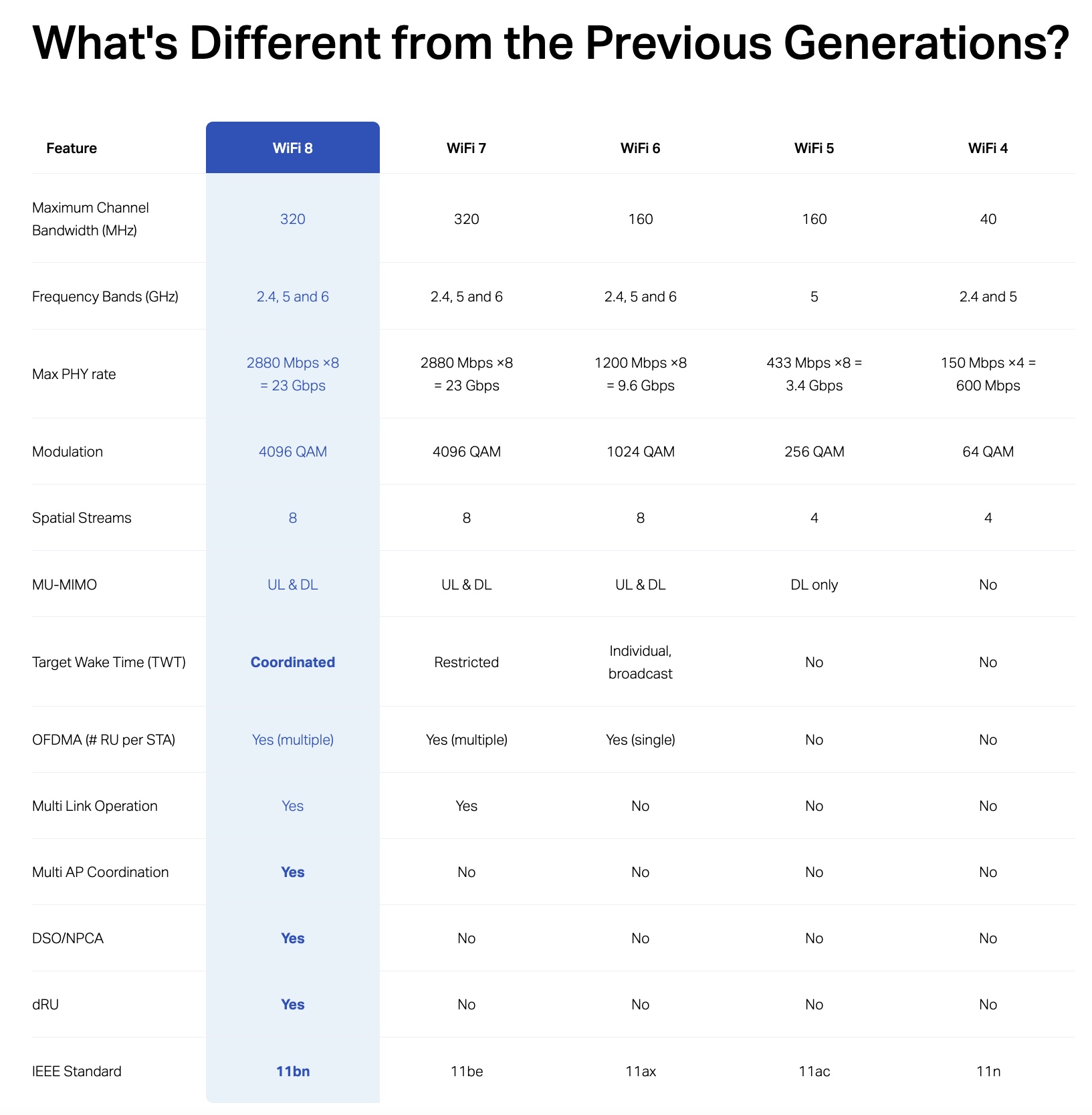

Поки більшість користувачів лише починає освоювати Wi-Fi 7, але галузь уже готується до впровадження наступного покоління — Wi-Fi 8 (IEEE 802.11bn), або, за термінологією розробників, Ultra High Reliability (UHR). Новий стандарт обіцяє не просто вищу швидкість, а насамперед якісно інший рівень стабільності та ефективності мережевого обміну.

На відміну від попередніх ітерацій, головний акцент Wi-Fi 8 зміщується з гігабітних піків на надійність у реальних умовах. Йдеться про мінімізацію втрат пакетів, покращення роботи при слабкому сигналі, зниження латентності та стабільність у сценаріях з високим навантаженням або великою щільністю точок доступу. За концепцією розробників IEEE, це має стати платформою для стабільного функціонування промислових IoT-середовищ, корпоративних WLAN і розумних міст.

Днями з'явилася новина, що компанія TP-Link першою офіційно підтвердила успішне проведення випробувань прототипу Wi-Fi 8. Повідомляється, що під час тестів були перевірені передача маякових сигналів (beacon) та реальний канал даних. За результатами, система продемонструвала стабільну роботу без втрат у типових сценаріях мережевого навантаження, що підтверджує працездатність базових механізмів нового стандарту.

Хоча TP-Link не розкриває конкретні технічні деталі обладнання, відомо, що проєкт реалізується у партнерстві з виробниками чипсетів — Qualcomm, Broadcom, Intel, MediaTek та іншими. Це свідчить про початок міжгалузевої координації, необхідної для формування повноцінної екосистеми Wi-Fi 8.

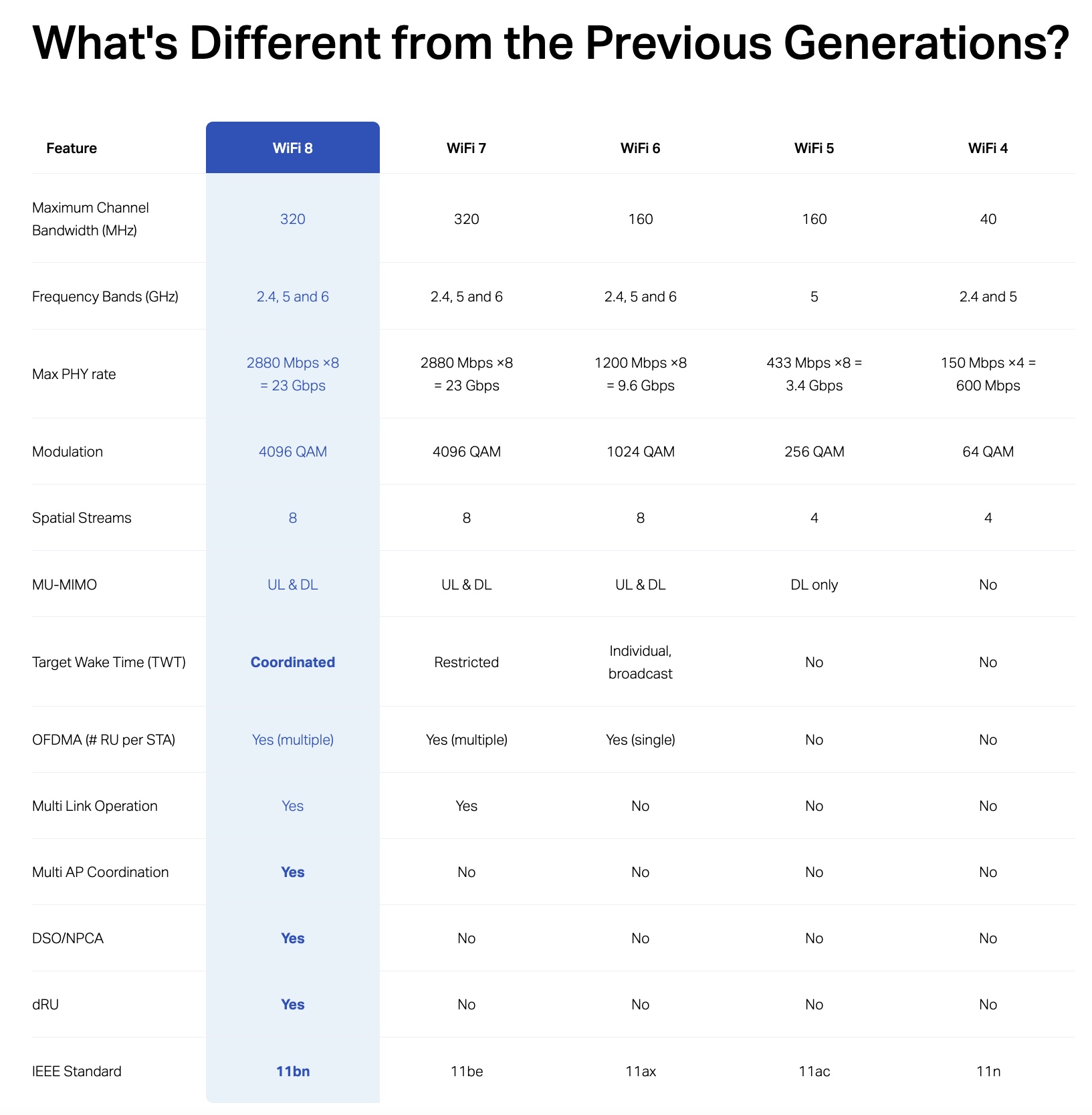

Згідно з попередніми технічними даними, теоретичні межі пропускної здатності залишаються на рівні Wi-Fi 7 — до 46 Гбіт/с. Проте інженери TP-Link оцінюють приріст ефективної швидкості в реальних умовах до 25 %, що досягається завдяки новим механізмам керування спектром і підвищеній стійкості до втрат пакетів.

Wi-Fi 8 не пропонує радикально нових діапазонів частот — робота все так само відбувається у смугах 2,4 ГГц, 5 ГГц і 6 ГГц. Проте основні зміни у способі використання спектра. Новий стандарт передбачає більш глибоку координацію між точками доступу через механізми Coordinated Spatial Reuse (Co-SR) та Coordinated Beamforming (Co-BF). Це дозволяє уникати колізій у багатоклітинних сценаріях, підвищуючи ефективність використання ефірного часу.

Ще одним ключовим напрямом розвитку є Dynamic Sub-Channel Operation (DSO) — динамічне призначення субканалів відповідно до поточного рівня завад і завантаження спектра. Такий підхід зменшує простої в передачі, забезпечуючи до 80% приросту ефективності в щільних середовищах.

Wi-Fi 8 також розвиває концепцію багатолінкових операцій, започатковану у Wi-Fi 7, і вдосконалює алгоритми формування променів. Це дозволяє не тільки підвищити швидкість доступу, а й забезпечити кращу синхронізацію між клієнтами, що переміщуються, наприклад у корпоративних кампусах або промислових цехах із великою кількістю точок доступу.

Wi-Fi 6 (802.11ax) був зосереджений на ефективності при багатьох клієнтах завдяки OFDMA та MU-MIMO, знизив латентність і зробив бездротові мережі придатними для корпоративних сценаріїв. Розробники Wi-Fi 7 (802.11be) сфокусувалися на мультиканальній роботі, подвоєнні ширини каналу до 320 МГц і підвищенні модуляції до 4096-QAM, що дозволило досягати пікових швидкостей понад 40 Гбіт/с.

Wi-Fi 8 розвиває ці напрацювання, але з іншим фокусом — надійність замість пікової швидкості. З технічного погляду, його завдання — зробити бездротові мережі більш передбачуваними у складних середовищах, де зараз навіть Wi-Fi 7 не завжди демонструє стабільність. Це має критичне значення для промислових систем, доповненої реальності, автономного транспорту та сценаріїв з високою чутливістю до затримок.

Станом на цей момент жоден із великих вендорів не представив комерційних пристроїв із підтримкою Wi-Fi 8. TP-Link продемонструвала лише тестовий зразок, який використовував експериментальні радіомодулі. Сертифікація стандарту в рамках WiFi Alliance очікується орієнтовно у 2028 році, після чого можна очікувати появу перших готових продуктів.

У проміжку між Wi-Fi 7 і Wi-Fi 8 виробники продовжать оптимізувати рішення для корпоративного сегмента. Зокрема, мультиканальні точки доступу, побудовані на архітектурі Wi-Fi 7, уже частково реалізують механізми, схожі на Co-SR і DSO. Тому можна очікувати, що перші комерційні реалізації Wi-Fi 8 стануть еволюційним розвитком нинішніх high-end платформ.

Якщо Wi-Fi 6 зробив бездротові мережі масштабованими, а Wi-Fi 7 — надшвидкими, то Wi-Fi 8 має зробити їх передбачуваними. Це — перехід від гонитви за піковими мегабітами до створення стабільної та керованої бездротової інфраструктури, здатної підтримувати критично важливі сервіси.

|

|

|