Екскурсія на AI-фабрику

22 сентябрь, 2025 - 16:25Тимур ЯгофаровКомпанія Microsoft представила Fairwater – свій найновіший американський центр обробки даних для AI, найбільшу і найсучаснішу AI-фабрику. Тож розберемось, що відрізняє її від звичайного дата-центру.

Слід зазначити, що на додаток до центру обробки даних Fairwater у Вісконсині Microsoft також будує кілька центрів, ідентичних Fairwater, в інших місцях по всій території США. Крім того, у Нарвіку, Норвегія, Компанія оголосила про плани з nScale та Aker JV щодо розробки нового гіпермасштабного центру обробки даних для AI. А у Лафтоні, Велика Британія, вона оголосила про партнерство з nScale для будівництва найбільшого в країні суперкомп'ютера для підтримки послуг у Великій Британії.

Ці центри обробки даних для AI є значними капітальними проєктами, що становлять десятки мільярдів доларів інвестицій і сотні тисяч передових AI-чипів, і будуть безперешкодно з'єднані з глобальною хмарою Microsoft Cloud, що налічує понад 400 дата-центрів у 70 регіонах по всьому світу. Завдяки інноваціям, які дозволяють об'єднати ці центри обробки даних у розподілену мережу, експоненційно множиться ефективність і обчислювальна потужність, щоб ще більше демократизувати доступ до послуг AI в усьому світі.

Отже, що таке центр обробки даних для AI? Це унікальний, спеціально побудований об'єкт, розроблений для навчання AI, а також для запуску великомасштабних моделей і додатків штучного інтелекту. Центри обробки даних для AI Microsoft забезпечують роботу OpenAI, Microsoft AI, наших можливостей Copilot та багатьох інших провідних робочих AI-навантажень.

Новий центр обробки даних для AI Fairwater у Вісконсині є видатним інженерним досягненням, що займає 315 акрів і складається з трьох масивних будівель загальною площею 1,2 млн квадратних футів. Для будівництва цього об'єкта знадобилося 46,6 милі глибоких фундаментних паль, 26,5 млн фунтів конструкційної сталі, 120 миль середньовольтних підземних кабелів і 72,6 милі механічних трубопроводів.

На відміну від типових хмарних центрів обробки даних, які оптимізовані для виконання багатьох менших, незалежних робочих навантажень, таких як розміщення вебсайтів, електронної пошти або бізнес-додатків, цей центр побудований для роботи як один масивний AI-суперкомп'ютер, що використовує єдину плоску мережу, яка з'єднує сотні тисяч новітніх графічних процесорів NVIDIA. Насправді він забезпечить у 10 разів більшу продуктивність, ніж найшвидший суперкомп'ютер у світі сьогодні, що дозволить виконувати робочі навантаження з навчання та висновків AI на рівні, якого ніколи раніше не бачили.

Ефективні AI-моделі покладаються на тисячі комп'ютерів, що працюють разом, оснащених графічними процесорами або спеціалізованими AI-прискорювачами, для обробки масивних паралельних математичних обчислень. Вони з'єднані надзвичайно швидкими мережами, щоб миттєво обмінюватися результатами, і все це підтримується величезними системами зберігання, які зберігають дані (такі як текст, зображення або відео), розбиті на токени — невеликі одиниці інформації, з яких навчається AI. Мета полягає в тому, щоб ці чипи були постійно зайняті, тому що якщо дані або мережа не можуть встигати, все сповільнюється.

Саме навчання AI — це цикл: AI обробляє токени послідовно, робить прогнози щодо наступного, звіряє їх з правильними відповідями та коригує себе. Це повторюється трильйони разів, поки система не стане краще виконувати те, для чого її навчають. Подумайте про це як про тренування професійної футбольної команди. Кожен графічний процесор — це гравець, який виконує вправу, токени — це розіграші, що виконуються крок за кроком, а мережа — це тренерський штаб, який вигукує інструкції та підтримує всіх у синхронізації. Команда повторює розіграші знову і знову, виправляючи помилки, поки не зможе виконати їх ідеально. Зрештою, AI-модель, як і команда, освоює свою стратегію і готова працювати в реальних ігрових умовах.

Спеціально побудована інфраструктура має вирішальне значення для ефективного забезпечення роботи AI. Щоб обчислити математику токенів у цьому масштабі з трильйоном параметрів провідних AI-моделей, ядро центру обробки даних AI складається з виділених AI-прискорювачів (таких як графічні процесори), встановлених на серверних платах поруч з центральними процесорами, пам'яттю та сховищем. Один сервер містить кілька прискорювачів графічних процесорів, з'єднаних для високошвидкісного зв'язку. Потім ці сервери встановлюються в стійку, з комутаторами (ToR), що забезпечують мережеве підключення з низькою затримкою між ними. Кожна стійка в центрі обробки даних з'єднана між собою, створюючи тісно пов'язаний кластер. Ззовні ця архітектура виглядає як багато незалежних серверів, але в масштабі вона функціонує як єдиний суперкомп'ютер, де сотні тисяч прискорювачів можуть навчати одну модель паралельно.

Цей центр обробки даних використовує єдиний, масивний кластер взаємопов'язаних серверів NVIDIA GB200 і мільйонів обчислювальних ядер та екзабайтів сховища, всі вони розроблені для найвимогливіших робочих AI-навантажень. Azure був першим хмарним провайдером, який запустив сервери NVIDIA GB200, стійки та повні кластери центрів обробки даних. Кожна стійка містить 72 графічних процесори NVIDIA Blackwell, з'єднані в єдиний домен NVLink, який забезпечує пропускну здатність 1,8 ТБ між графічними процесорами та надає кожному графічному процесору доступ до 14 ТБ об'єднаної пам'яті. Замість того щоб поводитися як десятки окремих чипів, стійка працює як єдиний, гігантський прискорювач, здатний обробляти 865000 токенів на секунду, що є найвищою пропускною здатністю серед усіх хмарних платформ, доступних сьогодні. Центри обробки даних AI в Норвегії та Великій Британії використовуватимуть подібні кластери та скористаються перевагами наступної розробки AI-чипів від NVIDIA (GB300), яка пропонує ще більше об'єднаної пам'яті на стійку.

Викликом при створенні масштабу суперкомп'ютера, особливо в міру того, як вимоги до навчання AI продовжують вимагати проривних масштабів обчислень, є правильне налаштування мережевої топології. Щоб забезпечити зв'язок з низькою затримкою на кількох рівнях у хмарному середовищі, Microsoft потрібно було розширити продуктивність за межі однієї стійки. Для найновіших розгортань NVIDIA GB200 і GB300 у всьому світі на рівні стійки ці графічні процесори спілкуються через NVLink і NVSwitch зі швидкістю терабайтів на секунду, усуваючи обмеження пам'яті та пропускної здатності. Потім, щоб з'єднати кілька стійок в одну групу, Azure використовує як InfiniBand, так і Ethernet, які забезпечують 800 Гбіт/с, у повній неблокуючій архітектурі, щоб гарантувати, що кожен графічний процесор може спілкуватися з будь-яким іншим графічним процесором на повній швидкості без заторів. А по всьому центру обробки даних кілька груп стійок з'єднані між собою, щоб зменшити кількість переходів і дозволити десяткам тисяч графічних процесорів функціонувати як єдиний суперкомп'ютер глобального масштабу.

При розміщенні в традиційному коридорі центру обробки даних, фізична відстань між стійками створює затримку в системі. Щоб розв'язати цю проблему, стійки в центрі обробки даних AI у Вісконсині розташовані у двоповерховій конфігурації, тому, крім мережевого з'єднання стійок з сусідніми стійками, вони також з'єднані з додатковими стійками над або під ними.

Цей багатошаровий підхід виділяє Azure. Microsoft Azure не тільки була першою хмарою, яка запустила GB200 в масштабі стійки та дата-центру; Microsoft робить це в масовому масштабі з клієнтами сьогодні. Завдяки спільній розробці повного стека з найкращими рішеннями від галузевих партнерів у поєднанні з власними спеціально побудованими системами, Microsoft створила найпотужніший, тісно пов'язаний суперкомп'ютер AI у світі, спеціально побудований для передових моделей.

Традиційне повітряне охолодження не може впоратися зі щільністю сучасного обладнання AI. Центри обробки даних Microsoft використовують передові системи рідинного охолодження — вбудовані труби циркулюють холодну рідину безпосередньо в сервери, ефективно відводячи тепло. Рециркуляція із замкнутим циклом забезпечує нульові втрати води: вода потрібна лише для одноразового заповнення, а потім постійно використовується повторно.

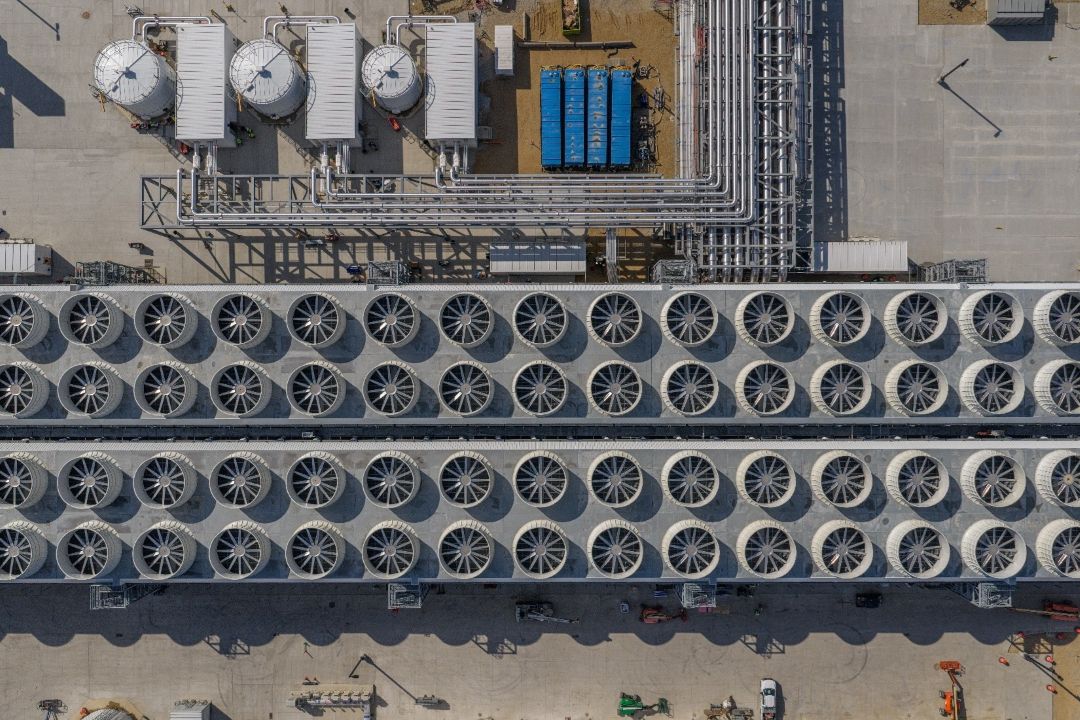

Спеціально проєктуючи центри обробки даних для AI, Microsoft змогла вбудувати інфраструктуру рідинного охолодження безпосередньо в об'єкт, щоб отримати більшу щільність стійок у дата-центрі. Fairwater підтримується другою за величиною у світі водоохолоджувальною чилерною установкою, яка буде безперервно циркулювати воду у своїй системі охолодження із замкнутим циклом. Потім гаряча вода відводиться до охолоджувальних «ребер» з кожного боку центру обробки даних, де 172 20-футові вентилятори охолоджують і повертають воду назад до центру обробки даних. Ця система підтримує ефективну роботу центру обробки даних AI, навіть при пікових навантаженнях.

Понад 90% потужностей центрів обробки даних Microsoft використовують цю систему, що вимагає води лише один раз під час будівництва та постійно використовує її повторно без втрат на випаровування. Решта 10% традиційних серверів використовують зовнішнє повітря для охолодження, переходячи на воду лише в найспекотніші дні — конструкція, яка значно зменшує використання води порівняно з традиційними дата-центрами.

Microsoft також використовує рідинне охолодження для підтримки робочих навантажень AI в багатьох власних наявних центрах обробки даних; це рідинне охолодження здійснюється за допомогою блоків теплообмінників (HXU), які також працюють з нульовим використанням води.

Сучасні центри обробки даних можуть містити екзабайти сховища та мільйони обчислювальних ядер CPU. Для підтримки кластера інфраструктури AI потрібна абсолютно окрема інфраструктура дата-центру для зберігання та обробки даних, що використовуються та генеруються кластером AI. Щоб навести приклад масштабу — системи зберігання центру обробки даних AI у Вісконсині мають довжину п'ять футбольних полів.

Було перероблено сховище Azure для найвимогливіших робочих навантажень AI, у масштабах цих масивних розгортань центрів обробки даних для справжнього суперкомп'ютерного масштабу. Кожен обліковий запис Azure Blob Storage може підтримувати понад 2 млн операцій читання/запису на секунду, а завдяки мільйонам доступних облікових записів можна еластично масштабуватися, щоб задовольнити практично будь-які вимоги до даних.

За цією можливістю стоїть фундаментально перероблена основа сховища, яка об'єднує місткість і пропускну здатність тисяч вузлів зберігання та сотень тисяч дисків. Це забезпечує масштабування сховища до екзабайтного масштабу, усуваючи необхідність ручного сегментування та спрощуючи операції навіть для найбільших робочих навантажень AI та аналітики.

Ключові інновації, такі як BlobFuse2, забезпечують високу пропускну здатність і доступ з низькою затримкою для локального навчання вузлів графічних процесорів, гарантуючи, що обчислювальні ресурси ніколи не простоюють і що масивні набори даних для навчання AI завжди доступні, коли це потрібно. Підтримка декількох протоколів дозволяє безперебійну інтеграцію з різноманітними конвеєрами даних, тоді як глибока інтеграція з аналітичними механізмами та інструментами AI прискорює підготовку та розгортання даних.

Автоматичне масштабування динамічно розподіляє ресурси в міру зростання попиту, у поєднанні з розширеною безпекою, стійкістю та економічно ефективним багаторівневим сховищем, платформа сховища Azure задає темп для робочих навантажень наступного покоління, забезпечуючи необхідну продуктивність, масштабованість і надійність.

Нові центри обробки даних для AI є частиною глобальної мережі центрів обробки даних Azure AI, з'єднаних через глобальну мережу (WAN). Йдеться не про одну будівлю, а про розподілену, відмовостійку та масштабовану систему, яка функціонує як єдина, потужна машина AI. AI WAN компанії створена з можливостями зростання в масштабах пропускної здатності, характерних для AI, щоб забезпечити широкомасштабне розподілене навчання в кількох, географічно різнорідних регіонах Azure, що дозволяє клієнтам використовувати потужність гігантського суперкомп'ютера AI.

Це фундаментальний зсув у нашому мисленні про суперкомп'ютери AI. Замість того щоб бути обмеженими стінами одного об'єкта, будується розподілена система, де обчислювальні ресурси, сховище та мережеві ресурси безперебійно об'єднуються та оркеструються в регіонах центрів обробки даних. Це означає більшу відмовостійкість, масштабованість і гнучкість для клієнтів.

Щоб задовольнити критичні потреби найбільших викликів AI, було потрібно переробити кожен шар інфраструктури хмарного стека. Йдеться не просто про ізольовані прориви, а про поєднання кількох нових підходів у сферах чипів, серверів, мереж і центрів обробки даних, що призводить до досягнень, де програмне та апаратне забезпечення оптимізуються як одна спеціально побудована система.

Центр обробки даних Microsoft у Вісконсині відіграватиме критично важливу роль у майбутньому AI, побудованому на реальних технологіях, реальних інвестиціях і реальному впливі на суспільство. Коли цей об'єкт буде з'єднано з іншими регіональними центрами обробки даних, і коли кожен шар інфраструктури Microsoft буде узгоджений як повна система, відкриється нова ера інтелекту, що працює на хмарі, безпечну, адаптивну та готову до того, що буде далі.