|

СПЕЦІАЛЬНІ ПАРТНЕРИ ПРОЕКТУ BEST CIOОпределение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях Человек годаКто внес наибольший вклад в развитие украинского ИТ-рынка. Продукт годаНаграды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары |

Розподілена інфраструктура як нова норма цифрової економіки

Автор – Тимур Ягофаров, 20 ноября 2025 г.

У міру того, як швидко наростає обсяг даних, що використовуються в бізнесі, на передній план виходить архітектура розподіленого підприємства. Слухаючи виступ Дениса Вілфорта (Denis Vilfort), директора з розвитку бізнесу HPE на цьогорічному заході компанії Discovery 2025, мимоволі починаєш ловити себе на думці: те, що десять років ще тому називали «розподіленою інфраструктурою», сьогодні виглядає як нова норма цифрової економіки. Стало очевидно, що корпоративні дані давно покинули колишні фортеці - закриті дата-центри, зосереджені в одному місті, - і рушили туди, де працюють люди, стоять камери, відбуваються транзакції, де виникають ризики та можливості. Саме про це й ішлося у виступі: світ більше не працює за логікою «одного центру», і тепер кожен магазин, або готель, або офіс, або навіть лікарський кабінет фактично стає власним вузлом обчислень і центром даних.

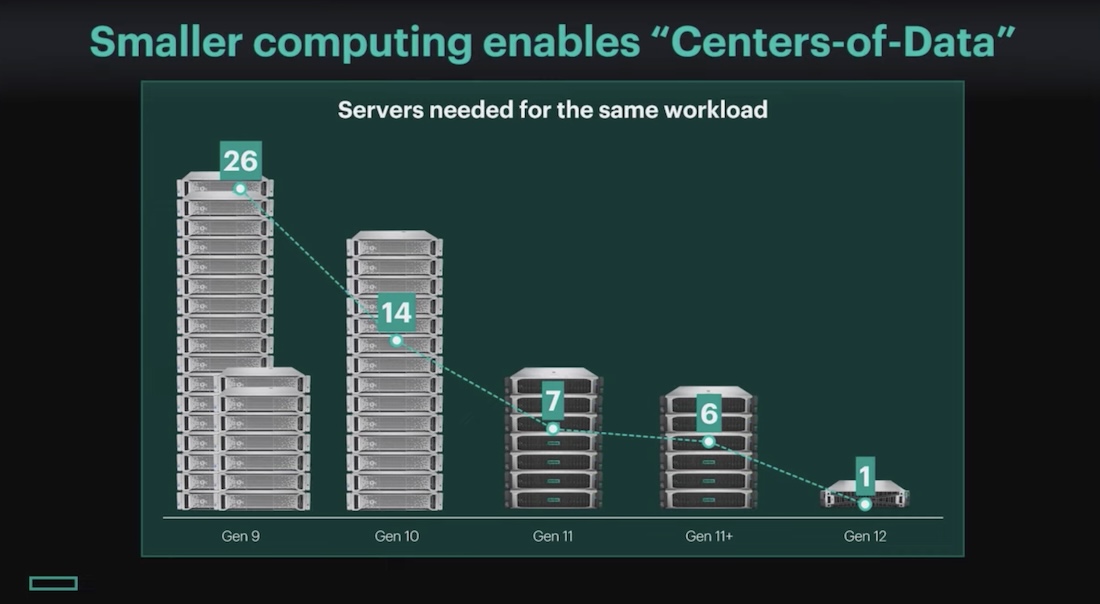

Це не маркетингова метафора - це наслідок технічної еволюції. Сервери стали не лише потужнішими, а й значно компактнішими. Денис Вілфорт іронізував: «Honey, I shrunk the data center». Колись для типового обчислювального навантаження потрібні були двадцять шість шаф, набитих 1U-серверами. Сьогодні те саме можна виконати на одному сервері з GPU й багатоядерними CPU. І головне - ця мініатюризація зменшила не лише розмір, а й енергоспоживання, а також відкрила шлях до локальних AI-навантажень, які раніше здавалося логічним відправляти у публічну хмару. Але «відправляти» - дедалі менш реалістичний сценарій. Трафік не встигає за ростом даних. HPE у власних тестах зіткнулася з показовим прикладом: внутрішній сервіс QA, який мав працювати за секунду, у публічній хмарі займав 21 секунду лише через те, що дані фізично не встигали проходити доступними каналами. Проблема не в тому, що у хмари мало обчислювальних ресурсів. Проблема в «діаметрі соломинки», якою качають дані.

Саме тому Денис Вілфорт так наполегливо говорив про «data gravity». Коли у магазині система відеоаналітики виявляє підозрілу поведінку покупця, у служби безпеки є секунди - не хвилини. Ніхто не буде чекати, поки фрейми відео докотяться до дата-центру в іншому штаті. Або в медицині: PET-скан з одного пацієнта - це 2 ТБ «слайсів» людського тіла. Лікар може працювати з цією моделлю як з тривимірною реконструкцією, перегортати її, нахиляти, шукати патології. Але якщо пацієнт переїхав з Сіетла до Флориди, його медична історія має переїхати разом із ним. Не файлами на флешці - а як частина безшовної інфраструктури, яку лікарі можуть бачити через єдиний простір імен незалежно від географії.

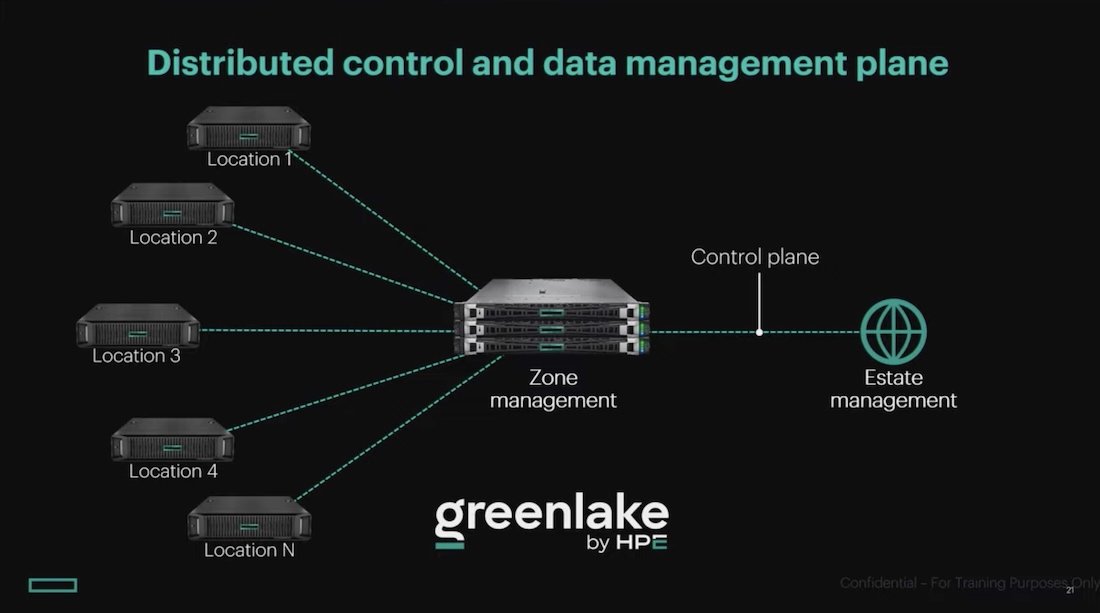

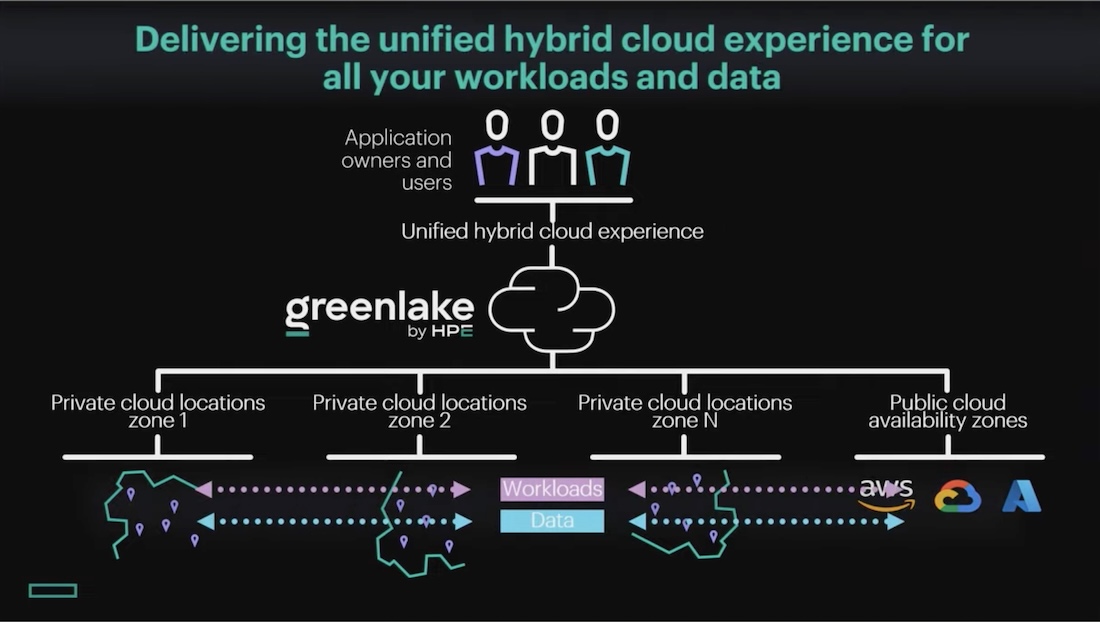

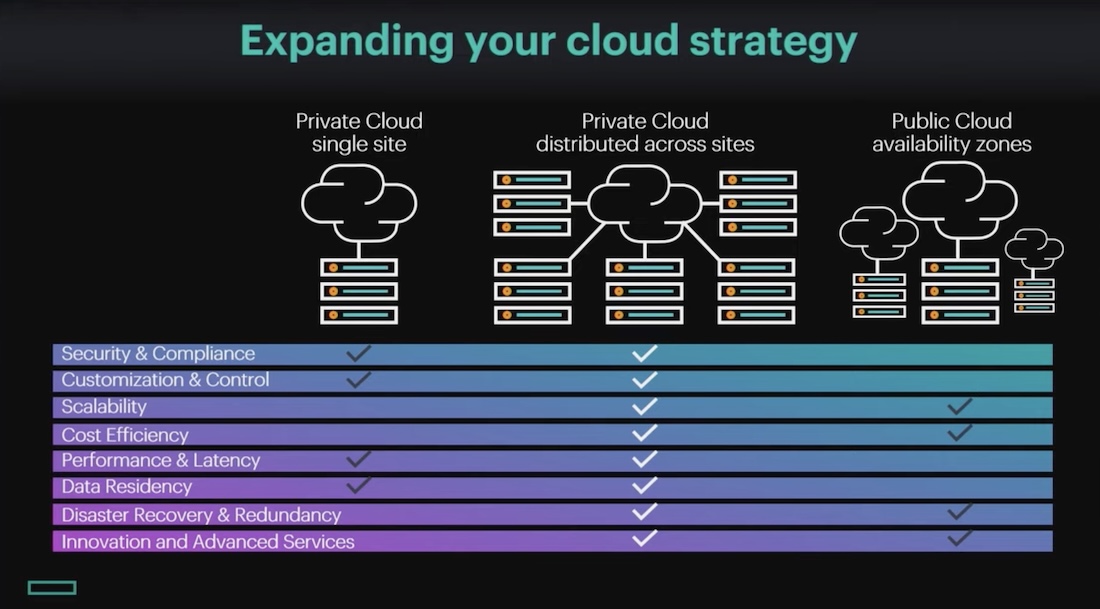

Саме це HPE називає приватною розподіленою хмарою. Не «данина моді», а необхідна модель для бізнесів, де десятки чи сотні локацій створюють дані щосекунди: від роздробу до лікарень, від виробництва до готельних мереж. Розподілена хмара має такі ж переваги контролю, як і корпоративний дата-центр, і таку ж гнучкість, як публічна хмара. І, найголовніше, дає компанії можливість миттєво переносити навантаження між локаціями. Якщо Чикаго перевантажене, робочі процеси можуть переїхати до Сіетла або Нью-Йорка - так само автоматично, як це відбувається у хмарних провайдерів, але в межах вашої власної інфраструктури. На цьому тлі природним виглядало входження у розмову GreenLake. Денис Вілфорт зауважив, що GreenLake колись сприймали лише як спосіб «платити за інфраструктуру за споживанням». Але на практиці, коли компанія бере на себе облік, моніторинг, розгортання та життєвий цикл інфраструктури, вона поступово переходить від моделі «as a service» до моделі «as a platform». GreenLake із набору інструментів керування перетворився на повноцінну операційну модель.

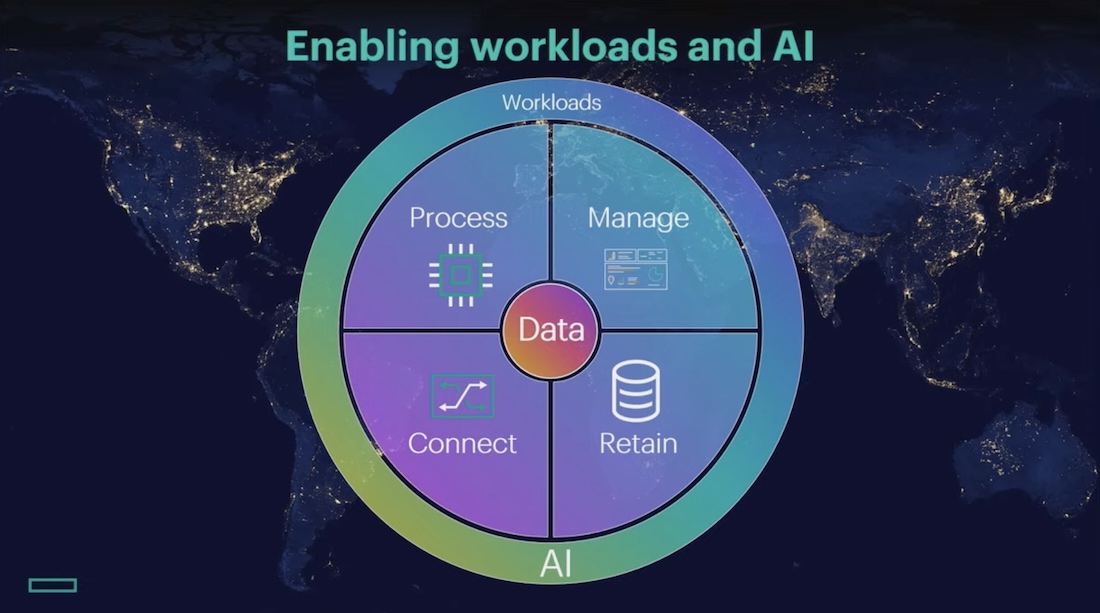

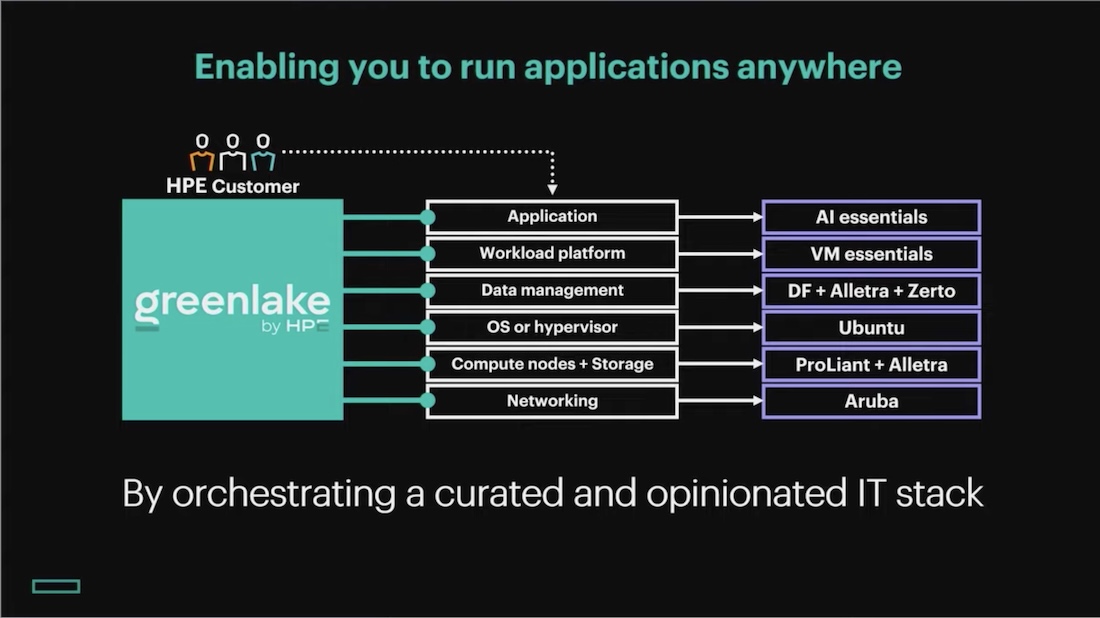

А вона, у свою чергу, складається з чітко структурованого технологічного «layer cake» HPE: спершу мережа (Aruba), потім живлення, потім сервери та сховища (ProLiant, Alletra), далі операційне середовище - Ubuntu з вбудованою в нього віртуалізацією HPE VME, яка не вимагає запускати Kubernetes усередині VM. Це робить контейнери «першокласними» компонентами інфраструктури. Далі - рівень даних: Zerto, Ezmeral Data Fabric, інструменти реплікації й захисту. І тільки тоді, на самій верхівці, з’являється те, заради чого все й існує, - робоче навантаження: AI, відеоаналітика, роздрібні операції, телеметрія, медичні обчислення. Саме в цю струнку архітектуру Денис Вілфорт вплітає агентну AI-модель. Кожен рівень - сервери, мережі, зберігання, контейнери - отримує власного агента, який постійно оцінює стан компонентів і сигналізує про дисбаланс. У компанії це називають «stack alignment» - вирівнювання стеку: якщо мережа працює повільніше, ніж очікує GPU, або диски не витягують IOPS, агенти попереджають про це ще до того, як проблема потрапить до користувача чи бізнес-процесу.

З цієї точки зору особливо показовим стало введення Денисом Вілфортом концепції OODA-loop, військової моделі прийняття рішень: Observe, Orient, Decide, Act. У сучасному бізнесі, де час реакції на події скорочується до секунд, OODA-петлі стають не просто аналогією, а базовим цифровим механізмом. Камери спостереження, сенсори, каси самообслуговування, електронні етикетки, виробничі датчики - усе це «observer». Платформа GreenLake з аналітичним шаром - «orient». А action - це або автоматичне рішення системи, або дія персоналу, який отримує сигнал у момент події. І чим коротша петля, тим більша ефективність, безпека й прибутковість. HPE стверджує, що агентна складова GreenLake фактично автоматизує частини OODA-циклу, перетворюючи розподілену інфраструктуру на екосистему дрібних, але постійно діючих «розумних вузлів». І саме це, а не окремі сервери чи GPU, створює реальну додану вартість: мережа взаємодіючих агентів, які безперервно оптимізують інфраструктуру.

Зрештою, усе це зводиться до простого принципу: приватна хмара має працювати як публічна, але належати вам. Компанія має контролювати дані, розташування робочих навантажень, використані інструменти й вибір технологій. Денис Вілфорт навіть жартував, що якщо хтось хоче розгортати Nutanix - будь ласка, VMware - будь ласка, Red Hat - теж без проблем. GreenLake не вимагає закритих стандартів: він покликаний стати універсальним середовищем, яке не нав’язує технології, а дозволяє їх інтегрувати. Для компаній з сотнями локацій ця логіка стає не теорією, а життєвою необхідністю. Бо від ефективності розподіленої хмари залежить не лише швидкість реагування на події, а й витрати, безпека, стабільність і здатність масштабуватися без болю й простоїв.

Саме в цю точку і влучав виступ Дениса Вілфорта - у розуміння того, що сьогоднішні дані не просто ростуть, а розповзаються геометрично, вимагаючи від інфраструктури не «пристосування», а переосмислення. HPE просуває ідею не «хмари десь там», а «хмари скрізь, де є ваш бізнес». Приватної, розподіленої, керованої агентами, здатної працювати ближче до даних і швидше реагувати на події. У фіналі Денис Вілфорт підкреслив, що HPE не просто продає обладнання, а разом із клієнтом будує й експлуатує ці розподілені платформи роками. «Це ваша хмара, ваше завдання, ваша логіка роботи, але ми поруч. Ми будуємо це разом із вами», - зазначив він. У залі це викликало помітну реакцію, бо для більшості компаній саме співпраця з постачальником, а не окремі технології, стає визначальним фактором успіху.

У результаті виступ Дениса Вілфорта перетворився на концентровану картину того, яким стане розподілений бізнес найближчі роки. Не гучні слайди, не футуризм, а дуже прагматична історія про те, як дані, яких за останні 10 років стало у 1250 разів більше, формують новий технічний ландшафт. І про те, що хмара майбутнього не десь далеко - вона стоїть під столом у кожній локації, обробляє події у реальному часі й зшиває бізнес у єдину систему, де дані мають вагу, а рішення приймаються тоді, коли це має значення - зараз.

Стратегія охолодження ЦОД для епохи AI

Читайте также

|

Останні обговоренняТОП-новости

ТОП-блогиТОП-статьи

|

||||||||||