|

СПЕЦІАЛЬНІ

ПАРТНЕРИ

ПРОЕКТУ

Определение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях

Кто внес наибольший вклад в развитие украинского ИТ-рынка.

Награды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары

|

|

7 июля 2016 г., 17:25

Mozilla представила на днях новый проект Context Graph, задача которого — помочь пользователям в поиске нового полезного контента на основе анализа их текущей браузерной активности.

Это система рекомендаций нового поколения для веба. Например, много веб-страниц содержат ссылки на один и тот же ролик YouTube, но не существует способа попасть на все эти страницы из самого видео. Изучение этой сети ссылок позволит Context Graph выработать наилучшие рекомендации.

Очевидно возникающие вопросы сохранения приватности Mozilla рассчитывает решить с привлечением к участию в создании экспериментальных систем контекстных рекомендаций группы пользователей-волонтёров. Вице-президент Firefox, Ник Нгуэн (Nick Nguyen), заверяет, что Context Graph будет открытым проектом и пользователи смогут самостоятельно контролировать, какие сведения они предоставляют и что получают взамен.

Как и другие недавние инициативы Mozilla, новый проект призван противодействовать тенденции постепенного закрытия Веба. Как заявил Нгуэн, их тревожит долгосрочная перспектива мира, в котором горсть компаний доминирует в технологиях и сервисах обнаружения информации, и те возможности для воздействия, которые предоставляет такое состояние дел.

Mozilla сообщает, что одним из элементов Context Graph является функция Activity Stream уже дебютировавшая в майском расширении Firefox — Test Pilot. Activity Stream облегчает пользователям навигацию по истории браузера, помогает им находить полюбившиеся в прошлом веб-сайты, но в дальнейшем, эта функция будет служить также для открытия ранее не посещавшихся ими сайтов.

1 июля 2016 г., 14:15

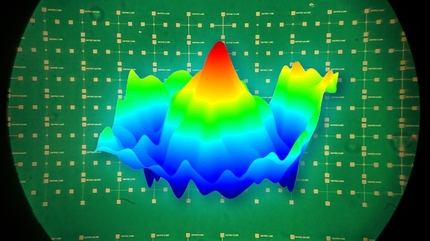

Увы, но Гарри Каспаров проиграл бы машине даже пересев в истребитель: искусственный интеллект отпраздновал ещё одну победу над человеком. Разработанная в Университете Цинциннати при участии компании Psibernetix система Alpha одержала верх в сражении на высокодостоверном симуляторе воздушного боя над полковником ВВС США в отставке Дженом Ли (Gene Lee).

Ли является инструктором подготовки пилотов истребителей и менеджером воздушных боев (Air Battle Manager) с огромным практическим опытом. Противостоявшая ему в симуляторе система, по отзывам этого эксперта, была самым агрессивным, динамично реагирующим и достоверным ИИ, из всех, которые он видел до сих пор.

Издание Journal of Defense Management, в котором опубликована подробная статья об Alpha, характеризует её как важный прорыв в прикладных системах, построенных на нечётких генетических алгоритмах. Проект этот создавался в исследовательских целях для управления беспилотными аппаратами в симулированных сценариях воздушных боев.

В её ранних воплощениях, Alpha постоянно побеждала базовую компьютерную программу, использовавшуюся Исследовательской лабораторией ВВС США. Иными словами, разбивала наголову всех своих искусственных противников. Именно эти непрекращающиеся победы заставили Ли в октябре прошлого года взять в собственные руки управление виртуальным истребителем.

В ходе многих попыток, эксперту так и не удалось сбить новейшую модификацию Alpha. Более того, он сам ни разу не смог выйти из боя непобежденным. После этого первого опыта взаимодействия человека с машиной, Alpha гарантированно расправлялась с любым выставленной против неё экспертом, в том числе в изначально неблагоприятных для неё условиях с ограничениями, наложенными на скорость, радиус поворота, на датчики и ракетные установки.

Lee, который встречается в симуляторах с ИИ с начала 1980-х, заявил, что уже в первом противостоянии с Alpha он был поражён осмысленностью и скоростью реакции системы: «Казалось, она была в курсе моих намерений, реагировала мгновенно на мои манёвры и выпуск ракет. Она знала как уйти от удара и, при необходимости, моментально переходила от защиты к нападению».

По его мнению опытный пилот может получить от ИИ ракету в корпус, пробуя что-то новое, но, как правило, они побеждает большинство программ ИИ если действует агрессивно и использует надежно наработанные тактические приёмы.

Однако теперь уже сам Ли, тренировавшийся с тысячами пилотов и закончивший U.S. Fighter Weapons School (аналог ученой степени в тактике и стратегии боя), вместе с другими экспертами оказался неспособен противостоять давлению и темпу сражения, навязанному искусственным разумом. «Я шёл домой чувствуя себя выжатым подчистую. Я был усталым, опустошенным и умственно истощенным. Это может быть и искусственный интеллект, но он представляет вполне реальный вызов моим способностям».

Безраздельно царящая в виртуальном небе Alpha очевидно представляет собой будущее воздушных сражений. Она способна считывать всю совокупность показаний датчиков, моделировать сценарий боя и выявлять после ситуационного анализа наилучший тактический план в 250 раз быстрее, чем человек-противник успевает моргнуть.

Что особенно удивляет, для всего этого – уклона от нескольких ракет с одновременной стрельбой по нескольким целям во взаимодействии с другими истребителями звена – вовсе не требуется мощь суперкомпьютера. Алгоритмы нечёткой логики Alpha, а точнее их подкласс Genetic Fuzzy Tree (GFT), отлично работают в реальном времени даже на ресурсах низкобюджетного Raspberry Pi.

Обычно такие алгоритмы хорошо справляются с задачами, имеющими до четырех или пяти входных параметров. Расширить их возможности на учёт сотни одновременных данных удалось, разбив процесс на каскады промежуточных решений, и применив вместо численного управления лингвистическое.

Своего современного уровня результативности Alpha достигла после тренировки на потребительском ПК стоимостью $500, включавшей состязания между автоматически генерируемыми и настраиваемыми вручную версиями программы, выбиравшимися случайным образом. Успешные экземпляры кода комбинировались и воспроизводились в следующих поколениях ПО, в соответствии с генетической частью алгоритма GFT.

29 июня 2016 г., 11:45

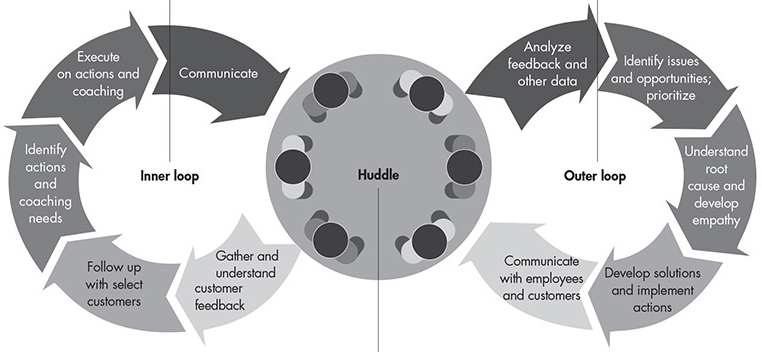

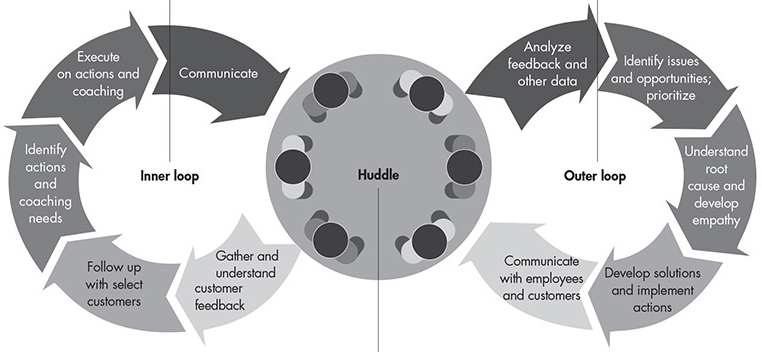

Переход от ПО уровня предприятия к выполняющему те же функции облачному сервису – это гигантская трансформация, как считает исполнительный директор Genesys, Поль Сегре (Paul Segre). «Когда вы продаёте ПО, вы устанавливаете его на предприятии и, возможно, настраиваете, – говорит он. – Но собственно работой с ним занимается партнёр или сам заказчик. Если мы продаём облачное решение, то мы же выступаем и провайдером сервиса, работающим в постоянном контакте с клиентом».

Для Genesys, ведущей компании в сфере ПО для контакт-центров, необходимость такого непрерывного взаимодействия потребовала понимать как к ней относятся клиенты. «Мы стараемся узнать не о продукте или его функциональности, а о том говорим ли мы с нужными людьми и в нужное время. Возможно, они розничные продавцы и не настроены общаться с нами в «Чёрную пятницу» – такими вопросами мы никогда не задавались в мире локальных сервисов (on-premise)».

Многие годы провайдеры корпоративных технологий отлично себя чувствовали с самыми низкими в индустрии показателями удовлетворенности клиентов (Customer Experience). Так, в представленном калифорнийской консалтинговой фирмой Bain & Company исследовании, охватившем 1200 корпоративных заказчиков среднее значение показателя Net Promoter Score составляло 14 для продавцов оборудования, 13 для провайдеров сервисов бизнеса-процессов и три для корпоративного ПО! Для сравнения, тот же индекс в ориентированных на клиента отраслях достигал 33 (для гостиниц) и 62 (для супермаркетов).

Держаться на плаву со столь низким рейтингом корпоративным технологиям отчасти помогала модель ориентации маркетинга не на конечных пользователях и учете их нужд, а на директорах по ИТ. Кроме того, один раз инвестировав в ПО и оборудование компании неохотно шли на новые расходы, сопряжённые с изменением провайдеров, даже если полученные технологии не оправдывали возлагавшиеся на них ожидания.

Это быстро меняется сейчас, когда модели подписки на облачные вычисления трансформируют взаимоотношения между вендором и покупателем, вовлекают больше бизнес-клиентов в процесс принятия решения. «Люди, покупающие облако, уже не те, кто покупал on-premise решения, – утверждает Сегре. – Часто это сами пользователи, возможно, отказавшиеся от собственных ИТ-отделов. Их ожидания совсем другие и Net Promoter информирует нас о том, чего от нас хотят как от сервис-провайдера».

В работе с более чем двумя тысячами компаний, строящих системы клиентской удовлетворенности, специалисты Bain сформулировали ряд ключевых требований, необходимых для успеха в их реализации.

Создание организации, ориентированной на улучшение опыта заказчиков, это длительный процесс, требующий полной поддержки со стороны руководства и административной команды на протяжении трёх-пяти лет. При этом опираться нужно на надёжную систему мониторинга успешности трансформации: более двух третей компаний, участвовавший в упомянутом выше исследовании, в качестве такой метрики использовали Net Promoter Score.

Очень важно учитывать опыт работы конечных пользователей, все чаще влияющих на решения о расширении и продолжении облачной подписки, – то что им нравится и то, что раздражает. SaaS-приложения создают новые возможности для понимания и для опережающих действий по устранению потенциальных причин для недовольства. В идеале, клиент вообще не должен сообщать провайдеру о неполадках или о том, какие функции использует больше всего – тот должен быть в курсе всего этого и использовать эту информацию для постоянного улучшения удовлетворения заказчиков.

Разработчики должны отказаться от устаревших методологий с длинными циклами и применять более восприимчивые к критическим потребностям конечных пользователей подходы, такие как Agile.

Также необходимо кропотливое создание отлаженной инфраструктуры операций и аналитики, а также корпоративной культуры внимания к клиенту: путем целевого найма новых сотрудников, непрерывного обучения уже имеющегося штата, системы инициатив и поощрений.

Ряд вендоров, включая Microsoft, Salesforce, SAP и Ariba, создают сети сервис-провайдеров или вводят в свой штат должность менеджеров по успеху заказчика (Customer Success Manager, CSM) для помощи клиентам в трансформации их процессов с максимальным сохранением имеющихся инвестиций. CSM работают вместе с отделами продаж, но независимо от них и играют роль выразителя и защитника интересов клиента. Так, по словам одного из клиентов Salesforce, общение с CSM привлекает его тем, что нацелено на улучшение выполнения работы, а не на то, чтобы заставить его купить расширения и новые продукты.

Для Genesys разработка и внедрение комплексной системы, ориентированной на опыт корпоративных клиентов, заняли два года, но окупили себя ростом показателя Net Promoter Scores на 30 пунктов с начала 2014 до конца 2015 г.

24 июня 2016 г., 13:45

Доклад Forrester Research предсказывает, что системы искусственного интеллекта (ИИ), к которым относят роботов, автоматизацию, умное оборудование и средства машинного обучения, к 2025 г. сократят общее количество рабочих мест в США на 7%. Эта цифра получена как результат вычитания из 16% замещаемых роботами позиций 9% новых возможностей трудоустройства, которые они создадут.

Аналитики Forrester Крейг Леклер (Craig LeClair) и Джей Пи Гаундер (J.P. Gownder), опубликовавшие эти прогнозы в среду, сулят обеспокоенным открывающимися перспективами неолуддитам новые, более интересные занятия. Они полагают, что в следующие девять лет умные технологии приведут к появлению в США 13,9 млн новых рабочих мест.

«Когнитивная эра создаст новые работы, такие как специалисты по контролю за роботами, аналитики данных и кураторы контента, – утешают авторы доклада. – Но ещё более драматичной будет трансформация существующих работ, например, превращение низкоквалифицированных специальностей по вводу данных в более высокоуровневые позиции аналитики или поддержки клиентов».

В качестве иллюстрации, Леклер и Гаундер приводят когнитивную платформу Watson компании IBM, которая может сократить время, затрачиваемое специалистами на анализ данных, освободив его для более творческих занятий, таких как интерпретация результатов. Устранение рутинных обязанностей, согласно Forrester, не только сделает работу интереснее, но и улучшит моральное состояние служащих, поможет уменьшить текучку.

Непосредственное общение с человеческим персоналом приобретает все большую важность для клиентов, перегруженных избыточной информацией из мобильных приложений, социальных сред, почтовых рекламных кампаний и с сайтов рекомендаций.

«Кабинетные работники продолжат терять свои места, хотя и не так быстро, как полагают некоторые паникёры, – резюмируют Леклер и Гаундер. – Но мы установили, что меняющийся характер работ будет иметь даже более серьёзные последствия, чем потеря занятости».

Первым «под раздачу» попадет офисный планктон персонал, службы административной поддержки – пик увольнений среди этих категорий придётся на период с 2016 по 2020 гг. Также пострадают служащие отделов продаж и сопутствующие профессии. Меньше всего нашествие роботов, не нуждающихся в отпусках и социальных пакетах, затронет врачей, финансистов – всех тех, чей род занятий требует креативного мышления и обширного багажа знаний.

В целом, в своих заключениях Forrester примыкает к оптимистичной части исследователей искусственного интеллекта, считающих, что прогресс в умных системах и робототехнике лишь поможет людям быстрее и лучше справляться со своими рабочими обязанностями.

21 июня 2016 г., 16:25

На следующий виток эволюции компьютеры поднимутся не за счёт прироста быстродействия уже существующих процессоров, а благодаря качественным изменениям аппаратной архитектуры. Именно такую задачу поставила перед собой корпорация Hewlett Packard Enterprise (HPE) в проекте нейроморфного компьютера.

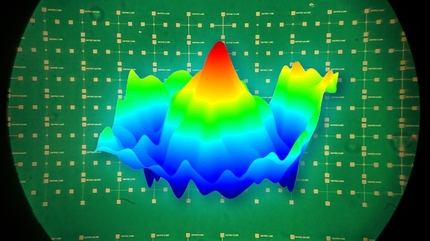

Ранний прототип такого компьютера, эмулирующего деятельность человеческого мозга, – Dot Product Engine – компания впервые показала на недавней конференции Discover в Лас-Вегасе (штат Невада). Конечная цель этого проекта – устройство, которое будет способно строить ассоциативные связи, использовать модели и алгоритмы обучения, подобно тому как это делаем мы, и за счёт этого обрабатывать информацию более быстрыми темпами и выдавать вероятностные результаты, пригодные для принятия решений.

Разумеется, потребуются годы и годы, прежде чем такая технология будет готова к массовому применению. Пока что, компания экспериментирует на концептуальном уровне, используя прототип, базирующийся на ее собственной мемристорной технологии в сочетании с особой архитектурой, позволяющей выполнять множество параллельных операций с многоуровневыми данными непосредственно в ячейках, где они хранятся.

Подобный подход, по словам сотрудника Hewlett Packard Labs, Кэт Грейвз (Cat Graves), позволит добиться громадного выигрыша в энергопотреблении, сэкономить много времени, снизить сложность вычислений и разгрузить внутрисистемные линии коммуникаций.

На продемонстрированной на конференции установке, предназначенной для перемножения матриц, ученые за один такт выполняли 8 тыс. операций. В реальном чипе быстродействие будет ещё выше благодаря интеграции в него всего того оборудования, которое в настоящее время реализовано на отдельных платах.

По своей природе нейроморфный процессор не предназначен для выдачи точных результатов. Это означает, что он никогда не заменит центральные или графические процессоры общего назначения. Тем не менее, его можно будет использовать в качестве сопроцессора, для ускорения интеллектуальных задач, таких как распознавание речи, фильтрация изображений или глубокое обучение.

«Хотя мы пока не знаем всех ответов, но уже начинаем прояснять ряд полезных моментов», – заявила Грейвз.

Помимо HPE, в области нейроморфных вычислений экспериментируют и другие компании, в том числе Qualcomm, использующая программный подход, и IBM, которая работает с другой процессорной архитектурой.

17 июня 2016 г., 16:35

Мемристор – полоска оксида переходного металла между двумя электродами, меняющая сопротивление в зависимости от положительного или отрицательного импульса напряжения, – был предложен в качестве четвертого базового устройства электроники (наряду с резистором, конденсатором и соленоидом) ещё в 1971 г. С тех пор мемристоры стали предметом многочисленных исследований, существенно прояснивших природу протекающих в них процессов, но ряд деталей, критичных для создания схем компьютерной памяти, до сих пор вызывают споры среди учёных.

Благодаря кооперации с двумя национальными лабораториями Министерства энергетики США – SLAC National Accelerator Laboratory и Lawrence Berkeley National Laboratory – группа исследователей из компании Hewlett Packard Enterprise (HPE) смогла уточнить особенности работы мемристора на атомном уровне. Результаты экспериментов опубликованы в журнале Advanced Materials.

Для углублённого изучения на оборудовании Stanford Synchrotron Radiation Lightsource (SSRL) в SLAC и Advanced Light Source (ALS) в Berkeley Labs авторы выбрали наиболее легко контролируемые устройства а основе оксида тантала.

С помощью рентгеновского излучения ALS интенсивностью 500 эВ и сканирующего трансмиссионного рентгеновского микроскопа, команда HPE создала карту размещения атомов кислорода до и после переключения состояния мемристора. Она показала, что импульс напряжения, отключающий сопротивление, оттягивает атомы кислорода примерно на 200 нм с проводящего пути.

Эксперименты прояснили, что даже слабых импульсов достаточно для создания такого пути в оксиде. За время действия импульса эта дорожка нагревается, что вызывает отталкивание атомов кислорода и дополнительно увеличивает электропроводность. Изменение полярности импульса обнуляет мемристор, втягивая атомы кислорода обратно и увеличивая сопротивление устройства. Разница между значениями напряжения может составлять от одного до шести порядков, в зависимости от таких параметров, как амплитуда управляющего импульса.

Для того, чтобы аналогичным образом визуализировать перемещения атомов тантала требовались рентгеновские лучи, обладающие более высокой энергией. Нужная интенсивность, 10 тыс. эВ, была достигнута в Berkeley Labs на отводе Beam Line 6-2 синхротронного источника SSRL. Одной сессии здесь оказалось достаточно, чтобы подтвердить предположения ученых: атомы тантала при переключении оставались неподвижными.

Наиболее важный итог эксперимента, по словам главного автора статьи, Сухаса Кумара (Suhas Kumar), заключается в том, что даже после более чем миллиарда импульсов с амплитудой напряжения, достаточной для коммерческого использования, ученым не удалось заметить никаких признаков ухудшения рабочих характеристик мемристора. Это позволило сконстуировать устройства, которые превзошли по циклической стабильности лучшие известные аналоги примерно в тысячу раз.

Кроме того, ученые пробовали увеличить производительность мемристоров, повышая напряжение, и возникающие сбои в работе устройств дали им дополнительную пищу для размышлений. Причина неполадок заключалась в том, что атомы кислорода отводились слишком далеко и не могли вернуться на свои прежние позиции.

Кумар отмечает, что помимо чипов энергонезависимой памяти, мемристоры, благодаря высокому быстродействию коммутации и малым по сравнению с транзисторами габаритам, могут с успехом использоваться и в логических схемах. Их некоторые дополнительные свойства окажутся полезны при реализации нового класса, так называемых нейроморфных компьютеров.

10 июня 2016 г., 10:20

Сеть Интернет создала миллионы новых возможностей для людей во всем мире и сделала сумму человеческих знаний доступной для любого, имеющего подключение, но она же породила проблемы, которые, похоже, в её рамках невозможно решить. И они далеко не исчерпываются засильем фотографий котиков.

«Эдвард Сноуден показал, что нами необратимо создана крупнейшая в мире сеть надзора», – заявил Брюстер Кайле (Brewster Kahle), глава некоммерческой цифровой библиотеки бесплатного контента, Internet Archive. Власти во всем мире пытаются избирательно ограничивать доступ своих граждан к онлайновому контенту, вводят цензуру Веба, формируя выгодное для себя общественное мнение.

По мнению сэра Тима Бернерса-Ли (Tim Berners-Lee), то как по прошествии 37 лет используется его изобретение полностью нивелирует изначальную идею содействия творческому проявлению каждой личности.

Для обсуждения возможной концепции построения и эксплуатации будущей информационной сети, свободной от контроля со стороны правительств и мегакорпораций, Бернерс-Ли, Кайле и другие видные деятели, в том числе один из авторов протокола TCP/IP Винт Серф (Vint Cerf), глава проекта Mozilla Митчелл Бейкер (Mitchell Baker) и специальный советник Electronic Frontier Foundation Кори Доктороу (Cory Doctorow) собрались на мероприятии Decentralized Web Summit в Сан-Франциско (штат Калифорния).

На саммите, который проходил 8 и 9 июня, также поднимались вопросы улучшения шифрования и отчётности, уменьшения зависимости создателей контента от рекламных доходов путём разработки защищённых прямых методов платежа на базе криптовалюты для подписчиков. «Сегодняшний потребитель, чтобы получить что-то «бесплатно» должен идти на сделку с маркетинговой машиной, стараясь не думать, что случится дальше с его персональными данными, – комментирует Бернерс-Ли. – Представьте мир, в котором оплата была бы простой для обоих участников сделки».

Хотя мысль о том, что над этими проблемами думают столько умных голов, вроде бы навевает оптимизм, простая логика подсказывает, что даже новый с иголочки, созданный под лозунгом «заблокировать Веб в открытом виде» (locking the web open), Интернет в силу самой человеческой природы будет замусорен и быстро превратится в то, чем он является сегодня.

6 июня 2016 г., 14:36

В набирающей темп гонке цифровых ассистентов все будут решать масштабы поддержки сторонними разработчиками и инсталлированной базы. Google Home может опереться на сообщество Android, Apple Siri — на разработчиков для iOS и огромное количество используемых устройств, для Microsoft Cortana такую же роль играет экосистема Windows 10.

Amazon, не обладает преимуществами основных конкурентов, поэтому решила превзойти их по степени открытости своей платформы искусственного интеллекта. Она создала максимально благоприятные условия для быстрой разработки приложений Alexa без жесткого контроля со своей стороны.

Такая политика уже начала приносить первые плоды. Спустя год после выхода инструментария Alexa Skills Kit компания смогла объявить, что для её цифрового ассистента уже доступно около 1000 навыков (skills), варьирующихся от заказа такси на Uber и управления домашним термостатом в системе Vivint до доставки пиццы Domino. Сервисы ряда банков, включая Capital One, уже могут использовать Alexa, а фитнесс-трекер Fitbit с его помощью улучшает мотивацию занимающихся, побуждая достигать более высоких показателей.

Несмотря на то, что такой подход несёт риск утери контроля над качеством приложений, он обещает и гораздо больший выигрыш от массового подключения сторонних команд к разработке новых «навыков» для Alexa.

«Мы воодушевлены тем, что уже доступны 1000 навыков и с нетерпением ждём, когда разработчики создадут следующие 10 тысяч», — заявляет директор Amazon по Alexa Роб Пульчиани (Rob Pulciani).

Amazon также выпустила Smart Home Skill API, превращающий Echo и Alexa в подобие интеллектуального домашнего проигрывателя. Кроме того, она связала Alexa с Amazon Web Services, в частности, со службой AWS Lambda, которая запускает код разработчиков и автоматически управляет вычислительными ресурсами.

Ожидается, что первые успехи Amazon побудят Google, Apple, и Microsoft также пересмотреть свою политику ограниченной поддержки сторонних разработчиков в сторону послабления, что ускорит внедрение инноваций в этой области.

1 июня 2016 г., 16:19

Профессор Техасского университета в Остине Дэвид Цукерман (David Zuckerman), при поддержке аспиранта Эшана Чатоопадхая (Eshan Chattopadhyay) разработал новый метод получения истинно случайных чисел, не требующий больших вычислительных затрат. Это важное открытие позволит более точно моделировать поведение сложных систем и упростит обеспечение высоких уровней безопасности для транзакций с кредитными картами, систем электронного голосования или военных коммуникаций.

Предыдущие версии так называемых экстракторов случайности — методов, над которыми Цукерман работал последние 20 лет, имели меньшую практическую ценность, поскольку требовали, чтобы одна из исходных последовательностей была истинно случайной или, чтобы обе они были близкими к абсолютной случайности.

Новый метод свободен от указанных ограничений, он берет две серии слабослучайных цифр и превращает их в одну, но истинно случайную. Слабослучайные последовательности, такие как результаты измерений температуры воздуха или биржевые котировки, скрывают в себе предсказуемые закономерности. Истинно случайные последовательности, такие как выпадение «орла» или «решки» предугадать невозможно.

Предварительный набросок статьи ученые прошлым летом разместили на онлайновом форуме Electronic Colloquium on Computational Complexity, формально же они представят своё достижение в июне на ежегодном симпозиуме по теории вычислений (STOC).

В статье показано как генерировать одно истинно случайное число, но бывший студент Цукермана, Синь Ли (Xin Li) уже продемонстрировал возможность расширения метода на получение последовательностей из таких чисел.

27 мая 2016 г., 16:05

Вот уже много лет производители электрофоретических экранов приучали нас скептично относиться к известиям о технологиях, которые вот-вот обеспечат полноценное отображение цвета в электронных книгах. Экраны у них получаются блеклыми, дорогими и быстро садят батарейки. Тем не менее, нельзя не признать, что последний анонс E-Ink выглядит довольно обнадеживающе.

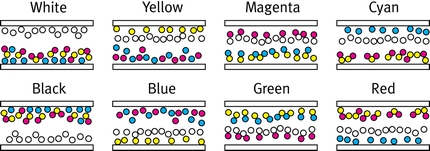

«Впервые мы можем создать любые цвета в любом пикселе», – с таким заявлением выступил глава глобального маркетинга холдинга E-Ink, Джованни Манчини (Giovanni Mancini). В отличие от прежних цветных технологий E-Ink, Triton и Triton 2, тут не используются составные пиксели и массивы светофильтров, что улучшает качество картинки.

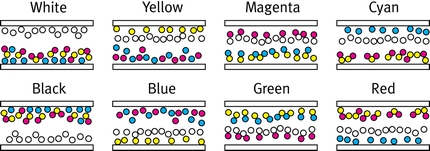

Технология Advanced Color ePaper (ACeP) способна отображать до 32 тыс. оттенков. Она во многом аналогична той, которая приводит в действие миллионы е-ридеров во всем мире, но вместо черного и белого цветов использует четыре пигмента: голубой, пурпурный, жёлтый (CMY). В монохромном дисплее чёрная и белая стороны пиксельной микрокапсулы просто меняются местами при переключении полярности. Для отображения многих тысяч цветовых комбинаций применяется более сложный метод управления положением пикселей, основанный на дополнительных свойствах каждого пигмента.

Сегодня в Сан-Франциско на ежегодной конференции SID Display Week, E-Ink впервые продемонстрировала полноцветный 20-дюймовый дисплей с разрешением 2500x1600. Он соответствует по энергопотреблению монохромным панелям для е-ридеров и, согласно заявлению компании, может использоваться, например, на автобусных остановках и получать питание от солнечных батарей.

Прототип дисплея ACeP имеет хорошую насыщенность цветов (примерно как на печатных плакатах). Технология производит впечатление почти готовой для коммерческого дебюта. Тем не менее, разработчики указывают на несколько имеющихся недочётов. Во-первых, разрешающая способность такого экрана пока не превышает 150 ppi, что вдвое меньше, чем у 6-дюймовых дисплеев высокоуровневых е-ридеров. Во-вторых, цветной экран работает даже медленнее, чем монохромные – полное обновление картинки происходит за две секунды.

Манчини считает, что отмеченные недостатки не представляют проблемы для главного целевого приложения данной технологии – цифровых вывесок и объявлений, где контент не требуется менять слишком часто. Он также сообщил, что хотя ширина прототипа сейчас не превышает полуметра, максимальные габариты таких дисплеев ограничиваются только производственными возможностями E-Ink.

На рынке цветные электрофоретические дисплеи, по оценкам разработчиков, появятся года через два. Не исключено, что к тому времени подоспеют и их потенциальные конкуренты, дисплеи Mirasol, тем более, что, по слухам, завод по их выпуску у Qualcomm в прошлом году купила Apple.

Представитель E-Ink не захотел уточнить, стоит ли ждать появления цветного ридера Amazon Kindle, он лишь повторил, что новая технология в первую очередь ориентирована на применение в дисплеях.

|

|

|