|

СПЕЦІАЛЬНІ

ПАРТНЕРИ

ПРОЕКТУ

Определение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях

Кто внес наибольший вклад в развитие украинского ИТ-рынка.

Награды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары

|

|

22 февраля 2022 г., 13:55

В течение двух десятилетий, с тех пор, как Firefox вышел из тени Netscape, он играл ключевую роль в формировании конфиденциальности и безопасности в Интернете, к большей открытости в Интернете и лучшим стандартам. В конце 2008 года 20% из полутора миллиардов пользователей Сети выбрали браузер Mozilla, а в некоторых странах его доля превышала 50%.

Однако, за следующие 15 лет доля Firefox на всех аппаратных платформах сползла до 4%, в мобильном же сегменте — до ничтожной половины процента.

«Бросив взгляд назад на пять лет, на нашу долю рынка и собственные цифры, которые мы публикуем, нет смысла отрицать снижение», отметила в интервью для Wired Селена Декельманн (Selena Deckelmann), старший вице-президент Firefox. Падение доли рынка сопровождалось двумя раундами увольнений в Mozilla в 2020 году.

В течение многих лет Firefox был главным конкурентом Google Chrome - доминирующему браузеру в мире, предлагая альтернативу, больше ориентированную на защиту приватности. Сегодня новая поросль браузеров, ориентированных на конфиденциальность, соперничает с Firefox на его территории. Firefox, DuckDuckGo, Brave, Vivaldi и Safari - все они в той или иной степени блокируют отслеживание, а Tor вообще считается самым защищённым браузером на рынке. Собственная статистика Mozilla демонстрирует падение аудитории активных пользователей примерно на 30 млн в месяц с начала 2019 года до начала 2022 года, что заставляет отраслевых аналитиков беспокоиться о будущем Firefox.

С Google у Mozilla сложные отношения: они не только конкуренты, но и деловые партнёры. За то, чтобы Google Search был в Firefox поисковым движком по умолчанию, Mozilla получает порядка 400 млн долл. в год, при том, что общий доход компании составляет 496 млн долл. (по состоянию на 2020 финансовый год).

Сделка Google-Mozilla в последний раз продлевалась в 2020 г., и теперь срок её действия истекает в 2023 г. Статистика показывает, что доля рынка Firefox за время действия этого соглашения упала примерно на 1%, и нет никаких гарантий, что Google пролонгирует сделку на прежних условиях.

Mozilla отказался сообщить, ведутся ли переговоры с Google, но признаёт, что в долгосрочной перспективе ей необходимо диверсифицировать способы заработка. Компания усиленно работает в этом направлении с 2019 года.

У Firefox есть другие партнёрские поисковые системы по умолчанию, кроме того, компания владеет сервисом отложенного чтения Pocket, который включает в себя платную премиум-подписку. Она также запустил два подписных решения в стиле VPN и компания начала размещать рекламу на новых вкладках Firefox.

Совокупный доход Mozilla от подписки и рекламы вырос с 14 млн долл. в 2019 г. до 24 млн в 2020 г., и компания ожидает, что по итогам 2021 г. новые продукты должны отвечать за 14% её дохода.

Снижение зависимости от Google является ключом к созданию «более здоровой» бизнес-модели, однако не все ходы, что делает Mozilla, приносят желаемый эффект. Служба обмена зашифрованными файлами была закрыта после того, как стала использоваться для распространения вредоносного ПО. Про телефоны на Firefox OS лучше вообще не вспоминать. Вставка же рекламы в адресную строку Firefox идёт вразрез с декларируемыми целями защиты конфиденциальности.

«По сути, это ведь оптимизированный браузер для обеспечения приватности, но пытаясь выжать из него максимум пользы и дохода, они двигаются совсем в других направлениях», - говорит один из бывших сотрудников Mozilla, ссылаясь на рекламу в строке поиска как на главный пример такого конфликта приоритетов.

Сильная сторона Firefox - это его расширяемость. Она предоставляет пользователям возможность при необходимости подключить многие изначально не активированные функции безопасности. Кроме того, помимо основного браузера Firefox Mozilla также имеет «для непересекающихся сценариев применения» браузер Focus, в котором защита приватности усилена по умолчанию.

«Проблема для Firefox состоит в том, чтобы найти уникальную позицию - не только в маркетинговых заявлениях, но и в их абсолютном продукте - и двигаться в одном направлении», комментирует ситуацию Барт Виллемсен (Bart Willemsen), вице-президент Gartner, занимающийся аналитикой приватности.

По словам Декельманн ключевая для её компании задача - сделать Firefox более персонализированным, чтобы помочь людям справиться с растущим потоком онлайновой информацией. Например, в прошлом году Firefox обновил свою домашнюю страницу, чтобы люди могли найти ранее брошенные поисковые запросы и недочитанные статьи. Компания дополнила кнопками быстрого доступа к часто посещаемым сайтам дизайн Focus для мобильных пользователей и добавила функции диспетчера паролей в Android-приложение Firefox. Особое внимание Mozilla уделяет партнёрским отношениям, включая недавнее сотрудничество с материнской компанией Facebook Meta в области рекламы, в большей степени ориентированной на сохранение приватности.

Буквально на днях объявлено о партнёрстве с Disney, связанном с мартовской кинопремьерой Pixar, которое включает изменение цвета настольного Firefox и рекламы, обои для мобильных приложений, розыгрыш подписки на Disney+. Сделка является яркой иллюстрацией как стремления Firefox к персонализации, так и причудливых путей избираемых компанией в поисках новых источников дохода.

Переосмысленная стратегия гласит, что для достижения успеха Firefox не обязательно должен стать таким же большим, как Chrome или Apple Safari. «Быть жизнеспособным выбором, - это всё, чего мы действительно хотим», отмечает Декельманн.

Несмотря на некоторые промахи, Firefox по-прежнему имеет важное значение. На рынке доминирует кодовая база Chromium и её браузерный движок Blink, лежащий в основе Microsoft Edge Browser, Brave, Vivaldi, Opera и др. Если не считать продвигаемый Apple в iOS движок WebKit, то единственной существующей альтернативой Chromium остаётся Firefox Gecko.

«Этому рынку нужно разнообразие, - говорит Виллемсен. - Нам требуется это отличие для открытых интернет-стандартов, ради предотвращения монополий».

В то время, как бывший сотрудник Mozilla предрекает: «Им просто придётся принять тот факт, что Firefox не восстанет из пепла», многие другие - внутри Mozilla и вне неё - убеждены, что с преуспевающим Firefox Интернет станет лучшим местом, чем сейчас. Заковыка заключается в том, чтобы понять, как туда, в это лучшее место, добраться.

15 февраля 2022 г., 14:48

Недавний прорыв исследователей из Инженерного колледжа Дрекселя (штат Пенсильвания), информация о котором обнародована в журнале Communications Chemistry, впервые обещает сделать высокоперспективную аккумуляторную технологию доступной для коммерческого использования.

До сих пор ввести серу в литиевую батарею мешала необратимая химическая реакция между так называемыми полисульфидами, и карбонатным электролитом. Эта реакция приводит к почти немедленному отказу батареи – уже после одного цикла эксплуатации.

Аккумуляторы Li-S демонстрируют исключительную производительность при использовании эфирного электролита. Он не вступает в реакцию с полисульфидами, но летуч и пожароопасен.

«Нашей основной целью было заменить эфир карбонатом, — сказал профессор Вибха Калра (Vibha Kalra), руководивший исследованием. – Вместо того, чтобы затевать внедрение в промышленность нового электролита, мы хотели создать катод, который мог бы работать с уже существующим литий-ионным электролитом».

.JPG)

В надежде блокировать образование полисульфидов, команда попыталась связать серу в катодной основе из углеродных нановолокон, используя метод осаждения из газовой фазы. Этого достичь не удалось, зато получилось что-то совсем другое.

«В начавшихся испытаниях, — рассказывает Калра… – серный катод, который, по ожиданиям, должен был затормозить реакцию, вместо этого работал на удивление хорошо, снова и снова».

При дальнейшем исследовании выяснилось, что в процессе осаждения серы на поверхность углеродных нановолокон она кристаллизовалась неожиданным образом, образуя, так называемую моноклинную гамма-фазу. Эта химическая фаза серы, которая не вступает в реакцию с карбонатным электролитом, ранее создавалась только при высоких температурах в лабораториях, а в природе наблюдалась только в экстремальных условиях нефтяных скважин.

«Во всех предыдущих исследованиях моноклинная сера была нестабильна при температуре 95° С, — говорит Рахул Пай (Rahul Pai), докторант и соавтор исследования. – В тех немногочисленных опытах, в которых была получена моноклинная гамма-сера, она была стабильной не более 20-30 минут. Но мы создали её в катоде, который подвергался тысячам циклов зарядки-разрядки без снижения производительности!».

Новый серный катод остается стабильным даже по прошествии целого года испытаний. Как сообщает дрексельская команда, его производительность не ухудшилась за 4000 циклов зарядки-разрядки, что эквивалентно 10 годам типичной эксплуатации аккумулятора. И, как и предполагалось, энергоёмкость такой батареи оказалась в три раза выше, чем у литий-ионного аккумулятора.

«Мы все еще работаем над тем, чтобы понять точный механизм, обеспечивающий стабильность этой моноклинной серы при комнатной температуре, однако уже ясно, что это захватывающее открытие может создать множество возможностей для разработки более дружественных к окружающей среде и доступных аккумуляторных технологий», — сообщил Калра.

С заменой традиционного катода в литий-ионных батареях на серный исчезнет зависимость отрасли от ограниченных и проблемных месторождений кобальта, никеля и марганца. Калра также предполагает, что наличие стабильного серного катода станет той предпосылкой, которая позволит исследователям продвинуться вперед в поисках реальных альтернатив для литиевого анода, включающих более легкодоступные элементы, такие как натрий.

11 февраля 2022 г., 13:44

.JPG)

В 2020 «пандемическом» году миллионы людей вдруг обнаружили, что работают из дома и удалённо взаимодействуют с помощью Zoom, Cisco Webex, Microsoft Teams и т. д. Внезапный и вынужденный переход на видеоконференции обострил не только технические проблемы (например, вопросы безопасности, работы программного обеспечения, пропускной способности), но также проблемы психологического характера.

Наиболее известным проявлением этих последних стала так называемая «усталость от Zoom»: это когда люди, которые принимают участие в нескольких удалённых собраниях, к концу дня чувствуют себя опустошёнными. Поскольку работа на дому, вероятно, продолжится в ближайшем будущем, «усталость от Zoom» как и другие проблемы, связанные с видеоконференциями, приобретают высокую актуальность. Поэтому возрастает необходимость в новых теоретических и экспериментальных исследованиях, которые помогли бы аргументированно подойти к устранению огрехов парадигмы удалённых межличностных коммуникаций.

В одном из первых исследований такого рода, сотрудники Университета штата Айова (ISU), Университета штата Миссисипи (Ole Mis) и Уичитского университета (штат Канзас) отслеживали, на что люди смотрят во время виртуальных встреч. Результаты анализа полученных данных, недавно представленные на Гавайской международной конференции по системным наукам, могут помочь более осознанно бороться с отвлекающими факторами видеоконференцсвязи.

«Если люди не могут сконцентрироваться на том, что происходит на собрании, то, возможно, следует улучшить дизайн платформы, чтобы удерживать их внимание и сделать встречи более продуктивными», — предполагает Джои Ф. Джордж (Joey F. George), заслуженный профессор бизнеса ISU.

Эксперимент состоял из двух видеоконференций, в которых каждый из десяти подопытных участвовал, сидя перед экраном компьютера в маленьком помещении без окон. Под монитором была смонтирована система слежения за взглядом RED 250, предоставленная фирмой SensoMotoric Instruments (SMI). Каждые четыре миллисекунды она записывала отражения ИК-сигнала от глаз, регистрируя направление взгляда и визуализируя траекторию его перемещения.

Сначала шла 15-минутная интерактивная встреча по Webex с тремя людьми и одним фейковым пользователем, у которого были отключены видео и звук. Во время встречи исследователи вносили отвлекающие факторы: кто-то шумно ел крекеры и пил газировку, кто-то переносил ноутбук в другую комнату.

Затем каждому из участников демонстрировали первые 10-минут записи Zoom-совещания в мэрии одного из городов Новой Зеландии, на котором присутствовало более 25 человек. Их картинки, отображаемые массивом 5х5 не оставались неподвижными как в первом тесте, но сдвигались всякий раз, когда кто-нибудь новый начинал говорить.

Экспериментаторы обнаружили, что в малой группе участники треть общего времени интерактивной встречи смотрели куда угодно, но не на экран компьютера. В большой группе, где подопытным отводилась роль пассивного наблюдателя видеозаписи, взгляд был направлен мимо экрана лишь 11% времени, а 25% времени внимание было обращено на говорящего. Запланированные организаторами эксперимента помехи (звуки еды, смена фона) действительно отвлекали внимание, но лишь на пару секунд, затем взгляд возвращался на экран.

Исследовательской группой также было установлено, что женщины смотрят на собственное видео гораздо чаще, чем мужчины (133 взгляда против 17). Это перекликается с результатами другого исследования, проведённого в Стэнфордском университете в прошлом году – его участники-женщины постоянно беспокоились о том, как они выглядят на видео.

Подводя итог, авторы этого исследования отмечают, что согласно собранным ими эмпирическим данным, участники продолжительных дистанционных встреч даже в отстутствие отвлекающих факторов находят, чем занять себя, например, своим собственным изображением.

По мнению Джорджа, люди в целом адаптировались к виртуальным встречам за первый год пандемии, но ситуация, когда ты сидишь с одной стороны стола, а все остальные сидят с другой стороны стола и все время смотрят на тебя, всё ещё кажется неестественной, она может вызывать более высокий уровень стресса и даже приводить к развитию «усталости от Zoom».

Учёный допускает, что дальнейшие эксперименты с более долгими видеовстречами могут выявить другие шаблоны поведения и движения взгляда. Также планируется более детально изучить, направлен ли взгляд на говорящего или на фон за его спиной.

«Это было первое в своем роде пробное исследование, и мы надеемся, что оно послужит стартовой площадкой для дальнейших работ в этой области», — сказал Джордж имея в виду не только практические приложения, но и совершенствование теоретического аппарата, такого как Теория восстановления внимания (Attention Restoration Theory). Разработанная почти три десятка лет назад, она получила широкое применение в период пандемии, объясняя стремление отвлечься во время виртуального совещания тем, что это требует меньше усилий, чем постоянная концентрация на обсуждаемых вопросах.

3 февраля 2022 г., 14:53

Огромные объемы данных извлекаются из смартфонов фирмами, стремящимися совершенствовать свои мобильные продукты, проводить исследования или улучшать таргетинг рекламы. В Европе и во многих других юрисдикциях закон обязывает делать эти данные анонимными, например, удаляя имена или номера телефонов, однако, как оказалось, этого уже недостаточно для сохранения конфиденциальности личности пользователей.

Анонимизированные данные о взаимодействиях, которые обычно состоят из псевдонимов сторон взаимодействия, метки времени взаимодействия и, возможно, дополнительной информации, разрешено передавать или продавать третьим лицам без согласия пользователей. В соответствии с действующими правилами защиты данных, такими как Общий регламент ЕС по защите данных (GDPR) или Калифорнийский закон о конфиденциальности потребителей (CCPA), такие анонимные (или деидентифицированные) данные не считаются личными.

Соответственно, они повсеместно используются, например, для изучения закономерностей изменения картины общения людей с близкими контактами с течением времени, влияния дружеских отношений в Facebook на политическую мобилизацию, динамики распространения дезинформации в Twitter или роста ареала эпидемий.

Исследование, опубликованное в журнале Nature Communications, показывает, что, вопреки бытующему мнению, данные о взаимодействии являются глубоко личными и конфиденциальными. Они с высокой точностью фиксируют, с кем мы разговариваем или встречаемся, в какое время и как долго, благодаря чему людей вполне возможно идентифицировать. Авторы работы предметно демонстрируют как это сделать на основании всего нескольких деталей коммуникаций, например, через WhatsApp.

Один из соавторов, Ив-Александр де Монджой (Yves-Alexandre de Montjoye) из Имперского колледжа Лондона (ICL), считает, что пришло время «заново изобрести понятие анонимности». Его команда собрала анонимные данные более, чем у 40 тысяч пользователей мобильных телефонов (в основном из приложений-мессенджеров). Затем они «атаковали» эти данные, ища закономерности в этих взаимодействиях.

Предложенный в статье метод, который вполне могли бы использовать и злоумышленники, базируется на геометрическом глубоком обучении. В нём нашли применение так называемые графовые сети внимания (GAT).

GAT это новая архитектура нейронных сетей, которые работают с данными, структурированными в виде графов. Она использует замаскированные самоконтролируемые уровни для устранения недостатков предыдущих методов, основанных на свёртках графов или их аппроксимациях. Складывая слои, в которых узлы могут сами следить за состоянием своих окрестностей, GAT позволяет неявно указывать разные веса для ближайших соседей без предварительного знания структуры графа.

С помощью GAT авторы анализировали поведенческий профиль человека, создавая векторное представление еженедельной сети его взаимодействий. Такие еженедельные профили, базирующиеся только на поведенческих характеристиках, объединяли параметры узлов и топологическую информацию, присутствующую в данных взаимодействия, и были специально оптимизированы для задачи идентификации.

В тестовом наборе данных такая модель смогла правильно идентифицировать пользователя в 52% случаев при учёте его двухуровневых взаимодействий (k = 2). Используя только взаимодействия человека с его прямыми контактами (k = 1), модель смогла идентифицировать его в 15% случаев.

Важно отметить, что точность такой модели лишь незначительно снижается с течением времени: 24% людей все еще правильно идентифицируются по прошествии 20 недель (k = 2), что делает данный метод идентификации реальным риском на практике.

Помимо этого, авторы показали, что их общий подход к профилированию графа применим и к другим типам данных взаимодействия. Для демонстрации они создали набор данных о приближении (попадании в радиус действия сети Bluetooth) для примерно 500 человек. Такая информация, собираемая мобильными приложениями, используется для отслеживания контактов носителей COVID-19. Исследователям она позволила связать сети взаимодействия с одним переходом (k=1) с точностью 26%

.JPG)

«Наши результаты свидетельствуют о том, что разрозненные и даже повторно псевдонимизированные данные о взаимодействиях всё же поддаются идентификации даже по прошествии долгого времени», — подводит итог статья, в подготовке которой помимо сотрудников ICL принимали участие их коллеги из Италии и Швейцарии.

Несоответствие практикуемых методов тем стандартам, что установлены европейскими регуляторами, Монджой объясняет тем, что традиционная анонимизация не была рассчитана на работу с настолько «богатыми» массивами данных, как те, которые предоставляются мобильными приложениями.

Многообещающим новым методом, по его словам, является жёсткое ограничение доступа к большим наборам данных, сводящее работу с ними до простых вопросов и ответов. Такой подход может вообще избавить от необходимости анонимизации мобильных данных.

25 января 2022 г., 10:45

В иностранных статьях Web3 неслучайно практически всегда соседствует с hazy concept (размытое, туманное понятие). Пытаясь осознать это неоднозначное явление, важно сразу задать себе два правильных вопроса: что такое Web3 сейчас и как Web3 изменит наше будущее.

Амбассадоры Web3 твёрдо заучили ответ на первый из них – они обещают нам безмятежное цифровое будущее, сочетающее в себе децентрализованность Web1 с интерактивностью и удобством Web2, но лишенное их недостатков: не нужно будет зависеть от провайдеров сервисов, включая банковские сервисы; каждый участник сети будет настолько анонимен, насколько пожелает сам, и сможет свободно и бесконтрольно со стороны правительства и корпораций обмениваться любой информацией и деньгами; творческим стартапам больше не нужно будет ложиться под венчурных инвесторов – финансирование реализации их замечательных идей обеспечит восторженная цифровая общественность, радостно раскупающая начеканеные ими токены в ненуждающемся ни в чьих разрешениях крипто-IPO.

Это звучит очень привлекательно. Настораживает лишь, что одним из главных адвокатов и апологетов этой идеи является ведущий венчурный капиталист Марк Андриссен, которого это самое светлое будущее, вроде бы, должно гарантированно оставить без работы.

Для полноты картины, после адвоката нужно выслушать и обвинителя. Пожалуй, самым яростным оппонентом Web3 выступает известный техножурналист Стивен Дил (Stephen Diehl). В его представлении технология блокчейн, «единственное применение которой — создание устойчивых к цензуре схем криптоинвестиций», это изобретение, чьи отрицательные внешние манифестации и ненулевая вероятность катастрофических последствий перевешивают всю гипотетическую выгоду от её внедрения.

Но даже если эту абсурдную (риторика Дила) идею удастся протолкнуть, остаются интересные вопросы. Например, если представить себе полностью децентрализованный вариант Facebook, кто в этой обезличенной соцсети будет удалять посты и паблики неонацистов, педофилов, идеологов террора? Чьи адвокаты будут отвечать на жалобы о нарушении авторских прав?

И кто будет платить за потребляемые ресурсы инфраструктуры? Каждый участник, напечатанными цифровыми токенами? Законы экономики не обманешь, чем больше будут печатать денег, тем меньше они будут стоить, а платить придётся ровно столько же. А точнее, каждому придётся выложить намного больше, поскольку децентрализация – это очень и очень дорого.

То, что централизованная схема всегда намного эффективнее децентрализованной в отношении потребления компьютерных ресурсов и полосы пропускания, это непреложный факт. Потому что вся децентрализованная сеть вынуждена «пересчитывать каждую программу в рамках безумно расточительного процесса достижения консенсуса по поводу гигантской глобальной машины состояний». Затраты на хранение генерируемых в процессе этой работы служебных данных будут головокружительными, ведь удаление информации противоречит самой идее блокчейн!

Примирить эти две диаметрально противоположные точки зрения, Андриссена и Дила, в рамках единого мировоззрения невозможно. Но можно, по примеру Скарлетт О'Хара, сказать: «Я подумаю об этом завтра.». А еще, подобно персонажу анекдота, воскликнуть: «Да что тут думать? Трясти надо!».

Пример такого практичного отношения к Web3 демонстрирует автор YouTube-канала Fireship, говоря, что Web3 это, конечно, надувательство, однако на этом можно и нужно заработать. В его примере, разработчик децентрализованного приложения чеканит миллион токенов, продаёт их за один доллар каждый. Первые покупатели перепродают их уже по два доллара. И так далее по классическому алгоритму коммерции: купил дешевле, продал дороже – неважно виртуальные это валюты или халтурные картинки из десятка пикселей, называемые уникальными и незаменимыми предметами цифрового искусства. Обычная финансовая пирамида, которая делает счастливыми всех, но особенно тех, кто находится на самой её вершине.

Получив в руки технологию, которая позволяет создавать такие финансовые пирамиды каждому, не глупо ли упускать такую возможность? Что это будет за мир, где каждый будет сам себе Мавроди? Неужели, мир из одних миллионеров? Бредовая мысль, но мы договорились: о будущем не думаем.

Всерьёз о будущем Web3 задумался Джек Дорси, которого забанили в им же созданном Твиттере. Этот дивный прецедент грядущего освобождения от платформенного диктата не наполнил его оптимизмом. Он уверен, что венчурный капитал не позволит отнять у себя бразды правления, и что Web3 это лишь «новое название для прежней, централизованной сущности».

Мокси Марлинспайк (@moxie) в своем блоге на примере двух, сделанных им, распределённых приложений (dApp), наглядно показал, насколько несвободен рядовой житель Web3, насколько он беззащитен перед провайдерами «несуществующих» платформ. Его токен NFT за нарушение условий сервиса (так и оставшееся неясным) был удалён с биржи OpenSea и, одновременно, пропал из сверхнадёжного (ключи хранятся на клиентском устройстве) криптокошелька MetaMask.

К уже упомянутым проблемам децентрализованной модели Мокси добавляет еще одну – инертность сообщества разобщённых разработчиков. В открытых проектах инновации внедряются черепашьими темпами – и это не вопрос финансирования. Если что-то действительно децентрализовано, изменить его становится очень трудно, и часто оно останавливается в развитии, даже если остальная часть экосистемы движется очень быстро и отстать, значит потерпеть неудачу. Централизация – это известный рецепт вывода из ступора протоколов 90-х годов. Сквозное шифрование в e-mail не могут реализовать уже более 30 лет, но в WhatsApp переход к e2ee занял всего год. Сегодня целые параллельные отрасли заняты улучшением методологий, таких как Agile, помогающих организовать эффективную работу огромных групп людей над проектами, где скорость имеет критическое значение.

И в заключение, вернемся к вопросам, заданным в начале.

Что такое Web3 сейчас? Сегодня мы (те из нас, кто не использует его как еще одну из многих схем быстрого обогащения) переживаем счастливый период романтического увлечения Web3. Когда венчурный капитал бескорыстно финансирует проекты dApp, а корпорации предоставляют нам инфраструктуру игровой площадки, где мы в розовом тумане увлечённо играем в анонимность и неподконтрольность от них.

Как Web3 изменит наше будущее? В полном заявленном апологетами объёме Web3 вряд ли укоренится в нашей жизни, а в какой мере это произойдет, пока можно гадать только на внутренностях жертвенного барашка. Мне, например, кажется, что протокол BitTorrent (на который в США уже завели более 200 тысяч исков) просто обречён на блокчейн-трансформацию, иначе его задушат, как задушили пионера одноранговых сервисов, компанию Napster. Тем более, что предпосылка для такой миграции, Межпланетная файловая система (IPFS), уже имеется.

Ясно одно, за надеждами розового периода идеалистов просто обязано прийти отрезвление, и анархо-капитализм практиков (когда каждый сам себе ФРС) продлится ровно до тех пор, пока в глазах регуляторов это не превысит уровень допустимой шалости. Но … повторяю, давайте подумаем об этом завтра.

Вместо эпилога.

Работа над этой статьёй была напряжённой, и как-то, я уснул прямо посреди фразы, уронив голову на мою верную клавиатуру Microsoft Arc. И приснился мне сон, будто я создал уникальный NFT из всего лишь одного пикселя радикально-чёрного цвета. И теперь сужусь с Apple, устройства которой, будучи выключенными, нагло пренебрегают моими неотчуждаемыми и защищенными блокчейн правами собственности – на всей площади своих немаленьких экранов!

Проснувшись с криком я, по примеру героя Станислава Лема, сказал себе, – «Страшен сон, да милостив Бог!» и продолжил ваять статью. А ведь кто-то сочтёт это неплохой идеей для стартапа;-)

5 января 2022 г., 16:26

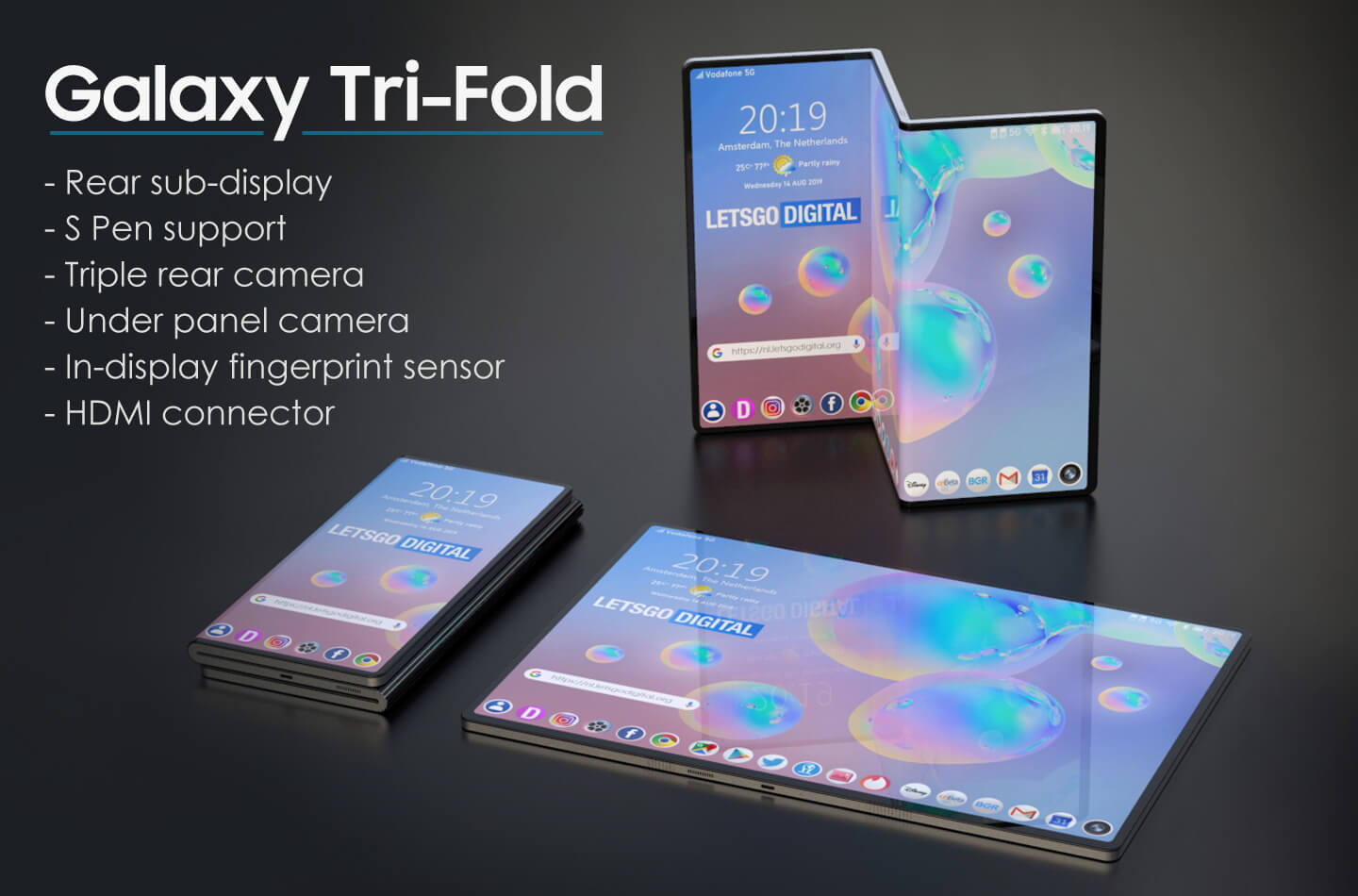

Со времени провального дебюта складного первенца Galaxy Fold, ситуация в сегменте foldable, можно сказать, нормализовалась. Гигантские ресурсы, брошенные в прорыв, позволили избавиться от явных дефектов и сгладить проблемы, присущие самому конструктиву. Новые поколения устройств со складными экранами даже довольно неплохо продаются – рынок велик и падок на диковинные технологии. Но энтузиазм техно-гиков переходящ, и чтобы подпитать его на этот раз, ведущие производители готовятся предложить им портативные устройства, экран которых складывается два раза, причём в разные стороны.

Зигзагообразно складываемые смартфоны, в принципе, логичный этап эволюции foldable. Такая схема, впервые реализованная в прототипе, который фирма TCL показала в 2019 г., удобна тем, что не требует отдельного дисплея для пользования смартфоном в сложенном виде.

Об интересе Samsung к Z-конструктиву стало известно еще в мае, когда корейская компания показала муляж подобного устройства. В августе, на Международной конференции по информационным дисплеям (IMID 2021), прототип Galaxy S-Foldable уже демонстрировался с работающим 7,2-дюймовым (18:9) дисплеем, правда, в фиксированном, полураскрытом виде.

Но ещё за год до этого показа, конкурент Samsung, компания Microsoft, зарегистрировала патентную заявку, в которой описывалось аналогичное, зигзагообразно складывающееся устройство. Информацию об этом только 23 декабря обнародовало Бюро патентов и товарных знаков США (USPTO). Предполагается, что редмондская компания сделает такую трёхэкранную схему базовой для нового портативного продукта под названием Surface Trio.

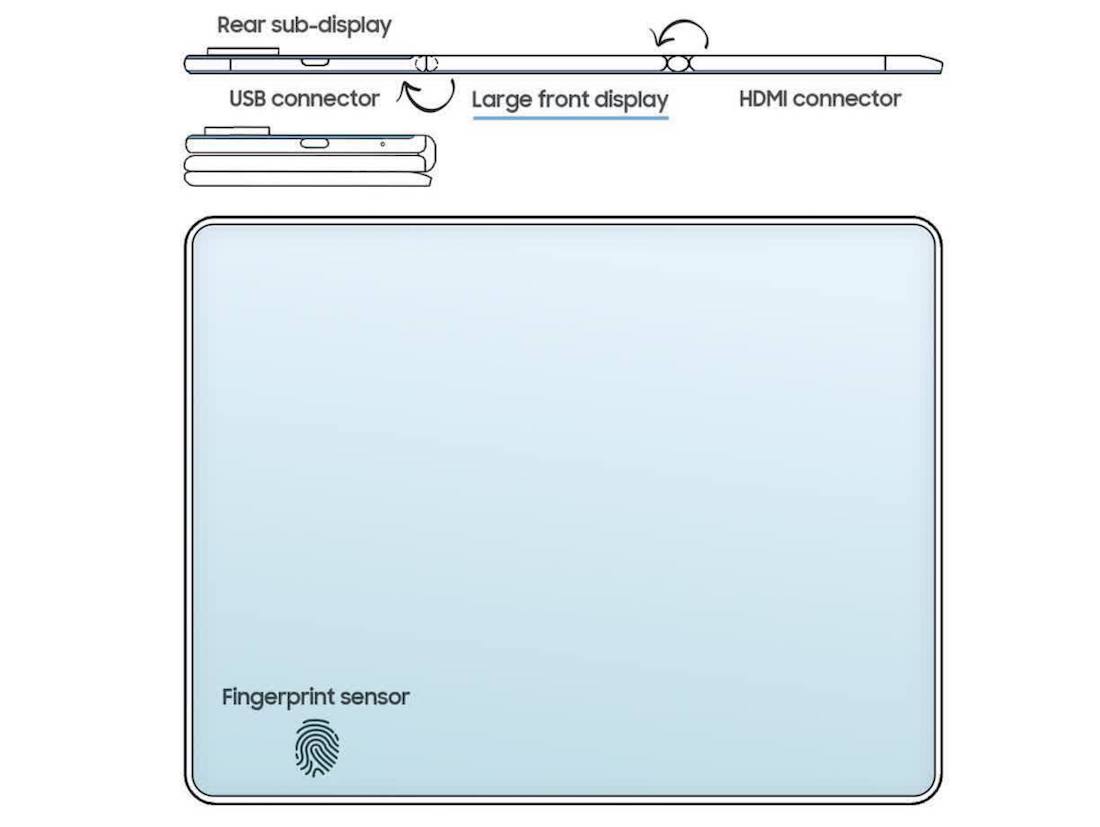

Об патенте на ту же тему, 23 декабря выданном Samsung в WIPO (World Intellectual Property Organisation), на днях сообщил ресурс LetsGoDigital. В отличие от концептуальной заявки Microsoft, здесь, на 42 страницах прилагающейся документации, описывается вполне законченная конструкция.

Galaxy Tri-Fold состоит из трёх сегментов, но аппаратная начинка, включая два аккумулятора, порты USB-C и HDMI, сосредоточена только в двух крайних модулях. Треть дисплея, остающаяся снаружи в сложенном виде, оснащена интегрированным в экран сенсором отпечатков пальцев. Конфигурация камер такая же, как в уже выпускаемой модели Z Fold 3 – три тыльные камеры и фронтальная, скрытая под экраном – однако на задней панели имеется небольшой дополнительный дисплей, благодаря чему снимать селфи станет возможно всеми четырьмя камерами

Samsung Electronics недавно оформила ещё несколько патентов, связанных с этим многофункциональным устройством, например, в прошлом месяце – на Z-образный смартфон с обратной беспроводной зарядкой. Скорее всего, мы услышим больше об этом универсальном смартфоне/планшете в 2022 или 2023 году.

Из других производителей, работающих над перспективными моделями в этом форм-факторе, можно назвать Vivo (устройство на Origin OS даже имеет виртуальную проекционную клавиатуру!), а также Huawei.

20 декабря 2021 г., 15:58

Став примером того, какой вред потенциально может принести проект с открытым исходным кодом, сопровождаемый и управляемый на добровольной основе, инцидент с Log4j в полной мере демонстрирует хрупкость и ненадёжность нашего повседневного мира, важнейшей частью которого уже давно стал Интернет.

Мир информационной безопасности 9 декабря узнал о существовании если не самой, то, безусловно, одной из самых серьёзных уязвимостей. Она получила обозначение CVE-2021-44228 и была названа по имени библиотеки, в которой её обнаружили.

Эта библиотека, Java Apache Log4j, применяемая для ведения журналов, встроена в множество приложений, сервисов и корпоративных программных средств, написанных на Java и используемых по всему миру, что создаёт огромную поверхность для атаки.

Log4j позволяет злоумышленникам без особых усилий удалённо запускать свой код и получать доступ к машинам. Дело дополнительно осложняется тем, что, в случае Log4j даже специалистам по безопасности очень трудно понять, является ли эта библиотека частью их приложений. Как и для многих других программ с открытым исходным кодом, риск здесь передаётся по цепочке поставок.

Даже если крупная организация считает, что она защитила себя от Log4j, всегда остаётся вероятность, что злоумышленники могут взломать её поставщика, который не следит за безопасностью своей ИТ-инфраструктуры так же тщательно, и воспользоваться им как воротами к более крупной и прибыльной цели.

Свежая, повсеместная и элементарная в применении уязвимость нулевого дня так и просилась в руки хакеров, и они не замедлили этим шансом воспользоваться. За считанные часы количество попыток эксплуатации Log4j достигло многих тысяч и продолжает быстро расти. Один из провайдеров услуг кибербезопасности прогнозирует, что в ближайшие дни атаки такого типа охватят почти половину всех корпоративных сетей.

Поначалу взломщики в основном ограничивались заброской криптомайнеров в захваченные системы, но затем последовали более опасные загружаемые «подарки», такие как экземпляры инструмента тестирования защиты от проникновений, Cobalt Strike, часто применяемого для кражи логинов/паролей с целью дальнейшего распространения внутри закрытых сетей.

Достоинства эксплойтов Log4j смогли оценить и кибервымогатели, уже начавшие с их помощью доставку кода Khonsari – нового семейства программ-ransomware с самой базовой функциональностью.

Ну и вишенкой на этом торте стали группы кибершпионажа государственного уровня, так называемые Advanced Persistent Threat (APT). Уже зарегистрированы попытки использования Log4j злоумышленниками, идентифицированными как APT из Китая, Ирана, Северной Кореи и Турции.

Началась работа по локализации новой угрозы. Агентство кибер- и инфраструктурной безопасности (CISA) Министерства внутренней безопасности США требует, чтобы федеральные агентства создали патч, исправляющий ошибку Log4j в течение нескольких дней. Но, как показывает практика, установка такого исправления на миллионах компьютеров растянется на многие годы, причём некоторые машины так и останутся незащищёнными.

Прогнозы неутешительны: Log4j, по всей видимости, останется проблемой на весь 2022 и последующие годы. Как это было с коронавирусом ровно два года назад, мы сейчас можем только поверхностно оценить подлинные риск, масштабы и последствия эксплуатации новой уязвимости.

Лучшее, что могут сделать организации на данный момент, – это следовать советам экспертов, устанавливать обновления для смягчения потенциального ущерба. И надеяться, что в ближайшее время они не прочитают в «Компьютерном Обозрении» о пришествии новых, ещё более катастрофических уязвимостей.

14 декабря 2021 г., 16:26

В последних результатах эталонных тестов производительности машинного обучения, опубликованных в конце ноября отраслевым консорциумом MLCommons, фигурирует представленная инженерами Google огромная версия программы естественного языка BERT, равную которой не использовал ни один другой поставщик.

В данный релиз не вошли результаты тестирования быстродействия выдачи прогнозов обученными нейросетями (так называемые inference), их MLCommons выпускает отдельно.

Состязания с использованием тестов MLPerf уже традиционно проходят в двух категориях: «закрытой» (Closed), где большинство поставщиков соревнуются на стандартных, хорошо зарекомендовавших себя сетях, таких как ResNet-50; и «открытой» (Open), позволяющей вендорам опробовать нестандартные подходы.

Участвовавшая в Open-категории, наряду с Graphcore и Samsung, Google, показала в ней компьютер с 2048 чипами-ускорителями TPU version 4. Эта система, кстати, доступная как услуга в Google Cloud, потратила на обучение крупнейшей в истории программы BERT около 19 часов.

Гигантская нейронная сеть содержит 481 миллиард параметров, что более чем на три порядка превышает стандартную версию Bert, известную как BERT Large и насчитывающую «всего» 340 миллионов параметров.

«Мы всегда заинтересованы в том, чтобы наши конкурсные предложения в MLPerf отвечали нашим внутренними нуждам и потребностями индустрии машинного обучения, – отметил Ааруш Селван (Aarush Selvan), курирующий инфраструктуру машинного обучения в Google. – Обучение больших моделей с десятками или сотнями миллиардов параметров, и даже с триллионом параметров и выше, становится все более важным как для Google …, так и для наших облачных клиентов».

Подчёркивая растущее значение крупномасштабных моделей, Google в этом году игнорировала участие в стандартных тестах, где используются испытанные, но несколько устаревшие программы. По мнению компании, MLCommons следует подумать о включении в стандартную категорию состязания MLPerf более крупных моделей.

«Бросить 4000 чипов, чтобы натренировать BERT всего за несколько секунд, это суперкруто, – заметил Сельван, имея в виду меньшую версию, BERT Large в категории Closed. – В реальной жизни вы никогда не будете использовать столько чипов для обучения такой маленькой модели».

Google добилась от гигантской модели BERT эффективности работы 63%, определяемой как количество операций с плавающей запятой в секунду, относительно теоретической производительности. По словам Сельвана, это лучше, чем следующий по величине результат в отрасли (52%): он был показан Nvidia для языковой модели Megatron-Turing, разработанной совместно с Microsoft.

Исполнительный директор MLCommons, Дэвид Кантер (David Kanter), сказал, что решение о включении крупных моделей должно быть принято членами консорциума коллегиально. Однако он отметил, что использование нейронных сетей умеренных размеров делает соревнование доступным для более широкого круга участников.

«В принципе мы могли бы сделать обучение GPT-3 эталоном MLPerf, – добавил он, имея в виду языковую модель со 175 млрд параметров, представленную OpenAI в прошлом году. – Проблема в том, что тренировка GPT-3 довольно затратна по вычислениям. Это десятки миллионов долларов».

Напротив, стандартный набор MLPerf любой исследователь может свободно позаимствовать, чтобы самому воспроизвести тесты. Таким образом, это очень ценный инженерный ресурс для всего сообщества, который помогает продвигать отрасль ИИ вперёд.

Google не планирует публиковать новую модель BERT. Селван, охарактеризовав её как «что-то, что мы сделали только для MLPerf». Данная программа аналогична той, что была описана в исследовании Google в начале этого года, посвященном нейронным сетям с высоким уровнем параллелизма.

Google также подчёркивает, что несмотря на новизну BERT с 481 млрд параметров, она тесно связана с практичными задачами, поскольку построена на реально используемой многослойной архитектуре Transformer.

Как от меньших участников MLPerf, от гигантской модели BERT требовалась определённая точность в предсказаниях – выше 72,2%. Однако, для удовлетворения этому требованию программе Google понадобилось меньшее количество выборок текстовых данных. В закрытой категории программы использовали почти полмиллиарда выборок, по 128 на каждую последовательность. Программа Google достигла точности прогнозов 75% с использованием всего около 20 млн выборок, но при длине последовательности 512 токенов.

24 ноября 2021 г., 18:20

На веб-странице NVIDIA AI Demos, где собраны программы, демонстрирующие возможности искусственного интеллекта, Nvidia Research представила вторую версию GauGAN (Гоген), которая получила способность создавать реалистичный пейзаж на основе его текстового описания.

Первая программа GauGAN, созданная в начале 2019 года, использовала в качестве входной информации рисунок. Достаточно было нескольких штрихов, чтобы программа заполнила их, нарисовав фотореалистичную картину.

Термин «GAN» в названии был введён в обиход Ианом Гудфеллоу (Ian Goodfellow) в 2014 году. Он расшифровывается как генеративные состязательные сети – широкий класс программ, задействующих сразу две нейросети: одна выдаёт результат и уточняет его, пока вторая не признает тот убедительным. GAN быстро стали любимым инструментом создания высокореалистичного контента для авторов дипфейков. Не отставала от них и Nvidia, представившая в 2018 году Style-GAN – синтезатор детальных изображений никогда не существовавших людей.

GauGAN образца 2019 года воспринимала линии рисунка как высокоуровневые абстракции гор, озёр или полей. Они становились структурным шаблоном – сегментационной картой – которую ИИ заполнял реалистичными формами.

Модель, лежащая в основе GauGAN2, обучена на 10 миллионах высококачественных пейзажных изображений с помощью NVIDIA Selene – система NVIDIA DGX SuperPOD, которая входит в десятку самых мощных суперкомпьютеров в мире. Исследователи использовали нейросеть для изучения связи между словами, такими как «зима», «туман» или «радуга», и изображениями, которым они соответствуют.

Чтобы ощутить возможности семантической сегментации, просто введите в текстовое окно фразу (на английском), например, «закат на пляже», и ИИ сгенерирует сцену в реальном времени. Добавьте дополнительное прилагательное, например «закат на каменистом пляже», или замените «закат» на «полдень» или «дождливый день», и модель, основанная на генеративных состязательных сетях, мгновенно скорректирует картину.

Дорисовывать сцену можно и непосредственно – с помощью грубых набросков. Реагируя на ярлыки, такие как «небо», «дерево», «камень» и «река», умная кисть будет порождать качественные изображения.

Тщательно отлаженный и отлично работающий прообраз будущего мощного инструментария цифровых художников, как водится, сразу попал в лапы кожаным варварам, начавшим предлагать для преобразования в ландшафт наименее подходящие для этого фразы. Среди таких хулиганов, как ни прискорбно, оказалась даже команда ZDNet, гордо презентовавшая в Сети бредовые результаты своего насилия над искусственным разумом.

Дурной пример заразителен. На иллюстрации –еженедельник «Компьютерное Обозрение» после тройной прогонки алгоритма GauGAN2.

Технология GauGAN уже нашла воплощение во вполне реальном и доступном для загрузки приложении NVIDIA Canvas, которое предназначено для машин с GPU NVIDIA RTX GPU.

15 ноября 2021 г., 20:13

В октябре 2019 года Google провозгласила, что первой достигла квантового превосходства: её квантовый компьютер с массивом из 54 кубитов всего за три минуты и 20 секунд (200 секунд) выдал ответ, который лучшему на тот момент классическому суперкомпьютеру, IBM Summit, пришлось бы искать 10 тысяч лет.

Спустя всего год, в декабре 2020 г., Китай представил фотонный квантовый компьютер, Jiuzhang который решил проблему выборки гауссовых бозонов на 76 кубитах за 200 секунд, что на классическом компьютере заняло бы 600 миллионов лет. С тех пор эта страна смогла достичь квантового превосходства ещё раз, в октябре 2021 г., в этот раз – с использованием квантового компьютера на сверхпроводящих кубитах (Zuchongzhi), однако, первенство уже принадлежало США и, казалось бы, с этим ничего нельзя поделать.

Но китайцы нашли способ, и он заключался в том, чтобы дискредитировать достижение конкурента. Сомнения в чистоте эксперимента Google высказывались и раньше, но предоставить решающее доказательство его некорректности удалось лишь сейчас, сотрудникам Института теоретический физики Китайской Академии Наук.

«Расчётное время, оцененное Google, относится к конкретному классическому алгоритму ... это не теоретическая оценка, которая применима ко всем возможным алгоритмам, – утверждают они. – То есть, в принципе, могут существовать алгоритмы, которые работают намного лучше, чем алгоритм Google, опровергая заявку в достижении квантового превосходства».

Именно такой классический алгоритм, основанный на методе тензорной сети, и предложили пекинские теоретики. В статье, подготовленной к публикации в научном журнале, сообщается, что их алгоритм на классическом вычислительном оборудовании выполнил симуляцию работы квантовых схем Sycamore с большей точностью, чем оригинальный квантовый процессор компании Google. Один миллион некоррелированных выборок, был создан с точностью 0,0037 по сравнению с 0,002 у квантового компьютера Google.

«Насколько нам известно, это первый раз, когда проблема выборки схем квантового превосходства Sycamore с точностью большей, чем на оборудовании Google ... решена на практике классическим способом», – заявил в интервью газете South China Morning Post руководитель группы, профессор Чжан Пань (Zhang Pan).

Системе с 512 графическими чипами (GPU) потребовалось на это около 15 часов, однако, как отмечают участники работы, это далеко не предел: «Если наше моделирование схем квантового превосходства реализовать с высокой эффективностью в готовящемся к выпуску экзафлопном суперкомпьютере, то, в принципе, общее время симуляции может быть сокращено до нескольких десятков секунд, что быстрее, чем в эксперименте с (квантовым) оборудованием Google».

Ниспровержение достижения Sycamore автоматически делает Китай не только первой, но и единственной на сегодняшний день страной, достигшей квантового превосходства.

Китай сделал квантовые технологии своим главным приоритетом – они указаны вместе с шестью другими ключевыми направлениями науки и техники в пятилетнем плане развития страны – в частности для таких приложений, как вычисления, сверхзащищённые сети связи и прецизионные измерения.

|

|

|