Confluent: від «архітектурного спагеті» LinkedIn до продажу за 11 млрд дол.

12 декабрь, 2025 - 11:33Ігор МасловУ понеділок, 8 грудня 2025 року, IBM оголосила про придбання Confluent за 11 млрд дол. – це одне з найбільших поглинань технологічного гіганта за останні роки. Придбана компанія не надто відома широкому загалу, але за нею стоїть дуже цікава історія. Тож як Confluent виникла та як змінила підхід до роботи з даними.

Народження Apache Kafka і до чого тут LinkedIn

Історія Confluent розпочалася не в умовному міфічному гаражі десь у Кремнієвій долині, а в офісі LinkedIn у Маунтін-В’ю восені 2008 року. Соціальна мережа для професіоналів переживала стрімке зростання, перетворюючись з простого сайту для резюме на складну багатофункціональну платформу. Проте її інженери зіткнулися з фундаментальною архітектурною проблемою, яка згодом призвела до створення однієї з найважливіших технологій сучасної інженерії даних.

У компанії функціонувало безліч різних систем: бази даних, сервіси пошуку, рішення для забезпечення безпеки, аналітичні платформи. Кожна з них повинна була обмінюватися даними з іншими. Інженери будували прямі з’єднання між системами – наприклад, сервіс повідомлень надсилав дані в базу користувачів, база передавала інформацію в аналітику і так далі. Дуже швидко це перетворилося на некерований хаос, таке собі «архітектурне спагеті». Додавання будь-якого нового сервісу вимагало написання десятків нових інтеграцій. Системи падали, дані губилися, затримки зростали. Традиційні рішення того часу – ActiveMQ або RabbitMQ – не підходили для масштабів соцмережі. На той момент LinkedIn вже генерувала близько 1 мільярда повідомлень на день, і старі черги просто захлиналися під таким навантаженням.

У цей момент в LinkedIn працювала унікальна група інженерів, якій доручили розв’язати проблему. До її складу входили троє ключових фігур: Джей Крепс (Jay Kreps) – головний інженер, Неха Наркхеде (Neha Narkhede) – інженерка з потокової інфраструктури, та Джун Рао (Jun Rao) – дослідник і старший інженер. Крепс написав перший прототип на різдвяні свята – саме він першим усвідомив суть проблеми та запропонував новий підхід. Як він згадує, більшість інженерів не хотіли працювати над цим проєктом, оскільки побудова конвеєрів даних не вважалася захопливою роботою.

Крепс, поцінувач та знавець літератури, назвав нову систему Kafka на честь письменника Франца Кафки. «Я подумав, що оскільки це система, оптимізована для запису, то ім’я письменника буде доречним», – жартував він пізніше. Втім, був і глибший підтекст: твори Кафки часто описують гнітючі, заплутані бюрократичні системи. Крепс іронізував, що їхня архітектура даних до появи Kafka була настільки ж кошмарною та безнадійною, як сюжети в романах письменника.

На відміну від традиційних черг повідомлень, Kafka була побудована як розподілений лог подій. Це була фундаментальна зміна парадигми: дані записувалися послідовно на диск і могли бути прочитані багатьма споживачами у власному темпі. Одним із технічних секретів неймовірної швидкості Kafka стало використання принципу «Zero Copy» (нульове копіювання). Це дозволяло передавати дані безпосередньо з диска в мережу, оминаючи зайве копіювання в оперативну пам’ять програми, що суттєво розвантажувало процесор. У 2011 році LinkedIn виклала Kafka у відкритий доступ, передавши проект під егіду Apache Software Foundation. Масштабованість рішення підтвердив час: якщо на старті система обробляла мільярд подій, то сьогодні інфраструктура LinkedIn на базі Kafka пропускає через себе понад 7 трильйонів повідомлень щодня.

Джей Крепс (Jay Kreps) народився у 1981 році, а його освітній шлях був нестандартним – він відвідував старшу школу лише один рік, вирішивши, що традиційне навчання неефективне. Причому йому вдалося переконати й чимало своїх друзів піти тим же шляхом самоосвіти. Крепс здобув ступінь бакалавра з комп’ютерних наук в Університеті Каліфорнії у Санта-Крузі у 2002 році, а магістра – там же само трьома роками пізніше. До LinkedIn він працював старшим інженером з data mining в NexTag. У соцмережі став головним архітектором даних та інфраструктури і започаткував розробку кількох open-source проєктів, включаючи Project Voldemort, Apache Kafka та Apache Samza. У 2013 році Крепс написав легендарну статтю «The Log: What every software engineer should know about real-time data’s unifying abstraction», яка стала маніфестом сучасної інженерії даних. Ця праця фактично відродила інтерес до концепції Write-Ahead Log (WAL), що десятиліттями використовувалася в базах даних, і популяризувала «Kappa Architecture» – підхід, де все розглядається як потік, на противагу складнішій Lambda-архітектурі. Крепс також є членом ради директорів Anthropic і його статки раніше у поточному році оцінювалися у 1,5 млрд дол.

Неха Наркхеде (Neha Narkhede) народилася у 1984 році в Пуні (штат Махараштра, Індія). Вона отримала ступінь бакалавра з комп’ютерної інженерії в Pune Institute of Computer Technology, а у 2007 році здобула ступінь магістра технологій в Технологічному інституті Джорджії. Після отримання магістерського ступеня почала кар’єру в Oracle як інженер-програміст, потім перейшла до LinkedIn, де очолювала команду інфраструктури для обробки потокової інформації. У тріо засновників Confluent Наркхеде відповідала за те, щоб зробити технологію зрозумілою та зручною у використанні. Вона стала головним євангелістом платформи, зумівши переконати консервативні компанії зі списку Fortune 500, що open-source рішення може бути надійним фундаментом для критичних банківських транзакцій. Вона є співавторкою книги «Kafka: The Definitive Guide», яка стала своєрідною біблією для розробників. У 2020 році увійшла до списку Forbes «America’s Self-Made Women». Вже у 37 років Наркхеде стала наймолодшою жінкою-підприємницею, яка досягла успіху самостійно (self-made), в індійському рейтингу найбагатших людей, зі статком, що оцінювався у $4700 крор (близько 520 млн дол.). У 2021 році разом з чоловіком Сачіном Кулкарні вона співзаснувала Oscilar – платформу на базі штучного інтелекту для виявлення шахрайства в онлайн-транзакціях, де вона зараз обіймає посаду CEO.

Щодо третього співзасновника, Джун Рао (Jun Rao), то він отримав ступінь бакалавра з комп’ютерних наук в Університеті Цінхуа у Пекіні у 1994 році, а докторський ступінь здобув на факультеті комп’ютерних наук Колумбійського університету в Нью-Йорку у червні 2000 року. Після захисту дисертації почав працювати дослідником у IBM Almaden Research Center в Сан-Хосе, Каліфорнія, де близько п’яти років займався дослідженнями в галузі баз даних та розподілених систем. Близько 2010 року приєднався до LinkedIn. У команді Confluent він відповідав за те, щоб Kafka була математично вивіреною та надійною. Саме завдяки його досвіду в Kafka була впроваджена модель ISR (In-Sync Replicas), яка гарантувала, що навіть при падінні серверів дані не будуть втрачені, що відкрило технології двері у фінансовий сектор. Джун є головою PMC Apache Kafka і коммітером Apache Cassandra.

Заснування Confluent і стрімке зростання

Вже за декілька років, до 2014 р., Apache Kafka стала феноменом, її використовували Netflix, Uber, Airbnb та Twitter. Індустрія отримала потужну технологію, яку троє інженерів створили для вирішення завдань, що виникли при розробці систем LinkedIn. Проте була проблема: система Kafka виявилась занадто складною для впровадження. Її налаштування та підтримка вимагали інженерної експертизи найвищого рівня, яка була на той момент доступна лише техногігантам. Таким чином, звичайні компанії, як-от банки, ритейлери й виробники, бажали використовувати Kafka, але не мали для цього достатньої кваліфікації.

І от 23 вересня 2014 року Джей, Неха та Джун прийняли рішення залишити комфортні посади в LinkedIn, щоб заснувати компанію, яка зробить Kafka доступною для всіх. Спочатку нове підприємство мало назву Infinitem, але згодом її перейменували на Confluent, що мало символізувати злиття всіх потоків даних в одне русло. Ідея була настільки потужною, що інвестори вишикувалися в чергу. Вже у листопаді того ж року компанія залучила 6,9 млн дол. у раунді Series A під керівництвом Benchmark Capital. Партнер Benchmark Ерік Вішрія став одним із перших, хто повірив у візію «потокових даних». Примітно, що LinkedIn також інвестував початкові 500 тис дол. у нову компанію.

Зі старту Confluent пішла перевіреним шляхом Open Core – моделі, яку успішно використовували Red Hat, MongoDB та інші компанії. Apache Kafka залишалася безкоштовною та відкритою, а компанія продавала Confluent Platform – платну версію для підприємств, яка включала додаткові інструменти: Schema Registry для управління форматами даних, REST Proxy для легшого підключення, KSQL для потокової обробки даних, та Control Center – графічний інтерфейс для моніторингу. Ця модель працювала добре. Серед замовників зʼявилися великі банки, такі як Goldman Sachs і JPMorgan Chase, та рітейлери, зокрема Walmart і Target, які почали купувати ліцензії Confluent.

Компанія демонструвала виняткову динаміку залучення інвестицій. У липні 2015 року було отримано ще 24 млн дол. у раунді Series B під керівництвом Index Ventures. Тоді оцінка стартапу склала вже 163 млн дол. Через два роки було проведено Series C під керівництвом Sequoia Capital. А у січні 2019 року компанія залучила ще 125 млн дол. у Series D під керівництвом знову ж таки Sequoia. На той момент загальне фінансування перевищило 200 млн, а оцінка – 2,5 млрд дол. У квітні 2020 року відбувся найбільший раунд – 250 млн дол. Series E під керівництвом Coatue. Загалом за п’ять раундів фінансування Confluent залучила 456 млн дол. від провідних венчурних фондів.

Хмарна трансформація та вихід на біржу

Десь у 2017 році засновники Confluent усвідомили загрозу – світ масово переходив у хмари, а модель «завантаж софт і встанови на свої сервери» помирала. Але тут була пастка: Amazon взяв безкоштовний код Apache Kafka і у листопаді 2018 року запустив власний сервіс – Amazon MSK. Це був екзистенційний виклик, адже Confluent ризикувала стати просто розробником безкоштовного коду, на якому заробляють такі гіганти, як та ж Amazon. Цей конфлікт став настільки гострим, що Confluent пішла на безпрецедентний крок, змінивши ліцензію частини своїх модулів на «Confluent Community License». Це юридично заборонило хмарним провайдерам продавати сервіси на базі коду Confluent, не відраховуючи їм роялті, що стало гучним прецедентом у світі Open Source.

Джей Крепс прийняв вольове, але ризиковане рішення: Confluent повинна стати Cloud-First компанією. Не просто перенести наявний продукт у хмару, а фундаментально переосмислити, як Kafka повинна працювати в хмарному світі. У січні 2020 року компанія оголосила Project Metamorphosis – амбітну інженерну та маркетингову кампанію з метою перетворити Kafka з «софту, який важко налаштувати» на «Serverless сервіс даних».

Щоб перемогти Amazon на його ж полі, Confluent таємно переписала код Kafka для своєї хмари, створивши Kora Engine – власну реалізацію з ключовою інновацією: розділенням обчислення та зберігання. В рамках цього оновлення інженери також позбулися застарілого координатора ZooKeeper, який був «вузьким місцем», замінивши його власним протоколом консенсусу KRaft. Раніше в Kafka дані зберігалися на дорогих дисках серверів, що робило довгострокове зберігання історії подій надзвичайно дорогим. Kora дозволяла автоматично скидати старі дані в дешеве об’єктне сховище, зберігаючи миттєвий доступ до гарячих даних. Завдяки цій технології Tiered Storage Kafka фактично перетворилася на базу даних з нескінченною глибиною історії. Це зробило зберігання даних у Confluent Cloud в 5-10 разів дешевшим, ніж у «чистої» версії Kafka. Крім того, платформа здобула справжню еластичність – клієнти могли натиснути кнопку і миттєво отримати в 10 разів більше пропускної здатності. Це стало економічною та технологічною перевагою, яку конкуренти не могли легко скопіювати.

Вже до 2021 року Confluent перетворилася на безперечного лідера в категорії «Data Streaming». Виручка компанії зростала експоненціально: у 2019 році – 149 млн дол., у 2020 – 236 млн дол. Компанія 24 червня 2021 року вийшла на біржу NASDAQ під тикером CFLT, залучивши 828 млн дол. від продажу 23 млн акцій за $36 кожна. Перший день торгів виявився тріумфальним: акції злетіли на 25%, закрившись на рівні $45,02. На пікових показниках першого дня компанію оцінювали у понад 11 млрд дол. IPO зробило засновників мільярдерами.

До 2025 року Confluent побудувала повну екосистему продуктів навколо Kafka. Флагманський продукт, Confluent Cloud, є повністю керованим хмарним сервісом, який працює на платформах всіх трьох хмарних гігантів. Компанія розробила понад 120 готових конекторів, які дозволяють підключити Kafka до будь-чого: від застарілої бази Oracle до сучасного Snowflake. У січні 2023 року Confluent здійснила стратегічне поглинання стартапу Immerok, заснованого творцями Apache Flink. Якщо Kafka – це «нервова система», то Flink – це «мозок», який дозволяє виконувати складні обчислення на потоках даних. У червні 2024 року Confluent офіційно запустила Confluent Cloud для Apache Flink.

Угода з IBM: новий розділ історії

У момент оголошення угоди з IBM компанія Confluent обслуговувала понад 6500 клієнтів по всьому світу, включаючи більш ніж 40% компаній зі списку Fortune 500. Серед клієнтів – Citigroup, Goldman Sachs, Uber, Netflix, British Gas, Royal Bank of Canada, Walmart, LinkedIn та тисячі інших. За оцінками галузевих аналітиків, близько 80% компаній Fortune 100 використовують Apache Kafka. На кінець ІІІ кв. 2025 року Confluent продовжує демонструвати стійке зростання у ключових сегментах: кількість клієнтів з річним постійним доходом (ARR) понад 100 тис дол. досягла 1487, що відображає зростання приблизно на 10% у річному вимірі. Водночас, сегмент найбільших корпоративних клієнтів із ARR понад 1 млн дол. показав прискорене зростання – до 234, тут збільшення на 27%.

Фінансові показники компанії демонстрували стабільне зростання: у 2023 році виручка склала 776,95 млн дол., у 2024 – 963,64 млн дол. (+24%), з цього Confluent Cloud – 492 млн дол. (+41% річних). Попри збитки у 345 млн дол. торік, фіксувалося послідовне покращення операційної маржі. Вперше в історії Confluent non-GAAP операційна маржа стала позитивною – це важлива віха на шляху до прибутковості. За чотири роки загальний цільовий ринок подвоївся – з 50 млрд дол. у 2021 році до 100 млрд дол. у 2025 році. При поточній виручці близько 1 млрд дол., оцінка угоди в 11 млрд дол. (мультиплікатор x11) виглядає доволі консервативною і прагматичною, порівняно з «перегрітими» оцінками 2021 року, що свідчить про зрілість ринку.

Переговори між IBM та Confluent велися у найвищій таємниці протягом кількох місяців. У понеділок 8 грудня 2025 року «Блакитний гігант» оголосив про укладення остаточної угоди щодо придбання всіх акцій розробника Kafka за ціною 31 дол. готівкою, тобто за 11 млрд дол. Пропозиція представляла премію близько 33-35% до ціни закриття у п’ятницю 6 грудня. Реакція ринку була миттєвою і драматичною – у передторгову сесію понеділка, 9 грудня, акції Confluent підскочили на 29%, торгуючись біля позначки 30. Найбільші акціонери, які контролюють приблизно 62% голосуючих акцій, уклали угоду з IBM про підтримку транзакції. Очікується, що угода буде завершена до середини 2026 року після схвалення акціонерами та регуляторними органами.

Для IBM придбання Confluent стало частиною стратегії посилення позицій у сферах гібридних хмар та штучного інтелекту під керівництвом CEO Арвінда Крішна (Arvind Krishna). За прогнозами IDC, до 2028 року з’явиться понад один мільярд нових логічних застосунків, а глобальний обсяг даних більш ніж подвоїться, досягнувши 200+ зетабайт. Confluent надає IBM критично важливу інфраструктуру для роботи з даними в режимі реального часу, що є фундаментальним для розгортання AI-систем.

Крішна описав придбання як «рішучий крок», що прискорює стратегію компанії в галузі гібридних хмар та AI, створюючи «інтелектуальне, завжди активне ядро» для корпоративних даних. Він провів паралелі з попередніми поглинаннями Red Hat (34 млрд дол. у 2019 році) та HashiCorp (6,4 млрд дол. у 2024 році), зазначивши, що Confluent відповідає тій же «дисциплінованій стратегії» поглинання потужних open-source платформ. IBM очікує, що угода стане акретивною (прибутковою / економічно вигідною) для скоригованого EBITDA протягом першого повного року після закриття. Компанія фінансує придбання повністю наявними коштами, без залучення зовнішнього боргового фінансування.

Confluent буде інтегровано в портфель IBM Software, який вже включає Red Hat, Watson AI, Automation та HashiCorp. Це придбання створює потужну синергію: оператори Confluent для Kubernetes ідеально доповнюють платформу Red Hat OpenShift, а технології CDC (Change Data Capture) дозволять IBM модернізувати бізнес клієнтів, які досі використовують застарілі мейнфрейми, безшовно витягуючи з них дані. Як зазначається, придбана платформа потокової передачі даних у режимі реального часу дозволить IBM надавати клієнтам наскрізну інтеграцію застосунків, аналітики, систем даних та AI-агентів. Особливо важливою є здатність Confluent готувати дані для AI – тримати їх чистими, структурованими та підключеними через різнорідні системи, усуваючи розрізненість даних, властиву великим підприємствам. Це критично важливо для архітектури RAG (Retrieval-Augmented Generation), де AI-моделі потребують не просто навчених знань, а актуальних фактів у реальному часі, щоб уникнути «галюцинацій». Як підкреслив Крішна: «Моделі настільки сильні, наскільки сильні сигнали, що їх живлять. Без потоків даних у реальному часі AI-системи працюють на застарілій інформації».

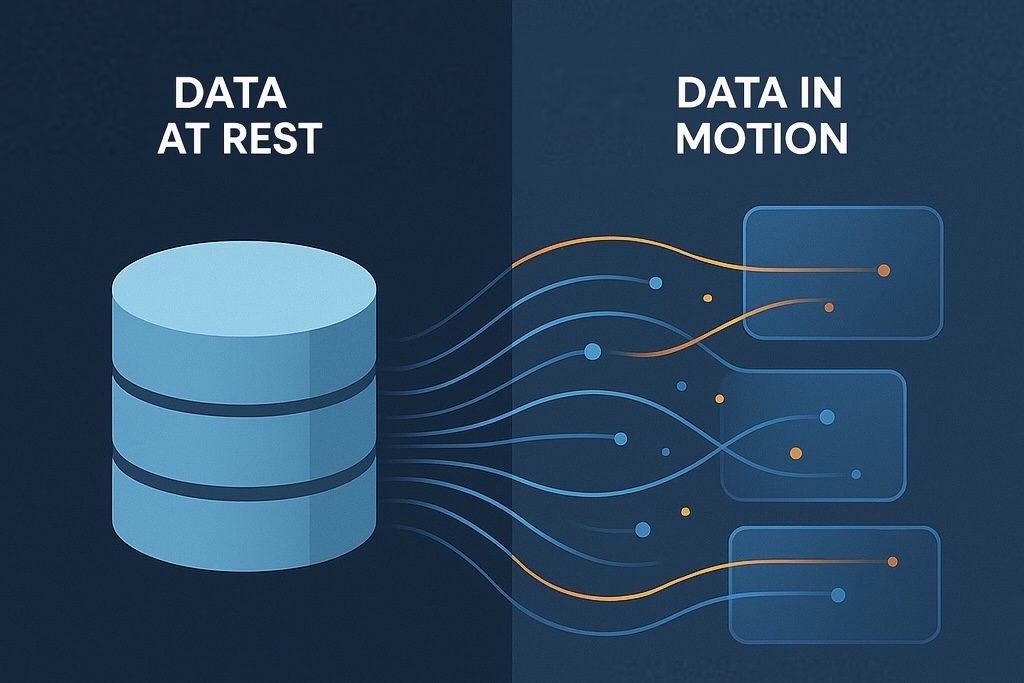

Спадщина Confluent: від Data at Rest до Data in Motion

Confluent фундаментально змінила парадигму роботи з даними. До її появи дані в корпораціях переважно «спали» – зберігалися в базах даних, чекаючи запитів. Аналітика виконувалася пакетами – дані збиралися протягом дня, вночі оброблялися, а вранці бізнес отримував звіти про вчорашній день. Це була епоха «Data at Rest». Confluent проголосила еру «Data in Motion» – дані стали безперервним потоком подій, на які бізнес повинен реагувати миттєво. Сьогодні Kafka стала стандартом де-факто для побудови event-driven архітектур.

Корпорації застосовують Kafka для аналітики у реальному часі – наприклад, для миттєвого аналізу поведінки користувачів, виявлення шахрайства. Goldman Sachs використовує це рішення для обробки трильйонів доларів транзакцій щодня, Uber – для координації сотень мікросервісів, LinkedIn – для синхронізації даних між десятками внутрішніх систем, Tesla – для обробки телеметрії з мільйонів автомобілів у реальному часі.

Компанія Confluent працювала в конкурентному середовищі протягом усієї своєї історії. Хмарні гіганти – AWS (з Amazon MSK), Microsoft Azure та Google Cloud пропонують власні керовані версії Kafka за нижчими цінами. З’явилися також нові гравці: Redpanda, який повністю переписав Kafka на C++, обіцяючи у 10 разів кращу продуктивність. Архітектура Redpanda (thread-per-core) дозволила уникнути проблем із «паузами» на очищення пам’яті (Garbage Collection), які історично були слабким місцем Java-базованої Kafka. Також на ринку присутній Apache Pulsar від Yahoo. Ще одним конкурентним фронтом стала боротьба між Apache Flink (підтримуваним Confluent) та Apache Spark (Databricks): Flink пропонує «чесний стрімінг» з обробкою кожної події окремо, тоді як Spark традиційно працює мікро-пакетами. Після піку у $98 на початку 2022 року акції Confluent впали до $17 у 2023 році через загальний спад ринку технологічних компаній. Компанія була змушена скоротити 10% персоналу у 2023 році та сфокусуватися на операційній ефективності.

Confluent відома своєю культурою, яку Крепс називає «Earn our customers’ love» («Заслужити любов клієнтів»). На відміну від агресивних продажів, компанія фокусується на освіті клієнтів, інвестуючи мільйони у створення навчальних матеріалів, безкоштовних курсів, детальної документації. Після пандемії COVID-19 Confluent стала компанією «Remote First», що дозволило наймати таланти по всьому світу. На момент IPO у компанії працювало близько 2000 співробітників, до кінця 2024 року було вже понад 3000.

За одинадцять років Confluent пройшла шлях від маленького стартапу до фундаментальної компанії інфраструктурного програмного забезпечення з оцінкою у 11 млрд дол. кешем. Вони зробили для індустрії даних те, що Google свого часу зробила для інформації в Інтернеті – організували їх і зробили доступними. Історія Confluent – це доказ того, що глибоко технічна проблема може стати основою для багатомільярдного бізнесу, якщо вирішити її елегантно і масштабно.

Це також приклад успішної комерціалізації open-source технології. Confluent знайшла тонкий баланс між розвитком безкоштовної спільноти Apache Kafka та побудовою прибуткового бізнесу навколо неї. Троє засновників демонструють різні траєкторії успіху. Джей Крепс залишається CEO до завершення угоди і, ймовірно, займе важливе місце в структурі IBM. Неха Наркхеде, яка пішла з Confluent у 2020 році, будує новий стартап Oscilar. Джун Рао залишається технічним лідером Apache Kafka та активним учасником open-source спільноти.

Безумовно, угода з IBM відкриває новий розділ в історії Confluent. Інтеграція з портфелем IBM повинна створити потужну платформу для корпоративних даних та штучного інтелекту. Це також символізує дозрівання ринку потокової обробки даних – від нішевої технології для технологічних гігантів до критичної інфраструктури для будь-якого великого підприємства у світі.

Час покаже, чи стане це поглинання таким же успішним, як придбання Red Hat, чи повторить помилки численних невдалих інтеграцій у технологічній індустрії. Але одне безсумнівно: історія Confluent вже назавжди змінила те, як світ думає про дані – не як про щось статичне, що лежить у базах, а як про живий потік подій, який рухає сучасний бізнес.