|

СПЕЦІАЛЬНІ ПАРТНЕРИ ПРОЕКТУ BEST CIOОпределение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях Человек годаКто внес наибольший вклад в развитие украинского ИТ-рынка. Продукт годаНаграды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары |

Кто на свете всех быстрее?..

Автор – Владимир Савяк, 21 июля 2011 г.

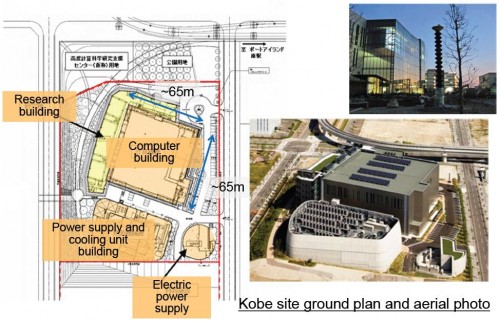

В Гамбурге состоялась ежегодная международная суперкомпьютерная конференция ISC’11, которая собирает практически всех участников мирового суперкомпьютерного сообщества. Во время конференции проходит большая выставка и объявляется июньский перечень наиболее мощных суперкомпьютеров мира (существует еще ноябрьская версия перечня топ 500, которая объявляется на подобном форуме – «SC», проходящем в США). В этом году на ISC пожаловало 2194 участников, среди которых было и несколько гостей из Украины. Мероприятие сопровождалось живым блогом, а также видеоблогом, который монтировался буквально вживую и выкладывался на YouTube. Ознакомиться с видео-публикациями можно по ссылке. Машины В первую очередь, хотелось бы отметить самую яркую новость ISC’11, а именно, победу в состязаниях самых мощных суперкомпьютеров японского шедевра инженерии и компьютерных наук «K Computer», построенного Fujitsu. 37-я редакция перечня самых мощных компьютеров в мире, в которой зафиксирована эта победа, была опубликована 20 июня 2011 г. Короткий анализ этого перечня свидетельствует об усилении тенденций сверхпараллелизма (значительное увеличение количества вычислительных элементов в сравнении с увеличением продуктивности одного). Данная тенденция наметилась уже более 10 лет тому назад и пока лишь лабораторные технологии могут поспорить с тем, что она будет отображена в перечне в ближайшие 5-10 лет. Она проявляется в значительной мере в применении многоядерных процессоров и разнообразных ускорителях, которые используют численные вычислительные элементы в рамках одного кристалла. Такой подход позволяет эффективно решать задачи с массовым параллелизмом, но, к сожалению, не дает возможности ускорить выполнение дополнений, которые не могут быть эффективно распараллелены. K Computer, установленный в Японии в RIKEN Advanced Institute for Computational Science (Институт передовых вычислительных наук RIKEN) компанией Fujitsu, оказался на первой ступеньке рейтинга. Система построена на базе процессоров Sparc64 Viiifx, ее производительность на тесте Linpack составляет 8.16 Pflop/s, при эффективности 93%, что характеризует ее как настоящее творение компьютерной инженерии. Детальную информацию о перечне топ-500 можно получить по ссылке, и соответственно, информацию о системе K Computer по следующей ссылке. Кстати, название машины происходит от японского иероглифа «Кей», который означает 10 квадриллионов (10*1015 или 10 петафлопс). Вы можете просмотреть видео «Supercomputer’s Revolution from Japan» (Революция суперкомпьютера из Японии) от канала Discovery. Стоимость проекта составила 1,2 млрд. долл., а поддержка системы будет стоить около 10 млн долл. в год. В соответствии с публичной информацией суперкомпьютер будет использоваться для:

Как считают японцы, даже сама возможность сократить время прогнозирования цунами, землетрясений и других естественных катаклизмов уже стоит того, чтобы создать такую машину. Система построена в полностью оригинальном конструктиве, похожем на стандартные 19 дюймовые шкафы, и в собственном формате. В конечном итоге, под систему построен отдельный архитектурный комплекс, который кроме всего предусматривает элементы для повышения сейсмостойкости, и такая безделушка как изготовление собственного шкафного конструктива не оказалась исключительной. Она, как и все другое, – создана в Японии.

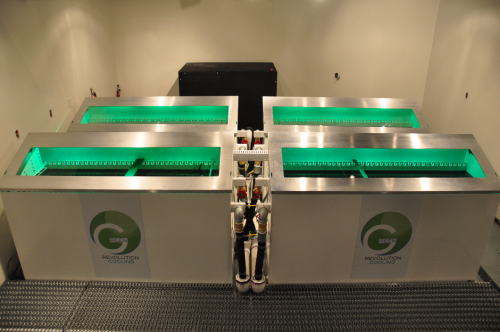

Kcomputer, как уже отмечалось, построен на базе японских процессоров Sparc6 Viiifx CPU, которые проектируются и изготовляются Fujitsu по 45nm технологии и потребляют 58Вт на процессор. Архитектура процессоров Sparc разработана в 1985 г. компанией Sun Microsystems и была представлена мировому сообществу в 1987 г. В 1989 была основана компания SPARC International Inc, которая продает лицензии на архитектуру и системы команд, на основе которой Fujitsu и, начиная с 1992 г., когда собственно и вышел процессор Sparclite – Fujitsu Mb8683x, выпускает собственные процессоры Sparc. Система использует 80 тыс. таких кристаллов, каждый из которых содержит 8 процессорных ядер, таким образом, 64 тыс. ядер составляют вычислительную мощность системы. Основой очень высокого показателя эффективности системы является подсистема обмена данными между процессором – памятью, и между вычислительными узлами. Комплекс построен из 4-х процессорных вычислительных узлов, соединенных между собой высокопроизводительным межузловым коммуникационным интерфейсом Tofu. Тепло от процессоров, с помощью системы водяного охлаждения, отводится наружу в отдельное здание, где расположены чиллерные системы и градирни, где и происходит охлаждение воды, которая несет тепло из вычислительных и коммуникационных чипов. Межузловая коммутационная сеть в системе построена по топологии шестимерного тора. Такая не простая, на первый взгляд, коммутационная сеть позволяет минимизировать время, затрачиваемое на коммуникации между узлами системы, вместе с тем обеспечивая меньшую стоимость, в сравнении с традиционной для таких систем коммутацией типа сети Клоса. Интересно, что по тороидальной топологии строились первые суперкомпьютеры на кластерной архитектуре – ucube / SCIT в новом Украинском государстве в Институте Кибернетики НАНУ, созданные в 1993-1995 гг. ПНВП «Юстар». Невзирая на то, что тороидальные технологии требуют большее количество кабелей, чем топология с использованием центрального коммутатора, они позволяют строить системы с большим количеством узлов без коммутаторов. Важным ее преимуществом также является ее большая пропускная способность и отказоустойчивость, так как данные между узлами могут двигаться по разным маршрутам одновременно. Вторую ступеньку занимает прежний рекордсмен, машина, – Tianhe-1a, установленная в Национальном центре суперкомпьютера в Тяньцзине, Китай, с пиковой производительностью 4.7 Pflop/s и стоимостью менее 100 млн. долл. Ее производительность составляет ~55%, соответственно, производительность с результатами теста Linpack составила 2.57 Pflop/s. Система построена на базе процессоров Intel Xeon и ускорителей GPU NVIDIA M2050. Третья ступенька перечня досталась машине Jaguar Cray Xt5, которая установлена в Oak Ridge National Laboratory (Национальная лаборатория Оук-Ридж, США). Его производительность на тесте Linpack составила 1.76pflop/s, при производительности ~76%. Система построена на базе процессоров AMD Opteron и использует оригинальную разработку Cray Seastar2+ для межузловых коммуникаций. Стоимость проекта – 104 млн. долл. Хотелось бы отметить, что в настоящее время даже пятисотое место в рейтинге может занять лишь система с производительностью свыше 40 Tflop/s на тесте Linpack. В то время как самая мощная на сегодня украинская система, установленная в КПИ, имеет производительность ~5.7 Tflop/s на тесте Linpack при пиковой ~7.3 Tflop/s. Ниже можно ознакомиться с презентацией оргкомитета топ-500 результатов анализа текущего рейтинга. View more presentations from top500 Перечень самых мощных вычислительных машин достаточно ярко отображает политику развитых в научно-техническом плане стран, так как в значительной мере он остается местом проявления политических амбиций, о чем можно часто услышать в кулуарах конференции ISC. Страны Традиционно японцы показывают себя как наиболее эффективную высокотехнологическую нацию, ее системы, хотя и не занимают значительную часть рейтинга по количеству, однако систематически занимают в нем первые позиции, как по общей производительности, так и по эффективности. Фактически, именно эффективность является отображением инженерного мастерства. И особенно тот факт, что у японцев самые большие машины строятся полностью японскими компаниями на базе японских компонентов, не может не вызывать уважение. США, конечно, были и остаются гегемонами рейтинга как передовая страна в сфере ИТ. Американские машины постоянно занимают первые ступеньки перечня, время от времени уступая той или другой машине из Японии, Китая или Европы. А китайцы, которые в этом году заняли второе место, опустившись с первого, которое они занимали в прошлом году, как того можно ожидать, пока еще не достаточно технологичны. Их машины больше отображают желания страны отметиться в перечне наличием у Поднебесной необходимых для этого финансов. Россия (система Ломоносов на данный момент занимает 13 ступеньку перечня), система которой также нашла свое место в перечне самых мощных вычислительных машин мира, находится где-то на ступень выше по технологичности от Китая, хотя значительно отстает в плане железных технологий от Японии и США. В то же время, приятным фактом для меня является то, что в создании самых больших российских машин принимают участие украинские программисты. Есть ли в перечне 500 самых мощных в мире суперкомпьютеров место для украинских машин? На мой взгляд, это зависит только от готовности государства финансировать их построение, а кому их создавать – найдется. Итак, с перечнем top500 мы покончили, теперь перейдем к более практическим вещам. Расскажу о новинках от производителей аппаратного и программного обеспечения, да и о самих производителях, на которых есть смысл обратить внимание. Технологии Интересным открытием для меня стали несколько компаний-производителей 10gb Ethernet коммутаторов. Если до сих пор в сфере высокопродуктивных вычислений на рынке 10gbe реальными игроками были Fujitsu, Voltaire и проявляли определенную активность такие игроки рынка ЦОД, как Force10 и Extreme Networking, то в этот раз я встретил одного совсем нового игрока – Gnodal, ветеранов рынка – Interface Masters (раньше мне не известных), и достаточно крупного и известного в мире игрока рынка 10gbe – компанию ARISTA, руководит которой один из первооснователей Sun Microsystems. Невзирая на большую на данный момент коммерческую ценность продуктов компании ARISTA и Interface Masters (поставщики ряда 10gbe решений для Cisco), для меня особенный интерес представляет именно Gnodal. Компания основана 2007 г. одним из ключевых менеджеров Quadrics – Фрэдом Хоумвудом (Fred Homewood), который руководил в Quadrics разработкой высокопродуктивных коммутаторов для суперкомпьютерных инсталляций. Коммутаторам и интерфейсным карточкам производства Quadrics не было равных по производительности и латентности до 2006 г. И хотя продукция компании была не из дешевых, ее использовали в наибольших в мире инсталляциях высокопродуктивных кластеров. Сегодня Gnodal предлагает уже готовые к использованию в ЦОД и высокопродуктивных кластерах коммутаторы 10gbe/40gbe с уникальными на рынке характеристиками. Фактически, ключевым в решениях Gnodal является ASIC собственной разработки, который и обеспечивает несравненную производительность и низкую латентность. В качестве же программной составляющей компания использует известный в индустрии программный стек Intelligent Switch Solution (ISS) от Aricent, который обеспечивает качественное управление системой. Относительно технических характеристик, коммутаторы от Gnodal обеспечивают плотность до 72 портов 10gbe на 1u, 1.5tbps Throughput, 150ns Latency, 1.6w / port. Приятные знакомства и интересные встречи в этом году состоялись у меня с участниками сообщества по поддержке кластерной файловой системы Lustre. После того, как Oracle отказался от финансирования разработок и поддержки Lustre (которая досталась Oracle от Sun Microsystems) на базе платформы Linux, мировое сообщество мгновенно отреагировало, предложив рынку несколько инициатив по ее поддержке. Lustre на сегодня является наиболее интересной и, очевидно, самой производительной кластерной файловой системой в мире. Сегодня она представлена в наибольших инсталляциях суперкомпьютеров мира, а также в огромной массе вычислительных систем уровня национальных лабораторий. В Украине нам повезло интегрировать Lustre в наибольшие отечественные машины, и несколько менее значительные инсталляции, где она показала себя как действительно высококлассная, надежная и скоростная файловая система. Что интересно, в команду разработки Lustre, еще со времен ее опеки командой CFS а позже Sun, входила группа разработчиков из Киева. Они внесли значительный вклад в развитие системы и ее поддержку, и на данный момент трудятся (по крайней мере, частично) в компаниях, которые взялись за коммерческую поддержку Lustre, а именно – Xyratex и Whamcloud. Мне наконец повезло познакомиться c Питером Бояником (здесь вы можете пересмотреть видео, в котором Питер рассказывает о его видении развития данной технологии в новой компании и на рынке вообще). Питер поделился со мной интересной информацией о будущем развитии системы, а особенно о том, как украинская команда попала к разработчикам Lustre. О продукте, который предлагает Xyratex можно больше прочитать в блоге. Другой продукт, который, хотя и не удивил меня, так как уже слышал о нем раньше, однако порадовал визуальным присутствием. Это система жидкостного охлаждения от Green Revolution Cooling. Ребята воспользовались для охлаждения серверов самым обычным чистым минеральным маслом, которое используется, например, в косметологии, для ухода за кожей малышей.

Чистое минеральное масло является диэлектриком и в него можно погрузить ваши серверы для максимально эффективного отведения тепла, прокачивая его через открытую градирню/теплообменник. Система охлаждения подобного типа будет максимально эффективной (будет иметь минимальное PUE, ниже, чем 1,1), так как энергетические расходы на функционирование подсистемы теплоотведения будут прежде всего связаны с насосами, которые обеспечивают циркуляцию жидкости через контур – градирня/шкаф. Причем подсистема насосов в данном решении организована в отказостойком режиме. Благодаря значительной массе жидкости, которая используется для теплоотведения, в случае исчезновения напряжения на насосах и их полной остановки, система не получит тепловой шок.

Благодаря высокой эффективности отведения тепла через жидкость, в контейнер размером в стандартный 19-ти дюймовый шкаф 42u, можно установить стандартное оборудование мощностью 100КВт и эффективно его отводить. Это может быть очень актуальным при значительном росте плотности высокопродуктивных вычислительных систем, которую можно наблюдать сегодня. Порадовал также Viking (Sanmina-SCI Corporation) своими модульными решениями для высокопродуктивных вычислений. Вот несколько интересных решений, которые могут понадобиться при построении систем с выдающимися параметрами производительности и плотности. Например, модули ОЗУ Ram-stack, которые позволяют получить плотность большую в 2-4 раза, чем стандартные, уже широко доступны на рынке решений. При использовании таких модулей, можно получить 288gb оперативки на 2-х процессорной материнке, а в ближайшее время еще больше. Другое интересное предложение – это использовать свободные слоты под ОЗУ для установки SSD накопителей. Такие накопители устанавливаются в слоты для DIMM, получая из них питание и используя соответствующее место для монтажа, а подключаются к SATA/SAS интерфейсу обычным внутренним кабелем. И, как всегда, меня порадовали SGI. На конференции компания представила новый Carlsbad 3 (высокопродуктивная кластерная система), который продается в компании под маркой Altix ICE. Новое поколение систем Altix ICE построено на базе Intel Xeon («Sandy Bridge EP») и использует для межузловой коммуникации FDR Infiniband (Fourteen Data Rate, с производительностью 56gb/sec). Система имеет абсолютно новый дизайн (к сожалению, пока еще не доступный для публикации), позволяющий масштабироваться до 2304 ядер на один шкаф (8 cores x 2 Cpus x 36 blades x 4 enclosures). Оригинальной особенностью системы является интегрированный FDR Infiniband backpalne и соответствующие коммутаторы, что значительно упрощает каблирование, обеспечивает высокую надежность и производительность и позволяет недорого строить такую топологию коммутации, как толстое дерево, гиперкуб, а также и так называемый расширенный гиперкуб. Не сложно подсчитать, что при количестве вычислительных двухпроцессорных узлов – 144 штуки на шкаф (материнские платы в модели M-rack планируется размещать парами друг напротив друга почти впритык, благодаря жидкостному охлаждению, таким образом достигая двойной плотности в сравнении с предыдущим дизайном), потребляемая мощность на шкаф может составлять свыше 80КВт. Как и ряд других производителей, SGI добавили в новый дизайн системы жидкостное охлаждение на уровне компонента вычислительного узла, а не только в виде водяных дверей, как это было раньше. Фактически, это едва ли не единственный способ эффективно отвести тепло из плотно набитого процессорами и другими компонентами шкафа. Новое жидкостное охлаждение позволяет обеспечить так называемое «охлаждение теплой водой». Это дает возможность уменьшить расходы на обеспечение нужного микроклимата функционирования системы, поскольку жидкость, которая поступает в систему, может иметь температуру вплоть до 30оС. Вместе с тем будет существовать и традиционный дизайн с воздушным охлаждением, который по плотности будет лучше Carlsbad 2 всего на 33%. Важные изменения в дизайне системы состоялись на уровне подсистемы электропитания. Для того, чтобы более эффективно обеспечивать подачу питания на рабочие элементы системы, модуль из блоков питания вынесен в отдельную полку. В зависимости от потребляемой мощности (какая, при использовании акселераторов, скажем, от NVIDIA), может значительно расти, можно будет использовать больше или меньше модулей питания, тем самым обеспечивая их максимально эффективную загрузку. В целом, в системе очень много инноваций и совершенствований, но о них я расскажу, когда большая часть информации станет публично доступной. Было очень приятно и полезно лично познакомиться на конференции с генеральным директором SGI Марком Барренечеа (Mark Barrenechea). Во время встречи я узнал немало интересного о планах развития флагманской линейки Altix UV, которая являет собой наиболее масштабируемые по процессорам и памяти серверные системы в мире. Как можно прочитать на странице компании, данная система оснащена процессорами Intel Xeon, предлагает масштабируемость до 2048 процессорных ядер (что является пределом масштабируемости OS Suse Linux – кстати, это практический максимум среди всех ОС на сегодняшний день). И с недавних пор система сертифицирована под использование Microsoft Windows Server Datacenter Edition. Не могу раскрыть все детали того, что было сказано, но рекомендую всем, кто интересуется не только высокопродуктивными научными вычислениями, но и обработкой больших баз данных, внимательно следить за развитием отношений между SGI и Microsoft. В будущем году увидим много интересного вокруг Altix UV и Microsoft SQL Server. Стратегія охолодження ЦОД для епохи AI

Читайте также

|

Останні обговоренняТОП-новости

ТОП-блогиТОП-статьи

|

||||||||||