|

СПЕЦІАЛЬНІ ПАРТНЕРИ ПРОЕКТУ BEST CIOОпределение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях Человек годаКто внес наибольший вклад в развитие украинского ИТ-рынка. Продукт годаНаграды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары |

Графические серверы и AMD EPYC

Автор – Андрій Тищенко, 23 июля 2020 г.

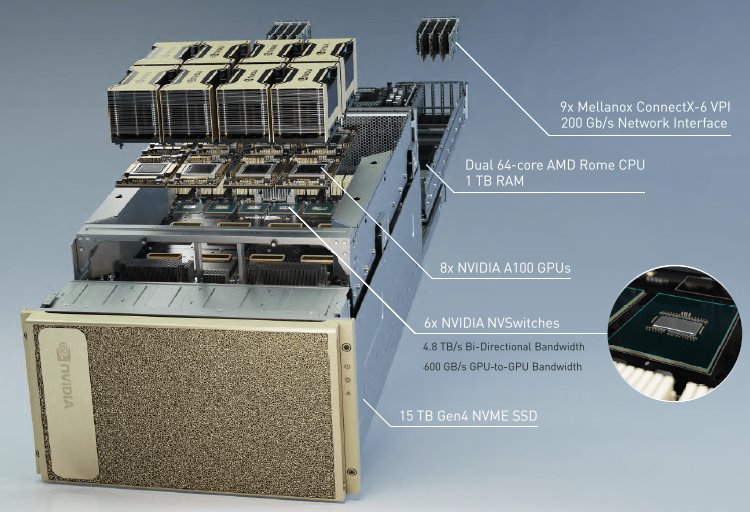

Представление о рыночном соперничестве как игре с нулевой суммой («выигрыш одного равен проигрышу другого») мешает оценить выгоды кооперативной конкуренции (или конкурентной кооперации — что кому ближе). Как у AMD c NVIDIA. Показывая NVIDIA DGX A100, универсальную систему под задачи машинного обучения (искусственного интеллекта, ИИ) с производительностью 5 петафлопс, NVIDIA нахваливала свои графические ускорители Tesla A100 и (теперь уже свои) сетевые адаптеры Mellanox ConnetX-6VPI c пропускной способностью 200 Гбит/с. Тенью прошло неординарное событие — впервые в своей практике NVIDIA выбрала центральные процессоры от AMD, не от Intel.

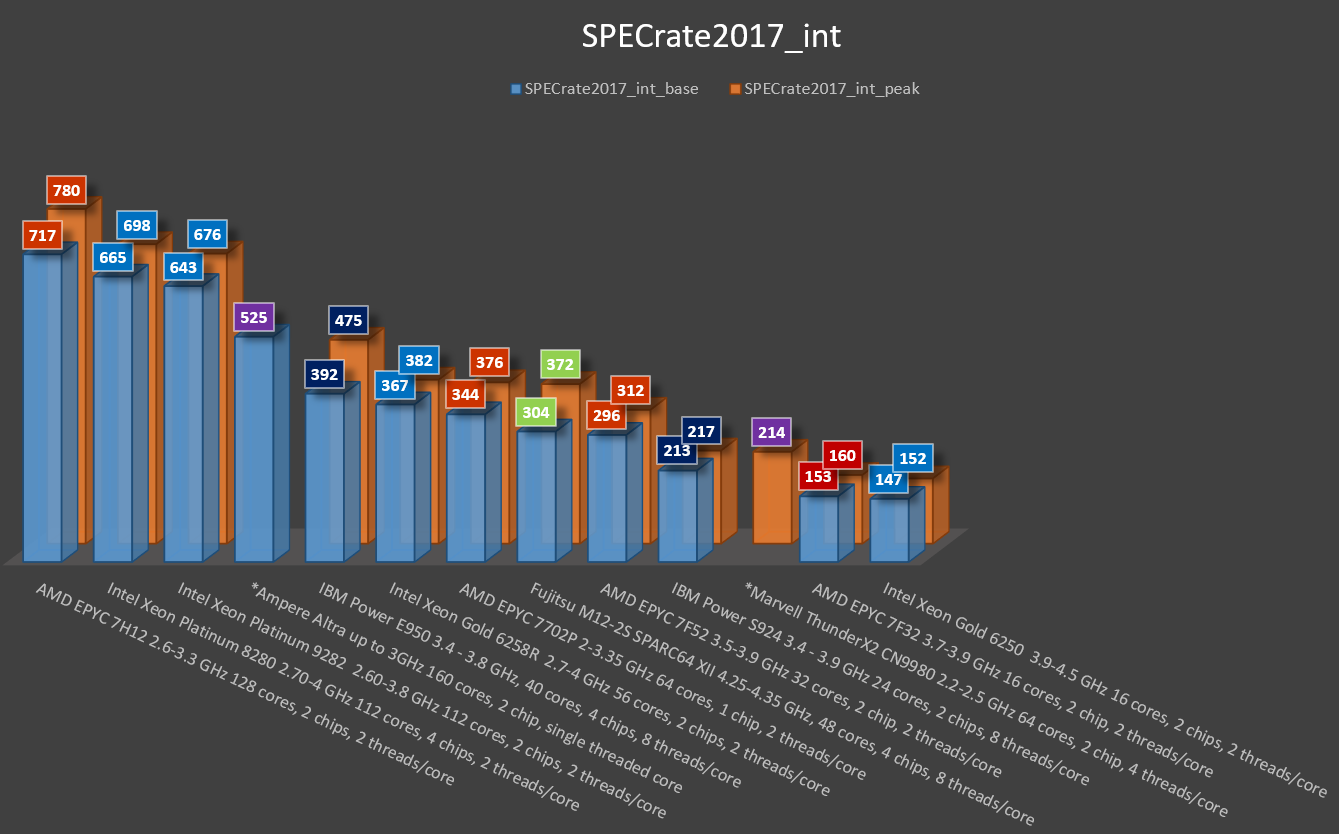

Cама AMD считает процессоры EPYC ключевым компонентом для высокопроизводительных вычислений (HPC). Чарли Бойли, вице-президент NVIDIA, с этим не спорит: «Наши новые графические процессоры A100, которые мы используем в DGX A100, обеспечивают огромный скачок производительности и возможностей. Чтобы они снабжались данными, нам требовались быстрые центральные процессоры с максимально возможным количеством ядер и PCI-линий. Используемые нами процессоры AMD [EPYC 7742] имеют по 64 ядра, много линий PCI и поддерживают PCIe Gen4». Экосистема ИИ Интеграцию процессоров EPYC в системы NVIDIA AMD называет «продолжением роста экосистемы». AMD EPYC второго поколения — единственные x86-совместимые процессоры, в которых насчитывается до 64 ядер и до 128 линий PCIe Gen 4. У AMD есть своя линейка графических процессоров Vega и ускорителей Radeon Instinct, что не является препятствием для соучастия в сторонних масштабных проектах. NVIDIA сегодня — объективный лидер в ИИ, а DGX A100 — готовая к коммерческой эксплуатации система. Поставки систем идут полным ходом: в Министерство энергетики США, университет Флориды, центр биомедицинского ИИ в Гамбурге, ведущие исследовательские лаборатории. Когда-то дойдет дело и до Radeon Instinct, но пока что для AMD важна роль партнера на рынке и причастность к HPC во всех его проявлениях. Спрос на GPU-вычислители «Cамая крупная графическая карта» NVIDIA DGX A100 стоит $200 тыс. Каждый из ее восьми ускорителей NVIDIA A100 — около $13 тыс. У GPU-cерверов есть и массовое применение — в аналитических и самообучающихся системах разного масштаба, с куда меньшими бюджетами. Выбор GPU велик: Tesla, Quadro RTX, да хоть GeForce. У каждой задачи есть свой набор метрик и критериев — как в этом обзоре систем компьютерного зрения и машинного перевода. Производители серверных платформ внимательно следят за трендами, включая GPU-расчеты. Встречаются совсем уж экзотические продукты, серверы Supercmicro для развешивания на столбах в эпоху IoT, 5G и смарт-городов. Но чаще это серверы 1-2U, под размещение в них 4–8 GPU. Один процессор AMD EPYC (128 линий PCIe, до 64 ядер) привлекательнее одного Intel Xeon SP (48 линий PCIe, до 28 ядер) в качестве базы GPU-сервера. Два процессора еще интереснее, хотя избыточны в большинстве прикладных задач. К первому поколению AMD EPYC 7001 (Naples) разработчики присматривались, на втором 7002 (Rome) перешли к действиям. Односокетные системы под большое число графических ускорителей идеальны для машинного обучения, научных расчетов, моделирования, VDI, кодирования видео и раздачи потоков. Два примера платформ 2U / 8 GPU под «земные» задачи Gigabyte G292-Z22 — односокетная платформа на AMD EPYC 7002 форм-фактора 2U под установку 8 одно- или 4 двухслотовых GPU-ускорителей.

Графический сервер ASUS ESC4000A-E10 скроен примерно так же. Оба поддерживают ускорители NVIDIA A100, Tesla T4, Quadro и AMD Radeon Instinct.

В сервере ASUS ESC4000A-E10 аж 11 слотов PCIe Gen 4 для установки плат расширения: графических акселераторов, дисковых и сетевых контроллеров. Поддерживается установка Ethernet-адаптера стандарта OCP 3.0 с пропускной способностью до 200 Гбит/с — пусть не в таком же количестве как у NVIDIA DGX A100, зато таких же. В сервер можно установить до восьми 3,5- или 2,5-дюймовых жестких дисков с поддержкой «горячей» замены, причем четыре устройства могут быть NVMe-накопителями. «Кесарю кесарево» Не платформы главное в GPU-расчетах, а гармония между используемыми программными моделями и аппаратной начинкой. Заказчики таких серверов — завсегдатаи площадок для разработчиков вроде GitHub. Тот случай, когда задачами правит глубокая экспертиза, а не вкусовщина пополам с религиозным рвением. Стратегія охолодження ЦОД для епохи AI

Читайте также

|

Останні обговоренняТОП-новости

ТОП-блогиТОП-статьи

|

||||||||||

"Два процессора еще интереснее"

причем они могут быть интереснее даже 4-х от ряда конкурентов

https://dou.ua/forums/topic/31182/

Хорошо хоть в обзоре упорядочили по CPU2017 Integer Rate, могли бы по количеству контактов, или по площади кристалла. В данном конкретном случае для Nvidia важно было количество (некоммутированных) линий PCIe из CPU, больше ничего. Одного AMD EPYC с его 128 линиями достаточно для подавляющего большинства GPU-вычислителей, двум CPU там нет работы. Логично, что односокетные серверы на AMD рулят в серверах хранения на NVMe и графических серверах.