|

СПЕЦІАЛЬНІ ПАРТНЕРИ ПРОЕКТУ BEST CIOОпределение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях Человек годаКто внес наибольший вклад в развитие украинского ИТ-рынка. Продукт годаНаграды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары |

HPE Discover Barcelona 2025: «новий стек» навколо AI - від мережі до даних

Автор – Юрій Kондратенко, 10 января

Форум HPE Discover у Барселоні став особливим для компанії - він припав на десяту річницю роботи Hewlett Packard Enterprise як самостійної структури. Проте головний акцент на конференції був зроблений не на минулому та підсумках, а на радикальній трансформації майбутнього. Ключовий меседж: АІ не злетить без фундаментальної перебудови мереж та хмарної інфраструктури. Саме місто, де проходив захід, Барселона, є своєрідною метафорою змін і реформування інфраструктури. З одного боку - місто, яке століттями добудовувало себе шар за шаром, з іншого - Ешампле (Eixample), спроєктований «із запасом» під зростання. Президент і CEO HPE Антоніо Нері (Antonio Neri) у ключовому виступі буквально підхопив цю паралель: коли складність стає нормою, «додавати ще один провулок» вже не рятує - потрібні інші підходи.

У XIX столітті, коли Барселона потерпала від зростання населення, лідери міста не просто прокладали нові вулиці - вони переосмислили всю планувальну структуру. Район Ешампле став сіткою широких проспектів, заокруглених кутів та відкритих бульварів - мережею, спроєктованою з думкою про майбутнє зростання та свободу руху, яку ніхто раніше не бачив. Це було місто, створене не для реакції на проблеми, а для передбачення майбутнього.

Саме так HPE і описує свою нинішню точку розвитку: інфраструктура підприємств перевантажена спадком, вартість віртуалізації зростає, вимоги до суверенності даних і безпеки стають жорсткішими, а AI додає до цього ще й вимогу до масштабу, латентності та енергетики. Тому конференція у Fira Barcelona Gran Via, що проходила на початку грудня, перетворилася на демонстрацію того, як HPE намагається «перекреслити план міста» у рамках ІТ-ландшафту, зводячи все до трьох опор: мережа, хмара, AI. Три хвилі AI: від генеративного до «фізичного» - і чому 95% пілотів не стають бізнесомПерша важлива теза, яку озвучив Антоніо Нері - AI зараз має три різні режими, кожен з яких створює унікальні вимоги до інфраструктури. Генеративний AI змінив спосіб створення контенту й роботи зі знаннями. «Агентний» (agentic) АІ - це перехід від інструмента до виконавця, що автоматизує процеси та ухвалює рішення в реальному часі. «Фізичний» AI виносить ці можливості у матеріальний світ машин і роботів. У цій логіці з'являється ключова теза: в agentic enterprise ІТ-підрозділ фактично керує цифровою робочою силою - тисячами спеціалізованих агентів, що працюють у всій організації. Це не просто зміна інструментів - це фундаментальна трансформація операційної моделі підприємства.

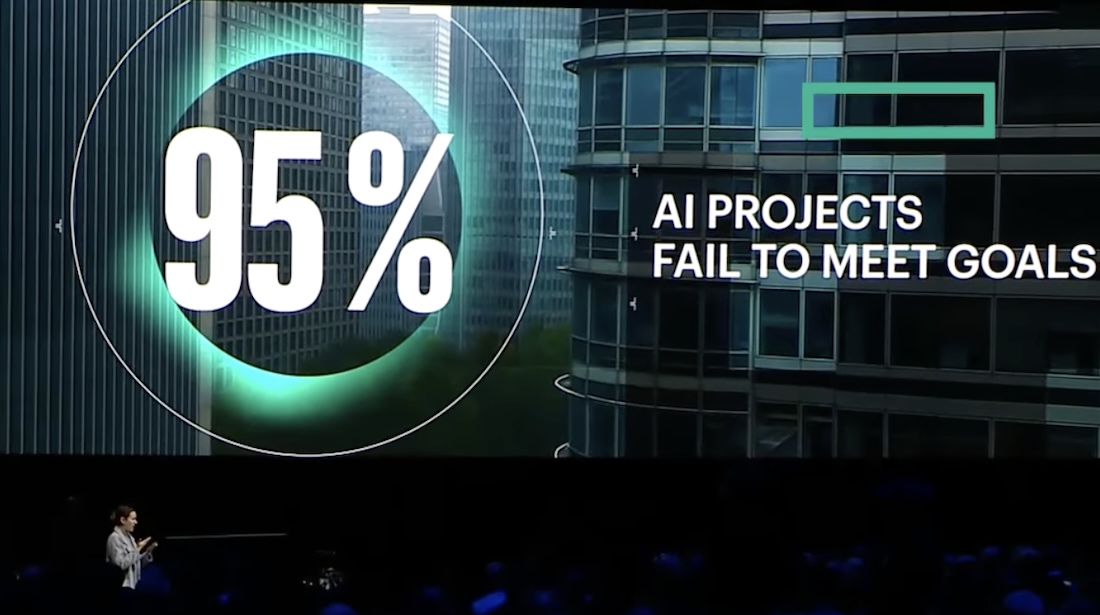

Але саме тут прозвучала й найбільш «твереза» статистика: за словами голови HPE, нещодавнє дослідження MIT Media Lab показує, що переважна більшість пілотних проєктів з AI не дає вимірюваного фінансового ефекту - у публічному обговоренні фігурує цифра близько 95% корпоративних AI-пілотів, які не змогли досягти очікуваних фінансових результатів та бізнес-впливу. Причин для цього багато. Значна частина сучасної інфраструктури складається з численних шарів успадкованого (legacy) IT, побудованих протягом десятиліть, що ускладнює управління та модернізацію. Водночас зростаючі вимоги до суверенності та безпеки даних змушують переосмислювати, як дані обробляються, як здійснюється доступ до них та як вони зберігаються. Витрати на хмару та віртуалізацію зростають, а багато організацій відмовляються від комерційних бізнес-моделей, які привʼязують до одного вендора. Компанії хочуть більше контролю та кращих опцій.

AI додав нові вимоги: він потребує продуктивності та масштабу, під які більшість середовищ не були спроєктовані, та робить питання сталого розвитку ІТ ще важливішим. Ці виклики взаємопов'язані - вирішення одного впливає на інші. І в міру зростання складності потреба у зниженні ризиків через більш безпечні, суверенні та масштабовані рішення стала критично важливою. Як підкреслив Антоніо Нері, теза про 95% вкрай важлива - і не як своєрідна лякалка, а як пояснення, чому HPE постійно повертається до базових речей: дані, інтеграція у процеси, операційна модель та контроль витрат. Мережа як фундамент: ставка на «self-driving network»Фактично Discover Barcelona 2025 стала першою великою європейською сценою HPE після закриття угоди з Juniper Networks у липні минулого року. Контекст угоди теж важливий: закриття відбулося після врегулювання з Мін'юстом США, який вимагав, зокрема, відокремлення певних активів і умов щодо доступу до Mist AI. На сцені це було подано максимально прагматично: обʼєднання HPE Aruba Networking та Juniper це спроба зібрати повний стек мережі та безпеки, де AI працює у двох напрямах одночасно. Мета була сформульована надзвичайно чітко: створити найкращий мережевий бізнес на планеті, щоб клієнти отримували найкращий можливий досвід операторів та кінцевих користувачів.

Рамі Рахім (Rami Rahim), теперішній президент та генеральний менеджер мережевого бізнесу HPE, який провів майже 30 років у мережевій індустрії, вийшов на сцену з чітким меседжем: в еру AI настав захоплюючий час для мережевих технологій. «Компанія об'єднує два неймовірні мережеві бізнеси, дивовижних людей та світового рівня технології найефективнішим способом для вирішення реальних проблем», зазначив він. Тепер повернемося до тези - AI працює у двох напрямах одночасно. Перший напрямок. AI for Networks - тобто AIOps, цифрові «двійники», віртуальні асистенти та автоматизація, що зменшує ручну роботу й кількість інцидентів. Рамі Рахім говорив про зниження trouble tickets і виїздів на місце «до 90%» у клієнтів, які вже використовують платформи Aruba Central або Juniper Mist. Клієнти також бачать суттєве зниження часу, який вони витрачають на практичні мережеві операції.

Кожне із згаданих рішень унікальне та привабливе по-різному, і вони доповнюють одне одного. Наприклад, Aruba Central чудово справляється з private cloud та on-premises розгортаннями, а також архітектурами віртуальних приватних хмар, тоді як Mist спеціально створювався для хмари. Разом вони можуть підтримувати будь-яку модель розгортання. При цьому Рахім наголошував на критично важливій тезі: ніхто не має залишитися «за бортом» - функції двох платформ переносяться одна в одну, а різниця між ними має поступово зникнути. Незалежно від варіанту розгортання, клієнти отримують потужну платформу управління, побудовану на масштабному AI та одному з найбільших data lakes в індустрії для створення мережевого інтелекту наступного покоління. Вже найближчим часом клієнти отримають доступ до об'єднаних можливостей: Marvis Actions та Large Experience Models з Mist, які забезпечують лідерство в індустрії у вирішенні інцидентів та прискоренні розгортання, переходять в Aruba Central. А AI-профілювання клієнтів та організаційна аналітика з Aruba Central, які приносять силу штучного інтелекту до рівня клієнта з функціональним інтерфейсом, переходять у Mist.

Революційним моментом став анонс першої двоплатформної Wi-Fi точки доступу, яка може працювати як з Mist, так і з Aruba Central. Клієнти отримують спокій та захист інвестицій, знаючи, що обладнання, яке вони обирають, однаково добре працюватиме з будь-якою платформою, зазначив Рамі Рахім. Це рішення стане доступним у третьому кварталі 2026 року, і відвідувачі Discover в Лас-Вегасі зможуть побачити його в дії разом з наступною хвилею інновацій. Другий напрямок. Networks for AI - мережі для AI-фабрик, де «звичайний датацентр» не витримує профілю навантаження: навчання моделей (training) потребує масивних east-west потоків, інференс (inference) - ультранизької латентності, а масштаб змушує думати про енергоефективність і охолодження як про елемент архітектури, а не «інженерку в підвалі». AI-навантаження фундаментально відрізняються: тренування моделей вимагає масивних East-West потоків трафіку, інференс потребує ультранизької латентності, і обидва сценарії вимагають безпрецедентного масштабу та надійності, а також вбудованої безпеки. Традиційні мережі просто не були спроєктовані для цього.

У цій частині презентації прозвучали конкретні маркери стратегії у залізі. Серед іншого анонс високопродуктивного Ethernet-комутатора QFX5250 на Broadcom Tomahawk 6 із рідинним охолодженням, а також компактнішого edge-маршрутизатора MX301 під сценарії винесення інференсу ближче до даних. Плюс до цього акцент на security-пласті через SRX4700 як «quantum-safe firewall». Паралельно HPE демонструє, що має намір бути не лише постачальником заліза, а й оператором мережі як сервісу, де Apstra в датацентрі з'єднується з OpsRamp в операційній площині, даючи не «сирі алерти», а причинно-наслідкову картину для AIOps. Окремо пролунала теза про «відкритість як зброю проти lock-in»: якщо Ethernet у масштабі AI-кластерів дійсно рухається до Ultra Ethernet, то HPE намагається показати себе як гравця, що підтримує стандарти й партнерства. Від NVIDIA (рішення для edge on-ramp і DCI) до AMD із Helios Rack Scale Architecture - це заявка на масштабований Ethernet у зоні, де історично домінували закриті підходи. Хмара: GreenLake як операційна модель, а не «ще один cloud»

Другий вектор виступу - гібридність як неминучість. Нері прямо називає AI «основним гібридним навантаженням» (ultimate hybrid workload): тренування, тюнінг, інференс, edge-сценарії та суверенні середовища не вкладаються у модель «або все в публічну хмару, або все on-prem». Звідси й логіка GreenLake: не будувати «ще одну хмару», а дати єдину cloud-операційну модель для всього периметра. Офіційно HPE позиціонує GreenLake як платформу, яка отримала визнання в першому Gartner Magic Quadrant for Infrastructure Platform Consumption Services (лідерство з найвищою здатністю до виконання та «найдальшим баченням»). Тут же HPE виводить на сцену ключовий для 2025 року продуктово-операційний меседж: GreenLake Intelligence - агентний AIOps-фреймворк, який трактує гібридне середовище як «одну безперервну систему» і пропонує набір спеціалізованих агентів для CloudOps/FinOps/NetOps/Compute/Storage з рекомендаціями або автоматичними діями під контролем ІТ. Це не «ще один чат-бот для адмінки», а спроба змінити модель експлуатації - від реагування до постійної оптимізації. З новою інтеграцією Compute Ops Manager HPE тепер може передавати телеметрію працездатності серверів, використання ресурсів фреймворку в реальному часі безпосередньо в агентну AI-платформу GreenLake. Це означає проактивну автоматизацію життєвого циклу, міждоменні інсайти та оптимізацію, що прискорює повернення інвестицій та допомагає знизити ризики - все в одному місці. «Великий VM-ресет»: Morpheus як відповідь на ціну віртуалізації

Одна з найпрактичніших частин доповіді - віртуалізація. Високі ліцензійні витрати, дедлайни, жорсткі runtime-моделі та загальне відчуття lock-in створили вікно можливостей для альтернатив. І тут HPE імплементує Morpheus у «наступне покоління Private Cloud»: VM Essentials (керування VMware і власним гіпервізором HVM), live-міграція, акцент на тарифікації «per-socket, а не per-core» і обіцянка скорочення VM-ліцензійних витрат «до 90%». Якщо перекласти це з маркетингової на інженерну мову, то HPE намагається закріпитися в ролі постачальника «операційної площини» для гібридної інфраструктури, де VM-платформа - лише один із runtime-шарів поруч із контейнерами, bare metal і публічними хмарами. Дані й зберігання: Alletra MP, «data intelligence nodes» і MCP як інтерфейс для агентів

Третя велика лінія центральної доповіді на конференції - дані як паливо для AI. Антоніо Нері наголосив на концепті, що зберігання має перестати бути «пасивним складом» і стати активним учасником пайплайнів. Звідси - Alletra MP і X10000, де звучить уже зовсім нова для класичного enterprise storage термінологія: класифікація й збагачення метаданими на льоту, tokenization/vectorization, нативна участь у agentic workflows через MCP. Паралельно оголошуються HPE Data Intelligence Nodes - GPU-системи «поруч» зі storage для препроцесингу/feature extraction/metadata enrichment, а також інтегрована HPE + NVIDIA AI data platform із акцентом на «GPU-speed data movement» та RDMA-шлях для S3-сумісного об'єктного доступу. Усе це подається як спосіб зняти типову проблему AI-проєктів: GPU дорогі, а простоюють через вузьке місце в даних. Суверенність як європейський сюжет

Для європейської аудиторії найважливіший «надсюжет» звучав окремо: суверенні архітектури та air-gapped сценарії. У кейноуті наводиться теза, що значна частка європейських організацій уже використовує або планує суверенні підходи, а HPE фіксує прискорення попиту на sovereign AI. Практичне продовження цього - анонс HPE & NVIDIA AI Factory Lab у Греноблі (Франція), де клієнти можуть тестувати й «доводити до промислового стану» AI-навантаження у суверенному середовищі в межах ЄС. Це не просто шоу-рум: задум у тому, щоб скоротити шлях від пілота до production, але без компромісу по резидентності даних і комплаєнсу.

Післямова: що насправді показала БарселонаЯкщо резюмувати почуте на конференції, то HPE намагається відповісти на дуже конкретний запит ринку: AI потрібен, але підприємства не хочуть платити за нього хаосом - ні фінансовим (віртуалізація/хмара), ні організаційним (розірвані домени), ні регуляторним (суверенність), ні технічним (мережа/дані/охолодження). Зазначимо, Discover Barcelona 2025 зафіксувала просту, але важливу тезу: у світі, де до 95% AI-пілотів так і не конвертуються у відчутний бізнес-ефект, перемагає той, хто приносить не черговий інструмент, а цілісну архітектуру - і, що важливіше, операційну модель, у якій AI не нашаровує нову складність, а системно зменшує її зсередини. Саме тому HPE формулює для 2026 року амбітну мету: поєднати Aruba Central і Mist, Morpheus і GreenLake Intelligence, інтелект сховищ та AI-пайплайни в єдину, передбачувану для використання екосистему - таку, що однаково масштабовано працюватиме і для великих підприємств, і для середніх компаній у самих різних галузях та індустріях.

Стратегія охолодження ЦОД для епохи AI

Читайте также

|

Останні обговоренняТОП-новости

ТОП-блогиТОП-статьи |

||||||||||