| 0 |

|

MLCommons, некомерційна організація, що займається вимірюванням продуктивності штучного інтелекту, оголосила результати бенчмарків MLPerf 4.0 для висновків AI та інших робочих навантажень. Бенчмарки MLPerf показують, наскільки добре графічні та центральні процесори справляються з різними завданнями, зокрема із завданнями виведення і навчання. У бенчмарку MLPerf 4.0 взяли участь понад 20 чіпмейкерів, серед яких вирізняються Nvidia і Intel.

Попередній раз MLCommons публікував результати MLPerf 3.1 у вересні 2023 року, і відтоді на ринку з'явилося багато нового обладнання, а чіпмейкери долучилися до перегонів з оптимізації та поліпшення своїх чипів для прискорення AI. Тому не дивно, що результати MLPerf 4.0 демонструють помітні поліпшення у більшості учасників.

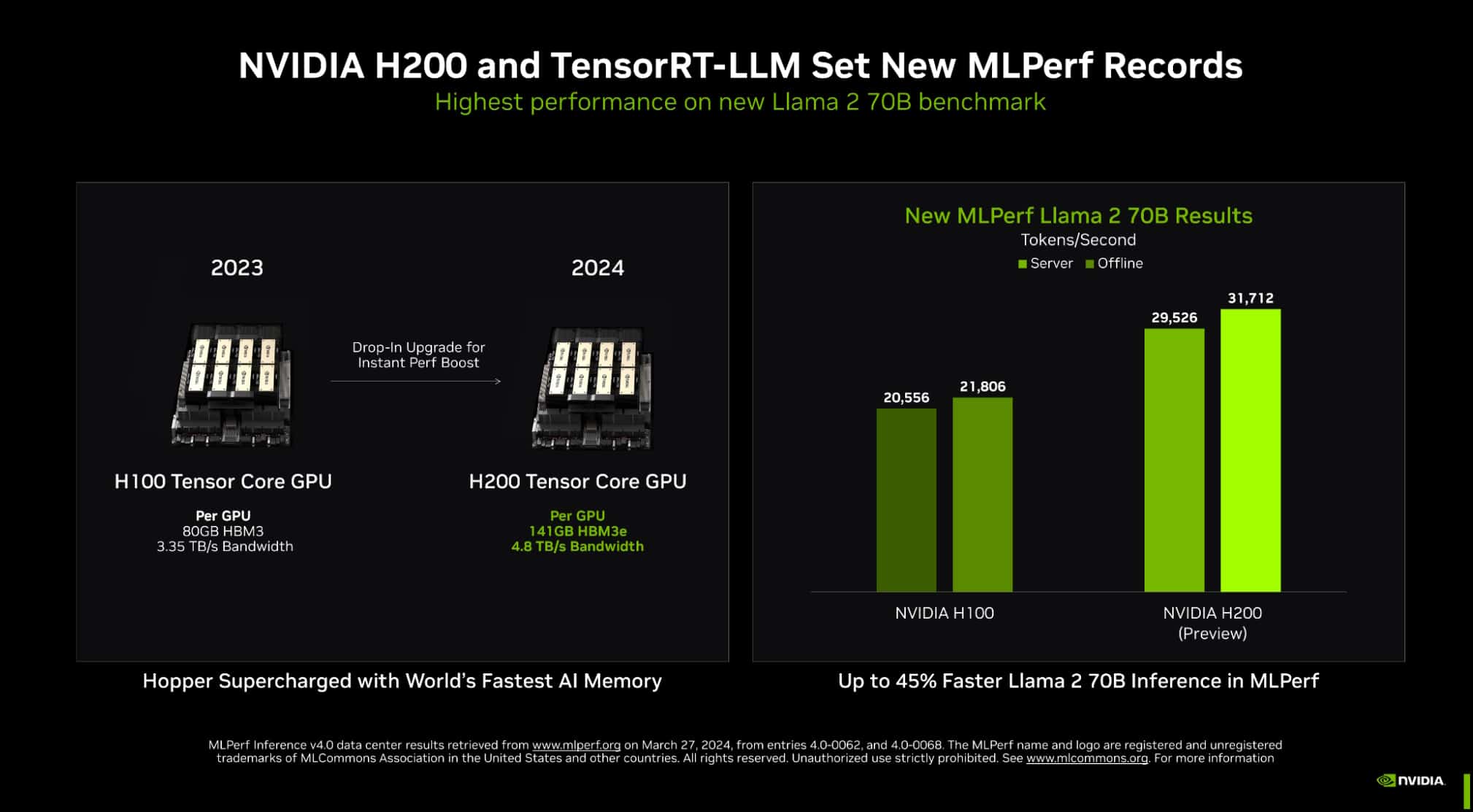

Примітно, що для останнього раунду тестів було оновлено бенчмарк MLPerf inference. Якщо в бенчмарку MLPerf 3.1 для узагальнення тексту використовували параметричну модель GPT-J 6B, то в новому бенчмарку як стандарт використовують модель Llama 2 70B від Meta Platforms із відкритим вихідним кодом. Крім того, MLPerf 4.0 включає перший в історії бенчмарк для генерації зображень за допомогою AI, що використовує модель Stable Diffusion від Stability AI.

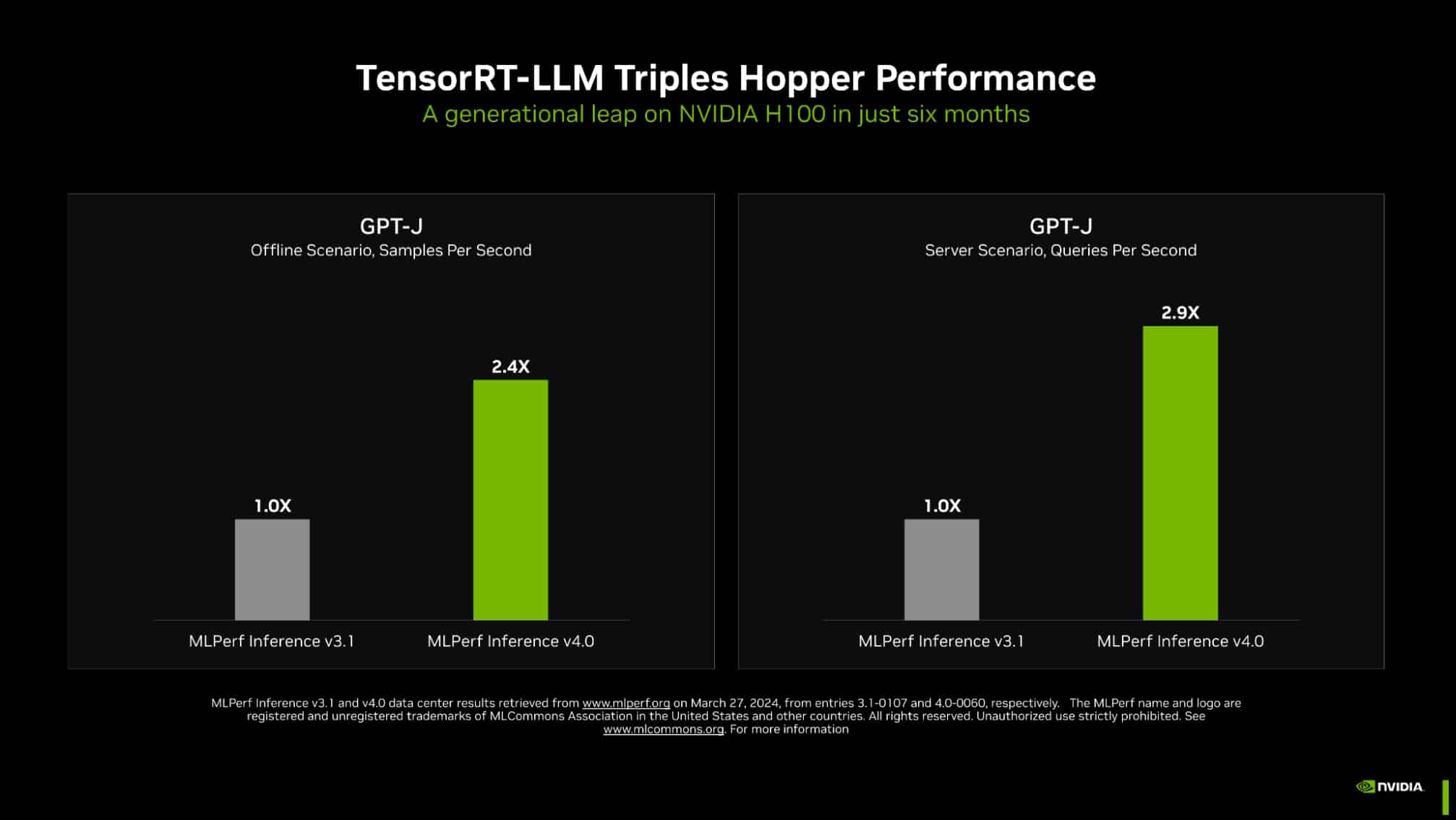

Nvidia — чіпмейкер, що домінує в індустрії AI, і на це є вагомі причини, як показують останні бенчмарки. Компанія показала дивовижні результати, продемонструвавши поліпшення не тільки в новітньому обладнанні, а й у деяких наявних прискорювачах AI. Наприклад, використовуючи свою технологію виводів TensorRT-LLM з відкритим вихідним кодом, компанія змогла потроїти продуктивність свого графічного процесора H100 Hopper у бенчмарках при узагальненні тексту.

Директор Nvidia з прискорених обчислень Дейв Сальватор підкреслив, що компанії вдалося потроїти продуктивність GPU H100 всього за шість місяців. "Ми дуже, дуже задоволені цим результатом", - сказав він. "Наша команда інженерів продовжує відмінно працювати, щоб знайти способи отримати більше продуктивності з архітектури Hopper".

Nvidia ще не проводила бенчмарки свого найпередовішого чіпа - GPU Blackwell, який був анонсований на заході GTC 2024, але цей процесор майже напевно перевершить чіп H100. Сальватор не зміг сказати, коли Nvidia планує провести бенчмаркінг продуктивності Blackwell, але висловив надію, що це станеться в найближчому майбутньому.

Nvidia продемонструвала результати роботи свого нового графічного процесора H200, який є другим поколінням GPU на базі архітектури Grace Hopper, і він показав значний приріст порівняно з H100. Наприклад, він виявився на 45% швидшим при тестуванні обчислень на Llama 2.

Компанія Intel більше відома своїми центральними процесорами, ніж графічними чіпами, і це означає, що вона залишилася позаду в індустрії AI, яка надає таке велике значення останнім. Проте, Intel конкурує у сфері GPU зі своїм чипом прискорювача Gaudi 2 AI, і компанія підкреслює, що наразі це єдина альтернатива GPU Nvidia, яка пройшла бенчмаркінг.

Чіпмейкер взяв участь у MLPerf 4.0 з Gaudi, а також зі своїми процесорами Xeon, і обидва показали дивовижний приріст порівняно з попереднім набором бенчмарків. Хоча загальна продуктивність Gaudi все ще не дотягує до H100 від Nvidia, Intel заявила, що результати його роботи дійсно кращі, ніж у конкурента за співвідношенням ціна/продуктивність.

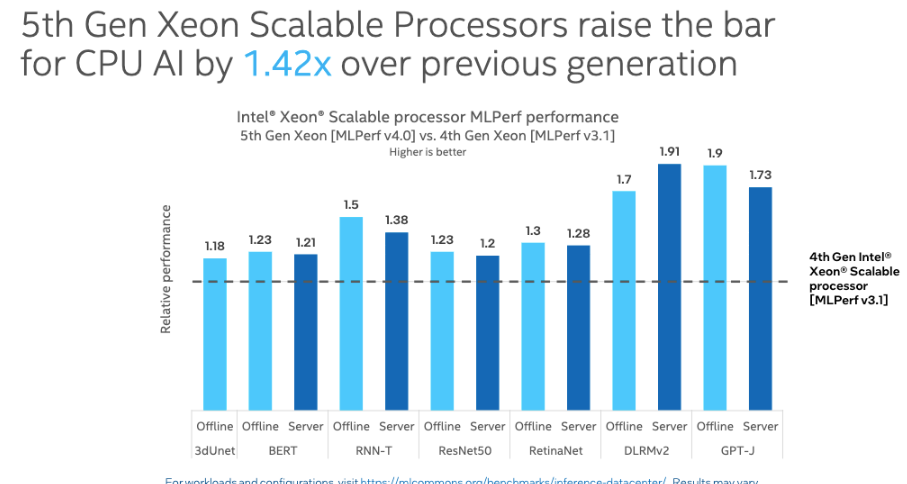

Крім того, процесор Intel Xeon 5-го покоління продемонстрував значне поліпшення продуктивності, опинившись у 1,4 раза швидшим за старіший процесор Intel Xeon 4-го покоління в тесті на умовиводи на Llama 2. У тесті на узагальнення тексту GPT-J LLM новітній чип Xeon виявився в 1,9 раза швидшим за свого попередника.

Результати важливі, оскільки, хоча найпотужніші моделі AI навчаються на GPU і використовують ці чіпи для висновків, багато дрібніших моделей замість цього працюють на CPU, які набагато дешевші та простіші в придбанні.

Ронак Шах (Ronak Shah), директор Intel з продукції Xeon для AI, каже, що компанія усвідомлює, що багато підприємств розгортають додатки AI в "змішаних середовищах загального призначення та AI". Унаслідок цього компанія зосередила свої зусилля на "розробці процесорів, які поєднуються між собою, із сильними можливостями загального призначення і рушієм AMX".

Останні бенчмарки MLPerf містять понад 8500 результатів, тестуючи практично всі можливі комбінації апаратних і програмних додатків AI. За словами засновника і виконавчого директора MLCommons Девіда Кантера, мета полягає не тільки в тому, щоб показати, який тип чіпа кращий у тому чи іншому сценарії, а й у тому, щоб встановити метрики продуктивності, на які виробники чіпів зможуть спиратися для поліпшення можливостей своїх продуктів. "Суть у тому, що щойно ми зможемо виміряти ці речі, ми зможемо почати їх покращувати", - сказав він на брифінгу.

Крім того, одна із заявлених цілей MLCommons - уніфікація чіпмейкерської індустрії, коли кожен еталон містить однакові набори даних і параметри конфігурації для різних чіпів і програмних додатків. Такий стандартизований підхід дасть змогу операторам центрів обробки даних ухвалювати обґрунтованіші рішення під час вибору найбільш відповідної архітектури AI для конкретного робочого навантаження.

Ready, set, buy! Посібник для початківців - як придбати Copilot для Microsoft 365

| 0 |

|