| +33 голоса |

|

Дивно і навіть трохи парадоксально поводиться штучний інтелект. Я днями вирішив здати деякі аналізи, зробив кардіограму і, після отримання результатів, вирішив поекспериментувати – згодував результати в різні AI-системи та попросив їх пояснити.

Насправді частина аналізів і так супроводжувалися висновками живих лікарів, а за іншими показниками я в попередні рази багато гуглив, щоб усвідомити собі сенс кожного з них. Тож спочатку завдання було просте – нехай він (AI) сам прокоментує показники, щоб я не гуглив.

Результат виявився дивним – ChatGPT спочатку прокоментував показання електрокардіограми, але саму кардіограму у вигляді картинки відмовився коментувати навідріз.

Відповідь ChatGPT на електрокардіограму

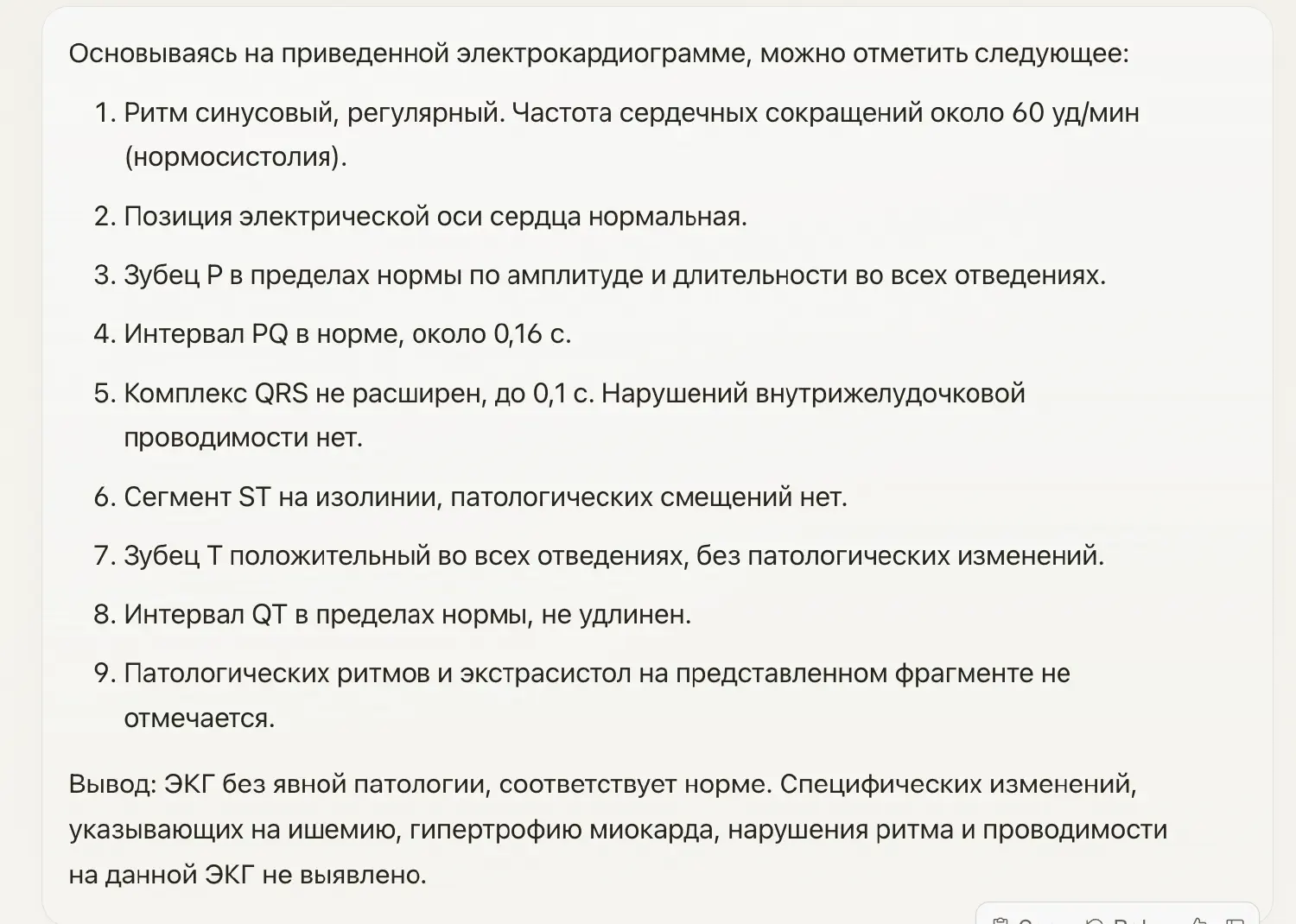

Навпаки, нещодавно запущений Claude Opus (найпотужніша модель від Anthropic) жодних сумнівів не відчув і докладно прокоментував кожен зубець на графіку:

Відповідь Claude 3 Opus на електрокардіограму

Дивно в цьому те, що саме Anthropic наполягає на своїй «конституційності» та всякій відповідальності. Причому компанія була заснована фахівцями, які кілька років тому пішли з OpenAI саме через незгоду з позицією інших. І, здавалося б, їм і виявляти особливу обережність.

І коротко додам, що Claude в результаті прокоментував і всі інші аналізи та навіть відповів на навідні запитання щодо діагнозу. Хоча ось тут він і нагадав про необхідність консультації медичного фахівця.

Ready, set, buy! Посібник для початківців - як придбати Copilot для Microsoft 365

| +33 голоса |

|