| +33 –≥–Њ–ї–Њ—Б–∞ |

|

–Э–∞ –і–љ—П—Е –њ—А–Є—И–ї–Њ —Б–Њ–Њ–±—Й–µ–љ–Є–µ, —З—В–Њ –§–∞–љ—М –•–Њ–є (Fan Hui), —В—А–µ—Е–Ї—А–∞—В–љ—Л–є —З–µ–Љ–њ–Є–Њ–љ –Х–≤—А–Њ–њ—Л –њ–Њ –Є–≥—А–µ –У–Њ, –њ—А–Њ–Є–≥—А–∞–ї –њ—А–Њ–≥—А–∞–Љ–Љ–µ AlphaGo –Њ—В DeepMind –≤ –њ—П—В–Є –Є–≥—А–∞—Е –њ–Њ–і—А—П–і (0-5 –≤–Њ –≤—Б–µ—Е –Є–≥—А–∞—Е —Б–µ—А–Є–Є). –Ф–µ–Љ–Є—Б –•–∞—Б—Б–∞–±–Є—Б –Є —Б–Њ—В–љ—П —Б–Њ—В—А—Г–і–љ–Є–Ї–Њ–≤ –µ–≥–Њ –њ–Њ–і—А–∞–Ј–і–µ–ї–µ–љ–Є—П –≤ Google —В–µ–њ–µ—А—М –±—А–Њ—Б–Є–ї–Є –≤—Л–Ј–Њ–≤ —З–µ–Љ–њ–Є–Њ–љ—Г –Љ–Є—А–∞, – –Є –Њ–љ –љ–µ –Њ—В–Ї–∞–Ј–∞–ї—Б—П. –Ь–∞—В—З –Є–Ј –њ—П—В–Є –Є–≥—А —Б–Њ—Б—В–Њ–Є—В—Б—П –≤ –°–µ—Г–ї–µ –≤ –Љ–∞—А—В–µ.

–У–∞—А—А–Є –Ъ–∞—Б–њ–∞—А–Њ–≤ –њ—А–Њ–Є–≥—А–∞–ї —И–∞—Е–Љ–∞—В–љ–Њ–Љ—Г –Ї–Њ–Љ–њ—М—О—В–µ—А—Г Deep Blue –≤ 1997 –≥. –Ґ–∞–Ї–Є–Љ –Њ–±—А–∞–Ј–Њ–Љ, —В–Њ–≥–і–∞ IBM —Г—Б—В–∞–љ–Њ–≤–Є–ї–∞ –≤–µ—Е—Г –≤ –Є—Б—В–Њ—А–Є–Є —А–∞–Ј–≤–Є—В–Є—П –Є—Б–Ї—Г—Б—Б—В–≤–µ–љ–љ–Њ–≥–Њ –Є–љ—В–µ–ї–ї–µ–Ї—В–∞. –Я–Њ—З—В–Є 20 –ї–µ—В —Б–њ—Г—Б—В—П, –≤ —П–љ–≤–∞—А–µ 2016 –≥., –≤ —Б—В–∞—В—М–µ –≤ –∞–≤—В–Њ—А–Є—В–µ—В–љ–Њ–Љ –Є–Ј–і–∞–љ–Є–Є Nature, –Ї–Њ–Љ–њ–∞–љ–Є—П Google —В–∞–Ї–ґ–µ –њ–Њ–ї—Г—З–Є–ї–∞ —Б–≤–Њ–µ –Љ–µ—Б—В–Њ –≤ –Є—Б—В–Њ—А–Є–Є, –Њ–±—К—П–≤–Є–≤, —З—В–Њ –Ї—Г–њ–ї–µ–љ–љ–∞—П –µ—О –љ–µ–±–Њ–ї—М—И–∞—П –±—А–Є—В–∞–љ—Б–Ї–∞—П –Ї–Њ–Љ–њ–∞–љ–Є—П DeepMind —А–µ–∞–ї–Є–Ј–Њ–≤–∞–ї–∞ —Б–Є—Б—В–µ–Љ—Г AlphaGo, –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ, —Б–њ–Њ—Б–Њ–±–љ—Г—О –њ–Њ–±–µ–і–Є—В—М —З–µ–Љ–њ–Є–Њ–љ–∞ –Љ–Є—А–∞ –њ–Њ –≤–Њ—Б—В–Њ—З–љ–Њ–∞–Ј–Є–∞—В—Б–Ї–Њ–є –љ–∞—Б—В–Њ–ї—М–љ–Њ–є –Є–≥—А–µ –У–Њ.

–Ь–љ–Њ–≥–Є–µ –ї—О–±–Є—В–µ–ї–Є –Є —Г –љ–∞—Б –≤ —Б—В—А–∞–љ–µ –Ј–љ–∞—О—В –µ–µ –њ—А–∞–≤–Є–ї–∞. –Э–∞ –њ–Њ–ї–µ —А–∞–Ј–Љ–µ—А–Њ–Љ 19—Е19 —Б–Њ–њ–µ—А–љ–Є–Ї–Є –њ–Њ–њ–µ—А–µ–Љ–µ–љ–љ–Њ –≤—Л–Ї–ї–∞–і—Л–≤–∞—О—В —Д–Є—И–Ї–Є, —Б—В–∞—А–∞—П—Б—М –Њ–Ї—А—Г–ґ–Є—В—М –Є —Г–і–∞–ї–Є—В—М —Д–Є—И–Ї–Є —Б–≤–Њ–µ–≥–Њ —Б–Њ–њ–µ—А–љ–Є–Ї–∞. –Ф–ї—П –Ї–Њ–Љ–њ—М—О—В–µ—А–∞ —Н—В–Њ –љ–∞–Љ–љ–Њ–≥–Њ –±–Њ–ї–µ–µ —Б–ї–Њ–ґ–љ–∞—П –Є–≥—А–∞, —З–µ–Љ —И–∞—Е–Љ–∞—В—Л

–Ф-—А –Ґ–∞–љ–≥—Г–є –І–Њ–≤–∞—А–і (Tanguy Chouard), –≥–ї–∞–≤–љ—Л–є —А–µ–і–∞–Ї—В–Њ—А Nature, –Ї–Њ—В–Њ—А—Л–є –љ–∞–±–ї—О–і–∞–ї –љ–µ–Ї–Њ—В–Њ—А—Л–µ –Є–≥—А—Л –Љ–∞—В—З–∞, –Њ–њ–Є—Б–∞–ї –њ–Њ–±–µ–і—Г –Ї–∞–Ї «–і–µ–є—Б—В–≤–Є—В–µ–ї—М–љ–Њ –Ї—А—Г—В—Г—О –і–ї—П —Б—В–Њ—А–Њ–љ–љ–µ–≥–Њ –љ–∞–±–ї—О–і–∞—В–µ–ї—П». «–≠—В–Њ –±—Л–ї –Њ–і–Є–љ –Є–Ј —Б–∞–Љ—Л—Е –Ј–∞—Е–≤–∞—В—Л–≤–∞—О—Й–Є—Е –Љ–Њ–Љ–µ–љ—В–Њ–≤ –Ј–∞ –≤—Б–µ –≤—А–µ–Љ—П, —З—В–Њ —П —А–∞–±–Њ—В–∞—О –≤ Nature», – —Б–Ї–∞–Ј–∞–ї –Њ–љ.

–≠—В–Њ – –њ–µ—А–≤–∞—П —В–∞–Ї–∞—П –њ–Њ–±–µ–і–∞ –і–ї—П –Ї–Њ–Љ–њ—М—О—В–µ—А–љ–Њ–є –њ—А–Њ–≥—А–∞–Љ–Љ—Л, –њ—А–Є—З–µ–Љ –Њ–љ–∞ –њ—А–Њ–Є–Ј–Њ—И–ї–∞ –љ–∞ –і–µ—Б—П—В—М –ї–µ—В —А–∞–љ—М—И–µ, —З–µ–Љ –Њ–ґ–Є–і–∞–ї–Њ—Б—М. –Ґ–Њ–ї—М–Ї–Њ-—В–Њ–ї—М–Ї–Њ, –≤ 2014 –≥. –†–µ–Љ–Є –Ъ—Г–ї–Њ–Љ (Rémi Coulom), —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї –њ—А–µ–і—Л–і—Г—Й–µ–є –њ—А–Њ–≥—А–∞–Љ–Љ—Л –і–ї—П –Є–≥—А—Л –≤ –У–Њ, Crazy Stone, –њ—А–µ–і—Б–Ї–∞–Ј–∞–ї, —З—В–Њ –њ–Њ—В—А–µ–±—Г–µ—В—Б—П –µ—Й–µ –љ–µ –Љ–µ–љ–µ–µ 10 –ї–µ—В –і–ї—П –Љ–∞—И–Є–љ—Л, —З—В–Њ–±—Л –≤—Л–Є–≥—А–∞—В—М —Г –њ—А–Њ—Д–µ—Б—Б–Є–Њ–љ–∞–ї—М–љ–Њ–≥–Њ –Є–≥—А–Њ–Ї–∞ –≤ –У–Њ, –Є–Љ–µ—О—Й–µ–≥–Њ —Б–∞–Љ—Л–є –≤—Л—Б–Њ–Ї–Є–є —А–µ–є—В–Є–љ–≥ –≤ –Љ–Є—А–µ. –Ґ–µ–њ–µ—А—М –њ—А–Њ–≥—А–∞–Љ–Љ–∞ AlphaGo –њ—А–µ–≤–Ј–Њ—И–ї–∞ –≤—Б–µ –Њ–ґ–Є–і–∞–љ–Є—П, —А–µ—И–∞—П –њ—А–Њ–±–ї–µ–Љ—Г —Б–Њ–≤–µ—А—И–µ–љ–љ–Њ –і—А—Г–≥–Є–Љ —Б–њ–Њ—Б–Њ–±–Њ–Љ, —З–µ–Љ –њ—А–µ–ґ–љ–µ–µ –Я–Ю.

–Т —Б–≤–Њ–Є—Е —А–∞–љ–љ–Є—Е AI-–њ–Њ–і–≤–Є–≥–∞—Е DeepMind –љ–∞—Г—З–Є–ї–∞ —Б–≤–Њ—О –њ—А–Њ–≥—А–∞–Љ–Љ—Г —Б–∞–Љ–Њ—Б—В–Њ—П—В–µ–ї—М–љ–Њ –Є–≥—А–∞—В—М –≤ –Ї–ї–∞—Б—Б–Є—З–µ—Б–Ї–Є–µ —Б—В–∞—А—Л–µ –≤–Є–і–µ–Њ–Є–≥—А—Л –љ–∞ Atari-80. –Ґ–µ–њ–µ—А—М AlphaGo –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В —В–Њ, —З—В–Њ –Ї–Њ–Љ–њ–∞–љ–Є—П –љ–∞–Ј—Л–≤–∞–µ—В «–≥–ї—Г–±–Њ–Ї–Њ–µ –Њ–±—Г—З–µ–љ–Є–µ», (Deep Learning), —З—В–Њ–±—Л –њ–Њ—Б—В—А–Њ–Є—В—М —Б–Њ–±—Б—В–≤–µ–љ–љ—Г—О –Љ–Њ–і–µ–ї—М –Є –њ–Њ–љ–Є–Љ–∞–љ–Є–µ –Є–≥—А—Л.

–Я—А–Є –Њ–±—Г—З–µ–љ–Є–Є –Ї–Њ–Љ–њ—М—О—В–µ—А–∞ –Є–≥—А–∞—В—М –≤ —В—Г –Є–ї–Є –Є–љ—Г—О –Є–≥—А—Г —Б–∞–Љ—Л–є –њ—А–Њ—Б—В–Њ–є –Љ–µ—В–Њ–і –Ј–∞–Ї–ї—О—З–∞–µ—В—Б—П –≤ —В–Њ–Љ, —З—В–Њ–±—Л –љ–∞—Г—З–Є—В—М –µ–µ –Њ—Ж–µ–љ–Є–≤–∞—В—М –Ї–∞–ґ–і—Л–є –≤–Њ–Ј–Љ–Њ–ґ–љ—Л–є —Е–Њ–і, –Њ—В –ї—Г—З—И–µ–≥–Њ –і–Њ —Е—Г–і—И–µ–≥–Њ, –Є –Ј–∞—В–µ–Љ –≤—Б–µ–≥–і–∞ –≤—Л–±–Є—А–∞—В—М –ї—Г—З—И–Є–є.

–Ґ–∞–Ї–∞—П —Б—В—А–∞—В–µ–≥–Є—П –і–∞–≤–љ–Њ —А–∞–±–Њ—В–∞–µ—В –≤ —В—А–Є–≤–Є–∞–ї—М–љ—Л—Е –Є–≥—А–∞—Е —В–Є–њ–∞ –Ї—А–µ—Б—В–Є–Ї–Њ–≤-–љ–Њ–ї–Є–Ї–Њ–≤, –Ї–Њ—В–Њ—А—Л–µ –і–∞–≤–љ–Њ –Є —Г—Б–њ–µ—И–љ–Њ —А–µ—И–µ–љ—Л –Ї–Њ–Љ–њ—М—О—В–µ—А–∞–Љ–Є. –Ю–љ–Є –њ–Њ–ї–љ–Њ—Б—В—М—О –њ–µ—А–µ–±–Є—А–∞—О—В –≤—Б–µ –≤–∞—А–Є–∞–љ—В—Л –Є –≤—Л–±–Є—А–∞—О—В —В–∞–Ї–Њ–є, –Ї–Њ—В–Њ—А—Л–є –≤–µ–і–µ—В, –њ–Њ –Ї—А–∞–є–љ–µ–є –Љ–µ—А–µ, –Ї –љ–Є—З—М–µ–є.

–Ю–і–љ–∞–Ї–Њ –≤ —Б–ї–Њ–ґ–љ—Л—Е –Є–≥—А–∞—Е —Г—А–Њ–≤–љ—П —И–∞—Е–Љ–∞—В, —В–∞–Ї–Њ–є «–і—Г–±–Њ–≤—Л–є» –њ–Њ–і—Е–Њ–і —В–µ—А–њ–Є—В –љ–µ—Г–і–∞—З—Г. –®–∞—Е–Љ–∞—В—Л —Б–ї–Є—И–Ї–Њ–Љ –≤–∞—А–Є–∞—В–Є–≤–љ—Л – –≤—Б–µ–≥–і–∞ –µ—Б—В—М –Њ–Ї–Њ–ї–Њ 35 –≤–∞—А–Є–∞–љ—В–Њ–≤ —Е–Њ–і–Њ–≤, –∞ –Є–≥—А–∞ –Љ–Њ–ґ–µ—В –і–ї–Є—В—М—Б—П –і–Њ 70-80 —Е–Њ–і–Њ–≤. –С—Л—Б—В—А—Л–є –Њ–±—Б—З–µ—В –Ї–∞–ґ–і–Њ–≥–Њ –њ–Њ–ї–Њ–ґ–µ–љ–Є—П —Б—В–∞–љ–Њ–≤–Є—В—Б—П –Ј–∞—В—А—Г–і–љ–Є—В–µ–ї—М–љ—Л–Љ –Є–ї–Є —В—А–µ–±—Г–µ—В –±–Њ–ї—М—И–Њ–є –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ–Њ–є –Љ–Њ—Й–љ–Њ—Б—В–Є, –њ–Њ—З–µ–Љ—Г –Є –њ–Њ—В—А–µ–±–Њ–≤–∞–ї–Њ—Б—М —Б—В–Њ–ї—М–Ї–Њ –ї–µ—В –і–ї—П –Ї–Њ–Љ–∞–љ–і—Л IBM, —З—В–Њ–±—Л –љ–∞–є—В–Є —Б–њ–Њ—Б–Њ–± –њ–Њ–±–µ–і–Є—В—М –Ъ–∞—Б–њ–∞—А–Њ–≤–∞.

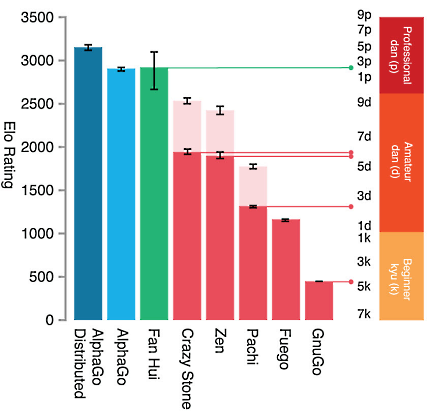

–Ф–Є–∞–≥—А–∞–Љ–Љ–∞ –Є–Ј —Б—В–∞—В—М–Є –≤ Nature. –Ъ–∞–Ї –≤–Є–і–љ–Њ, –≤ —Б–∞–Љ–Њ–Љ –Љ–Њ—Й–љ–Њ–Љ —Б–≤–Њ–µ–Љ –≤–∞—А–Є–∞–љ—В–µ —Б–µ–≥–Њ–і–љ—П AlphaGo –Є–≥—А–∞–µ—В –љ–∞ —Г—А–Њ–≤–љ–µ –њ—А–Њ—Д–µ—Б—Б–Є–Њ–љ–∞–ї–∞ –њ—П—В–Њ–≥–Њ –і–∞–љ–∞, –Њ–њ–µ—А–µ–ґ–∞—П –њ–Њ–±–µ–ґ–і–µ–љ–љ–Њ–≥–Њ Fan Hui (—В—А–µ—В–Є–є –і–∞–љ) –Є –і–∞–ї–µ–Ї–Њ —Г–є–і—П –≤–њ–µ—А–µ–і –Њ—В –і—А—Г–≥–Є—Е –∞–љ–∞–ї–Њ–≥–Є—З–љ—Л—Е –њ—А–Њ–≥—А–∞–Љ–Љ (–ї—О–±–Є—В–µ–ї—М—Б–Ї–Є–є —Г—А–Њ–≤–µ–љ—М). –С–ї–µ–і–љ–Њ-—А–Њ–Ј–Њ–≤—Л–Љ —Ж–≤–µ—В–Њ–Љ –њ–Њ–Ї–∞–Ј–∞–љ –њ—А–Њ–≥—А–µ—Б—Б —В–∞–Ї–Є—Е –њ—А–Њ–≥—А–∞–Љ–Љ –Ј–∞ –њ–Њ—Б–ї–µ–і–љ–Є–µ —З–µ—В—Л—А–µ –≥–Њ–і–∞

–У–Њ –µ—Й–µ —Б–ї–Њ–ґ–љ–µ–µ –≤ –≤—Л—З–Є—Б–ї–Є—В–µ–ї—М–љ–Њ–Љ –Њ—В–љ–Њ—И–µ–љ–Є–Є. –Я—А–∞–≤–Є–ї –≤ –У–Њ –≤—Б–µ–≥–Њ –і–≤–∞. –Ю–љ–Є –ї–µ–≥–Ї–Є –і–ї—П –љ–Њ–≤–Є—З–Ї–∞ –Є –Њ—З–µ–љ—М —Б–ї–Њ–ґ–љ—Л –і–ї—П –Љ–∞—Б—В–µ—А–∞. –§–Є—И–Ї–Є –і–Њ–ї–ґ–љ—Л –≤—Л–Ї–ї–∞–і—Л–≤–∞—В—М—Б—П –њ–Њ –Ї—А–∞–є–љ–µ–є –Љ–µ—А–µ —Б –Њ–і–љ–Є–Љ –њ—Г—Б—В—Л–Љ –Љ–µ—Б—В–Њ–Љ —А—П–і–Њ–Љ —Б –љ–Є–Љ –Є–ї–Є —Б —З–∞—Б—В—М—О –≥—А—Г–њ–њ—Л –Ї–∞–Љ–љ–µ–є —В–Њ–≥–Њ –ґ–µ —Ж–≤–µ—В–∞ –њ–Њ –Ї—А–∞–є–љ–µ–є –Љ–µ—А–µ —Б –Њ–і–љ–Є–Љ –њ—Г—Б—В—Л–Љ –Љ–µ—Б—В–Њ–Љ, –Є –µ—Б–ї–Є –Њ–љ–Є —В–µ—А—П—О—В —Б–≤–Њ—О «—Б–≤–Њ–±–Њ–і—Г» (–Ј–∞–Ї—А—Л–≤–∞—О—В—Б—П —Б–Њ –≤—Б–µ—Е —Б—В–Њ—А–Њ–љ), —В–Њ —Г–і–∞–ї—П—О—В—Б—П —Б –і–Њ—Б–Ї–Є.

–Т —В–Њ –≤—А–µ–Љ—П, –Ї–∞–Ї —Г —И–∞—Е–Љ–∞—В 35 –≤–∞—А–Є–∞–љ—В–Њ–≤ –Ї–∞–ґ–і–Њ–≥–Њ —Е–Њ–і–∞, –≤ –У–Њ –Є—Е –Њ–±—Л—З–љ–Њ –Њ–Ї–Њ–ї–Њ 250, –≤–Ї–ї—О—З–∞—П –Њ–і–љ—Г —В–Њ–ї—М–Ї–Њ 361 (19—Е19) —Б—В–∞—А—В–Њ–≤—Г—О –њ–Њ–Ј–Є—Ж–Є—О. –Х—Б–ї–Є –Є–≥—А–∞ –≤ —И–∞—Е–Љ–∞—В—Л –і–ї–Є—В—Б—П –њ—А–Є–±–ї–Є–Ј–Є—В–µ–ї—М–љ–Њ 50-80 —Е–Њ–і–Њ–≤, —В–Њ –Є–≥—А–∞ –≤ –У–Њ —В–Є–њ–Є—З–љ–Њ –њ—А–Њ–і–Њ–ї–ґ–∞–µ—В—Б—П –њ—А–Є–Љ–µ—А–љ–Њ –і–Њ 150 —Е–Њ–і–∞.

–Х—Б–ї–Є –±—Л Google DeepMind –њ–Њ–њ—Л—В–∞–ї–∞—Б—М –њ—А–Њ—Б—З–Є—В–∞—В—М –Є–≥—А—Г —В–∞–Ї–Є–Љ –ґ–µ –Њ–±—А–∞–Ј–Њ–Љ, –Ї–∞–Ї –Ї—А–µ—Б—В–Є–Ї–Є-–љ–Њ–ї–Є–Ї–Є, –µ–µ –њ—А–Њ–≥—А–∞–Љ–Љ–∞ –і–Њ–ї–ґ–љ–∞ –±—Л–ї–∞ –±—Л –Є—Б—Б–ї–µ–і–Њ–≤–∞—В—М –Є –Њ—Ж–µ–љ–Є—В—М –љ–µ–≤–µ—А–Њ—П—В–љ–Њ–µ –Ї–Њ–ї–Є—З–µ—Б—В–≤–Њ –≤–Њ–Ј–Љ–Њ–ґ–љ—Л—Е –њ–Њ–ї–Њ–ґ–µ–љ–Є–є – –њ—А–Є–Љ–µ—А–љ–Њ 10^169. Google —Б–Њ —Б–≤–Њ–Є–Љ –љ–∞–Ј–≤–∞–љ–Є–µ–Љ, –Ї–Њ—В–Њ—А–Њ–µ, –Ї–∞–Ї –Є–Ј–≤–µ—Б—В–љ–Њ, –Њ–±–Њ–Ј–љ–∞—З–∞–µ—В «–≥—Г–≥–Њ–ї», —В.–µ. 10^100, –њ—А–Њ—Б—В–Њ –Њ—В–і—Л—Е–∞–µ—В.

–≠—В–Њ –і–µ–ї–∞–µ—В –љ–µ–≤–Њ–Ј–Љ–Њ–ґ–љ—Л–Љ –њ–Њ–ї–љ—Л–є –њ–Њ–Є—Б–Ї, –Є –і–∞–ґ–µ —Б–µ–ї–µ–Ї—В–Є–≤–љ—Л–є –њ–Њ–Є—Б–Ї, –Ї–Њ—В–Њ—А—Л–є –±—Л–ї –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞–љ Deep Blue, —З—В–Њ–±—Л –њ–Њ–±–µ–і–Є—В—М –Ъ–∞—Б–њ–∞—А–Њ–≤–∞, – –Ї–Њ—В–Њ—А—Л–є, –≤ —Б–≤–Њ—О –Њ—З–µ—А–µ–і—М, –і–µ–ї–∞–ї —Н—Д—Д–µ–Ї—В–Є–≤–љ—Л–µ —Е–Њ–і—Л –Є–љ—В—Г–Є—В–Є–≤–љ–Њ, –њ–Њ–ї–∞–≥–∞—П—Б—М, —В–∞–Ї —Б–Ї–∞–Ј–∞—В—М, –љ–∞ —Б–Њ–±—Б—В–≤–µ–љ–љ—Г—О –љ–µ–є—А–Њ–љ–љ—Г—О —Б–µ—В—М.

–°–ї–Њ–ґ–љ–Њ—Б—В–Є –Ї –њ—А–Њ–±–ї–µ–Љ–µ –У–Њ –і–Њ–±–∞–≤–ї—П–µ—В –Є —В–Њ, —З—В–Њ, –≤ –Њ—В–ї–Є—З–Є–µ –Њ—В —И–∞—Е–Љ–∞—В, –Ј–і–µ—Б—М –Њ—З–µ–љ—М —В—А—Г–і–љ–Њ —Б–Љ–Њ—В—А–µ—В—М –љ–∞ –і–Њ—Б–Ї—Г –Є –њ—Л—В–∞—В—М—Б—П –Љ–∞—В–µ–Љ–∞—В–Є—З–µ—Б–Ї–Є –Њ–њ—А–µ–і–µ–ї–Є—В—М, –Ї—В–Њ –њ–Њ–±–µ–ґ–і–∞–µ—В –≤ –і–∞–љ–љ—Л–є –Љ–Њ–Љ–µ–љ—В.

–Т —И–∞—Е–Љ–∞—В–∞—Е –Є–≥—А–Њ–Ї, –Є–Љ–µ—О—Й–Є–є —Д–µ—А–Ј—П, –≤–µ—А–Њ—П—В–љ–Њ, –њ–Њ–±–µ–і–Є—В –Є–≥—А–Њ–Ї–∞, —Д–µ—А–Ј—М –Ї–Њ—В–Њ—А–Њ–≥–Њ –≤–Ј—П—В, – –Є —В–∞–Ї –і–∞–ї–µ–µ. –Ґ–Њ –µ—Б—В—М, –≤ –њ—А–Є–љ—Ж–Є–њ–µ, –≤–Њ–Ј–Љ–Њ–ґ–љ–Њ –љ–∞–Ј–љ–∞—З–Є—В—М –Њ–њ—А–µ–і–µ–ї–µ–љ–љ–Њ–µ —А–∞–љ–ґ–Є—А–Њ–≤–∞–љ–Є–µ, —А–µ–є—В–Є–љ–≥ —Ж–µ–љ–љ–Њ—Б—В–Є –і–ї—П –Ї–∞–ґ–і–Њ–є —Д–Є–≥—Г—А—Л –Є –≤—Л—А–∞–±–Њ—В–∞—В—М –њ—А–∞–≤–Є–ї–∞ —В–µ–Ї—Г—Й–µ–≥–Њ —Б—З–µ—В–∞, –Ї–Њ—В–Њ—А—Л–є –њ—А–Є–Љ–µ—А–љ–Њ –Њ—Ж–µ–љ–Є–≤–∞–µ—В –њ–µ—А—Б–њ–µ–Ї—В–Є–≤—Л –Ї–∞–ґ–і–Њ–≥–Њ –Є–≥—А–Њ–Ї–∞ –њ–Њ—Б–ї–µ –Ї–∞–ґ–і–Њ–≥–Њ —Е–Њ–і–∞.

–Т –Њ—В–ї–Є—З–Є–µ –Њ—В —И–∞—Е–Љ–∞—В, –≤ –У–Њ —Д–Є—И–Ї–Є —А–µ–і–Ї–Њ —Г–і–∞–ї—П—О—В—Б—П —Б –і–Њ—Б–Ї–Є –Є –љ–µ—В –љ–Є–Ї–∞–Ї–Њ–≥–Њ –њ—А–Њ—Б—В–Њ–≥–Њ –Љ–∞—В–µ–Љ–∞—В–Є—З–µ—Б–Ї–Њ–≥–Њ —Б–њ–Њ—Б–Њ–±–∞ –Њ–њ—А–µ–і–µ–ї–Є—В—М, –Ї—В–Њ –Є–Ј —Б–Њ–њ–µ—А–љ–Є–Ї–Њ–≤ –љ–∞—Е–Њ–і–Є—В—Б—П –≤ –±–Њ–ї–µ–µ —Б–Є–ї—М–љ–Њ–Љ –њ–Њ–ї–Њ–ґ–µ–љ–Є–Є, –њ–Њ–Ї–∞ –Є–≥—А–∞ –љ–µ –Ј–∞—И–ї–∞ —Б–ї–Є—И–Ї–Њ–Љ –і–∞–ї–µ–Ї–Њ. –Я–Њ—Н—В–Њ–Љ—Г —А–∞–Ј—А–∞–±–Њ—В—З–Є–Ї–Є AlphaGo —Б–Њ—Б—А–µ–і–Њ—В–Њ—З–Є–ї–Є—Б—М –љ–∞ —Б–Њ–≤–µ—А—И–µ–љ–љ–Њ –і—А—Г–≥–Њ–є —Б—В—А–∞—В–µ–≥–Є–Є.

–Ф—Н–≤–Є–і –°–Є–ї—М–≤–µ—А (David Silver), –≤–µ–і—Г—Й–Є–є —Б–Њ–Є—Б—Б–ї–µ–і–Њ–≤–∞—В–µ–ї—М –њ—А–Њ–µ–Ї—В–∞ DeepMind, –≥–Њ–≤–Њ—А–Є—В –њ–Њ —Н—В–Њ–Љ—Г –њ–Њ–≤–Њ–і—Г —Б–ї–µ–і—Г—О—Й–µ–µ: «AlphaGo —Б–Љ–Њ—В—А–Є—В –≤–њ–µ—А–µ–і, –Ј–∞–Ї–∞–љ—З–Є–≤–∞—П –Њ—Б—В–∞–≤—И—Г—О—Б—П —З–∞—Б—В—М –Є–≥—А—Л –≤ —Б–≤–Њ–µ–Љ –≤–Њ–Њ–±—А–∞–ґ–µ–љ–Є–Є –Љ–љ–Њ–≥–Њ —А–∞–Ј».

–Я—А–Њ–≥—А–∞–Љ–Љ–∞ –њ–∞—А–∞–ї–ї–µ–ї—М–љ–Њ –Є—Б–њ–Њ–ї—М–Ј—Г–µ—В –і–≤–µ –љ–µ–є—А–Њ–љ–љ—Л—Е —Б–µ—В–Є. –У–ї–∞–≤–љ–∞—П –Є–Ј –љ–Є—Е –њ–Њ–і—А–∞–ґ–∞–µ—В —Б—В—А—Г–Ї—В—Г—А–µ —З–µ–ї–Њ–≤–µ—З–µ—Б–Ї–Њ–≥–Њ –Љ–Њ–Ј–≥–∞, —З—В–Њ–±—Л —Б–Њ–µ–і–Є–љ–Є—В—М –Њ—З–µ–љ—М –њ—А–Њ—Б—В—Л–µ —В–µ–Ї—Г—Й–Є–µ –Њ–і–Є–љ–Њ—З–љ—Л–µ —А–µ—И–µ–љ–Є—П –≤ —Б–ї–Њ–ґ–љ—Л–є –≤—Л–±–Њ—А –Њ–±—Й–µ–є —Б—В—А–∞—В–µ–≥–Є–Є. –≠—В–∞, —Б—В—А–∞—В–µ–≥–Є—З–µ—Б–Ї–∞—П, —Б–µ—В—М –Њ–±—Г—З–∞–µ—В—Б—П –љ–∞ –њ—А–Є–Љ–µ—А–µ –Љ–Є–ї–ї–Є–Њ–љ–Њ–≤ –Ј–∞–њ–Є—Б–µ–є –Є–≥—А –У–Њ –њ–Њ –∞—А—Е–Є–≤—Г.

–Ш—Б–њ–Њ–ї—М–Ј—Г—П –љ–∞–±–ї—О–і–µ–љ–Є—П, –њ—А–Њ–≥—А–∞–Љ–Љ–∞ —Б–Њ–Ј–і–∞–µ—В –њ—А–Њ–≥–љ–Њ–Ј–љ—Г—О –Љ–Њ–і–µ–ї—М –Њ–ґ–Є–і–∞–µ–Љ–Њ–≥–Њ –±—Г–і—Г—Й–µ–≥–Њ. –Т —А–µ–Ј—Г–ї—М—В–∞—В–µ –Њ–љ–∞ –≤ —Б–Њ—Б—В–Њ—П–љ–Є–Є —В–Њ—З–љ–Њ –њ—А–µ–і–њ–Њ–ї–Њ–ґ–Є—В—М —Б–ї–µ–і—Г—О—Й–µ–µ –і–≤–Є–ґ–µ–љ–Є–µ –Њ–њ—Л—В–љ–Њ–≥–Њ —Б–Њ–њ–µ—А–љ–Є–Ї–∞ –њ—А–Є–Љ–µ—А–љ–Њ –≤ 57% —Б–ї—Г—З–∞–µ–≤ (–њ–Њ —Б—А–∞–≤–љ–µ–љ–Є—О —Б 44% –і–ї—П –њ—А–Њ—Д–µ—Б—Б–Є–Њ–љ–∞–ї—М–љ–Њ–≥–Њ –Є–≥—А–Њ–Ї–∞-—З–µ–ї–Њ–≤–µ–Ї–∞).

–Я–Њ—Б–ї–µ —Н—В–Њ–≥–Њ –љ–µ–є—А–Њ–љ–љ–∞—П —Б–µ—В—М –њ—Л—В–∞–µ—В—Б—П —Б—Л–≥—А–∞—В—М –њ—А–Њ—В–Є–≤ —Б–∞–Љ–Њ–µ —Б–µ–±—П, –Є–Ј–≤–ї–µ–Ї–∞—П —Г—А–Њ–Ї–Є –Є–Ј –≤–Њ–Ј–Љ–Њ–ґ–љ—Л—Е –њ–Њ–±–µ–і –Є –њ–Њ—В–µ—А—М –Є –Њ–±—Б—З–Є—В—Л–≤–∞—П –Љ–Є–ї–ї–Є–Њ–љ—Л –≤–∞—А–Є–∞–љ—В–Њ–≤. –Ч–∞—В–µ–Љ –≤—В–Њ—А–Њ–є —Д–Є–ї—М—В—А –њ–Њ–Љ–Њ–≥–∞–µ—В –≤—Л–±–Є—А–∞—В—М –ї—Г—З—И–Є–є —В–µ–Ї—Г—Й–Є–є —Е–Њ–і.

–†–∞–Ј—А–∞–±–Њ—В–Ї–∞ AlphaGo –±—Л–ї–∞ –≤–∞–ґ–љ–∞ –і–ї—П DeepMind –љ–µ –њ—А–Њ—Б—В–Њ –Ї–∞–Ї –±—А–Є–ї–ї–Є–∞–љ—В –≤ –µ–µ –Ї–Њ—А–Њ–љ–µ. –Ъ–Њ–Љ–њ–∞–љ–Є—П —Г—В–≤–µ—А–ґ–і–∞–µ—В, —З—В–Њ —Б–Њ–≤–µ—А—И–µ–љ—Б—В–≤–Њ–≤–∞–љ–Є–µ –њ—А–Њ–≥—А–∞–Љ–Љ—Л –Є –≥–ї—Г–±–Њ–Ї–Њ–µ –Є–Ј—Г—З–µ–љ–Є–µ –Є–≥—А–Њ–≤—Л—Е –Љ–µ—В–Њ–і–Њ–≤ –Ї—А–∞–є–љ–µ –≤–∞–ґ–љ—Л –і–ї—П –µ–µ –±—Г–і—Г—Й–µ–є —А–∞–±–Њ—В—Л. –Ф–µ–Љ–Є—Б –•–∞—Б—Б–∞–±–Є—Б —Б–Ї–∞–Ј–∞–ї, —З—В–Њ «–≤ –Ї–Њ–љ–µ—З–љ–Њ–Љ —Б—З–µ—В–µ, –Љ—Л —Е–Њ—В–Є–Љ –њ—А–Є–Љ–µ–љ–Є—В—М —Н—В–Є –Љ–µ—В–Њ–і—Л –≤ –≤–∞–ґ–љ—Л—Е —А–µ–∞–ї—М–љ—Л—Е –њ—А–Њ–±–ї–µ–Љ–∞—Е, – –Њ—В –Љ–µ–і–Є—Ж–Є–љ—Б–Ї–Њ–є –і–Є–∞–≥–љ–Њ—Б—В–Є–Ї–Є –і–Њ –Љ–Њ–і–µ–ї–Є—А–Њ–≤–∞–љ–Є—П –Ї–ї–Є–Љ–∞—В–∞». –Э–∞–њ—А–Є–Љ–µ—А, –Њ —В–Њ–Љ, –Ї–∞–Ї Google DeepMind —Г—З–Є—В—Б—П —З–Є—В–∞—В—М –Є –њ–Њ–љ–Є–Љ–∞—В—М –њ—А–Њ—З–Є—В–∞–љ–љ–Њ–µ, —Б–Љ–Њ—В—А–Є –≤ –Њ–±–Њ–Ј—А–µ–љ–Є–Є MIT.

–Ґ–µ–Љ –љ–µ –Љ–µ–љ–µ–µ, –≤ –і–∞–љ–љ—Л–є –Љ–Њ–Љ–µ–љ—В –Ї–Њ–Љ–∞–љ–і–∞ DeepMind —Б–Њ—Б—А–µ–і–Њ—В–Њ—З–µ–љ–∞ –љ–∞ –і–Њ—Б—В–Є–ґ–µ–љ–Є–Є –Ј–∞–Ї–ї—О—З–Є—В–µ–ї—М–љ–Њ–є —Ж–µ–ї–Є – –њ–Њ–±–µ–і–µ –≤ –Љ–∞—В—З–µ —Б —З–µ–Љ–њ–Є–Њ–љ–Њ–Љ –Љ–Є—А–∞ –њ–Њ –У–Њ –Ы–Є –°–Є-–і–Њ–ї–Њ–Љ (Lee Se-dol). –°–∞–Љ –Ы–Є –≥–Њ–≤–Њ—А–Є—В, —З—В–Њ «–љ–µ–Ј–∞–≤–Є—Б–Є–Љ–Њ –Њ—В —А–µ–Ј—Г–ї—М—В–∞—В–∞, —Н—В–Њ –±—Г–і–µ—В –Ј–љ–∞–Ї–Њ–≤–Њ–µ —Б–Њ–±—Л—В–Є–µ –≤ –Є—Б—В–Њ—А–Є–Є «baduk» (–Ї–Њ—А–µ–є—Б–Ї–Њ–µ –љ–∞–Ј–≤–∞–љ–Є–µ –У–Њ).

«–ѓ —Б–ї—Л—И–∞–ї, —З—В–Њ –Є—Б–Ї—Г—Б—Б—В–≤–µ–љ–љ—Л–є –Є–љ—В–µ–ї–ї–µ–Ї—В Google DeepMind —Г–і–Є–≤–Є—В–µ–ї—М–љ–Њ —Б–Є–ї–µ–љ –≤ –У–Њ, –Є —Б—В–∞–љ–Њ–≤–Є—В—Б—П –≤—Б–µ —Б–Є–ї—М–љ–µ–µ –і–µ–љ—М –Њ—В–Њ –і–љ—П. –Э–Њ —П —Г–≤–µ—А–µ–љ, —З—В–Њ —Б–Љ–Њ–≥—Г –њ–Њ–±–µ–і–Є—В—М, – –њ–Њ –Ї—А–∞–є–љ–µ–є –Љ–µ—А–µ, –љ–∞ —Б–µ–є —А–∞–Ј», – —Б–Ї–∞–Ј–∞–ї –Ы–Є.

–ѓ —Б—В–∞–≤–ї—О –љ–∞ AlphaGo

–Ґ–µ–њ–µ—А—М —Г–ґ–µ –њ—А–Є–≤—Л—З–љ–µ–µ –Є —Г–≤–µ—А–µ–љ–љ–µ–µ –Њ—В–≤–µ—З—Г –љ–∞ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ—Л–є –≤–Њ–њ—А–Њ—Б – «–І—В–Њ –±—Г–і–µ—В –і–∞–ї—М—И–µ?».

–Э—Г –≤–Њ—В… –Т–Љ–µ—Б—В–Њ –Љ—Г–і—А–Њ–є –љ–µ—В–Њ—А–Њ–њ–ї–Є–≤–Њ–є –Є–≥—А—Л –≤ –љ–∞—И –Љ–Є—А –Њ–њ—П—В—М –≤—А—Л–≤–∞–µ—В—Б—П –Ї–Њ–Љ–њ—М—О—В–µ—А… –Є –і–µ–ї–∞–µ—В –≤—Б–µ –љ–µ–љ—Г–ґ–љ—Л–Љ –Є –љ–µ–Є–љ—В–µ—А–µ—Б–љ—Л–Љ

–Я–Њ–љ—П—В–љ–Њ, —З—В–Њ –≤—Б–µ –∞–ї–≥–Њ—А–Є—В–Љ–Є—З–µ—Б–Ї–Є–µ –Є–≥—А—Л –Њ–±—А–µ—З–µ–љ—Л. –Т–Њ–њ—А–Њ—Б –Њ –≤–≤–µ–і–µ–љ–Є–Є –і—А–∞–Ї–Њ–љ–Њ–≤—Б–Ї–Њ–є —Б–Є—Б—В–µ–Љ—Л –љ–∞–±–ї—О–і–µ–љ–Є—П –Є –Њ—Е—А–∞–љ—Л –≤ –Ї–∞–Ј–Є–љ–Њ –Њ–±—Б—Г–ґ–і–∞—В—М –љ–µ –±—Г–і–µ–Љ. –Ю–±—А–∞—В–Є–Љ—Б—П –ї—Г—З—И–µ –Ї —Б–Є—В—Г–∞—Ж–Є–Њ–љ–љ—Л–Љ –љ–µ–Њ–њ—А–µ–і–µ–ї–µ–љ–љ—Л–Љ –Є–≥—А–∞–Љ, – –≤ –њ–µ—А–≤—Г—О –Њ—З–µ—А–µ–і—М –љ–µ–Ї–Њ–љ—В–∞–Ї—В–љ—Л–Љ —Б –Љ—П—З–Њ–Љ. –ѓ –љ–µ –≤–Є–ґ—Г –Њ—Б–Њ–±—Л—Е —В–µ—Е–љ–Є—З–µ—Б–Ї–Є—Е –њ—А–Њ–±–ї–µ–Љ, —З—В–Њ–±—Л —Б–і–µ–ї–∞—В—М, –љ–∞–њ—А–Є–Љ–µ—А, —А–Њ–±–Њ—В–∞ –і–ї—П –Є–≥—А—Л –≤ –±–Њ–ї—М—И–Њ–є —В–µ–љ–љ–Є—Б.

–Э—Г–ґ–љ–∞ –њ—А–Њ—Б—В–Њ –±–Њ–ї—М—И–∞—П –±—Л—Б—В—А–∞—П –і–≤—Г—Е–Ї–Њ–Њ—А–і–Є–љ–∞—В–љ–∞—П —Б–Є—Б—В–µ–Љ–∞ –њ–µ—А–µ–Љ–µ—Й–µ–љ–Є—П. –Ґ–∞–Ї–Є–µ —Г–ґ–µ –і–∞–≤–љ–Њ –Є—Б–њ–Њ–ї—М–Ј—Г—О—В—Б—П –≤ –≥—А–∞—Д–Њ–њ–Њ—Б—В—А–Њ–Є—В–µ–ї—П—Е, —Б–Є—Б—В–µ–Љ–∞—Е CAD –Є 3D-–њ—А–Є–љ—В–µ—А–∞—Е. –Ф–µ–ї–Њ —В–Њ–ї—М–Ї–Њ –≤ –Љ–∞—Б—И—В–∞–±–µ.

–Ф–Њ–±–∞–≤–Є–Љ —В–µ—Е–љ–Њ–ї–Њ–≥–Є–Є –Љ–∞—И–Є–љ–љ–Њ–≥–Њ –Ј—А–µ–љ–Є—П, —А–∞—Б–њ–Њ–Ј–љ–∞–≤–∞–љ–Є—П –Є —Б–∞–Љ–Њ–Њ–±—Г—З–µ–љ–Є—П. –Я–Њ–ї—Г—З–∞–µ–Љ –Љ–µ—Е–∞–љ–Є—З–µ—Б–Ї—Г—О —А—Г–Ї—Г —Б –≥–ї–∞–Ј–∞–Љ–Є –Є —А–∞–Ї–µ—В–Ї–Њ–є. –Ь–Њ–ґ–љ–Њ –њ–Њ—Д–∞–љ—В–∞–Ј–Є—А–Њ–≤–∞—В—М, –Ї–∞–Ї –Љ–∞—И–Є–љ–∞ –љ–∞–Љ–µ—А–µ–љ–љ–Њ –њ—А–Њ–Є–≥—А—Л–≤–∞–µ—В –њ–µ—А–≤—Л–є –≥–µ–є–Љ, –Є–Ј—Г—З–∞—П –њ–Њ–≤–∞–і–Ї–Є —Б–Њ–њ–µ—А–љ–Є–Ї–∞-—З–µ–ї–Њ–≤–µ–Ї–∞: —Б–Ї–Њ—А–Њ—Б—В—М –µ–≥–Њ –њ–µ—А–µ–Љ–µ—Й–µ–љ–Є—П, —Б—В—А–∞—В–µ–≥–Є—О —Г–і–∞—А–Њ–≤, –Є—Е —Б–Є–ї—Г –Є —В—А–∞–µ–Ї—В–Њ—А–Є—О –Є —В.–і. –Р –Ј–∞—В–µ–Љ —Г–≤–µ—А–µ–љ–љ–Њ –љ–∞—З–Є–љ–∞–µ—В –≥–Њ–љ—П—В—М –µ–≥–Њ –њ–Њ —Г–≥–ї–∞–Љ –Є –љ–∞–±–Є—А–∞—В—М –Њ—З–Ї–Є.

–Ф—Г–Љ–∞—О, –≤ —В–µ—З–µ–љ–Є–µ –±–ї–Є–ґ–∞–є—И–Є—Е –ї–µ—В –њ–Њ–і–Њ–±–љ—Л–є –Њ–±—А–∞–Ј–µ—Ж –њ–Њ—П–≤–Є—В—Б—П. –Х–≥–Њ –њ–Њ–љ–∞—З–∞–ї—Г –±—Г–і—Г—В —И–Є—А–Њ–Ї–Њ –Є—Б–њ–Њ–ї—М–Ј–Њ–≤–∞—В—М –і–ї—П —Б–њ–∞—А—А–Є–љ–≥–∞, –љ–Њ –≤ —Ж–µ–ї–Њ–Љ —В–µ–љ–љ–Є—Б, – –Ї–∞–Ї –Є —И–∞—Е–Љ–∞—В—Л, –Є –У–Њ, – —Г—В—А–∞—В–Є—В —Б–≤–Њ—О –Є—Б–Ї–ї—О—З–Є—В–µ–ї—М–љ–Њ—Б—В—М –Є –Њ–±–∞—П–љ–Є–µ.

–Ґ–Њ –ґ–µ –Ї–∞—Б–∞–µ—В—Б—П –љ–∞—Б—В–Њ–ї—М–љ–Њ–≥–Њ —В–µ–љ–љ–Є—Б–∞ (—Б–Ї–Њ—А–Њ—Б—В—М –≤—Л—И–µ, –љ–Њ –Љ–∞—Б—И—В–∞–±—Л –Љ–µ–љ—М—И–µ), —Б–љ—Г–Ї–µ—А–∞ –Є —В.–і., –Є —В.–њ. –Ґ–∞–Ї —З—В–Њ, –≤–Є–і–Є–Љ–Њ, —Г –ї—О–і–µ–є —Б–Ї–Њ—А–Њ –Њ—Б—В–∞–љ–µ—В—Б—П —В–Њ–ї—М–Ї–Њ —В—А–∞–і–Є—Ж–Є–Њ–љ–љ–∞—П –Є–≥—А–∞ «–Љ–∞—Е–љ–µ–Љ –љ–µ –≥–ї—П–і—П». –•–Њ—В—П, –Ї—В–Њ –Ј–љ–∞–µ—В?..

–•—А–Њ–љ–Є–Ї–Є –У–Њ-1. DeepMind

–°—В—А–∞—В–µ–≥—Ц—П –Њ—Е–Њ–ї–Њ–і–ґ–µ–љ–љ—П –¶–Ю–Ф –і–ї—П –µ–њ–Њ—Е–Є AI

| +33 –≥–Њ–ї–Њ—Б–∞ |

|