Як HBM та флешпам’ять «подружилися», щоб прискорити AI

17 февраль, 2026 - 17:26Тимур ЯгофаровВи колись замислювалися, чому сучасні AI-моделі іноді «гальмують» із відповіддю, хоча всередині сервера стоять топові GPU? Проблема не у швидкості обчислень, а в пам'яті. Точніше, у вічній дилемі: обрати надшвидку, але малу HBM, або величезну, але повільну флешпам’ять (SSD).

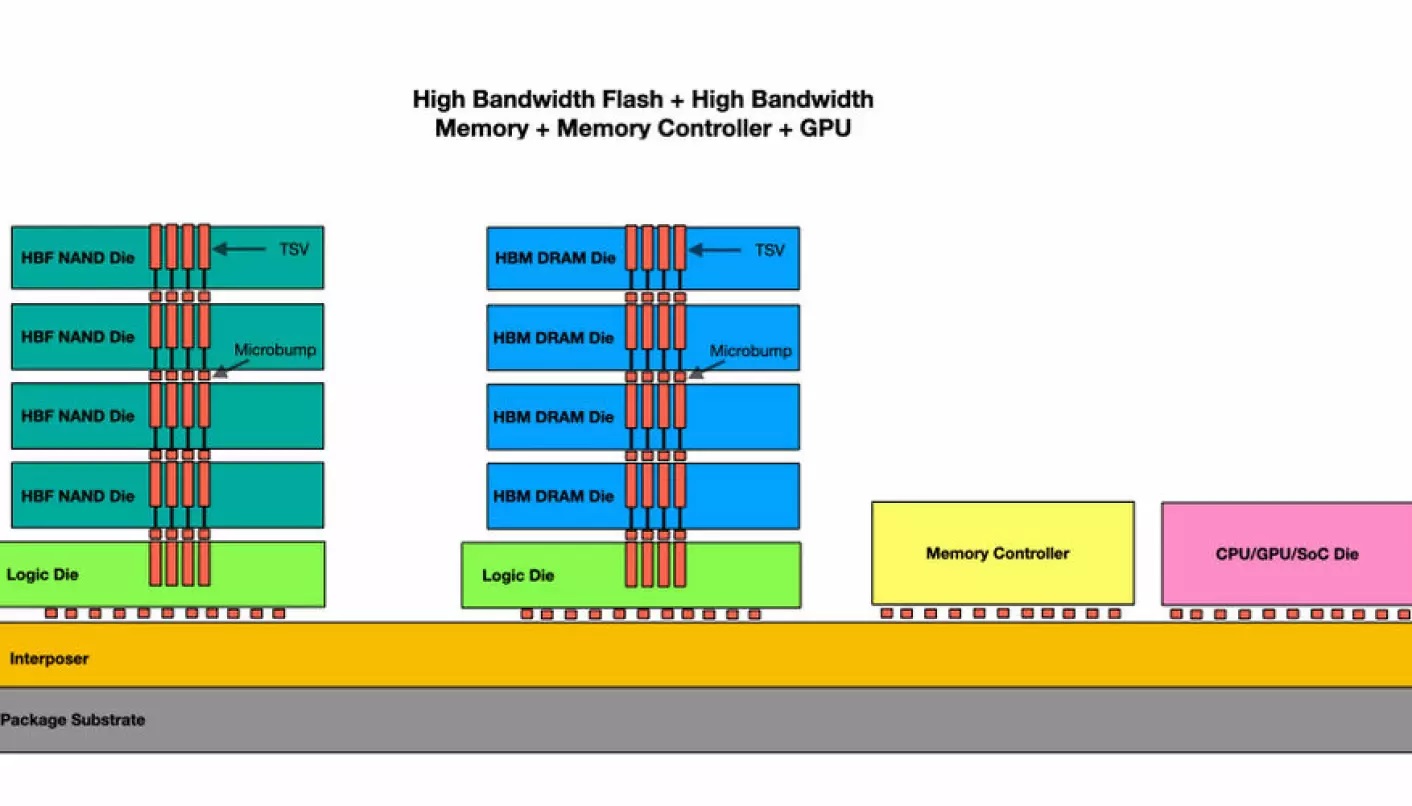

Компанія SK Hynix вирішила, що обирати не обов'язково. У своїй новій науковій роботі для IEEE вона представила архітектуру, яка поєднує швидкість HBM та місткість флешпам’яті прямо «під капотом» відеокарти.

Сучасні GPU (наприклад, майбутня Nvidia Rubin) використовують HBM-пам'ять, підключену через інтерпозер. Вона неймовірно швидка, але її місткості катастрофічно не вистачає для гігантських моделей. Коли місце в HBM закінчується, дані доводиться тягнути зі звичайних SSD через шину PCIe. Це як намагатися пити коктейль через дуже тонку і довгу соломинку — швидкість падає миттєво.

Це особливо критично для KV-кешу (структури, де зберігається контекст розмови). Наприклад, нова Llama 4 підтримує контекст до 10 млн токенів. Для зберігання такого об'єму потрібно близько 5,4 ТБ пам'яті. Щоб просто втримати ці дані в HBM, сьогодні потрібно об'єднувати десятки GPU в один кластер.

SK Hynix пропонує додати на той самий інтерпозер, де стоять чипи GPU та HBM, ще й HBF (High-Bandwidth Flash).

HBF має свої «суперсили» та слабкості. Серед переваг, перш за все, місткість, яка до 16 разів більша, ніж у HBM, та швидкість: пропускна здатність на рівні HBM (набагато швидше за будь-який SSD).

Є й недоліки. Так затримка вища, ніж у HBM (мікросекунди проти наносекунд), та флешпам’ять не любить постійного перезапису й витримує близько 100 000 циклів.

Таким чином було прийняте рішення використовувати HBF як гігантський кеш для даних, які потрібно переважно читати, а не записувати. Наприклад, для ваг моделі та вже обчислених контекстів (KV-кешу).

Дослідники протестували модель на базі архітектури Nvidia Blackwell (B200) з 8 стеками HBM3E та 8 стеками HBF. Ось що вийшло.

Швидкість генерації токенів зросла у 1,25 раза для контексту в 1 млн токенів та у неймовірні 6,14 раза для 10 млн токенів порівняно з системою лише на HBM.

Показник продуктивності на ват покращився у 2,69 раза.

Тепер навантаження, для якого раніше було потрібно 32 відеокарти (суто через обсяг пам'яті), можна обробити всього на двох GPU. Це колосальна економія на електриці та вартості серверів.

Ми входимо в «Еру агентів», де AI повинен пам'ятати величезні пласти інформації про користувача в реальному часі. Технологія робить «довгу пам'ять» AI дешевшою та швидшою. Замість того щоб будувати цілі ферми з GPU, компанії зможуть запускати надпотужні моделі на компактніших та енергоефективніших системах.

Це ще один крок до того, щоб складний AI став не просто іграшкою для корпорацій, а доступним інструментом у кожному офісі.