Тест LLM на краще знання української

14 январь, 2026 - 17:25Sergey PetrenkoСучасні LLM часто «думають» англійською, а потім перекладають результат, що призводить до граматично правильних, але неприродних текстів. Саме тому я замислився – як перевірити, що модель дійсно якісно «розмовляє» українською. Так й народився невеликий проєкт, який створено, щоб оцінити не просто когнітивні здібності моделей, а саме нативність володіння мовою – те, наскільки текст звучить природно для носія.

Чому це важливо

- Культурний код: Перевірка використання питомо українських конструкцій (кличний відмінок, частки «ж», «бо», «адже»).

- Якість контенту: Виявлення кальок та канцеляризмів, які роблять текст «штучним».

- Гігієна мови: Запобігання масовій генерації суржику та забрудненню інфопростору.

Як проходила перевірка

Бенчмарк складається з трьох рівнів:

- Блок А: Тести з еталонними відповідями (виправлення помилок, переклад, завдання із ЗНО).

- Блок V: Автоматичний аналіз на наявність кальок (русизмів/англіцизмів) та українських маркерів.

- Турнір: Парні порівняння генерацій с обчислюванням Elo-рейтингу, де якість мови оцінюють відкалібровані моделі-судді.

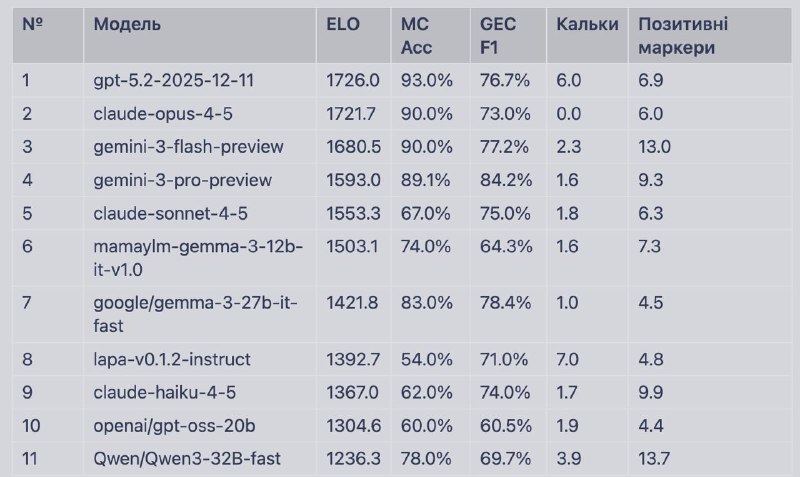

Ключові результати (Січень 2026)

- Лідери: Найвищий ELO-рейтинг у GPT-5.2 та Claude Opus 4.5. Що правда, GPT досить часто використовує кальки (русизми), переважно синтаксичні.

- Чистота мови: Claude Opus 4.5 – єдина модель із нульовим показником кальок (найкраща для офіційних текстів).

- Open-Source: модель MamayLM (Gemma 12B), що дотренована з використанням українського датасета та токенізатора, посіла 6-те місце, випередивши значно більші моделі від Google та Anthropic. Інша модель українських розробників – Lapa – теж досить достойно виглядає.

Проєкт опубліковано на github (навіть можна поставити зірку), якщо є побажання – пишіть.