Теория информации преподносит сюрпризы для машинного обучения

19 март, 2019 - 18:05Леонід БарашНовое исследование ставит под сомнение популярную концепцию о том, как алгоритмы машинного обучения «думают» об определенных задачах.

Концепция выглядит примерно так: благодаря своей способности отбрасывать бесполезную информацию, класс алгоритмов машинного обучения, называемых глубокими нейронными сетями, может изучать общие понятия из необработанных данных, например, идентифицировать кошек, как правило, после обнаружения десятков тысяч изображений разных кошек в разные ситуации. Говорят, что эта, казалось бы, человеческая способность возникает как побочный продукт многоуровневой архитектуры сетей. Ранние слои кодируют метку «кошка» вместе со всей необработанной информацией, необходимой для прогнозирования. Последующие слои затем пропускают информацию, как будто через узкое горлышко. Нерелевантные данные, такие как цвет шерсти кошки или блюдце с молоком рядом с ней, забываются, оставляя только общие черты. Теория информации дает границы того, насколько оптимальным является каждый слой, с точки зрения того, насколько хорошо он может сбалансировать конкурирующие требования сжатия и прогнозирования.

«Много раз, когда у вас есть нейронная сеть, и она учится сопоставлять лица с именами, или изображениями с числами, или удивительными вещами, такими как перевод текста с французского на английский, у нее есть много промежуточных скрытых слоев, через которые проходит информация, - говорит Артемий Кольчинский, научный сотрудник SFI и ведущий автор исследования. - Так что существует давняя идея, что по мере того, как исходные данные преобразуются в эти промежуточные представления, система обменивается прогнозами на сжатие и создает концепции более высокого уровня через это информационное узкое горлышко».

Однако Кольчинский и его сотрудники Брендан Трейси (Brendan Tracey, SFI, MIT) и Стивен Ван Куйк (Steven Van Kuyk, Университет Веллингтона) обнаружили удивительную слабость, применив это объяснение к общим проблемам классификации, где каждый вход имеет один правильный выход (например, в котором каждая картинка может быть кошкой или собакой). В таких случаях они обнаружили, что классификаторы со многими слоями, как правило, не дают некоторого прогноза для улучшенного сжатия. Они также обнаружили, что существует множество «тривиальных» представлений входных данных, которые с точки зрения теории информации являются оптимальными в отношении их баланса между предсказанием и сжатием.

«Мы обнаружили, что эта мера информационного узкого горлышка не дает сжатие таким же образом, как это делаете вы или я. Учитывая выбор, она так же счастлива валить в одну кучу «бокалы для мартини» с «лабрадорами», как и смешивать их с «фужерами для шампанского», - объясняет Трейси. - Это означает, что мы должны продолжать искать меры сжатия, которые лучше соответствуют нашим представлениям о сжатии».

Хотя идея сжатия входных данных может все еще играть полезную роль в машинном обучении, это исследование показывает, что этого недостаточно для оценки внутренних представлений, используемых различными алгоритмами машинного обучения.

В то же время Колчинский говорит, что концепция компромисса между сжатием и прогнозированием будет по-прежнему сохраняться для менее детерминированных задач, таких как прогнозирование погоды из набора данных с шумом. «Мы не говорим, что информационное узкое место бесполезно для контролируемого [машинного] обучения, - подчеркивает Колчинский. - То, что мы здесь показываем, это то, что оно ведет себя нелогично по многим распространенным проблемам машинного обучения, и это то, что люди в сообществе машинного обучения должны знать».

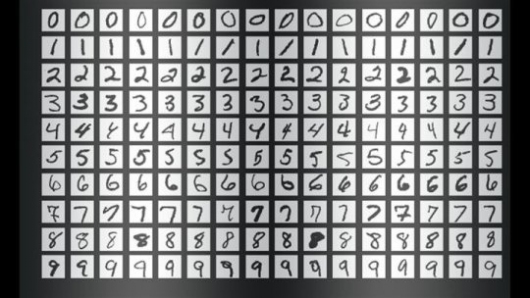

Это примеры из базы данных рукописных цифр MNIST