Семь оттенков «don’t be evil» для ИИ

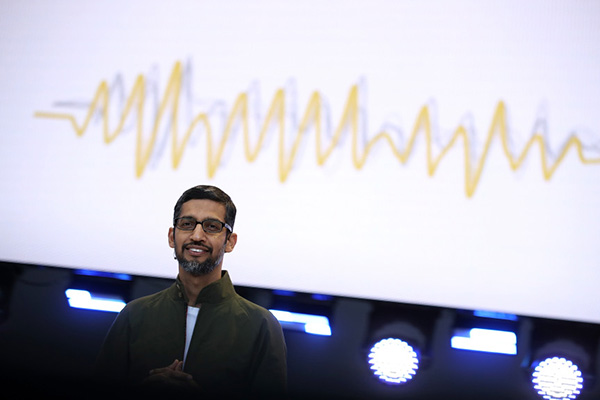

12 июнь, 2018 - 18:05Виталий КобальчинскийCEO Google Сундар Пичай выполнил обещанное и в блоге перечислил семь принципов, ставших ответом на апрельскую петицию нескольких тысяч служащих компании. Напомню, они требовали отказа от дальнейшего участия в проекте Министерства обороны США под названием Maven и внесения в политику Google положений о запрете на разработку военных приложений.

Про проект Maven, предусматривающий создание интеллектуальных алгоритмов анализа изображений с дронов, Пичай не сказал ни слова. Поэтому остаётся довольствоваться неофициальными ссылками на Диану Грин: CEO Google Cloud, якобы пообещала, что Google не станет продлевать контракт с Пентагоном после его завершения в 2019 г.

Неидеальны и обещанные «принципы робототехники»: на мой взгляд, им всё же недостаёт азимовской чёткости формулировок. Тем не менее, вот они, пришедшие на смену неофициальному девизу Google — не причинять зла (Don’t be evil). Согласно архивам Wayback Machine, этот знаменитый лозунг тихо исчез с сайтов Google в конце апреля — начале мая 2018 г.

Технологии искусственного интеллекта, создаваемые Google, должны:

-

Быть благоприятными для общества (в социальном и/или экономическом смысле).

-

Избегать создания или усиления несправедливой предвзятости (к расам, этническим группам, полу, национальности, доходу, сексуальной ориентации, политическим и религиозным воззрениям и т.п.).

-

Разрабатываться и тестироваться для безопасности (разработка, испытания и мониторинг после внедрения в соответствии с лучшими практиками безопасности ИИ).

-

Быть прозрачными для контроля со стороны людей (предоставлять объяснения действий, возможности для обратной связи и жалоб).

-

Включать принципы конфиденциальности (поощрять архитектуры с ограничителями для соблюдения приватности, обеспечивать позрачность и контроль за использованием информации).

-

Поддерживать высокие стандарты научного совершенства (Google будет продвигать строгие и междисциплинарные исследования, распространять методические материалы, лучшие практики для создания полезных приложений ИИ).

-

Предоставляться для использования в соответствии с этими принципами (компания должна ограничивая доступность потенциально вредных или опасных технологий).

В дополнение к семи принципам были провозглашены и четыре запретные для Google области применения ИИ. Это:

-

технологии, которые могут нанести вред: компания будет действовать только если посчитает, что польза существенно перевешивают риски, и должна предусмотреть соответствующие ограничения в целях безопасности;

-

оружие или другие технологии, основная цель которых заключается в нанесении или прямом содействии нанесению повреждений людям;

-

технологии, которые собирают или используют информацию для наблюдения, нарушая международно признанные нормы;

-

технологии, чья цель противоречит общепринятым принципам международного права и правам человека.

В то же время, глава Google подчеркнул, что компания продолжит сотрудничество с правительством и военными в использовании ИИ для кибербезопасности, обучения, подбора кадров и многих других «мирных» областях. Насколько чётко удастся провести грань между поиском жертв авиакатастрофы и огневых точек для целеуказания — покажет время.

«Мы осознаём, что такая мощная технология поднимает столь же серьёзные вопросы о её использовании», — пишет Пичай.

Компания оставляет за собой право на ошибку, то есть может блокировать уже используемую технологию, если станет известно, что та применяется в нарушение вышеприведенных принципов. Нашумевшими примерами таких ошибок являются алгоритм рекомендаций YouTube, предлагающий пользователям экстремистские видео, и функция распознавания в Google Photos, причислявшая темнокожих людей на снимках к человекообразным обезьянам.

Также Google DeepMind, OpenAI, основанная Илоном Маском, и другие ведущие лаборатории искусственного интеллекта всё чаще говорят о необходимости отступления от принципов свободного распространения информации об исследованиях — некоторые результаты слишком опасны для открытой публикации.