NVIDIA представила платформу TensorRT Hyperscale

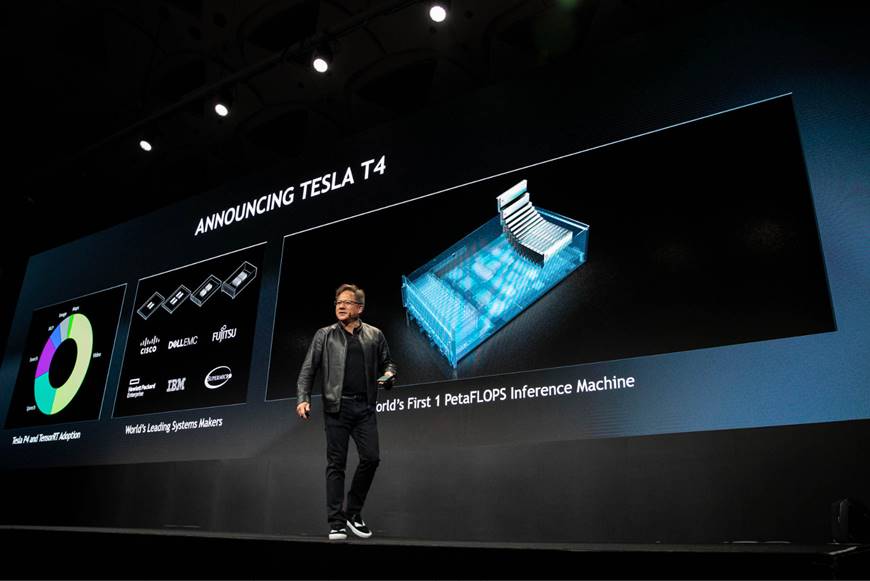

На региональной конференции NVIDIA по ускоренным вычислениям и искусственному интеллекту GPU Technology Conference в Японии глава компании Дженсен Хуанг объявил платформу TensorRT Hyperscale. Эта новая платформа для дата-центров с поддержкой ИИ обеспечивает ускорение инференса для голосовых, видео, графических и рекомендательных сервисов. В ее основе находятся четыре GPU Tesla T4 и полноценный набор программ для инференса.

Напомним, что Tesla T4 представляет собой ускоритель инференса. Благодаря тензорным ядрам архитектуры Turing, он повышает скорость операций произвольной точности в ИИ-приложениях.

TensorRT 5 — новейшая версия оптимизатора и среды исполнения инференса. Позволяет специалистам оптимизировать работу нейронных сетей и применять их для таких приложений, как компьютерное зрение и речь, в дата-центрах и встраиваемых устройствах.

В свою очередь TensorRT инференс-сервер — это контейнеризованный микросервис, который позволяет приложениям использовать ИИ-модели при создании дата-центров. Поддерживаются несколько моделей на GPU, оптимизировано для всех ключевых ИИ-фреймворков и масштабируется с помощью Kubernetes на GPU NVIDIA.

Компания также предлагает пакет CUDA 10, оптимизированный под Turing. Он включает оптимизированные библиотеки, новые конструкции модели программирования для определения выполнения программы, улучшенную совместимость API.