Можно ли провести на мякине искусственный интеллект

7 декабрь, 2018 - 11:35Тимур ЯгофаровТехнология ИИ претендует на то, чтобы получить широкое применение уже в ближайшее время в самых разнообразных сферах. Но можно ли ей доверять на все 100%, особенно когда речь идет о критически важных вопросах безопасности?

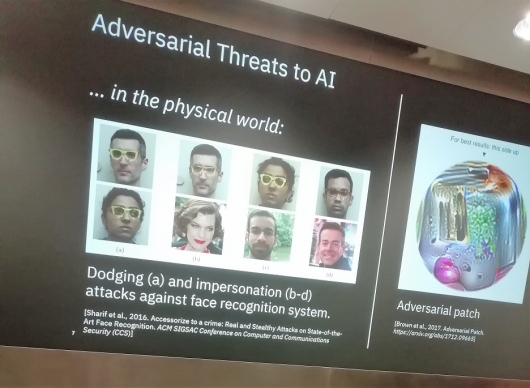

Одним из важнейших этапов внедрения ИИ является его тренировка на тех данных, с которыми впоследствии предстоит иметь дело. Исследователи IBM Research в Цюрихе рассказали о такой возможности создавать черные ходы в системах ИИ, как внесение в исходный набор данных специально подготовленных искажений. В результате, система будет неверно опознавать некоторые объекты, тогда как все остальные окажутся корректно определены. В качестве такого примера эксперт привел ситуацию, когда после тренировки на распознавание дорожных знаков, ИИ указывал на знак «Стоп», как на знак ограничения скорости, если к нему был прикреплен желтый листочек для заметок. Понятно, что в реальной дорожной обстановке такая ошибка может дорого стоить.

Пример внедрения "черного хода" в данные для тренировки ИИ

Стоит иметь в виду, что зачастую системы ИИ обучают на наборах данных, которые получены самыми разнообразными способами, начиная со сбора в социальных сетях и заканчивая генерированием добровольцами. И попробуй определить, не является ли этот набор преднамеренно искаженным для каких-то злонамеренных целей. Помочь в этом призвано решение Adversarial Robustness Toolbox, которое выпущено в виде открытого кода разработчиками IBM Research еще весной 2018 г и доступно на GitHub. Пока оно поддерживает только изображения, но в планах расширение его возможностей и на анализ речи, а также других используемых для тренировки ИИ форматов данных.

При общении с экспертом он призвал ИТ-специалистов, которые отвечают на внедрение решений на базе ИИ, особое внимание уделять тому, являются ли сертифицированными те наборы данных, что используются для тренировки.