HPC Day 2012: «Новые вызовы»

22 ноябрь, 2012 - 17:33Леонід БарашКонференция HPC Day, посвященная технологиям, аппаратному и программному обеспечению для построения мощных вычислительных кластеров, суперкомпьютеров, GRID, а также инфраструктуре для их поддержки, прошла в середине октября в НТУУ КПИ. Кроме НТУУ КПИ и компании «Юстар», в ее организации приняли участие HPC Advisory Council и НАН Украины.

|

| Филиппе Траутманн: «НР предлагает для НРС доступные и высокопроизводительные вычислительные системы, в том числе и с низким энергопотреблением» |

Конференция проходила в течение двух дней: первый был посвящен семинарам, тогда как пленарные доклады состоялись во второй. С него, нарушая хронологический ход мероприятия, мы и начнем.

Пленарную сессию открыл доклад менеджера НР в регионе EMEA по продуктам HPC & POD Филиппе Траутманна (Philippe Trautmann) о лучших практиках НР для ускорения инноваций с помощью высокопродуктивных вычислений.

Прежде всего, он отметил, что НРС не нужно рассматривать как нечто экзотическое в мире вычислений: они широко используются во многих областях науки и техники, медицине и биологии, геологии, метеорологии, в СМИ и индустрии развлечений — этот список можно продолжать и продолжать. Рынок огромный, и, по данным IDC, только в Европе он достигает 3,5 млрд. долл., а в России и СНГ — 300 млн. долл.

Большинство заказчиков в Западной Европе используют системы с производительностью на уровне PFLOPS. В то же время технологии HPC сегментируются. Здесь можно выделить системы с низким потреблением энергии, базирующиеся на таких процессорах, как ARM, Atom и CPU AMD; сверхпроизводительные системы, использующие NVIDIA Tesla и Intel Xeon Phi и, наконец, широко распространенные суперкомпьютеры на процессорах Xeon.

Недавно НР объявила о выходе некоторых новых продуктов. Это серверы поколения G8. Наряду с NVIDIA Kepler (K10 и K20), они поддерживают также и акселераторы Intel. В ответ на запросы рынка компания разработала экономичный ЦОД для высокопроизводительных вычислений — НР POD 240а. Эта автономная модульная система позволяет установить до 4400 серверов и занимает площадь в 10 раз меньшую, чем традиционные ЦОД такой же вычислительной мощности. Для своей установки НР POD 240а не требует помещения и инсталлируется в течение одного—двух месяцев. Кроме этого, начата работа над проектом Moonshot (CPU ARM/Atom), с помощью которого компания надеется установить в вычислениях новые стандарты стоимости, энергоэффективности и плотности. Проект предусматривает установку от 50 до 80 серверов в шасси. Серверы хорошо подходят для построения систем с массовым параллелизмом для решения определенных задач (к примеру, расшифровки генов). Есть также прогресс и в области «интеллектуальных решений» — это новый комплекс Hadoop и программный пакет для управления кластерами Insight CMU.

|

| Тун Лю: «Mellanox разрабатывает новинки, которые позволяют повысить скорость внутрисистемных соединений, а также вносит вклад в ускорение обработки Big Data» |

Для НРС компания предлагает доступные и высокопроизводительные вычислительные системы, в том числе и с низким энергопотреблением. Это кластеры на платформе х86 с ОС Linux. Они оборудованы многоядерными процессорами и сетью InfiniBand для внутрисистемной связи, графическими платами с GPU-ускорителями. К примеру, на серверах серии SL можно установить до 8 графических плат. Все системы доступны для тестирования заказчиками в Европейской лаборатории НР.

Важную роль в НРС играют внутрисистемные соединения. О достижениях в этой области компании Mellanox Technologies рассказал директор по техническим вычислениям Тун Лю (Tong Liu). Прежде всего, он отметил, что компания поставляет полное решение, включающее микросхемы, коммутаторы и адаптеры, ПО и соединительные кабели. Продукты Mellanox используют 210 компаний из TOP 500 лучших компаний мира. В суперкомпьютерах Mellanox InfiniBand уже опережает Ethernet по количеству установок.

Далее докладчик обратил внимание аудитории на улучшения, которые появились с выходом четвертого поколения InfiniBand — Fourteen Data Rate (FDR) InfiniBand. Пропускная способность увеличилась до 14 Гб/с на одну дорожку, что для распространенных четырехдорожечных портов дает значение 56 Гб/с. Схема линейного кодирования была модифицирована с 8bit/10bit до 64bit/66bit, что повысило эффективность соединения, была также добавлена прямая коррекция ошибок (FEC). Кроме этого, FDR InfiniBand сегодня является единственной технологией, которая работает со стандартом PCI-E 3.0. Важным является также поддержка технологии Virtual Protocol Interconnect (VPI), которая позволяет использовать совместно Ethernet и InfiniBand в сложных системах. Кроме эффективного межкомпонентного соединения, InfiniBand может с успехом служить каналом к СХД, в том числе и удаленных.

Mellanox разрабатывает новинки, которые позволяют повысить скорость внутрисистемных соединений. К ним относится Connect-IB — однопортовый и двухпортовый канальный InfiniBand-адаптер хоста (НСА), который рассматривается как основа для систем с производительностью, исчисляемой ExaFLOPS. Это первый в мире адаптер с пропускной способностью 100 Гб/с (на двух портах). Он способен передавать 130 млн. сообщений в секунду — в четыре раза больше, чем другие решения InfiniBand. Реализован также прямой обмен данными между GPU (GPUDirect RDMA peer-to-peer) и ряд других механизмов, повышающих общую производительность вычислительных систем. При увеличении количества узлов и процессоров практически линейную масштабируемость обмена сообщениями обеспечивает Fabric Collective Accelerator (FCA).

|

| Себастьян Кабаньоль демонстрирует возможности HP CMU в режиме реального времени |

Компания вносит вклад в ускорение обработки Big Data. Так, популярный пакет программ Hadoop предусматривает перемещение больших объемов данных для получения результатов. Mellanox разработала ускоритель обработки неструктурированных данных UDA, таким образом, Hadoop теперь может работать через InfiniBand, что повысило его эффективность на 45%. В процессе разработок новых технологий компания тесно сотрудничает с ведущими производителями программного и аппаратного обеспечения.

Включение в вычисления графических процессоров позволяет добиться не только ускорения, но и снизить количество CPU, требуемое для получения планируемой производительности. Наиболее популярна сегодня платформа NVIDIA Tesla. Новейшую архитектуру Kepler представил менеджер по работе с системными интеграторами Дмитрий Конягин из NVIDIA.

Компания не только каждые два года в

По сравнению с Fermi, в архитектуре Kepler радикально пересмотрена структура строительных элементов, увеличено количество вычислительных ядер в блоке, который теперь называется SMX (восьмая генерация SM, Streaming Multiprocessing), и пересмотрена управляющая логика. Это в три раза повысило энергоэффективность. Технология Hyper-Q позволила решить проблему максимальной загрузки графического процессора. В архитектуре Fermi центральный процессор мог послать GPU только одну задачу MPI (Message Passing Interface). Фактически, GPU оставался незагруженным. В архитектуре Kepler количество MPI-задач увеличилось до 32. То есть ядра CPU одновременно запускают задачи на Kepler. В результате удалось добиться сокращения времени простоя CPU и максимальной утилизации GPU. Технология динамического параллелизма позволила снизить обмен данными между CPU и GPU. Это происходит за счет того, что GPU, получив основную задачу от CPU, стал способен независимо от него планировать свою работу.

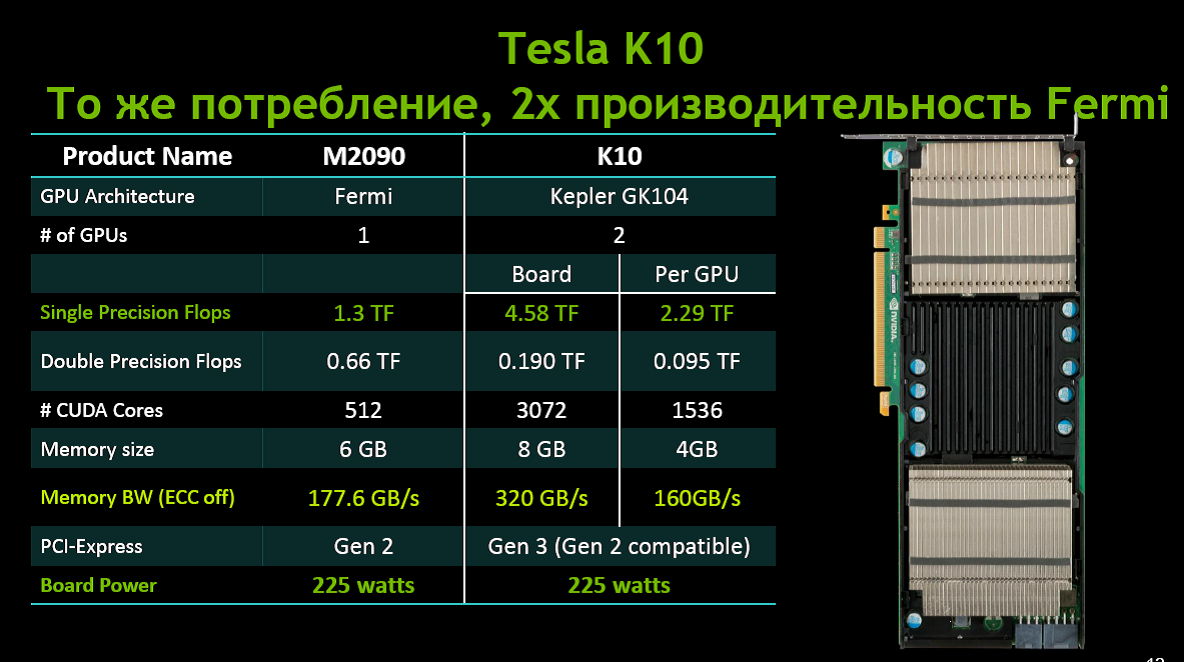

Далее Дмитрий Конягин перешел к обзору непосредственно продуктов и провел краткое сравнение Tesla К10 и Tesla К20. В частности, он отметил, что первый ускоритель спроектирован для высокопроизводительных вычислений с одинарной точностью и предназначен для обработки изображений, сигналов, задач молекулярной динамики и некоторых задач сейсморазведки, тогда как второй, с двойной точностью и технологиями Hyper-Q и Dynamic Parallelism, предназначен для задач вычислительной гидродинамики и ряда физических задач. Читатель может увидеть конкретные цифры на приведенном ниже слайде.

Докладчик обратил внимание аудитории на то, что сегодня 118 коммерческих приложений ускоряются с помощью GPU.

Вторая часть презентации Дмитрия Конягина относилась к особенностям программирования GPU. Здесь можно пользоваться готовыми библиотеками, включать директивы открытого стандарта OpenACC в тексты программ на Фортране или С или воспользоваться языком программирования CUDA C/C++.

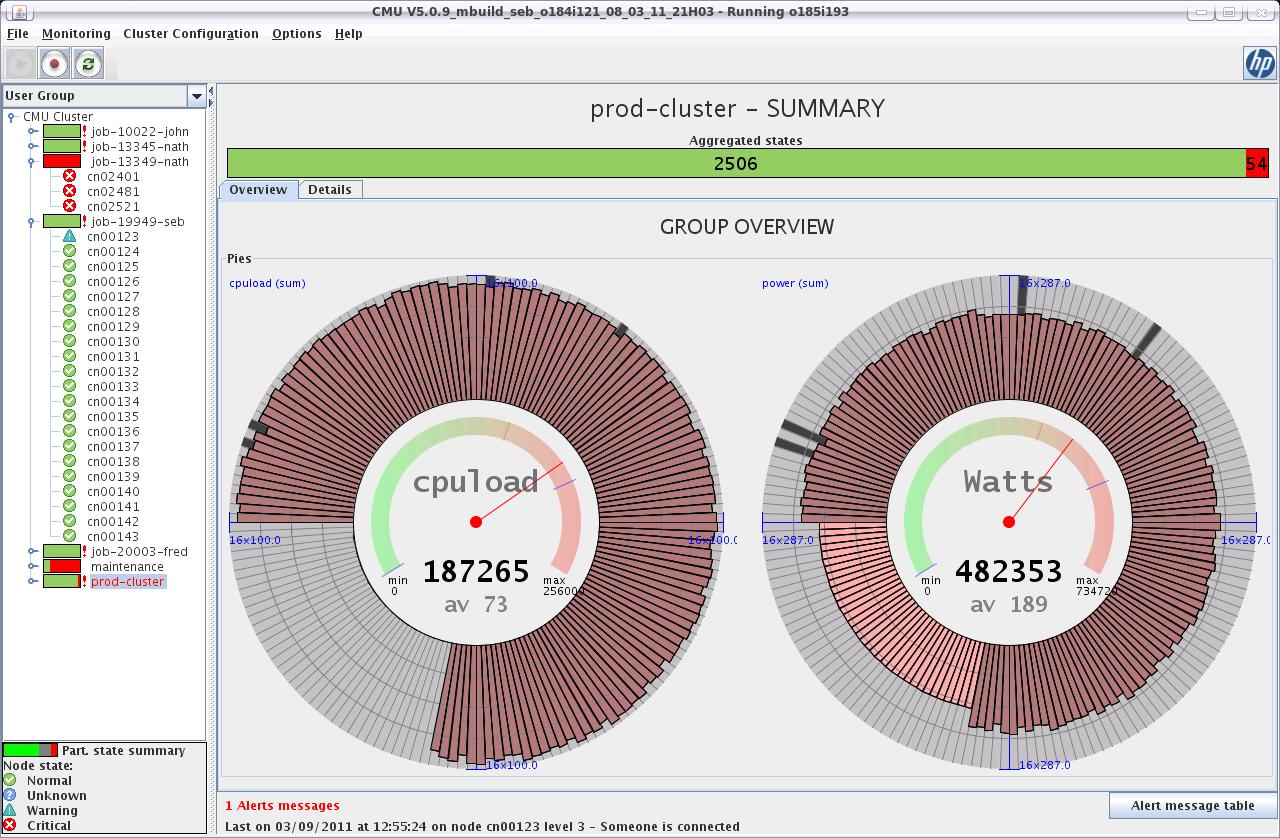

Эффективность вычислений во многом зависит от управляющего ПО. Ведущий архитектор из НР Себастьян Кабаньоль (Sebastien Cabaniols) представил НР Insight Cluster Management Utility (CMU) — инструмент для управления вычислительными кластерами.

Insight CMU представляет собой пакет программ, позволяющий минимизировать совокупную стоимость владения компьютерными фермами. Сегодня CMU позволяет управлять 4 тыс. узлов, и вскоре их количество планируется удвоить. Примечательно, что пакет не зависит от многих архитектурных особенностей систем, таких как внутрисистемные соединения, акселераторы, топология сети (открытый кластер, защищенный кластер, WAN), стека MPI, мат. библиотек, компиляторов и др. Более 90% CMU поставляется «под ключ» вместе с кластерами НР, однако пакет можно приобрести отдельно с поддержкой и руководством.

|

| Александр Франке проводит семинар по PBS Professional |

CMU устанавливается на главный узел. Его три основные характеристики включают CLI, API и GUI (последний обеспечивает контроль типа приборной доски). С помощью этого пакета решаются три главных вопроса: это подготовка серверов к работе и распределение ресурсов, мониторинг функционирования системы и управления ею.

Машина распределения ресурсов обеспечивает три основных функции. Резервирование и клонирование позволяет определить эталонный узел и скопировать его на другие серверы. Функция автоматической инсталляции устанавливает мост между CMU и унаследованными системами (Red Hat Kickstart, SLES Autoyast, Preseed Debian). Наконец, diskless-функция устраняет необходимость обязательной загрузки серверов с жестких дисков.

Система мониторинга легко масштабируется, позволяет включать любые объекты для мониторинга с помощью сценариев, интегрируется с более крупными системами. Система аварийных сообщений позволяет автоматически запускать нужные программы на основе данных мониторинга.

Подключив свой ноутбук к кластеру в Гренобле, Себастьян Кабаньоль создал искусственное задание и получил на экране диаграммы загрузки серверов:

Разработчики CMU расширили функциональность утилиты, включив возможность просмотра истории нагрузок кластера в режиме реального времени с помощью добавления оси времени. Пакет также может осуществлять и мониторинг GPU.

О проектировании сетей для высокопроизводительных вычислений на базе оборудования Extreme Networks рассказал системный инженер Дмитрий Смирнов. С точки зрения сетевой инфраструктуры НТС выдвигают три требования: это минимальная задержка, достаточная для наращивания производительности емкость и надежность. Затем докладчик проанализировал каждое из вышеуказанных требований и обрисовал методы решения возникающих проблем. Так, задержка определяется, в основном, расстоянием передачи, сетевой инфраструктурой и особенностями прикладных программ. Лучшие практики минимизации задержек рекомендуют правильный выбор провайдера оптической связи (в случае создания геокластера), более скоростной интерфейс для быстрой сериализации, сокращение количества уровней в сети для быстрой передачи (растягивать L2, уменьшать L3), оптимальный выбор сетевого оборудования (например, коммутаторы без буферизации пакетов), управление отбрасыванием пакетов с целью уменьшения неустойчивости синхронизации. Существенную роль играют также количество транзитных узлов, топология сети и множество других факторов (на которых здесь нет возможности останавливаться). Емкость, или производительность сети, во многом определяется архитектурой коммутаторов, в частности особенностями соединения коммутационных фабрик с модулями ввода-вывода. Для построения высокопроизводительных кластеров в арсенале Extreme Networks имеются такие технологии, как агрегирование каналов (Multiswitching Link Aggregation — MLAG), модульная ОС ExtremeXOS, высокоскоростное стекирование коммутаторов, высокопроизводительные магистральные коммутаторы серии BlackDiamond.

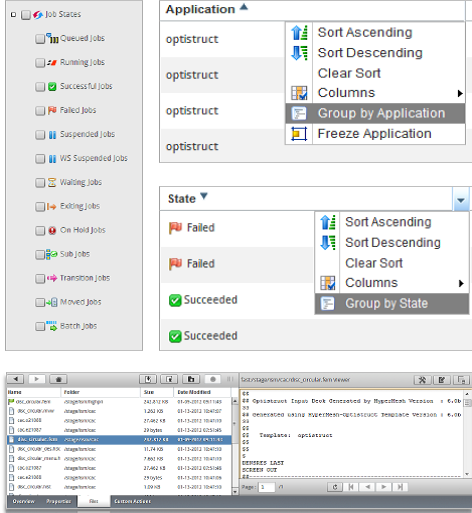

Мало иметь высокопроизводительный кластер, вычислениями необходимо также управлять. О ПО PBS Professional, предназначенном для этих целей, рассказал программный инженер по техническим вычислениям Александр Франке (Alexander Franke) из компании Altair. Этот пакет работает у многих заказчиков из области науки и техники, госорганов. Основное назначение PBS Professional — упростить передачу команд. Обычно это делается с помощью сценариев. Но пользователей, которые могут его написать, не так уж много. В то же время им необходимо контролировать вычислительный процесс.

В основе технологий управления вычислениями лежит PBS Professional. На этом уровне есть ряд прикладных служб, в частности, интерфейсы для передачи задач вычислительной системе. Пользователь может построить собственный графический интерфейс для этих целей. Кроме передач заданий, с помощью PBS Professional можно осуществлять мониторинг выполняемых задач, например, увидеть, сколько задач выполнены успешно, сколько неуспешно и почему, можно приостановить или прервать выполнение каких-либо задач, посмотреть файлы с выходными данными.

Далее, пользователь может визуализировать результаты вычислений с помощью имеющихся в пакете средств или использовать для этого любой вставной модуль третьего производителя, поддерживаемый веб-браузером. Дополнительно к PBS Professional обычно внедряется система управления правами доступа. В процессе доклада Александр Франке демонстрировал возможности пакета на примерах снимков экрана.

Заключил пленарную сессию доклад менеджера Fujifilm Дмитрия Алексеева под названием «Где хранить зетабайты?». Он привел убедительные аргументы за то, что на фоне растущих расходов на хранение данных, рано списывать ленточные системы. По его словам, дисковые системы стоят в

Вернемся теперь к первому дню конференции. Как уже упоминалось выше, он был посвящен семинарам для специалистов. Первый семинар, темой которого была NVIDIA CUDA, провел тренер из научно-образовательного центра Applied Parallel Computing Александр Шевченко. Он представил новинки в CUDA 5 и Kepler, прочитал краткое введение в OpenACC и провел практикум. На втором семинаре Тун Лю рассказал о новостях от HPC Advisory Council, представил современные технологии межузловой связи, повышающие эффективность НРС-систем и рассмотрел пример проектирования кластеров с учетом новых технологий. Заключительный семинар, на котором были детально рассмотрены возможности и особенности PBS Professional, провел Александр Франке.