Что ждет ЦОД за горизонтом?

23 ноябрь, 2011 - 14:14Тимур ЯгофаровВ последнее время все чаще доводится встречать рассуждения о том, насколько важным при построении проектов любого масштаба является расчет совокупной стоимости их владения. Например, с появлением новых процессорных платформ их производители ратуют за смену оборудования предыдущего поколения, так как это позволяет достичь значительного повышения эффективности даже на относительно небольшом предприятии. А как быть с центрами обработки данных, где устанавливается огромное количество серверов?

Тема построения ЦОД стала почти обязательной на конференциях, организуемых в последнее время производителями серверного и сетевого оборудования. А фокусирующийся на этом направлении дистрибьютор – компания «Мегатрейд» – даже проводит так называемую «Академию ЦОД» для своих партнеров. Это двухдневное мероприятие уже второй раз подряд проходило в комплексе «Gintama Бриз» в пригороде Киева, причем его программа была достаточно плотной и включала презентации вендоров, оборудование которых поставляет в нашу страну «Мегатрейд». С полным набором презентаций, с которыми выступали сотрудники «Мегатрейд» и приглашенные компанией специалисты можно познакомиться в онлайне, и мы не будем останавливаться на всех, так как большая их часть представляла описание номенклатуры того или иного производителя. Уверены, что гораздо интереснее простых описаний оборудования будет рассказ о тенденциях развития всей отрасли построения центров обработки данных, с которым выступил представитель Panduit Александр Андреев. На базе его презентации и данных из других источников и будет построена эта попытка заглянуть «за горизонт» ЦОДостроения.

Прежде всего, почему настолько актуальна тема ЦОД сегодня, когда большая часть пользователей, казалось бы, вообще не имеет напрямую дела с серверами. Но на самом деле это не так, ведь в эпоху быстро растущей популярности мобильных средств доступа к различным онлайновым ресурсам, в том числе и к социальным сетям, всю эту армию нужно не только обслужить провайдеру мобильной связи, но и обеспечить контентом. А значит, на каждые пару десятков проданных смартфонов придется установить как минимум один сервер, а то и два.

В ближайшей перспективе – резкий рост числа интернет-подключений, помноженный на быстро увеличивающуюся популярность таких «тяжелых» сервисов как видео и обмен файлами

Как показывает анализ активности современных пользователей, наиболее динамично увеличивается популярность размещенного в онлайне видео и файловый обмен, а эти сервисы требуют достаточно производительных серверов и систем хранения данных. И если вопросы производительности на нынешнем этапе уже более-менее понятно как решать, то с расходом энергии на саму работу вычислителей и охлаждение помещений с ними все гораздо сложнее. Эта статья расходов увеличивается гораздо быстрее чем затраты на само оборудование. Поэтому стремясь сэкономить, ЦОД пытаются поместить либо рядом с источниками дешевой электроэнергии, либо в те географические зоны, где требуется меньше затрат на охлаждение.

В качестве примеров оригинальных решений с использованием естественного охлаждения можно привести новый дата-центр Google, расположенный в финском городе Хамина. Здесь для охлаждения используются старые гранитные туннели, через которые вода подавалась на несуществующий ныне целлюлозно-бумажный комбинат. Теперь эта вода охлаждает центр обработки данных, а затем возвращается в Финский залив. А во Франкфурте для дополнительного охлаждения центра обработки данных на его крыше высадили растения, правда, этот ЦОД все же не отказался от систем кондиционирования воздуха. Зато Facebook в стремлении укрепить репутацию экологически ответственной компании опубликовал планы строительства серверной фермы в районе Северного полярного круга, где оборудование будет охлаждаться естественным путем. Что уже говорить о таком решении, как установка ЦОД рядом с геотермальной электростанцией в Исландии, где не только достаточно холодно, чтобы использовать внешний воздух для охлаждения оборудования, но и электроэнергия оказалась гораздо дешевле. Именно это привлекло компанию Opera, разместившую здесь свои серверы, которые обслуживают трафик браузера Opera Mini.

Иной вариант экономии реализован в центре обработки данных Cisco в городе Аллен (штат Техас), который построен на базе конвергентной инфраструктуры с передачей данных и трафика систем хранения по единой сети. В результате сокращается количество коммутаторов, адаптеров и кабелей значительно снижается энергопотребление: чем меньше кабелей, тем свободней обтекают оборудование естественные потоки воздуха, снижая потребность в вентиляторах. Еще больше снижает потребности в энергии виртуализация серверов, позволяя обрабатывать тот же объем информации меньшим количеством физических серверов. В результате кондиционирование воздуха в этом ЦОДе включается лишь тогда, когда температура воздуха в помещениях превышает 25 градусов Цельсия. Для энергопитания офисных помещений используются солнечные батареи. Все это позволяет компании Cisco сократить расходы на охлаждение центра обработки данных на 600 тысяч долл. в год.

Но это день сегодняшний, а как еще можно увеличить эффективность, ведь энергозатраты на обслуживание ЦОД будут неуклонно расти вместе с трафиком и числом пользователей? А что если используемую ныне технологию виртуализации перенести на более высокий уровень и в качестве вычислительного кирпичика рассматривать не одну отдельную серверную платформу, а целый их кластер? Тогда с полным выходом из строя целой секции ее нагрузку можно перенести на другую. Причем, формироваться эти секции будут не в виде стоек в некоем помещении, а как отдельные контейнеры. И плотность размещения оборудования в них будет такой высокой, что ремонтировать отдельные серверы или блоки питания не потребуется. При выходе из строя одного из них просто будет понижаться вычислительная нагрузка на всю секцию в целом пропорционально числу отказавшего оборудования. Если же это источник питания, то уменьшается и нагрузка на весь контейнер в целом на ту долю мощности, которую обеспечивал этот БП. Тем более что динамически менять мощность оказывается эффективнее, чем закладывать ее в дополнительное оборудование с запасом на возможную пиковую нагрузку.

В последнее время в моду вошло построение ЦОД с обеспечением высокого уровня надежности без учета того, насколько это экономически обосновано. Например, ЦОД класса Tier4 стоит в 3,5 раза дороже Tier1 и почти вдвое – Tier2. А что если вместо одного высокоуровневого Tier4 построить два Tier1 с обеспечением балансировки их нагрузки и/или резервирования? Возможно, обеспечить необходимый уровень надежности будет проще и эффективней путем объединения двух территориально разнесенных ЦОД более низкого уровня, чем резервировать оборудование в одном? Ведь резервирование приводит к существенному увеличению стоимости решения, не говоря уже о занимаемой площади помещений ЦОД и падении эффективности всей системы в целом.

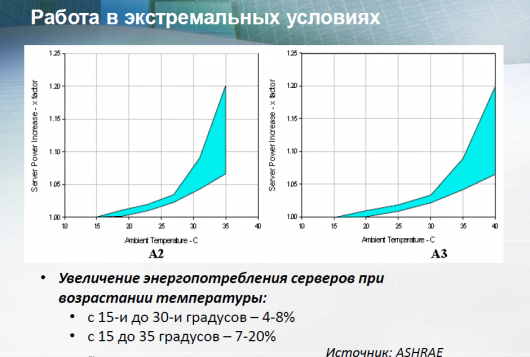

Увеличение температуры помещения приводит к росту энергопотребления серверов

Еще одно достаточно неожиданное предложение по повышению эффективности ЦОД связано с полным либо частичным отказом от охлаждения электроники. Почему его обеспечивают сейчас? Это связано с требованием соблюдения температурного режима для увеличения надежности функционирования элементной базы. Стандарт, разработанный American Society of Heating, Refrigerating and Air-Conditioning Engineers (ASHRAE) в 2004 г, предусматривал диапазон рекомендованных значений температуры для эксплуатации электроники от 20 до 25°С и относительной влажности 40-55%. В 2008 г он был скорректирован до 18-27°С и до 60%. При этом стандарт указывает допустимые параметры: температуру – 10-35 °С и влажность 20-80%. Что же произойдет, если использовать в ЦОД не комфортные для человека рекомендованные параметры, а допустимые, и обойтись без доступа персонала в рабочую зону?

Более высокая температура окружающей среды требует и более интенсивного обдува оборудования

Оказывается, при возрастании температуры помещения происходит следующее увеличение энергопотребления серверов: с 15 до 30 °С на 4-8%, а с 15 до 35 °С на 7-20%. При этом конечно же потребуется улучшить обдув электроники в таких пределах: с 15 до 30 °С в 1.8 раз, а с 15 до 35 °С в 2.5 раза. Из-за увеличения потока воздуха через системные блоки вырастет и шум по следующему соотношению. Если взять 25°C за 0 дБ, то 30°C даст прирост в 4.7 дБ, 35°C – 6.4 дБ, 40°C – 8.4 дБ, а 45°C уже 12.9 дБ. Для понимания этих величин отметим, что разница в уровне шума на улице и в офисе составляет примерно 10 дБ. Поэтому находиться в таком интенсивно продуваемом помещении можно недолго даже без специальных средств защиты типа изолирующих наушников или «берушей». Что же касается экономии электроэнергии, то вполне понятно, что возрастание потребления на 20% гораздо меньше, чем двукратный запас, закладываемый на кондиционирование. При этом стоит учесть, что на большинстве территорий со значительными сезонными перепадами температур горячий период времени, требующий дополнительного расхода электроэнергии самих серверов и на их охлаждение, невелико: лето и возможно часть весны и осени. А в остальные сезоны и этого не нужно.

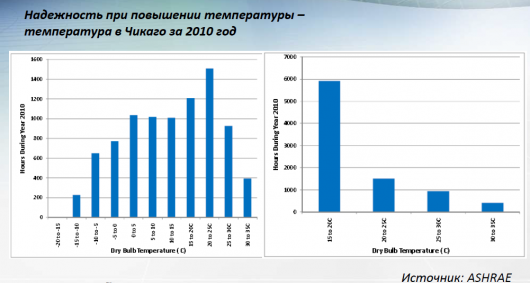

Вот что говорит статистика о погодных условиях в районе Чикаго

А что же с надежностью самих электронных схем, которым придется работать при повышенных температурах? По данным исследования ASHRAE, проведенного в ЦОД, который был размещен в Чикаго, среднегодовая надежность оборудования, находившегося в эксплуатации без кондиционирования, составляет 0,99. При этом в более жаркое время года надежность, конечно, падала, зато в холодное возрастала, но эти колебания оказались незначительными и взаимно компенсировались.

Что же до ставших привычными в ИТ-инфраструктурах ИБП, то от них, конечно, совсем отказаться нельзя, так как непрерывность обеспечения электроэнергией ЦОД в любом случае требуется. Но предлагают отказаться от ИБП малой и средней мощности, устанавливаемых в составе контейнеров или их групп, а оставить только мощные мегаваттные роторного типа. Они отличаются высокой эффективностью, да и период детских болезней роста это оборудование уже пережило, поэтому с его помощью вполне можно обеспечивать весь комплекс без резервирования на отдельных участках.

Главный вопрос дня – когда разработчики ПО смогут предложить комплексы для управления таким ЦОД. И нужно сказать, что прогресс в этом направлении уже наблюдается. Так во время презентации новой серверной 16-ядерной платформы AMD представитель VMware сообщил, что в компании работают в данном направлении. И первым шагом является недавно объявленное ею решение под звучным именем vCloud. В его рамках предлагается ПО управления «облаком» vCloud Director, с помощью которого можно формировать на базе единого пула серверов отдельные «частные облака», изолируя их друг от друга на всех уровнях. Чем «облако» не наглядный символ того самого ЦОД, построенного в виде городка из контейнеров с серверами? И по заявлению сотрудника VMware, компания будет развивать свою «облачную» линейку.

Примечательно, что в развернувшейся на презентации AMD дискуссии, не раз упоминалась концепция ЦОД на базе модульной структуры. И представители лидеров ИТ-индустрии соглашались, что это один из наиболее перспективных сценариев развития этой сферы. Понятно, что кроме крупных ЦОД, на основе которых будут строиться «облака» различного масштаба, будут создаваться и частные решения для относительно небольших компаний и тех, кто по тем или иным причинам желает держать аппаратные платформы под присмотром собственного персонала и на собственных площадях. Но в любом случае стоит познакомиться с этой концепцией, тем более что получила поддержку лидеров индустрии. И появившись несколько лет назад в арсенале Sun Microsystems в виде 40-футового контейнера, набитого серверами, как решение для мгновенного разворачивания ИТ-инфраструктуры практически в любых условиях, эта идея сегодня трансформировалась в достаточно логично обоснованную концепцию, нацеленную на повышение эффективности. Интересно, когда она будет реализована на практике.