Частотный анализ выявляет фальсификации, визуально неотличимые от реальности

Исследователи из Института информационной безопасности Хорста Гёрца в Рурском Университете г. Бохум (Германия) и Кластера передового опыта «Кибербезопасность в эпоху крупномасштабных противников» (Casa) разработали новый метод эффективной идентификации глубоко фальсифицированных изображений или дип-фейков.

В эту среду команда представила свою работу на Международной конференции по машинному обучению (ICML). Кроме того, исследователи выложили использовавшийся ими код в свободном доступе на GitHub.

Дип-фейками называют изображения, фальсифицированные с применением нейронных сетей глубокого обучения, а точнее, так называемых генеративных состязательных сетей (Generative Adversarial Networks, GAN). В этом методе работают две нейросети: одна генерирует картинку, а вторая пытается определить, реальное это изображение или подделка. Если фальсификация обнаруживается , то первая нейросеть изменяет свою картинку — пока она не становится неотличимой от реальной.

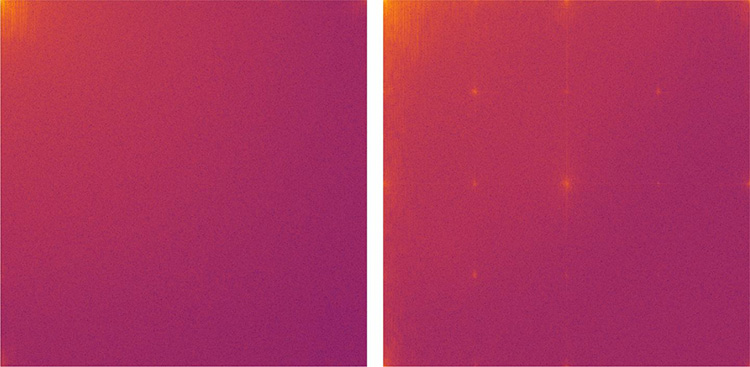

До сих пор глубоко фальсифицированные изображения анализировали с помощью сложных статистических методов. Группа из Бохума избрала другой подход: с помощью дискретного косинусного преобразования она трансформировала изображения в частотный вид, в котором оно представлено суммой различных косинусных функций.

Спектральный анализ показал, что в отличие от естественных изображений, которые в основном состоят из низкочастотных функций, в картинках, сгенерированных с помощью GAN, присутствуют артефакты в высокочастотной области.

«Наши эксперименты подтвердили, что эти артефакты возникают не только в изображениях, сгенерированных GAN. Они являются структурной проблемой всех алгоритмов глубокого обучения, — пояснил Джоэл Франк (Joel Frank) с кафедры системной безопасности. — Мы считаем, что артефакты, описанные в нашем исследовании, всегда будут указывать на глубоко фальсифицированное изображение, созданным с помощью машинного обучения. Таким образом, частотный анализ является эффективным способом автоматического распознавания компьютерных изображений».