Big Data в гипоцикле Gartner

5 декабрь, 2013 - 11:45Александр ЧерниковКак всякая новая «Большая Вещь» концепция Big Data в последние два-три года является своеобразным маркетинговым тараном, применяемым в буквальном смысле для вышибания денег из потенциальных заказчиков. Но представление ее как «актуального бизнес-приоритета» сегодня, пожалуй, является некоторым преувеличением даже для стран с наиболее развитыми информационными технологиями

Поток публикаций и все новые предлагаемые области использования Big Data сделали свое дело – «панацея» на слуху, и все, что связано с «большими данными» уже кажется понятным и привычным. Между тем, за последние четыре года сами аналитики Gartner дважды меняли название отслеживаемой категории, пока пришли к окончательному названию «Big Data».

В 2010 г. это – «Extreme Transaction Processing», в 2011 г. – «Big Data and Extreme Information Processing and Management» (причем сам термин «Big Data» приводится еще в кавычках). Только в 2012 г. Big Data получили свое окончательное название как категория. Кроме того, далеко не все так уж прекрасно с продвижением и рациональным использованием Big Data.

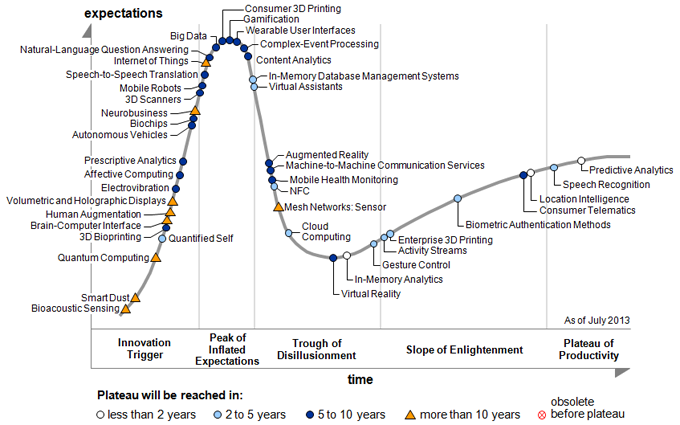

Рис. 1. – Big Data на пороге «впадины разочарований».

Согласно Gartner, самые большие разочарования этого года, так или иначе связанные с Big Data, приходятся на Cloud Computing и In-memory Databases, которые в этом году (наряду с виртуальной реальностью) находятся на самом дне «Впадины обманутых ожиданий» (Trough of Disillusionment).

Поскольку на созревание Big Data и выход технологии на стабильную платформу продуктивности аналитиками Gartner отводится от 5 до 10 лет, то можно ожидать, что через год-два для нее наступит время стремительного падения популярности. Вместе с тем, как видно на верхних графиках, в 2014 г. Big Data окажутся на вершине «дутых ожиданий» (Peak of Inflated Expectations), которые частично оправдаются, видимо, только к концу десятилетия.

Как известно, гипоцикл вообще был придуман для демонстрации текущего уровня гиперболизации появляющихся технологий относительно реального уровня видимой на сегодня их полезности.

Например, для Cloud Computing и вычисления, и хранение данных в облаке воспринимаются клиентами в основном как экономически выгодные варианты, но… «организации немного разочарованы действительной достаточно высокой стоимостью Cloud Computing», как недавно сказал в интервью InformationWeek аналитик Gartner Ник Хайдекер (Nick Heudecker). Он же добавил: «Мы начинаем сегодня видеть некоторое сопротивление со стороны организаций, которые наконец поняли, что они, возможно, экономят не так уж много денег».

Это, в частности, объясняет, почему после громких медных труб и барабанов разговоры о Cloud Computing поутихли и сегодня не так уж много практических подвижек в этой области – тем более, в Украине.

Происходит это в основном потому, что использование чего-либо, приближающегося к Big Data, в облаке требует таких затрат на хранение и перемещение данных, что они могут превысить выгоды от удаленного компьютинга. Хайдекер сослался на прецедент потокового сервиса цифровых музыкальных записей Spotify, который, промучившись пару лет, в конце концов решил построить собственное локальное (on-premises) облако.

Еще одна цитата: «Облако имеет смысл, когда вы не можете предсказать свою загрузку данных или свои требования к производительности системы. Но как только у вас есть предсказуемая рабочая нагрузка, и вы можете легко оценить, в каких ресурсах будете нуждаться, облако становится гораздо менее привлекательным».

Хайдекеру вторит Роб Розен (Rob Rosen), руководитель направления Big Data в компании Pentaho (open source provider of reporting, analysis, dashboard, data mining and workflow capabilities), который сказал, что «Облако – великолепное место для прототипирования и построения концепта архитектуры. Но как только все заработало и объемы данных и вычислений начинают увеличиваться, компании начинают получать ежемесячные счета, которые заставляют их сказать – эй, обождите, может, пора перенести все это на свою площадку»?

То же касается In-memory Database. Эта технология привлекла большое внимание за счет рекламируемых выгод быстрой работы (fast performance), упрощенной инфраструктуры (simplified infrastructure) и требований к потребляемой мощности (power requirements).

Вопросы появляются, когда речь заходит о поддержке аварийного восстановления (support for disaster recovery), высокой доступности (high availability), имеющемся наборе инструментов для работы с базой данных (database tooling), и создании команды разработки приложений.

Согласно Gartner, положение существенно не изменится в следующие два-пять лет, а возможно и более, в зависимости от используемой СУБД. Платформа SAP HANA, Aerospike, акселератор IBM BLU для DB2, Microsoft SQL Server 2014, разработки Oracle – все это до сих пор окончательно не вышло из бета-стадии.

Другие технологии, связанные с Big Data и отраженные в гипоцикле, включают SQL-интерфейсы Hadoop и Internet of Things, которые сейчас подбираются к пику дутых ожиданий, и несколько разновидностей social analytics, которые стремительно опускаются во впадину разочарований.

Тем не менее, согласно Gartner, латентный период созревания целого ряда технологий, связанных с Big Data, относительно скоро закончится и в последующие несколько лет следует ожидать существенных изменений и перекраивания рынка.

Поэтому, не умаляя значения направления, хочется сделать следующие выводы:

- Учитывая неопределенное состояние технологий, связанных с Big Data, в Украине сейчас были бы полезнее не маркетинговые мероприятия (что мы наблюдаем и текущей осенью), а семинары по изучению соответствующих продуктов и «лучших практик» внедрения в различных отраслях.

- Более предметный разговор о преимуществах и недостатках Big Data следовало бы перенести на год-два, когда, скорее всего, и определятся области для использования «больших данных» в украинских реалиях.