| 0 |

|

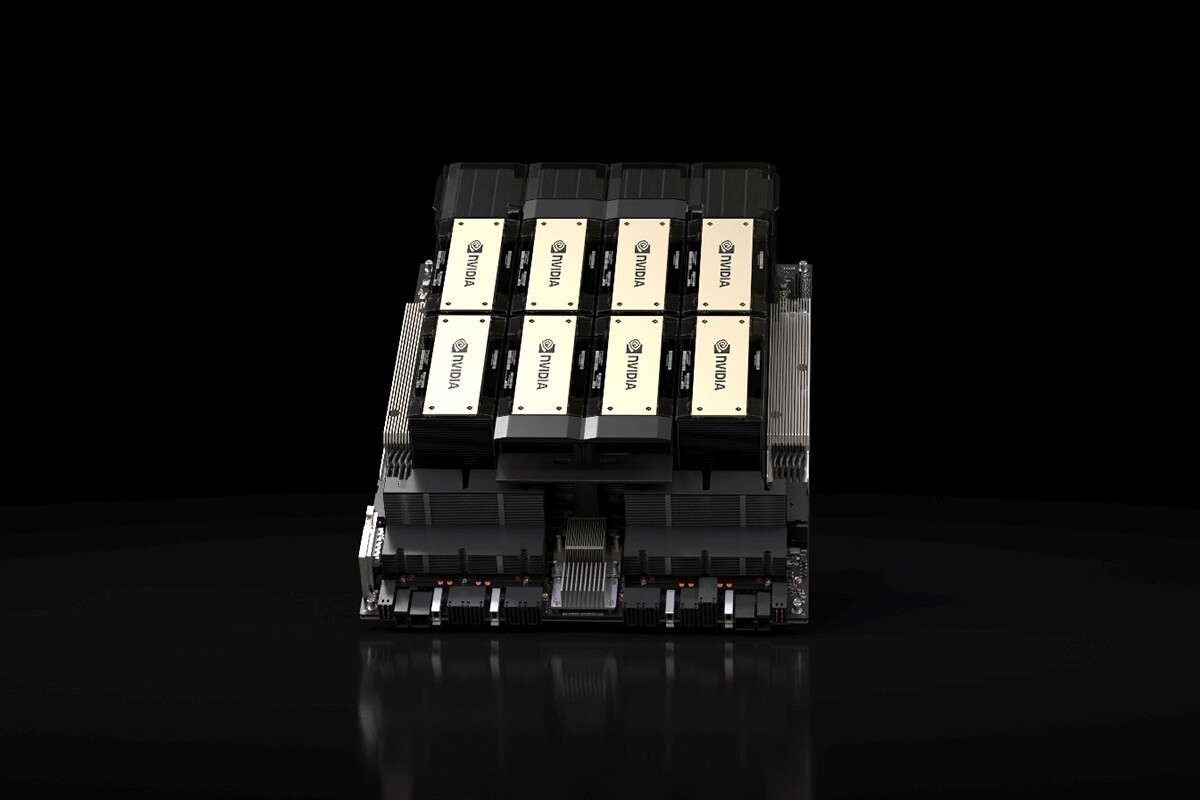

У рамках участі в конференції SC2023, компанія Nvidia анонсувала платформу HGX H200, що базується на архітектурі Nvidia Hopper та оснащена графічним процесором H200 Tensor Core з передовою пам'яттю для роботи з величезними об'ємами даних для виконання завдань генеративного AI та високопродуктивних обчислювальних навантажень.

Заявлено, що Nvidia H200 - це перший GPU з HBM3e - швидшою пам'яттю для прискорення генеративного AI та великих мовних моделей, а також для розвитку наукових обчислень у високопродуктивних обчислювальних системах. Завдяки HBM3e Nvidia H200 забезпечує 141 ГБ пам'яті зі швидкістю 4,8 ТБ/с, що майже вдвічі більше за об'ємом та у 2,4 раза більше за пропускною спроможністю, порівняно з його попередником Nvidia A100.

"Для створення інтелекту за допомогою генеративного AI та HPC-застосунків необхідно ефективно обробляти величезні обсяги даних на високій швидкості за допомогою великої та швидкої GPU-пам'яті", - сказав Ян Бак (Ian Buck), віцепрезидент із гіпермасштабування і HPC у Nvidia. "З Nvidia H200 провідна в індустрії наскрізна суперкомп'ютерна платформа для AI стала ще швидшою для вирішення найважливіших завдань у світі".

Зазначається, що архітектура Nvidia Hopper забезпечує безпрецедентний стрибок продуктивності порівняно зі своєю попередницею і продовжує підіймати планку завдяки постійним програмним покращенням H100, включно з нещодавнім випуском бібліотек з відкритим вихідним кодом, таких як Nvidia TensorRT-LLM.

Впровадження H200 призведе до подальшого зростання продуктивності, включно з майже дворазовим збільшенням швидкості обчислень на Llama 2, LLM із 70 мільярдами параметрів, порівняно з H100. Додаткове лідерство в продуктивності й поліпшення в H200 очікуються в майбутніх оновленнях ПЗ.

Nvidia H200 буде доступна в серверних платах HGX H200 з чотирьох- і восьмиканальною конфігурацією, які сумісні як з апаратним, так і з програмним забезпеченням систем HGX H100. Ця платформа також доступна в суперчипі NVIDIA GH200 Grace Hopper з HBM3e, анонсованому в серпні.

Завдяки цим опціям H200 може бути розгорнута в будь-якому типі ЦОД, включно з локальними, хмарними, гібридними та граничними. Глобальна екосистема партнерів Nvidia - виробників серверів, включно з ASRock Rack, ASUS, Dell Technologies, Eviden, GIGABYTE, Hewlett Packard Enterprise, Ingrasys, Lenovo, QCT, Supermicro, Wistron і Wiwynn - може оновити свої наявні системи за допомогою H200.

Amazon Web Services, Google Cloud, Microsoft Azure та Oracle Cloud Infrastructure стануть одними з перших постачальників хмарних послуг, які почнуть розгортати інстанси на базі H200 з наступного року, а також CoreWeave, Lambda і Vultr.

Заявлено, що завдяки високошвидкісним міжз'єднанням Nvidia NVLink і NVSwitch HGX H200 забезпечує найвищу продуктивність під час виконання різноманітних прикладних робочих навантажень, включно з навчанням і виведенням LLM для найбільших моделей, що перевищують 175 млрд параметрів.

Восьмиканальний HGX H200 забезпечує понад 32 PFLOPS обчислень FP8 для глибокого навчання і 1,1 ТБ сумарної пам'яті з високою пропускною спроможністю для найвищої продуктивності в генеративних застосунках AI та HPC.

У парі з процесорами NVIDIA Grace з надшвидким інтерфейсом NVLink-C2C H200 утворює суперчип GH200 Grace Hopper з HBM3e - інтегрований модуль, призначений для роботи з додатками HPC і AI гігантського масштабу.

Платформа прискорених обчислень Nvidia підтримується програмними інструментами, які дають змогу розробникам і підприємствам створювати та прискорювати готові до виробництва додатки від AI до HPC. До їх числа входить набір програм Nvidia AI Enterprise для таких робочих навантажень, як мова, системи рекомендацій і гіпермасштабні висновки.

Платформа NVIDIA H200 буде доступна у світових виробників систем і постачальників хмарних послуг із другого кварталу 2024 року.

Стратегія охолодження ЦОД для епохи AI

| 0 |

|