|

СПЕЦІАЛЬНІ ПАРТНЕРИ ПРОЕКТУ BEST CIOОпределение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях Человек годаКто внес наибольший вклад в развитие украинского ИТ-рынка. Продукт годаНаграды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары |

Ничто не забыто

Автор – Андрій Кухар, 8 февраля 2013 г.

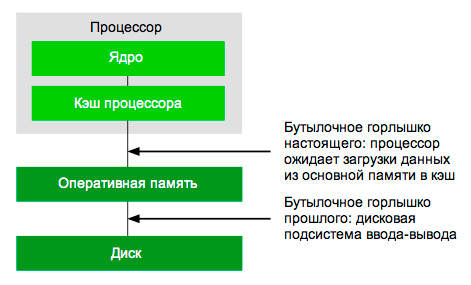

Тематика бизнес-аналитики вот уже который год продолжает оставаться одной из самых обсуждаемых в ИТ-индустрии. Самой «горячей» из современных аналитических технологий выступает хранение данных в оперативной памяти (in-memory BI, английский язык лапидарнее русского). Скорости радиНе будет преувеличением сказать: основной причиной того, что средства in-memory BI снискали популярность, выступает их исключительно высокая скорость работы. С точки зрения производительности, главное бутылочное горлышко традиционных BI-приложений — медленные диски или еще более медленный доступ к СУБД, в сотни раз уступающие скорости RAM-доступа (если говорить более точно: типичный промышленный сервер оснащается памятью со скоростью доступа как минимум 6400 MБ/c, это в 64 раза превышает скорость чтения жесткого диска и в 100 и более раз выше скорости дисковой записи). Если приложение по сути очень быстрое, ему не требуются сложные структуры данных для дальнейшей оптимизации. Даже простые, малопроизводительные in-memory-программы, как правило, быстрее хорошо оптимизированных дисковых программ. При разработке и развитии ПО это обстоятельство позволяет существенно экономить ресурсы. Именно сравнительная легкость создания и гибкость in-memory BI — сильнейшие стороны данной концепции.

Архитектура современной вычислительной системы Слабая сторона данной модели кроется в насущной потребности обеспечивать хранение данных максимально компактно. Недопустимо просто загружать сведения в основную память, не заботясь об эффективности их размещения, необходимо тщательно продумывать и реализовывать алгоритмику компрессии. Наиболее проработанные in-memory-системы используют меньше пространства под данные, чем СУБД с традиционной архитектурой хранения. Как правило, здесь используются алгоритмы сжатия, позволяющие достигать 5-10-кратного уровня сжатия. Прошлое, которое стало будущимИзвестно, что подстегнули распространение этой концепции два фактора: удешевление чипов памяти и появление На первый взгляд,

Самая популярная программа анализа данных Microsoft Excel всегда была построена с использованием in-memory-архитектуры Поэтому настоящим толчком к популяризации in-memory-технологий на поверку оказались резко падающие цены на память. Благодарить нужно азиатскую полупроводниковую индустрию c ее крупными инвестициями в производством чипов памяти. И вызваны они были отнюдь не потребностями отрасли бизнес-аналитики, а растущим потребительским спросом на электронные устройства со всем большим объемом памяти. Так что волна интереса и потребления in-memory-технология исходит не от инноваций в сфере разработки ПО бизнес-назначения, а гонкой за гигабайты на рынке потребительских аппаратных средств. Ощутите разницу (pdf): в 2000 г. 1 ГБ памяти можно было приобрести за 1 тыс. долл., уже в конце прошлого года этот же объем стоил... $2, а по прогнозу в 2015 г. его цена будет $0,5, в 2018 г. — $0,06, в 2021 г. — $0,03, в 2024 г. — $0,008, в 2027 г. — $0,001, в 2030 г. — $0,0003. Для сравнения в прошлом году 1 ГБ серверной дисковой памяти обошелся бы в $0,1-0,15. Любопытно, что средства бизнес-аналитики, использующие для размещения данных основную память, появились раньше использующих дисковые системы решений (по всей видимости, из-за того что in-memory ПО легче разрабатывать). Первым средством многомерного анализа можно считать интерактивный матричный язык программирования и интегрированную среду разработки APL (A Programming Language на базе математической нотации Айверсона), появившийся в Ни для кого не секрет, что по-настоящему массовым BI-средством является Microsoft Excel (к слову, названный приложением прошлого десятилетия), а ведь данная программа всегда была построена на in-memory-архитектуре. Как и ее почивший в

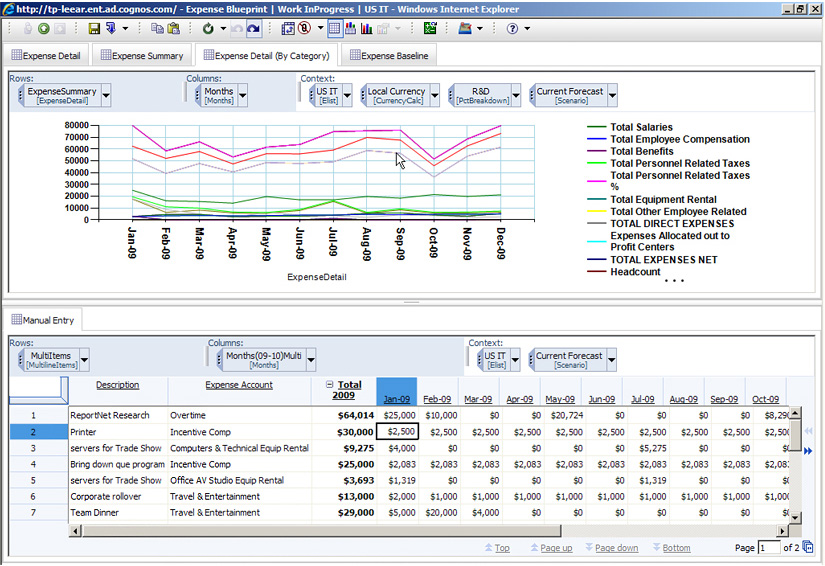

Старейший BI-продуктом, сохранившим свою in-memory-сущность, является Cognos TM1, так сложилось, что он и старейший BI-инструмент вообще Старейшим BI-продуктом, до настоящего времени сохранившим свою in-memory-сущность (чистый in-memory OLAP-движок), является IBM Cognos TM1, так сложилось, что он и старейший BI-инструмент вообще. На наш взгляд, было бы некорректно в рамках рассматриваемой темы обсуждать in-memory СУБД, поскольку лишь их подкласс ориентирован на решение задач бизнес-аналитики. К тому же они явно заслуживают отдельной статьи (она будет предложена читателям КО в скором времени). Здесь лишь отметим, что и в этой сфере пионером был Голубой Гигант, и продукт компании — иерархическая СУБД и система управления информацией IMS/VS с технологией Fast Path (pdf) — датируется 1976 г. Одним словом, и в контексте in-memory-CУБД можно смело говорить о том, что под луной оказалось опять хорошо забытое старое, которое становится будущим. Остаться должен только один?Разработчикам необязательно выбирать одну архитектуру хранения данных. Ничто не мешает поставщику ПО с применением дисковой системы добавить in-memory-вариант, например, как это сделала SAP, предложив поддержку HANA для своей BI-платформы SAP NetWeaver Business Warehouse. Либо же использовать большие кэши данных в оперативной памяти для оптимизации дисковой производительности, подобную схему приняла на вооружение Oracle, выпустив In-Memory Database Cache. Разумеется, решения, спроектированные и оптимизированные под чистые in-memory-архитектуры будут по скорости превосходить дисковые системы с кэшированием, поскольку в последних останутся медленные операции перемещения данных и избыточные операции индексирования. В то время как в ПО с применением дисков применяют кэширование, in-memory-продукты при нехватке основной памяти автоматически используют виртуальную память (диски). А еще есть сравнительно доступная FLASH-память (SSD), это постоянное хранилище, как и дисковые системы, но с более быстрым временем отклика, ее можно эксплуатировать вместо дисковой памяти без необходимости в серьезной модернизации ПО. Ее в качестве кэша применяет в частности компания Oracle в своем аппаратно-программном комплексе Exadata (технология Exadata Smart Flash Cache). И этот вариант хранения данных еще больше путает картину.

Не все in-memory-технологии одинаково полезны Различия между двумя архитектурными подходами нередко имеются лишь в теории, на практике же они сосуществуют, и часто в рамках одного решения и даже одного приложения. И это оправданно, ведь серебрянных пуль не бывает, in-memory-технологии не панацея. Есть случаи, когда они в чистом виде вообще технически не применимы. Скажем, для мультитерабайтных хранилищ данных сегодня все же не обойтись без традиционной архитектуры с многоэтапными ETL-процедурами и витринами данных. Тем не менее, с учетом продолжающегося падения цен на оперативную память, in-memory-технологии будут все более популярны. По версии, недавно озвученной экспертами Gartner, — уже к 2014 г. 30% аналитических приложений будут использовать in-memory-средства для ускорения вычислительных процедур. Новые горизонтыПо мнению отраслевых экспертов, следующим прорывом в области in-memory BI будет «раскрытие» потенциала многоядерных процессорных архитектур. Сегодня эксплуатируются серверные CPU с восемью (например, Intel Xeon E5-4620) и шестнадцатью ядрами (AMD Opteron 6366 HE, Oracle SPARC T3), но в будущем число ядер будет расти. И технологии работы in-memory BI должны быть оптимизированы для задействования всех ядер и эффективной работы с памятью, ведь бутылочное горлышко производительности теперь располагается между кэшем процессора и оперативной памятью. Еще одна богатая на возможности развития BI-технологий сфера — использование GPU-ускорителей. По скорости обработки данных они могут превосходить универсальные процессоры в десятки и даже сотни раз (уже есть примеры в научных вычислениях). Соответствующие исследовательские проекты ведутся на протяжении последних нескольких лет (в том числе в HP Laboratories, pdf), все идет к тому, что в скором времени за ними последуют и коммерческие предложения, которые позволят существенно ускорить выполнение требующих интенсивных вычислений задач бизнес-аналитики. Стратегія охолодження ЦОД для епохи AI

Читайте также

|

Останні обговоренняТОП-новости

ТОП-блогиТОП-статьи

|

||||||||||