| 0 |

|

Обчислювальний стартап Cerebras Systems запустив, як він стверджує, найшвидший у світі сервіс виводів AI, який уже доступний у хмарі.

Під виведенням AI розуміють процес прогону живих даних через навчену AI-модель для складання прогнозу або вирішення завдання. Служби висновків, за даними Cerebras, - це сегмент, що найшвидше зростає, на який сьогодні припадає близько 40% усіх робочих AI-навантажень у хмарі.

Однак наявні сервіси штучного інтелекту, схоже, не задовольняють потреб усіх клієнтів. «Ми спостерігаємо всілякий інтерес до того, як зробити висновок швидше і за менші гроші», - сказав головний виконавчий директор Cerebras Systems Ендрю Фельдман (Andrew Feldman). За його словами, компанія має намір домогтися цього за допомогою своїх нових послуг «високошвидкісного виведення». Він вважає, що запуск цього сервісу є переломним моментом для індустрії AI, заявляючи, що швидкість у 1000 токенів на секунду, яку він може забезпечити, порівнянна з появою свого часу широкосмугового інтернету, що відкриває нові можливості для AI-додатків.

Cerebras є виробником спеціалізованих і потужних комп'ютерних чипів для AI і високопродуктивних обчислень (HPC). За останній рік вона не раз потрапляла в заголовки газет, стверджуючи, що її чіпи не тільки потужніші за графічні процесори Nvidia, а й економічно ефективніші. «Це продуктивність, недосяжна для GPU», - заявив співзасновник і головний технічний директор компанії Шон Лі (Sean Lie).

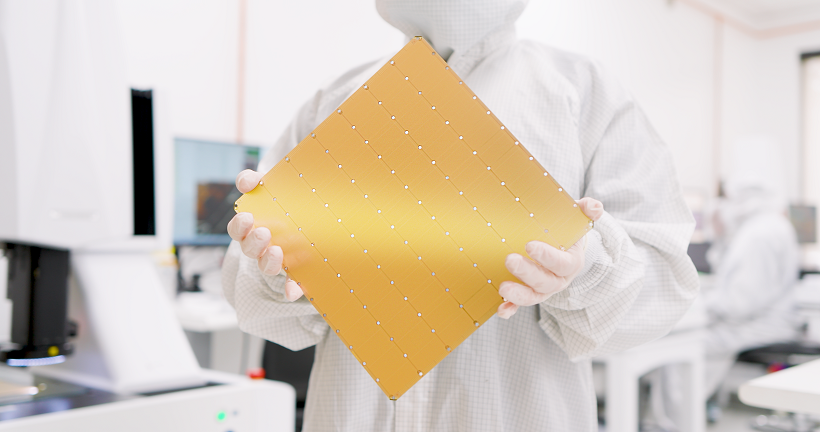

Флагманським продуктом компанії є новий процесор WSE-3, анонсований у березні та створений на основі більш раннього чипсета WSE-2, який дебютував у 2021 р. Він побудований за передовим 5-нанометровим техпроцесом і має на 1,4 трлн транзисторів більше, ніж його попередник, більше ніж 900 тис. обчислювальних ядер і 44 ГБ вбудованої статичної пам'яті з довільним доступом. За даними стартапу, WSE-3 має в 52 рази більше ядер, ніж один графічний процесор Nvidia H100.

Чип доступний у складі пристрою для центрів обробки даних під назвою CS-3. Сам чіп поставляється з вбудованими модулями охолодження і живлення. Що стосується продуктивності, то Cerebras WSE-3, як стверджується, удвічі потужніший за WSE-2 і здатний досягти пікової швидкості в 125 петафлопс.

Система Cerebras CS-3 - це рушій, на якому працює новий сервіс Cerebras Inference, і в ній у 7 000 разів більше пам'яті, ніж у GPU Nvidia H100, що дає змогу розв'язати одну з основних технічних проблем генеративного AI: необхідність у більшій пропускній здатності пам'яті.

Сервіс Cerebras Inference, як стверджується, працює у 20 разів швидше, ніж аналогічні хмарні сервіси, що використовують найпотужніші GPU Nvidia. За даними Cerebras, він забезпечує 1800 токенів за секунду для моделі Llama 3.1 8B з відкритим вихідним кодом і 450 токенів за секунду для Llama 3.1 70B.

За словами стартапу, вартість послуги становить лише 10 центів за мільйон токенів, що в 100 разів перевищує продуктивність для робочих навантажень, пов'язаних із виведенням даних AI.

Компанія додає, що сервіс Cerebras Inference особливо добре підходить для робочих навантажень «агентного AI», або AI-агентів, які можуть виконувати завдання від імені користувачів, оскільки таким додаткам необхідна можливість постійно підказувати свої базові моделі.

Міка Хілл-Сміт (Micah Hill-Smith), співзасновник і виконавчий директор незалежної компанії Artificial Analysis з аналізу моделей AI, заявив, що його команда перевірила, що Llama 3.1 8B і 70B, яка працює на Cerebras Inference, досягає «якісних результатів оцінювання» відповідно до рідної 16-бітної точності в офіційних версіях Meta. «Завдяки швидкості, яка розширює межі продуктивності, і конкурентоспроможній ціні, Cerebras Inference особливо привабливий для розробників AI-додатків, які працюють у режимі реального часу або вимагають великих обсягів», - сказав він.

Клієнти можуть вибрати три рівні доступу до сервісу Cerebras Inference, включно з безоплатною пропозицією, яка надає доступ на основі інтерфейсу програмування застосунків і широкі обмеження на використання для тих, хто хоче поекспериментувати з платформою.

Рівень для розробників призначений для гнучких безсерверних розгортань. Доступ до нього здійснюється через кінцеву точку API, яка, за словами компанії, коштує в рази менше, ніж альтернативні сервіси, доступні сьогодні. Наприклад, ціна Llama 3.1 8B становить лише 10 центів за мільйон токенів, а Llama 3.1 70B - 60 центів. За словами компанії, підтримка додаткових моделей уже на підході.

Існує також корпоративний рівень (Enterprise Tier), який пропонує моделі з тонким налаштуванням і призначені для користувача угоди про рівень обслуговування зі спеціалізованою підтримкою. Він призначений для тривалих робочих навантажень і може бути доступний через керовану Cerebras приватну хмару або реалізований на місці. Cerebras не розкриває вартість цього конкретного рівня, але каже, що ціни надаються за запитом.

Cerebras заявляє про дивовижний список клієнтів із раннім доступом, серед яких такі організації, як GlaxoSmithKline, стартап Perplexity AI, що спеціалізується на AI-пошуку, і постачальник програмного забезпечення для мережевої аналітики Meter. Доктор Ендрю Нг (Andrew Ng), засновник DeepLearning AI, ще одного з ранніх користувачів, розповів, що його компанія розробила кілька робочих процесів агентного AI, які вимагають неодноразового звернення до LLM для отримання результату. «Cerebras створила напрочуд швидку здатність до висновку, яка буде дуже корисна для таких робочих навантажень», - зазначив він.

Амбіції Cerebras на цьому не обмежуються. За словами Фельдмана, компанія «веде переговори з кількома гіперскейлерами» про пропозицію своїх можливостей у їхніх хмарних сервісах. «Ми хочемо мати їх як клієнтів», - сказав він, а також таких спеціалізованих постачальників AI, як CoreWeave і Lambda.

Крім сервісу для обробки висновків, Cerebras також оголосила про низку стратегічних партнерств, щоб надати своїм клієнтам доступ до всіх спеціалізованих інструментів, необхідних для прискорення розробки AI. Серед її партнерів такі компанії, як LangChain, LlamaIndex, Docker, Weights & Biases і AgentOps.

Cerebras заявила, що її Inference API повністю сумісний з Chat Completions API від OpenAI, що означає, що наявні додатки можна перенести на її платформу за допомогою лише кількох рядків коду.

Стратегія охолодження ЦОД для епохи AI

| 0 |

|