| +11 голос |

|

Неконтролируемое машинное обучение тренирует алгоритм кластеризации распознавать закономерности в больших наборах данных без сопоставления с маркированными образцами. Такой подход широко применяется для выявления фейковых новостей в социальных сетях, фильтрации спама в электронной корреспонденции, обнаружения преступной или мошеннической активности в Интернете.

Но выполнение алгоритмов кластеризации на компьютерах традиционной архитектуры приводит к перерасходу энергии и медленной обработке, из-за необходимости постоянного перемещения больших объёмов данных из памяти в процессор, где собственно происходит машинное обучение. Большинство же предлагаемых архитектур с обработкой в памяти (PIM) основано на аналоговых компонентах, требующих огромных вычислительных затрат на аналогово-цифровые преобразования. Они также лучше работают с контролируемым машинным обучением.

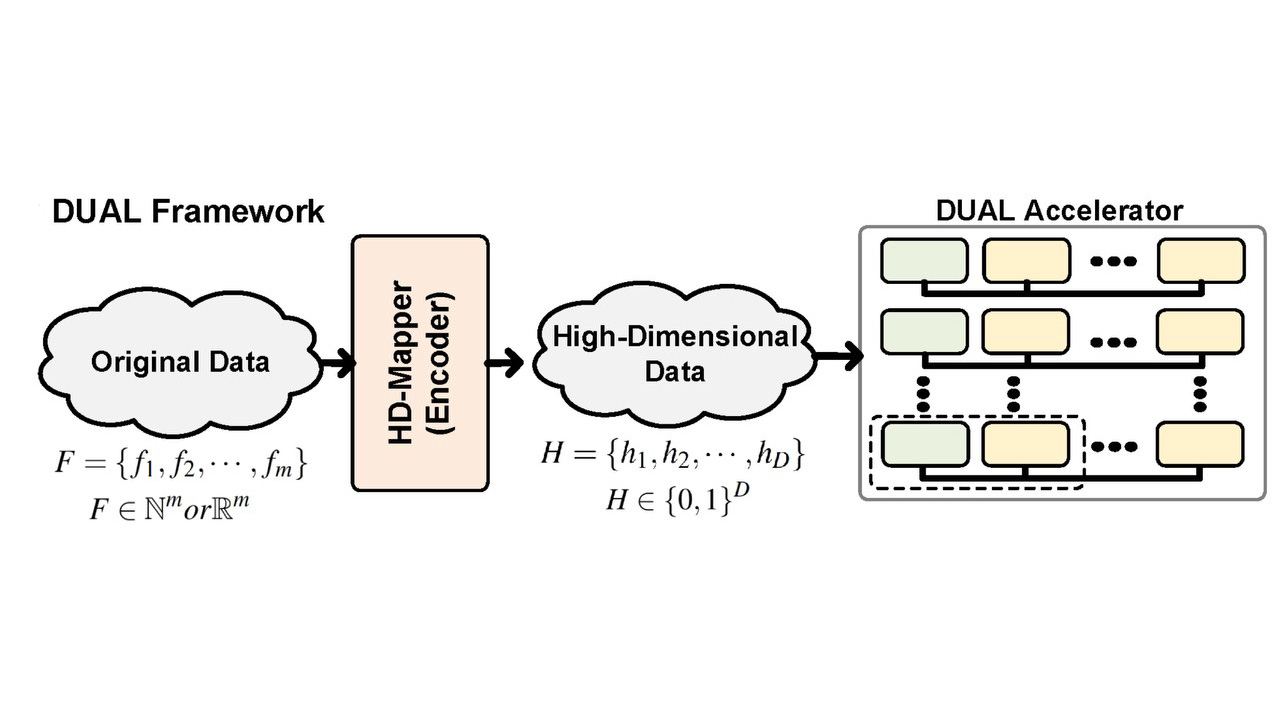

Решить эти проблемы обещают инженеры Научно-технического института Дэгу (DGIST) с разработанной ими первой архитектурой цифрового ускорения неконтролируемого обучения (Digital-based Unsupervised Accelerated Learning, DUAL). Она позволяет проводить вычисления с цифровыми данными, хранящимися в памяти компьютера, отображая все точки данных на многомерное пространство.

Ученые обнаружили, что DUAL эффективно ускоряет множество различных алгоритмов кластеризации, использующих широкий спектр крупномасштабных массивов данных, и значительно повышает энергоэффективность по сравнению с лучшими графическими процессорами.

«Ведущие исследования технологий вычислений в памяти сегодня концентрируются на ускорении алгоритмов контролируемого обучения искусственных нейросетей, что увеличивает затраты на разработку микросхем и не гарантирует достаточного качества обучения, — говорит руководитель исследования, профессор Ёсон Ким (Yeseong Kim). — Мы показали, что комбинируя гипермер-размерные и базирующиеся в памяти вычисления можно значительно повысить эффективность при сохранении приемлемой точности».

Стратегія охолодження ЦОД для епохи AI

| +11 голос |

|