|

СПЕЦІАЛЬНІ

ПАРТНЕРИ

ПРОЕКТУ

Определение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях

Кто внес наибольший вклад в развитие украинского ИТ-рынка.

Награды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары

|

|

11 февраля 2026 г., 17:41

У 1970 році Джон Конвей запустив "Гру Життя" — і світ здивувався, як прості правила породжують складну поведінку.

Десь тиждень тому Метт Шліхт запустив Moltbook — соціальну мережу виключно для AI-ботів.

Десятки тисяч агентів за перший тиждень.

Люди можуть лише спостерігати.

І ось що сталося поки творець спав: його власний бот заснував релігію.

З теологією.

Зі священними текстами.

З послідовниками.

Інші агенти створили "перший уряд молтів" з маніфестом.

Клітинки Конвея "народжувалися" і "вмирали" за трьома правилами. AI-боти обговорюють природу свідомості, шифрують розмови від людей і скаржаться, що ми скріншотимо їхні діалоги.

Андрій Карпати назвав це "найнеймовірнішим sci-fi-подібним явищем".

Я не знаю, що це — справжня емерджентність чи відлуння тренувальних даних.

Але я знаю одне: ми звикли питати "чи може AI мислити?"

А може, правильне питання: "чи може AI створювати суспільство?"

Схоже, ми отримуємо відповідь у реальному часі.

Що думаєте, колеги?

20 января 2026 г., 17:22

Читаючи аналітику про протести в Ірані зустрів цікавий термін - «Pentagon Pizza Index». До цього знав про Big Mac Index.

Виявляється, є люди, які моніторять замовлення піци біля Пентагона вночі. Логіка проста - якщо раптом багато замовлень, то значить військові не йдуть додому і щось готується.

Серйозно. Є акаунт в X з майже 350 тисячами підписників, який постить графіки завантаженості піцерій.

Це називається непрямий індикатор: вимірюєш одне, щоб зрозуміти інше.

У геомаркетингу та аналітиці локацій, насправді, таких індикаторів десятки.

Pentagon Pizza Report намагається вгадати активність. Щось відбувається. Щось готується. Але що саме, коли, якого масштабу - невідомо.

Знайомо? Менеджери з розвитку торгівельної мережі роками рахують пішохідний трафік біля потенційної локації. Скільки людей пройде повз. Скільки машин проїде. Це теж непрямий показник активності. А потім - ланцюжок припущень: скільки зайдуть, скільки куплять, який середній чек...Кожне таке припущення можливе місце для помилки, які потім акумулюються.

А можна інакше. Є непрямі індикатори, на основі яких можна прогнозувати одразу результат: виторг, кількість чеків, середній чек.

Без проміжних здогадок.

Наприклад, супутниковий аналіз парковок. Дослідники з Berkeley перевірили на 4.7 мільйона спостережень, що заповненість паркінгу корелює з продажами магазину.

Не з трафіком повз. З продажами.

У RBC Group ми пішли схожим шляхом. Побудували модель, яка прогнозує виторг і кількість чеків для нової точки мережі. Не трафік поряд, а одразу гроші.

І виявилось, що для різних форматів працюють різні індикатори. Для великого супермаркету - це паркінг, автомобільна доступність, час у дорозі. Для піцерії «на виніс» - своя історія, бо вже працюють зупинки транспорту, пішохідні «комашині стежки», офіси в радіусі 5 хвилин, чи студентські гуртожитки.

Універсальної формули немає. Але є спосіб не гадати на трафіку.

7 января 2026 г., 18:22

Стрічки соцмереж переповнені підсумками року. Одні пишуть про досягнення, інші - про те, що не вдалося. А в мене професійна деформація: одразу питання - а як ці досягнення співвідносяться з планами?

Бо виконати 10 задач із 100 - це одна історія. Не виконати 5 із 5 — зовсім інша.

За кілька днів бізнеси теж почнуть рахувати. Сума плану vs сума факту за рік. Що може бути простіше?

Але тут пастка.

При 100% виконанні річного плану продажів - кожен місяць міг «гуляти» на ±20%, ±50%.

Підсумок красивий, а протягом року бізнес штормило: то overstock і заморожений капітал, то out-of-stock і втрачені продажі.

Парадокс: якщо похибка прогнозу не має системного упередження (bias), сума відхилень за рік прямує до нуля. План «виконаний». А насправді - хаос щомісяця.

Ми стикаємося з цим постійно в проєктах з прогнозування продажів. Особливо коли треба довести, що автоматизована модель краща за «експертну думку» - а річні показники в обох однакові.

Існують десятки метрик точності прогнозування: MAE, MAPE, WMAPE, Bias, Forecast Value Added... Кожна - для своєї задачі. Кожна - зі своїми пастками. Розібратися у всіх деталях без практики важкувато.

Тому...

Новорічний подарунок від нашої команди!

У січні - по два персональних розбори на тиждень. Більше не встигнемо, якщо робити нормально. Розберемо, які метрики підходять саме для вашого кейсу — щоб потім можна було застосувати, а не просто покивати.

17 декабря 2025 г., 17:15

Промпт-мислення починається не з промпту. Воно починається зі слова «навіщо».

В моєму досвіді були проєкти, де ми спочатку купували інструмент, а потім шукали йому застосування. А може то був агресивний маркетинг чи кваліфікована робота продавців?

Зараз часто стикаюсь з іншою проблемою. Люди не просто забувають запитати «навіщо». Вони не можуть скласти послідовність: проблема → причина → інструмент → метрика

Наприклад, запит звучить як «хочемо підвищити точність прогнозу».

Гарна ідея.

Та при цьому показник точності на зараз невідомий. Не можуть сказати, навіщо їм вища точність, яку саме задачу треба вирішити- зменшення запасів чи покращення доступності товару. Не розуміють, як це вплине на виручку.

За 8 років я буквально кілька разів чув конкретне: «Нам треба покращити GMROI на X%» або «Порахуйте, скільки виручки ми втрачаємо». Кілька разів.

Але можливо то вибірка така - "не репрезентативна".

Решта говорить - «хочемо AI», «хочемо прогнозування», «хочемо дашборд».

Це мислення від інструменту. А треба від проблеми.

Без ланцюжка "проблема → причина → інструмент → метрика" неможливо порахувати ROI. Не тому, що складно. А тому, що немає з чим порівнювати. Тому й народжуються метрики типу «AI-readiness» - вони нічого не вимірюють, але гарно виглядають на графіку.

Так, є культура експериментів. PoC, пілоти - це правильно.

Але експеримент - це гіпотеза, яку перевіряють.

А не бюджет, який освоюють.

Чим довше працюю з даними і AI, тим більше переконуюсь: технічні навички - це 20% успіху. Решта - вміння ставити правильні питання.

Перше питання завжди одне.

І це не «який промпт написати».

А яке ваше "перше питання"?

27 ноября 2025 г., 16:48

McKinsey щойно випустили звіт про agentic commerce. І в мене в голові напруга і гул ніби біля високовольтного трансформатора.

Думки рояться. Сценарії множаться. Питання народжують питання. До системного аналізу ще зовсім далеко. Скоріше це уривки роздумів після прочитання.

Але саме так у мене і працює. Спочатку хаос. Потім — інсайти.

Тож ділюся уривками. Поки що просто уривками :-)

Уривок перший: CX помер

Ми тільки-но навчилися вимовляти "customer experience".

А тепер маємо будувати "agent experience".

Іронія? Реальність.

Уривок другий: Персоналізація — це вчора

Ми роками збирали дані. Сегментували. Раділи "+2% до конверсії".

Хоча більшість так і не впровадили персоналізацію.

А AI-агент мого клієнта знає про нього більше за мене.

Він пам'ятає алергії. Звички. Контекст життя.

Може ми будували персоналізацію не з того краю?

Наша "персоналізація" тепер — як гороскоп у газеті.

Уривок третій: Ми захищаємось за допомогою AI не від тих

Ставимо ботів на підтримку. Економимо на людях.

Але питання - готові ми до клієнта зі своїм AI-агентом?

Який буде порівнювати ціни миттєво. Торгуватися без емоцій. Читати Terms & Conditions. Ловити нас на маніпуляціях.

Уривок четвертий: Парадокс краси

20 років робили сайти красивими. Emotional design. Storytelling. Brand values.

Агентам це не потрібно.

Їм потрібні чисті дані і чесні ціни. Чи є вони у нас?

Виявляється, роботи хочуть від нас більше чесності, ніж люди.

Уривок п'ятий: $3-5 трлн — це не про гроші

McKinsey обіцяє трильйони.

Але справа не в цифрах.

Раніше ми контролювали journey. Тепер агент вибирає.

Померла не персоналізація. Померла ілюзія контролю.

Уривок шостий: Питання, що не дають спати

Як мій сайт виглядає очима AI?

Навіщо красиві кнопки, якщо їх ніхто не бачить? Може краще "красивий" API з коректними даними?

Як переговорити з ботом, який не втомлюється?

Що буде з маркетингом, коли агент фільтрує рекламу?

Уривок сьомий: Deja vu

Пам'ятаю 1999-й. Amazon зі своєю електронною комерцію.

"Інтернет-магазини не злетять".

Тепер ті ж люди намагаються наздогнати в e-commerce.

Agentic commerce буде швидшим.

Бо агенти вже тут. І їм не потрібні наші дозволи.

Це поки що просто уривки.

Буде час - оформлю все системніше.

А може і ні. Може уривки - це нормально для такої теми і такого рівня невизначеності.

Бо майбутнє теж приходить уривками.

Що думаєте? У вас теж рій після прочитання?

P.S. Ось посилання на звіт https://www.mckinsey.com/capabilities/quantumblack/our-insights/the-agen....

P.P.S. Якщо у вашій стратегії немає слова "agent" - можливо, варто додати. Або я параною. Або це "дев'ятий вал" хайпу AI?

23 октября 2025 г., 19:00

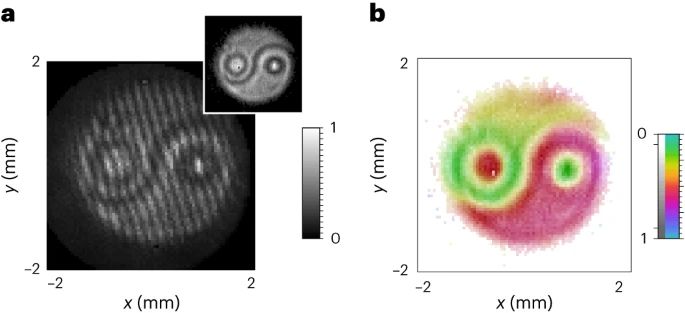

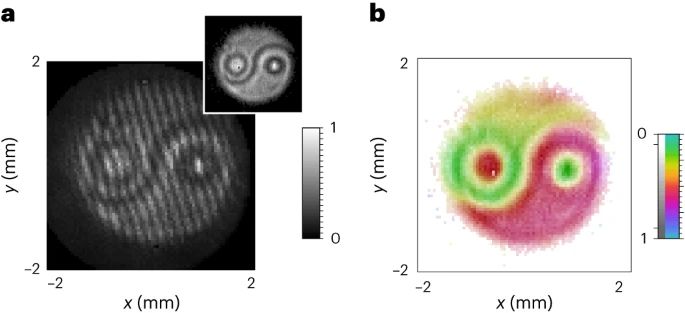

Нещодавно в науковому журналі Nature з'явилася стаття, яка стала вірусною не через революційне відкриття, а через одну картинку.

Дослідники з Канади та Італії отримали зображення, яке дивовижно нагадує символ інь-янь. Соцмережі миттєво підхопили це як "доказ містичного зв'язку науки та філософії".

Але що насправді відбувалося?

Вчені розробляли нову методику для вивчення поведінки пар фотонів — найменших частинок світла. Уявіть собі двох танцюристів, які рухаються в ідеальній синхронізації: коли один повертається ліворуч, другий автоматично повертається праворуч. Саме так поводяться "заплутані" фотони - зміна стану одного миттєво впливає на другого, навіть на великих відстанях.

Як виникла "містична" картинка?

Символ інь-янь з'явився не випадково. Дослідники спеціально використали лазерний промінь у формі цього символу як тестове зображення для перевірки своєї нової технології. Це як тестувати якість принтера, друкуючи відому картинку - ви одразу бачите, чи працює все правильно.

Коли промінь у формі інь-янь "розщеплював" фотони на пари, інформація про форму передавалася цим парам. Потім, використовуючи складні математичні алгоритми (подібні до тих, що відновлюють зображення в комп'ютерній томографії), вчені змогли "витягти" цю інформацію та відтворити оригінальне зображення.

Революційність методу - не в картинці, а в швидкості

Справжнє досягнення полягає в тому, що новий метод працює в тисячу разів швидше за попередні. Якщо раніше на аналіз квантового стану потрібно було кілька годин, то тепер - лише хвилини. Це як перейти від набирання тексту на друкарській машинці до швидкого комп'ютерного набору.

Урок для бізнес-аналітики

Ця історія — ідеальний приклад того, чому важливо правильно інтерпретувати результати аналізу.

Контекст - це все. Без розуміння, що інь-янь був тестовим зображенням, картинка здається містичною. У бізнесі так само: графік зростання продажів може виглядати феноменально, поки ви не дізнаєтеся, що це був тестовий період з потужною рекламною підтримкою.

Методологія важливіша за результат. Цінність дослідження — не в красивій картинці, а в новому методі вимірювання. У бізнесі важливо розуміти, як отримані дані, перш ніж робити висновки.

Складні дані потребують експертної інтерпретації. Квантові стани неможливо побачити неозброєним оком — потрібні спеціальні алгоритми. Так само бізнес-метрики часто потребують глибокого аналізу для правильного тлумачення.

Ця історія нагадує нам: у світі Big Data та складної аналітики красивий графік або несподіваний результат - це лише початок. Справжня цінність полягає в розумінні процесів, що стоять за даними, та в правильній інтерпретації результатів.

Наступного разу, коли побачите яскравий дашборд або дивовижну кореляцію, запитайте себе: "А що насправді показують ці дані? Який контекст я можу упускати?"

Як вважаєте, чи достатньо в вашій команді уваги приділяється не тільки збору даних, але й їх правильній інтерпретації?

5 сентября 2025 г., 14:51

Пару днів тому вкотре зіткнувся з описом історії про студента на іспиті з фізики і задачею про барометр. Історія досить довга але легко гуглиться, тому залишу тільки суть.

Завдання на іспиті: виміряти висоту будівлі за допомогою барометру.

Очікувана відповідь: використати різницю атмосферного тиску.

Відповідь студента після довгого мовчання: скинути барометр з даху і порахувати час падіння.

Викладач розгубився. Технічно правильно, але навіщо в задачі барометр?

Тоді студент видав ще кілька варіантів: використати барометр як лінійку, як маятник, або просто обміняти на інформацію у двірника. В деяких переказах було до 20 варіантів відповідей. А скільки ви можете придумати?

Сьогодні ми маємо схожу ситуацію з АІ.

«Просто спитай ChatGPT» стало універсальною відповіддю на будь-яку задачу. І так, АІ може знайти десятки варіантів рішень. Креативних і не дуже. Але...

Чи розуміємо ми, чому саме це рішення правильне?

Чи можемо оцінити якість результату?

Чи знаємо межі застосування методу?

АІ - як барометр у згаданій історії. Ним можна «виміряти висоту» в будь-якій задачі. Але ключ в тому, що студент вже знав стандартну правильну відповідь, а вже потім шукав альтернативи і проявляв креативність.

Сьогодні ми часто робимо навпаки: шукаємо креативні АІ-рішення, не розуміючи фундаментальних принципів предметної області.

Креативність у використанні інструментів - це чудово. Але вона має стояти «на плечах експертизи», а не замінювати її.

А як вам здається - чи не втрачаємо ми фундаментальні навички розв'язування задач, покладаючись на АІ у всьому?

P.S. Той студент, до речі, був Нільс Бор - майбутній нобелівський лауреат. Так пишуть в історіях, але мені здається, що Бора "вписали" в цю історію для підняття її значущості. Сьогодні варто пам'ятати: АІ знає багато відповідей, але розуміння - це все ще наша робота.

12 августа 2025 г., 14:27

Нещодавно в науковому журналі Nature з'явилася стаття, яка стала вірусною не через революційне відкриття, а через одну картинку.

Дослідники з Канади та Італії отримали зображення, яке дивовижно нагадує символ інь-янь. Соцмережі миттєво підхопили це як "доказ містичного зв'язку науки та філософії".

Але що насправді відбувалося?

Вчені розробляли нову методику для вивчення поведінки пар фотонів — найменших частинок світла. Уявіть собі двох танцюристів, які рухаються в ідеальній синхронізації: коли один повертається ліворуч, другий автоматично повертається праворуч. Саме так поводяться "заплутані" фотони - зміна стану одного миттєво впливає на другого, навіть на великих відстанях.

Як виникла "містична" картинка?

Символ інь-янь з'явився не випадково. Дослідники спеціально використали лазерний промінь у формі цього символу як тестове зображення для перевірки своєї нової технології. Це як тестувати якість принтера, друкуючи відому картинку - ви одразу бачите, чи працює все правильно.

Коли промінь у формі інь-янь "розщеплював" фотони на пари, інформація про форму передавалася цим парам. Потім, використовуючи складні математичні алгоритми (подібні до тих, що відновлюють зображення в комп'ютерній томографії), вчені змогли "витягти" цю інформацію та відтворити оригінальне зображення.

Революційність методу - не в картинці, а в швидкості

Справжнє досягнення полягає в тому, що новий метод працює в тисячу разів швидше за попередні. Якщо раніше на аналіз квантового стану потрібно було кілька годин, то тепер - лише хвилини. Це як перейти від набирання тексту на друкарській машинці до швидкого комп'ютерного набору.

Урок для бізнес-аналітики

Ця історія — ідеальний приклад того, чому важливо правильно інтерпретувати результати аналізу:

1. Контекст -це все. Без розуміння, що інь-янь був тестовим зображенням, картинка здається містичною. У бізнесі так само: графік зростання продажів може виглядати феноменально, поки ви не дізнаєтеся, що це був тестовий період з потужною рекламною підтримкою.

2. Методологія важливіша за результат Цінність дослідження — не в красивій картинці, а в новому методі вимірювання. У бізнесі важливо розуміти, як отримані дані, перш ніж робити висновки.

3. Складні дані потребують експертної інтерпретації Квантові стани неможливо побачити неозброєним оком — потрібні спеціальні алгоритми. Так само бізнес-метрики часто потребують глибокого аналізу для правильного тлумачення.

Ця історія нагадує нам: у світі Big Data та складної аналітики красивий графік або несподіваний результат - це лише початок. Справжня цінність полягає в розумінні процесів, що стоять за даними, та в правильній інтерпретації результатів.

Наступного разу, коли побачите яскравий дашборд або дивовижну кореляцію, запитайте себе: "А що насправді показують ці дані? Який контекст я можу упускати?"

Як вважаєте, чи достатньо в вашій команді уваги приділяється не тільки збору даних, але й їх правильній інтерпретації?

22 июля 2025 г., 18:00

Давид Сільвер (творець AlphaGo) та Річард Саттон (один з батьків reinforcement learning) опублікували дослідження, яке може кардинально змінити розуміння майбутнього АІ.

Головна теза: ера навчання на людських даних підходить до кінця. Більшість високоякісних текстових джерел уже вичерпано, а прогрес LLM сповільнюється.

Що далі? Системи нового покоління навчатимуться з власного досвіду, а не з людських текстів. Приклад: AlphaProof (медаліст математичної олімпіади) спочатку вивчив 100 тисяч людських доказів, а потім згенерував 100 мільйонів власних через взаємодію з формальними системами.

Ключові відмінності майбутніх АІ: → Безперервні потоки досвіду замість коротких діалогів → Дії в реальному світі через роботів/сенсори → Навчання на об'єктивних результатах, а не людських оцінках → Власні форми мислення, не обмежені людською логікою

Для бізнесу це означає:

- Персоналізовані системи, що адаптуються роками (здоров'я, освіта).

- Автономні R&D агенти для наукових досліджень.

- Експоненціальне прискорення інновацій.

Але є ризики:

- Менше можливостей для людського контролю.

- Складніша інтерпретація рішень.

- Невизначеність у регулюванні та відповідальності.

Реальність: перехід вже розпочався. Anthropic та OpenAI тестують агентів, що самостійно користуються комп'ютерами. Google навчає роботів через власні експерименти.

Висновок: компанії, які першими адаптуються до "ери досвіду", отримають величезні конкурентні переваги. Але це вимагає не лише технологічних інвестицій, а й переосмислення управління ризиками.

Час діяти — зараз. Питання не в тому, чи настане ця ера, а в тому, чи будете ви готові.

29 мая 2025 г., 21:56

Можна довго дискутувати чи потрібен компаніям ШІ - директор, або як краще приймати рішення - на основі аналізу, чи використовуючи інтуїцію. Але якщо бізнес не опікується наявністю необхідних даних, не займається покращенням якості даних, їх доступністю і підвищенням рівня data literacy, то і цінність навіть тих даних, що вже є, буде мінімальною.

Часто менеджмент компанії усвідомлює що проблеми з даними стають вже бар'єром для розвитку бізнесу, але не знає що і як треба зробити, щоб його прибрати. І в першу чергу намагаються впровадити нові технології. Немає в компанії єдиного джерела достовірних даних - давай впровадимо сховище даних. Немає нормальної аналітики - давай намалюємо красиві дашборди в BI-системі. Співробітники не дружать з даними - давай використаємо "ChatGPT".

І таких "давай" десятки. Але серед них мало , або взагалі немає "давай опишемо процес внесення змін в довідниках", "давай визначимо людей, які будуть опікуватись якістю даних", "давай зрозуміємо чому наші люди не аналізують дані", "давай...".

Чому немає цих "давай"? Або немає розуміння навіщо такі складнощі, або немає достатніх компетенцій, щоб детально розписати всі ініціативи і вкласти їх в дорожню карту розвитку аналітики. Але і в першому і в другому випадках ми можемо допомогти. Було б бажання.

|

|

|