|

СПЕЦІАЛЬНІ

ПАРТНЕРИ

ПРОЕКТУ

Определение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях

Кто внес наибольший вклад в развитие украинского ИТ-рынка.

Награды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары

|

|

4 декабря 2013 г., 16:52

Выбор подходящей модели жесткого диска для высокоемкой и/или производительной системы хранения данных зачастую оказывается непростой задачей даже для IT-специалиста. Несмотря на то, что все производители, включая WD, стараются сделать разделение между линейками продукции как можно более «прозрачным», отличия между ними все равно зачастую неочевидны. Попробуем исправить эту ситуацию.

Принципы разделения линеек HDD

Итак, во-первых, все накопители можно разделить на две больших категории по классу пользователей, для которых они созданы: пользовательские (consumer) и корпоративные (enterprise). Пользовательские HDD проектируются с учетом оптимального сочетания той или иной характеристики (скорости работы или емкости) и цены, в то время как третья важнейшая характеристика — надежность — не является главным приоритетом (хотя, конечно, и над ней ведется серьезная работа). В корпоративных накопителях ситуация обратная: наиболее важна для них именно надежность, т.к. утеря важных коммерческих данных либо простая неработоспособность СХД в течение значительного промежутка времени для компании может стоить очень дорого.

Второй критерий разделения жестких дисков на линейки — это их ориентированность на ту или иную модель применения. Главные среди них — это хранение данных (высокоемкие модели) и производительность. Если посмотреть на линейку накопителей WD, то, соответственно, среди пользовательских моделей это будут WD Green (высокая емкость, низкое потребление и нагрев, низкая цена в пересчете на 1 ГБ) и WD Black (высокая производительность). Среди корпоративных серий их аналоги — это WD Red* и WD Re, соответственно. Однако есть большое число потребителей, которым нужен компромисс между этими характеристиками, потому создаются и «промежуточные» серии, обладающие оптимальным для той или иной модели применения сочетанием емкости и производительности (а для enterprise — и надежности). Это серии WD Blue для десктопных и WD Se для корпоративных линеек.

* WD Red нельзя назвать строго корпоративной серией HDD, т.к. они предназначены и для RAID-массивов в рабочих станциях и NAS класса SOHO, и для домашних ПК с RAID-массивом для хранения данных.

Что же отличает корпоративные серии жестких дисков WD от десктопных?

1) Поддержка TLER (Time Limited Error Correction) — функции, необходимой для корректной работы HDD в RAID-массивах. В случае возникновения задержки при считывании или записи данных на накопитель по какой-либо причине жесткий диск всегда пытается повторить попытку или исправить ошибку, переназначить сектор и т.п. На это время он перестает отвечать на запросы контроллера. В настольном ПК чаще всего эта задержка не критична, и HDD может потратить от нескольких секунд до минут (в зависимости загруженности) без ущерба для работоспособности системы. Однако в RAID-массиве контроллер постоянно следит за состоянием дисков, и в случае отсутствия отклика от HDD в течение определенного промежутка времени он пометит его как «сбойный», а массив либо «рассыплется», либо уйдет в режим перестроения, в зависимости от уровня RAID. Следовательно, установив десктопный HDD в RAID, пользователь рискует работоспособностью массива даже в случае невинных ситуаций вроде термокалибровки диска, когда контроллер попросту не дождется его ответа и пометит накопитель как нестабильный, и RAID распадется. Функция TLER ограничивает время, которое HDD может потратить на исправление ошибок, 7 секундами. Если за это время накопитель не справился — он сообщает о ситуации контроллеру, и вместо того, чтобы отметить весь HDD как нестабильный, будет лишь сделана отметка о необходимости восстановления данных в том или ином секторе массива, без потери работоспособности всего хранилища.

2) RAFF (Rotary Acceleration Feed Forward) — отслеживание вибраций накопителя в нескольких плоскостях и коррекция «на лету». Функция необходима для систем с большим числом HDD, где несколько вибрирующих дисков могут ввести всю дисковую полку или корзину в резонанс и сделать работу нестабильной. В настольных накопителях такой функции либо вообще нет, либо она рудиментарна (отслеживание ускорения в одной из плоскостей для детекции удара или падения и парковка головок).

3) Dual-Stage actuator и контроль высоты полета головок. Первая технология повышает точность и скорость позиционирования блока головок чтения-записи над магнитной дорожкой за счет наличия дополнительного пьезоэлектрического привода на кончике актуатора. Чтобы проиллюстрировать, для чего это нужно, представьте, что вам нужно написать что-нибудь от руки, не двигая ни кистью, ни локтем, а только плечом. Что касается контроля высоты полета головок, то это необходимо для обеспечения оптимального расстояния между ними и магнитной пластиной, независимо от положения диска и температуры (головки парят над пластиной за счет потока воздуха, создаваемого ее вращением). Решение этой проблемы до изумления изящно: на «штанге»-актуаторе, в конце которой закреплены головки, устанавливается нагревательный элемент, который при необходимости подогревает ее, и тепловое расширение корректирует ее форму.

4) Оптимизация внутреннего ПО («прошивки») под конкретный профиль использования: Re — максимальная производительность при доступе к HDD в несколько потоков малыми блоками данных (системы высокой готовности, ERP, CRM, почтовые серверы и т.д.), Se — высокая производительность при работе блоками данных 128 КБ (потоковый режим доступа — файловые хранилища, системы резервного копирования, видеомонтаж и т.п.), Red — оптимизация для сетевого доступа в потоковом режиме (медиасерверы, архивные файловые хранилища). Пользовательские HDD чаще всего оптимизируются под типичную для ПК нагрузку — преимущественно последовательный доступ блоками по 4 КБ, небольшую глубину очереди запросов, и во многих случаях могут работать значительно медленнее даже идентичных с точки зрения механики корпоративных жестких дисков.

5) Более строгий контроль качества — все корпоративные серии проходят более жесткое тестирование на заводе, благодаря чему гарантируется более высокая надежность, в частности, режим работы 24/7 (против 8/5 для пользовательских моделей HDD). Соответственно, для них заявляется большая наработка на отказ (MTBF до 1,4 млн. часов) и предоставляется большая гарантия. Кроме того, эти накопители дают администраторам доступ к значительно большему числу параметров мониторинга SMART, по которым можно оценить состояние устройства и его «здоровье».

Именно за все эти отличия покупатель и платит ту разницу в цене между, скажем, WD Black и WD Re, или между Green и Red.

Итак, обратим внимание на конкретные линейки и посмотрим, какие у них козыри. Для примера возьмем топовые модели емкостью по 4 ТБ:

Как видим, серии Re и Se отличаются скорость вращения шпинделя 7200 об/мин, благодаря чему скорости линейного чтения и записи достигают 171 МБ/с, а время позиционирования головок примерно на треть ниже, чем у Red, пластины в которых вращаются со скоростью 5400 об/мин. Также отметим, что в серии Re алгоритм позиционирования оптимизирован для максимальной скорости, однако за счет этого диски немного больше потребляют, греются и шумят.

У серии Re наибольший показатель надежности — 600 000 циклов парковки головок против 300 000 у других линеек (большая устойчивость к механическому износу) и наработка на отказ 1 200 000 часов в любой модели использования. Для линейки WD Se также гарантируется 1,2 млн часов MTBF, однако только в случае использования в сетевых хранилищах с числом дисковых корзин до 5.

Совокупность этих характеристик делает серии Re и Se оптимальными для высокопроизводительных и высокоемких СХД — Re — с максимальной нагрузкой и надежностью, Se — для чуть менее критичных по этим параметрам.

Наконец, серия Red предназначена именно для долговременного хранения данных во всевозможных сетевых СХД начального уровня, внутренних RAID-массивах и т.п. Благодаря скорости вращения 5400 об/мин они потребляют минимум вдвое меньше, чем «старшие» серии, меньше греются и практически не шумят. При этом их производительности более чем достаточно для подавляющего большинства задач, которые ставятся перед системами хранения, для которых они позиционируются.

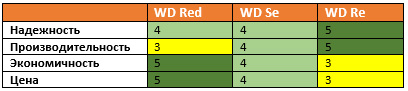

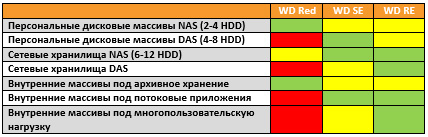

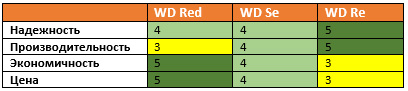

В процессе выбора конкретной серии для построения СХД нужно оценить, какой параметр — надежность, производительность, экономичность (энергопотребление и нагрев) или цена — является наиболее важным, каким можно немного пожертвовать, а какой и вовсе не принципиален. Для наглядности выставим всем трем сериям условные оценки:

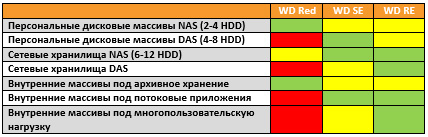

Таким образом, примерный список моделей применения этих серий будет выглядеть следующим образом:

14 октября 2013 г., 10:41

Разговоры о том, что продукты на базе NAND флеш-памяти вытеснят традиционные HDD с рынка, ведутся уже не первый год. Для многих это очевидно, ведь SSD уже получили высокую популярность в сегменте ПК и рабочих станций среднего и высокого уровня, прочно обосновались в ноутбуках и начали свою экспансию на серверный рынок, продажи все растут, розничная стоимость все снижается. Однако так ли радужны их перспективы?

В данный момент твердотельные накопители всевозможных формфакторов, по большому счету, не отбирают рынок у HDD, их появление создало отдельную нишу высокопроизводительных систем хранения данных, и сейчас эта ниша заполняется. Однако ниша высокоёмких СХД куда более обширна, и до тех пор, пока NAND (или ее потомки) не потеряет в себестоимости примерно на порядок, в этот сегмент она проникнуть не сможет. А оснований считать, что это случится, немного.

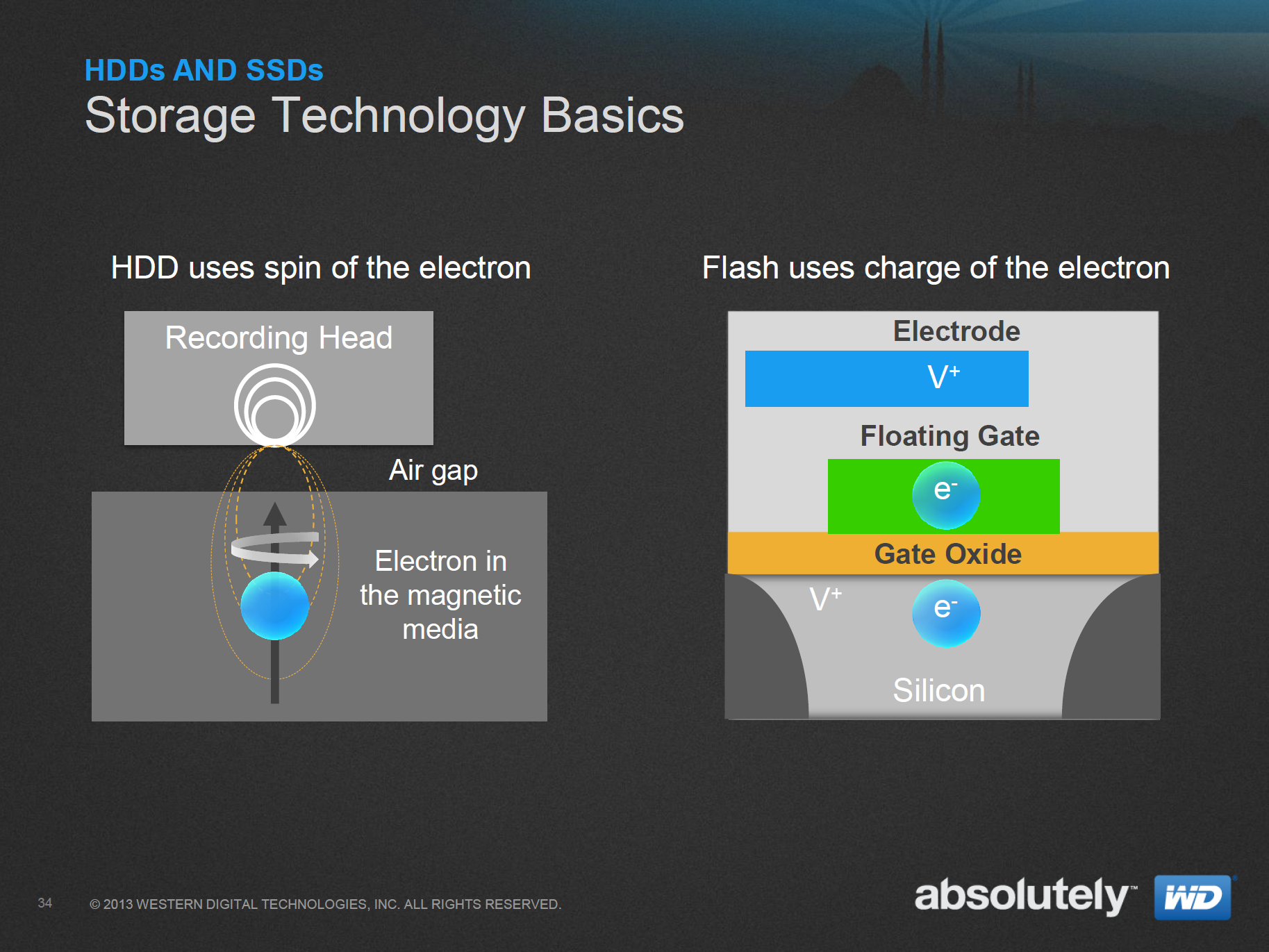

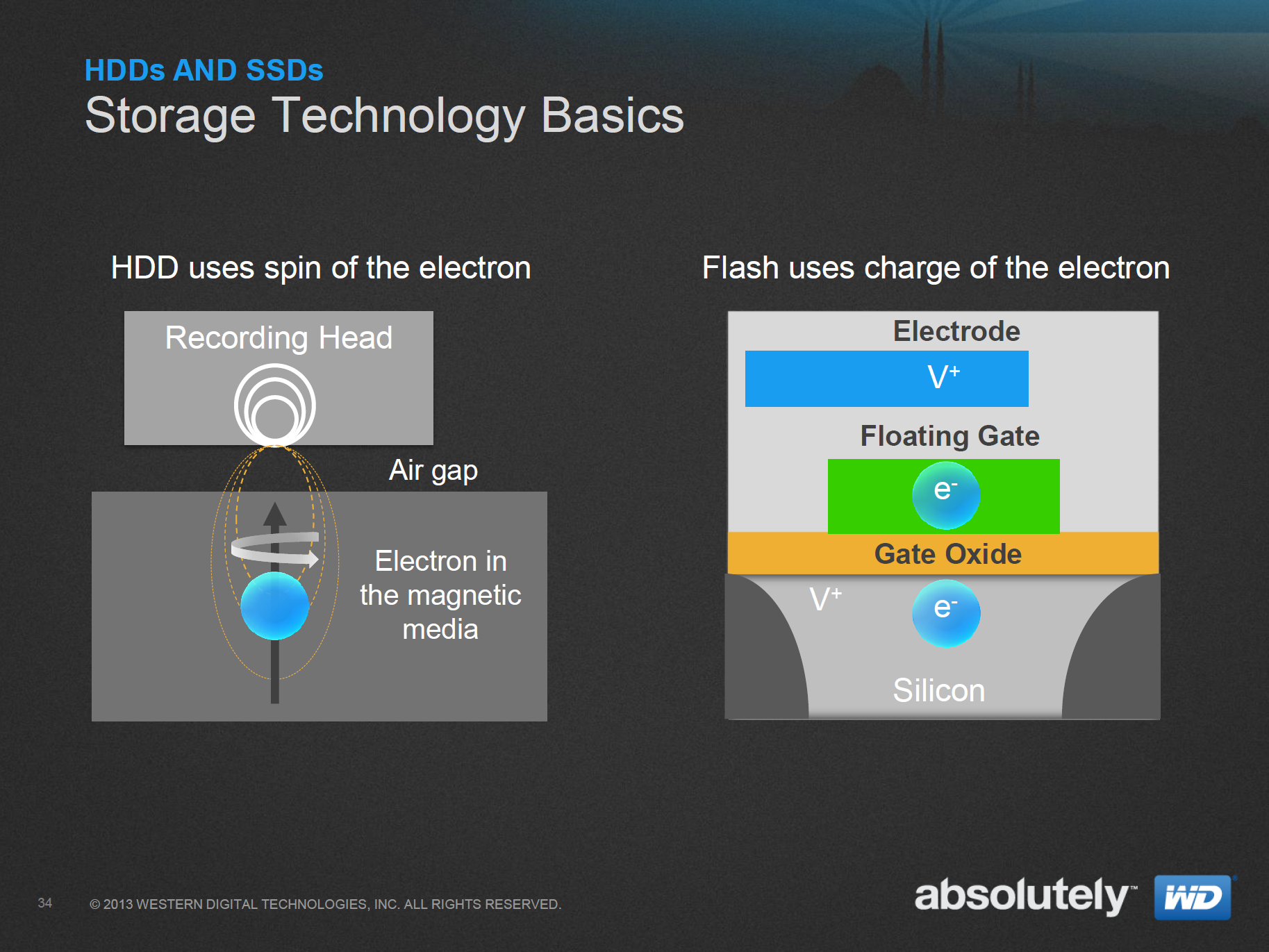

Принцип хранения данных в HDD и SSD

Основная «врожденная» проблема флэш-памяти – ее износ по мере использования. Для хранения данных в ячейке используется заряд электронов, захватываемых транзистором с плавающим затвором. Каждый раз для записи нового бита в ячейку ее нужно сначала стереть, подав напряжение на транзистор, что приводит к постепенному снижению его надежности. Выражается это в том, что в какой-то момент затвор потеряет способность держать заряд, а ячейка, соответственно, станет непригодной для хранения информации. И самая большая проблема, что с эволюционным развитием техпроцессов производства NAND ресурс чипов сокращается, чего большинство разработчиков SSD стараются не афишировать.

С уменьшением физических размеров транзистора он становится более подвержен пробою и утечке хранимого в нем заряда, а подача повышенного напряжения, необходимого для стирания ячейки, «изнашивает» его сильнее. Простой пример: для фактических SSD-первопроходцев на пользовательском рынке – Intel X25-M на базе 34-нм NAND – заявлялся ресурс 10 тыс. циклов перезаписи. Для современных SSD на основе чипов, произведенных по 25-нм техпроцессу, этот показатель составляет 3-5 тыс. циклов. В 2013 г. большинство производителей начали переход на техпроцесс 16 нм, что еще сильнее снизит надежность. Возвращаясь к сравнению с HDD, отметим, что их развитие никак с изменениями надежности не связано.

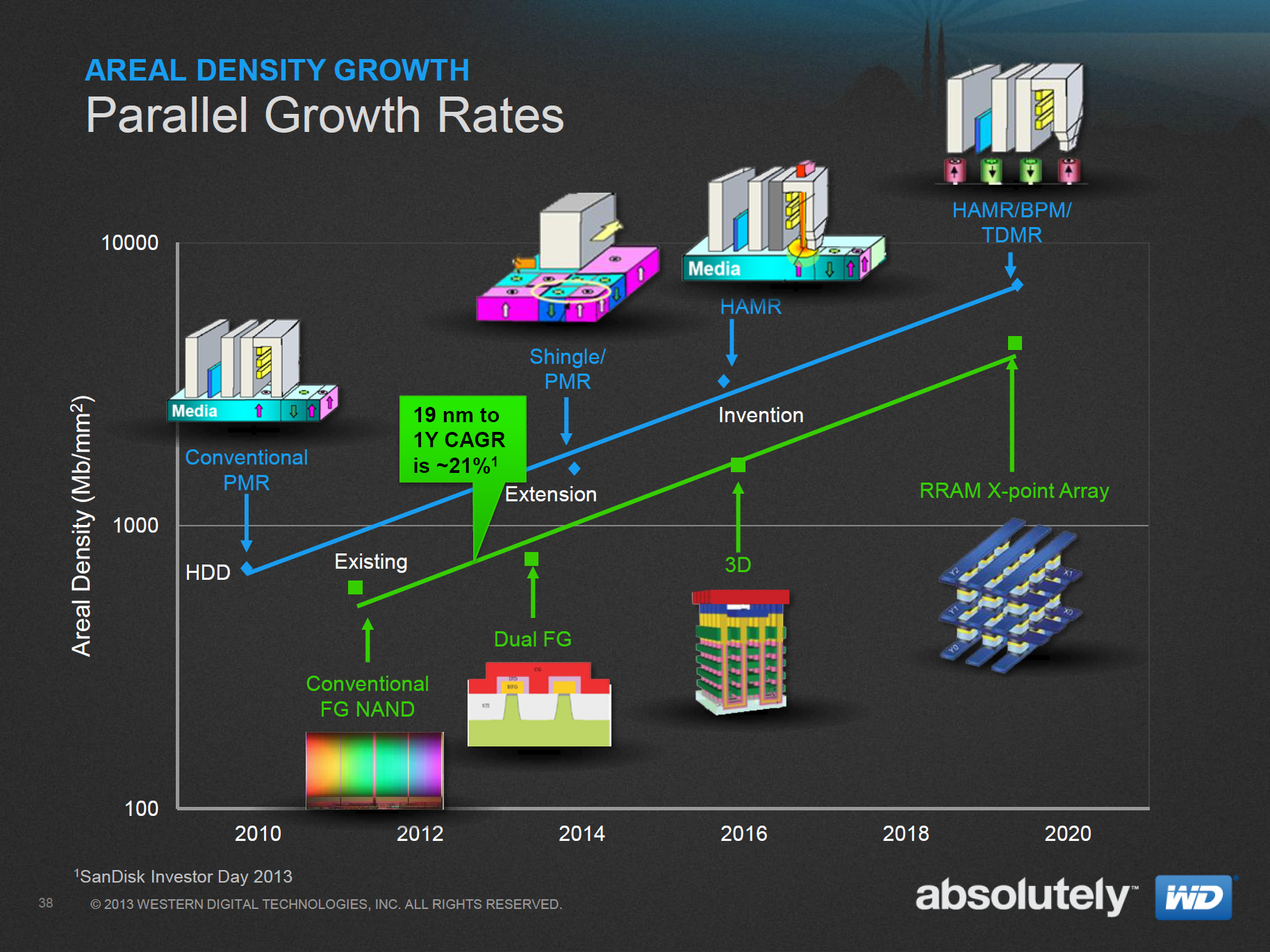

Второй фактор – цена. В настоящее время единственный способ снизить себестоимость чипов NAND-памяти (как и любых других полупроводниковых устройств) – это рост числа работоспособных кристаллов, выходящих из одной кремниевой пластины.

Разница в себестоимости 1 Гб между HDD и SSD колоссальна

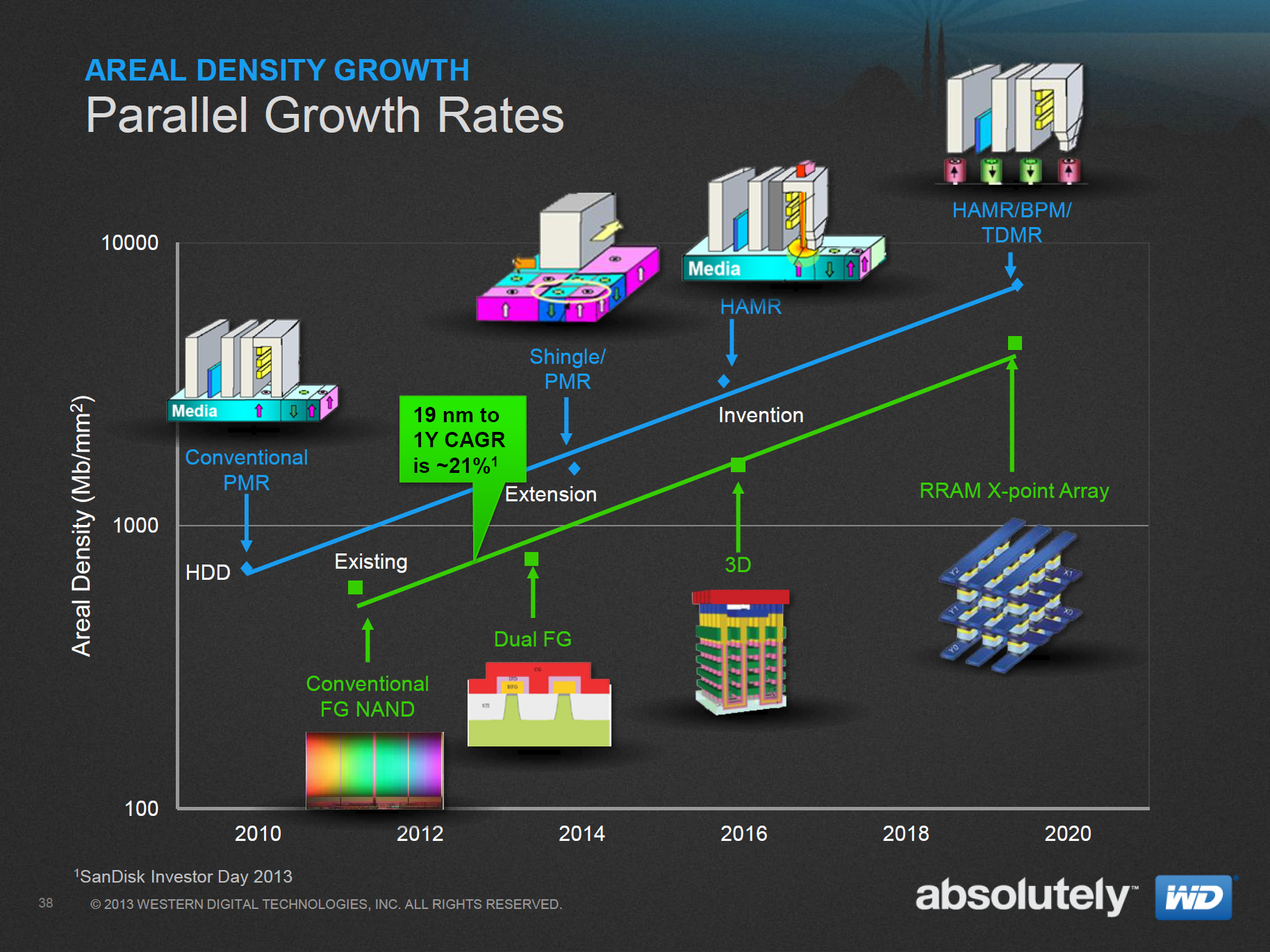

Достигается он двумя способами – уменьшением техпроцесса (больше чипов на каждую пластину) и переходом на пластины большего диаметра. Однако даже переход на пластины диаметром 450 мм и 16 нм техпроцесс себестоимость радикально не снизит, а значит, SSD не смогут побороться с HDD по показателю стоимости гигабайта. В настоящий момент, по данным WD, показатель CAGR (Compound Annual Growth Rate, инвестиционно-аналитический термин, показывающий среднегодовую степень роста и эффективность возврата инвестиции) для HDD составляет 41%, в то время как для 19 нм NAND – около 21%. Значит, и быстрого снижения цены флеш-памяти тоже ждать не приходится.

Производители NAND отмечают, что уже в ближайшее время им придется значительно усовершенствовать технологии производства, чтобы продолжать развитие. Первым шагом (который уже сделали, например, Samsung и Toshiba) будет переход от планарных к трехмерным микросхемам: в кристалле NAND фактически будет «бутерброд» из расположенных слоями друг над другом ячеек памяти. За счет этого им удастся увеличить емкость чипов. Однако как это скажется на надежности, каков процент выхода годных кристаллов, каков объем инвестиций для перехода на 3D-NAND – не афишируется.

Эволюция HDD также непроста – на данный момент производители практически достигли предела плотности записи на пластины с использованием традиционных магнитных головок. Ближайшим шагом вперед станет «черепичная» запись (Shingle Magnetic Recording), которая, по большому счету, будет просто оптимизацией используемой площади пластин, а начало коммерческого использования HAMR (Heat Assisted Magnetic Recording) ожидается лишь через два года.

В итоге, на данный момент нет никаких предпосылок тому, чтобы продукты на базе флеш-памяти сменили HDD в качестве лидирующей технологии на рынке СХД. Снизить на порядок себестоимость производства полупроводниковой продукции за краткие сроки невозможно, т.е. SSD не сравняются по стоимости 1 Гб с HDD. Показатель числа гарантируемых циклов перезаписи без перехода на другие материалы для затворов транзисторов также будет только падать. Так что не стоит пока хоронить HDD – перспективы их развития как раз более оптимистичны, хоть и развиваются они не так стремительно.

4 ноября 2009 г., 22:35

Предлагаю заинтересованным ознакомиться с видеозаписями с семинара компании Adaptec, прошедшего 1 октября при участии Entry.

Файлы разбиты соответственно темам, будет выложен практически полный семинар, за исключением вырезанных несущественных моментов.

Сразу оговорюсь, что видеомонтажер из меня "так себе", радикально улучшить качество видео и особенно звука (прямо перед камерой стоял пьедестальный сервер с очень шумным БП) мне не удалось.

Сейчас залиты на сервер две части, чуть позднее будут еще две (Vimeo ограничивает объем 500 МБ в неделю, остальные хостинги или неудобны, или ограничены по времени записи).

P.S. [Тарас Олейник]: На данном семинаре, проведенном лишь среди довольно узкого круга ИТ-специалистов, Adaptec рассказывала о перспективах применения SSD для модернизации уже существующих систем хранения данных корпоративного уровня, а показывала собственное решение, MaxIQ, использующее производительный SSD для кэширования запросов на чтение. Выигрыш в производительности, по исследованиям компании, может достигать, ни много ни мало, четырех-пяти раз(!) -- при довольно небольших затратах на саму модернизацию.

Детальнее об этом в частности и о перспективах SSD в СХД вообще -- в отчетах о тестировании, проведенном самой компанией (на русском языке):

28 октября 2009 г., 12:42

У гиков-любителей хардвера зачастую и развлечения гиковские. Я, например, довольно давно интересуюсь разнообразными проектами распределенных вычислений, начиная от "for fun"-инициатив вроде distributed.net, взламывающих подбором алгоритмы шифрования, до поиска внеземных цивилизаций в SETI@Home и молекулярной биологии (Folding@Home и аналоги), и даже предварительным этапом Storage@Home - проекта распределенного файлового хранилища для научных данных. Начиналось это увлечение примерно в то же время, когда появился более-менее стабильный и регулярный доступ к Интернет для получения и отдачи заданий, то есть во времена Athlon на ядре Thunderbird. Тогда, помнится, я прикладывал недюжинные усилия, разгоняя процессор ради пары-тройки миллионов ключей в секунду, вычисленных в distributed.net, а уж массовое появление двуядерных CPU стало манной небесной.

Скриншот просмотрщика GPU-клиента Folding@Home, подойдет и в роли скринсейвера :)

Через несколько лет я полностью переключился на Folding@Home, тем более что в этом проекте активно развивается поддержка GPGPU, позволяющая считать силами видеокарты. В частности, лето позапрошлого года было переломным: вышел клиент для NVIDIA CUDA, разом обошедший по производительности существовавший уже вариант для ATI Stream вдвое, о CPU и SMP-клиентах и говорить не приходится. Естественно, такой разрыв в производительности при том, что "голое" быстродействие GPU канадского разработчика превышает показатели NVIDIA, вызывает недоумение. Разработчики Folding@Home объясняют это явление тем, что CAL (Compute Abstraction Level) - дополнительная промежуточная стадия в AMD Stream, обеспечивающая низкоуровневый доступ к GPU, вносит значительные задержки. Кстати, забавный факт: Stream базируется на Brook+ - оптимизированной AMD версии языка программирования Brook, разработанного в Стенфордском университете, специалисты которого разработали и сам Folding@Home.

С другой стороны, очевидна заинтересованность и поддержка NVIDIA в проекте: если со стороны AMD наиболее заметная активность - это включение дистрибутива F@H в пакет драйверов Catalyst, то калифорнийцы выделили несколько специалистов для непосредственной работы над GPU-клиентом F@H. Например, на форуме техподдержки и обсуждения F@H у них можно получить ответы на вопросы, консультации и т.п.

В любом случае, соотношение сил в этом отдельно взятом проекте сейчас далеко не в пользу AMD: Radeon HD 4890 нарабатывает в сутки 3500-3700 ppd (points per day, условных очков, которыми оцениваются посчитанные задания), а GeForce GTX 285 - более 7500 ppd. Такая ситуация сохраняется уже больше двух лет, и я уже практически поставил крест на использовании Radeon для распределенных вычислений.

Логотип Distributed.net (клиент зрелищностью не блещет)

Каково же было удивление, когда на днях из интереса я заглянул на сайт с бета-версиями клиентов distributed.net и, увидев там варианты для Stream и CUDA, попробовал оба. Результаты, прямо скажем, ошеломили: в этом проекте все с точностью до наоборот. GeForce GTX 275 у меня демонстрирует около 300 млн. ключей в секунду, "двуглавый" GTX 295 - примерно 530 млн., а Radeon HD 4890 - обеспечивает те же 500 млн. с одного ядра! Конечно, это не в 2.5 раза быстрее, как в предыдущем проекте, но все равно впечатляет. А сейчас установленный в стенд Radeon HD 5870 "молотит" больше миллиарда ключей в секунду, благодаря чему я за сутки в 8 раз обошел показатели товарища, нагрузившего SMP-клиентами один "скромный" вычислительный центр (в свободное время, естественно). И это на неоптимизированном ядре, которое R800 вовсе не знает.

В связи с этим возникает логичный вопрос: как так получается? Folding@Home разрабатывается при активном участии NVIDIA, потому успехи этой архитектуры логичны. С другой стороны, distributed.net пишут энтузиасты без какой-либо поддержки (разве что консультации) со стороны обоих вендоров, и обе ветки (CUDA и Stream) развиваются практически параллельно. Как же так? Distributed.net проще? В таком случае CAL еще сильнее бы замедлял работу, не успевая "кормить" GPU задачами. Может, CUDA уделяют мало внимания? Нет, различных вычислительных ядер под CUDA насчитывается 9, а под Stream - всего 2.

Создается впечатление, что налицо лобби, хотя со стороны специалистов Стенфорда это было бы нелогичным, как-никак они в первую очередь заинтересованы в общем быстродействии распределенной сети, в том числе и на базе чипов ATI. Пахнет политикой :) Наверное, AMD больше внимания уделяет серьезным коммерческим проектам вроде продуктов Cyberlink, Adobe и т.п.?

6 октября 2009 г., 20:35

Fujitsu и Toshiba завершили процесс передачи контроля над подразделением жестких дисков первой в пользу второй. Напомню, что в начале этого года японские корпорации анонсировали сделку, которая способна перетасовать многие карты на рынке HDD: приобретение Toshiba бизнеса накопителей Fujitsu "забесплатно", а точнее за погашение операционных долгов, на тот момент составлявших около 60 млн. долларов. Правда, пока у Fujitsu остается около 20% акций, но они будут проданы японскому гиганту позднее.

Кстати, судя по всему, теперь уже бывший игрок "большой тройки" на рынке серверных жестких дисков был не слишком заинтересован в плавном и беспроблемном переносе своей линейки под бренд Toshiba. Помнится, когда готовилась тема номера по накопителям SAS, именно Fujitsu оказалась единственным вендором, не проявившим заинтересованности в участии. Видимо, идея в том, что Toshiba не будет пользоваться готовым модельным рядом, а примется за разработку собственных устройств.

Таким образом, остается лишь два игрока рынка HDD, обладающих полным ассортиментом устройств от десктопных до серверных - Hitachi и Seagate. Однако им может оказаться непросто: мощностей у Toshiba куда больше, чем у Fujitsu, с жесткими дисками она также не новичок (наработок в области устройств малого формфактора и высокой емкости, равно как и опыта в их производстве и продвижении ей не занимать). Кто знает, вдруг через год-другой она сможет угрожать гегемонии Seagate?

30 сентября 2009 г., 18:35

Сегодня в Сан-Хосе откроется конференция NVIDIA GPU Technology Conference, на которой компания будет рассказывать о новых решениях для обработки графики и высокопроизводительных вычислениях на основе GPU и обсуждать перспективные проекты. Для интересующихся будут реализованы веб-трансляции. Расписание следующее:

- Wed. Sept 30 - 1:00 PM to 2:30 PM (по Киеву – 30 сент. 23:00 – 00:30): Opening Keynote with Jen-Hsun Huang, CEO and Co-Founder, NVIDIA

- Wed. Sept 30 – 3:00 PM to 4:15 PM (по Киеву – 1 окт. 01:00 – 02:15) : General Session on Important Trends in Visual Computing;

- Wed. Sept 30 – 4:30 PM to 5:45 PM (по Киеву – 1 окт 02:30 – 02:45): General Session on Breakthroughs in High performance Computing

- Thurs. Oct 1 – 9:00 AM to 10:30 AM (по Киеву – 1 окт 19:00 – 20:30): Day 2 Keynote with Hanspeter Pfister, Professor and Computing Visionary, Harvard University

- Fri. Oct 2 – 8:30 AM to 10:00 AM (по Киеву - 2 окт 18:30 – 20:00): Day 3 Keynote with Richard Kerris, CTO, Lucasfilm

Полный список мероприятий и участников конференции можно увидеть тут, там же находятся и ссылки на трансляции. Доклады очень даже интересные, по крайней мере первый (на котором, скорее всего, будет показан новый акселератор NVIDIA GF300), третий и пятый :)

29 сентября 2009 г., 19:34

В статье о ноутбуке Fujitsu с внешним графическим акселератором, использующим технологию AMD eXternal Graphics Platform, я сокрушался о том, что "Зеленая стрела" оказалась крайне пассивной по поводу собственной очень перспективной технологии. Напомню, что XGP, позволяющая подключать к ноутбуку внешний модуль с мощной видеокартой и дополнительными контроллерами (USB, eSATA, Wi-Fi, что угодно) была представлена летом 2007 года вместе с платформой AMD Puma.

Технология вызвала живой интерес прессы по всему миру, однако так и осталась фактически концептом, воплотившись лишь в Fujitsu Amilo Sa3650. Однако, как оказалось, крест на ней все же не поставили.

Выясняется, что новый нетбук Acer Ferrari One на платформе AMD Congo, будет использовать второе поколение XGP, и покупатель будет иметь возможность за дополнительную плату приобрести внешний ускоритель к нему, названный DynaVivid Graphics Dock. Внутри корпуса, по странному дизайнерскому решению выполненного в черном цвете, установлен чип ATI Mobility Radeon HD 4670. Также он предоставит 6 портов USB и выходы HDMI и D-Sub.

Благодаря этой конфигурации нетбук может стать полноценным домашним медиацентром: двухъядерного процессора Athlon X2 L310 с частотой 1,2 ГГц, 2 ГБ оперативной памяти и встроенного Radeon HD 3200 вполне хватит для Windows 7, при этом нетбук снабжен звуковым кодеком с поддержкой Dolby Home Theatre 3 и контроллером 802.11n. Внешний ускоритель способен выводить видео с разрешением до 2048x1536 через HDMI и перенаправлять туда же аудиопоток, поддерживается кодирование HDCP. Радует и цена: около $500 за нетбук (что немного, учитывая конфигурацию) и $199 за DynaVivid Graphics Dock.

Короче говоря, комплект очень интересный, и я с нетерпением жду его появления. Надеюсь, его путь от производителя до нашего Тестлаба займет не два года, как это было с предыдущей инкарнацией XGP.

25 сентября 2009 г., 3:59

Пост жуткой ненависти.

Как уже, наверное, все знают, вчера представили Radeon HD 5800. У нас стараниями компании AMD с одной стороны и Тимура Ягофарова с другой вовремя оказался семпл 5870-й модели, и в следующем номере выйдет его обзор. Если мне повезет.

Дело в том, что драйвер для этой видеокарты пока существует лишь в бета-версии. И никто не додумался в ту же папку на FTP, где он лежит, положить список багов. А среди них есть абсолютно прелестная вещь: кроме Radeon HD 5800, никакая другая карта с этой версией драйвера работать не способна. Либо все сразу же красочно рассыпается артефактами - цветными точками, как при переразгоне, повреждении ядра или VRM, либо попросту в произвольном месте (в том числе и в 2D) изображение заменяется залитым странным цветом "детской неожиданности" экраном, причем ОС продолжает работать. Я уж грешным делом подумал, что служивший верой и правдой Palit Radeon HD 4870 Sonic помер и заменил его аналогом от ASUS, но картина там ровно та же.

А теперь самое приятное: я уже 3 часа пытаюсь эти драйвера удалить и поставить Catalyst 9.9. Штатный деинсталлятор радостно рапортует об удалении, но после перезагрузки проблемы остаются, а поиск находит на два скролла оставленных в системе файлов (при 1200 пикселях десктопа по вертикали). Бесплатный Driver Sweeper и платный Driver Cleaner их вроде как удаляют, но, судя по всему, что-то все же в памяти остается. Беда-беда. Если очередной заход "издалека" не удастся - придется весь стенд заново подымать, а это, на минутку, около 20 единиц не самого легкого ПО, не считая самой ОС и драйверов.

Надо было новинку напоследок, "на сладкое" оставить.

Пользуясь случаем, передаю привет программистам ATI/AMD, которых до этого в "холиворах" по поводу качества драйверов я защищал.

P.S. А карточка отличная, да.

8 сентября 2009 г., 17:05

После окончания официальной части сегодняшней презентации новых процессоров Intel Core i5 и Core i7 (Lynnfield) специалист по применению продукции компании Сергей Шевченко продемонстрировал нам уже рабочий образец 32-нанометрового СPU на базе ядра следующего поколения, Clarkdale, способный функционировать на уже выпущенных материнских платах для Socket 1156.

По словам Сергея, с технической точки зрения не будет никаких ограничений при переходе на Clarkdale с сохранением уже имеющейся платы на базе чипсета P55. Единственной потерей будет отключение встроенного графического ядра (напомним, что эти процессоры будут содержать два чипа на одной подложке: один - сам CPU, второй - 45-нанометровый кристалл с контроллерами памяти и PCI Express и графическим ядром).

Для нормальной работы устройств нужна поддержка со стороны BIOS, потому пока сложно сказать, все ли выпущенные материнские платы на P55 будут поддерживать новые процессоры. Как-никак производителям платформ есть смысл выпустить новые версии плат, на которых будет разведен графический выход, и простимулировать рынок к их приобретению, отказавшись обеспечивать поддержку новинок в старых платах. Впрочем, надеемся, что до таких грубых методов не дойдет. Точно известно, что свежепредставленные платформы Intel на P55 будут поддерживать эти процессоры, что и продемонстрировал Сергей на примере инженерного образца будущего Core i5.

Из других деталей стало известно, что GPU в Clarkdale является серьезно доработанным чипом серии 4500 HD и будет превосходить предшественника примерно на 80%. У процессоров разных классов графическое ядро будет работать на разных частотах. По некоторым сведениям в Сети, ожидаются 900 МГц для топовых моделей и 733 для продуктов среднего класса.

Что ж, ждем зимы. Если GPU действительно доведен до ума, Core i3 на этом ядре будет новым вариантом идеальной платформы для медиацентра.

18 августа 2009 г., 16:50

Мобильная платформа AMD Puma была представлена более года назад, однако не все ее возможности оказались реализованы в конечных устройствах. Речь идет о внешних графических акселераторах, упоминание которых вызвало активное обсуждение и множество вопросов у присутствовавших на той пресс-конференции AMD.

Напомню, что платформа AMD Puma строится на базе интегрированного чипсета, содержащего маломощный, но вполне достаточный для большинства нужд графический акселератор (Radeon HD 3200). Обновленные версии оборудованы более современными GPU, однако речь не об этом.

Эти мобильные чипсеты, как и настольные аналоги, поддерживают технологию Crossfire. AMD решила одним махом занять два сегмента рынка ноутбуков: нишу ультрапортативных устройств и сверхпроизводительные игровые ПК. Достигаться это должно было возможностью подключения внешнего графического акселератора XGP (External Graphics Platform) с помощью проприетарного (но, тем не менее, бесплатного) интерфейса, логически представляющего собой PCI Express 2.0 x8, названного Lasso. Преимущества очевидны: GPU является самым "жадным" в плане энергопотребления элементом ноутбука, в случае с топовыми моделями превосходящим даже подсветку матрицы. Ему нужно свое довольно мощное и громоздкое охлаждение. Нужда в высокопроизводительной графике для ноутбука возникает отнюдь не всегда: если на десктопах вариант "оторвался от постоянной игры, чтобы посмотреть кино/зайти в Интернет/поработать/etc" довольно типична, то мобильные ПК все же в основном используются в противоположном ключе, а значит, GPU большую часть времени простаивает, но энергию потребляет.

XGP все эти проблемы устраняет одним махом: нужна мобильность - взяли ноутбук и пошли на работу, причем ноутбук этот может быть абсолютно любого класса, от бюджетного до дорогого ультрапортативного, лишь бы был чипсет AMD и порт Lasso. Решили поиграть (очевидно, что в пределах доступности розетки) - подключили XGP, получив мощь топовой графики, и наслаждаемся высокими настройками. Плюс XGP позволяет подключать дополнительную периферию по USB - тюнеры, внешние диски, что угодно.

Казалось бы, производителям ноутбуков за такую идею нужно хвататься обеими руками! Однако нет, прошел год, а в мире до сих пор существует аж один (!) ноутбук с поддержкой XGP - Fujitsu Amilo SA 3650. Причин этому довольно много, и среди них не последнее место занимают высокая цена и малая доступность модулей с топовыми GPU Mobility Radeon, на основе которой строятся XGP, низкий спрос на игровые ноутбуки в целом, годичная эксклюзивная лицензия AMD на Lasso... В итоге, отличное в теории решение фактически оказалось нереализованным.

Тем не менее, у нас наконец появилась возможность его рассмотреть. Компания Fujitsu предоставила на тестирование вышеупомянутый ноутбук Amilo SA 3650 с GraphicBooster (фирменное название XGP).

Итак, что обещали, и что получилось:

- доступна версия GraphicBooster только с Radeon HD 3870 512 MB, хотя планировались варианты с HD 3470, 3670, 3850 X2 и 3870 X2;

- Один из обещанных возможных режимов работы - использование XGP для ускорения вывода графики на экран самого ноутбука - не работает, для активации XGP обязателен внешний монитор*;

- Встроенный USB-концентратор действительно отлично работает и с внешними HDD, и с USB-тюнером;

- Быстродействие действительно отличное и сравнимо с аналогичной конфигурацией десктопного ПК, при наличии адекватного процессора в ноутбуке современные игры - не проблема;

- Обещанная возможность "горячего" подключения, к сожалению, не работает, необходима перезагрузка*;

- Внешнее питания XGP - обычный ноутбучный БП, универсально, но довольно громоздко.

* - наиболее свежие драйверы для GraphicBooster на сайте Fujitsu датированы февралем 2008 года, а обычный установщик AMD Catalyst Suite почему-то XGP не распознает. Пришлось вручную указывать ОС, какой же GPU там установлен, причем не Mobility. Возможно, поэтому эти возможности и не работают, я еще проверю с теми драйверами Fujitsu (для теста производительности они, естественно, непригодны).

В целом впечатление смешанное, с одной стороны такие решения вызывают удовольствие своим изяществом, с другой стороны - разочарование пассивностью индустрии. Возможно, с окончанием эксклюзивной лицензии AMD производители начнут внедрять XGP более активно, и NVIDIA сделает аналогичное решение, однако это довольно сомнительно.

Подробный обзор и тестирование этих устройств читайте в следующем номере "Компьютерного Обозрения".

|

|

|