|

СПЕЦІАЛЬНІ ПАРТНЕРИ ПРОЕКТУ BEST CIOОпределение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях Человек годаКто внес наибольший вклад в развитие украинского ИТ-рынка. Продукт годаНаграды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары |

ЦОД как объект системной и структурной оптимизации

Автор – Юрий Кученко, 14 мая 2009 г.

Статья опубликована в №15 (681) от 28 апреля

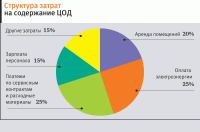

Мировой финансовый кризис, затронувший сегодня практически все отрасли экономики, заставляет компании активно искать пути сокращения издержек и повышения эффективности своей деятельности. В этом процессе оптимизация собственной ИТ-инфраструктуры является одной из приоритетных задач. Центральное место в работе ИТ-зависимых компаний занимает центр обработки данных (ЦОД), на который тратится максимум ресурсов при построении, на поддержку и его дальнейшее развитие. Исторически появление и развитие ЦОДостроения напрямую связано с многократным увеличением объемов хранимой и обрабатываемой информации, необходимостью обеспечить высокую эксплуатационную готовность ответственных приложений и непрерывность бизнес-процессов. Исходя из функций и основных требований к центрам обработки данных, ЦОД можно определить как комплексное решение, предназначенное для высокопроизводительной обработки, хранения и передачи данных, обладающее высокой эксплуатационной готовностью. Это решение включает в себя также инженерную инфраструктуру, составляющую немалую долю затрат как при инсталляции центра, так и в стоимости совокупного владения системой. С другой стороны, ЦОД представляет собой объединение большого количества программных и аппаратных платформ различного типа – серверов, СХД, ОС, систем управления нагрузкой и средств резервирования данных, выстроенных в соответствии со спецификой бизнес-задач его владельца. Аналитики IDC отмечают значительный рост спроса на ЦОД в Украине в последние два года. Дальнейшими ускорителями этих процессов являются продолжающееся развитие рынка Интернета, увеличение объемов онлайн-контента, усложнение ИТ-инфраструктур компаний. Рост потребительского спроса демонстрирует ужесточение требований к качеству, надежности, отказоустойчивости и в совокупности с ценовой аргументированностью (как инсталляционных, так и долговременных затрат) становится одним из важнейших аспектов в практике строительства и эксплуатации центров. Среди основных тенденций, характерных для середины 2008 г., называются повышенный уровень качества строящихся центров, появление объектов премиум-класса и рост количества больших по размеру ЦОД (третьей категории и выше) с высокой энергетической плотностью. Однако росту спроса препятствуют определенный дефицит фирм, имеющих опыт самостоятельной реализации подобных проектов, и отсутствие со стороны исполнителя глубокого понимания бизнес-потребностей заказчика, а с противоположной стороны – недостаточная техническая компетентность, позволяющая сформулировать требования к системе «на языке ИТ». Тем не менее прошлый год характеризовался ростом количества клиентов, готовых платить за качественно предоставленные услуги, делались активные целенаправленные инвестиции в создание современных ЦОД как для собственных (корпоративных), так и для коммерческих нужд. Несмотря на устойчиво демонстрируемые высокие темпы роста количества центров (стабильный прирост почти на треть в год, если не учитывать достаточно неоднозначных результатов IV квартала 2008 г. и I –2009 г., о них разговор отдельный) на протяжении последних трех лет, о зрелости украинского рынка ЦОД говорить преждевременно, он, по мнению многих аналитиков, лишь находится на этапе завершения своего формирования. В качестве одного из подтверждений приводится статистика, указывающая на продолжающуюся концентрацию объектов в столице и, со значительным отрывом, в некоторых городах-миллионниках. ЦОД через призму трансформации и оптимизации ИТ-инфраструктурыРазвернувшийся глобальный экономический кризис заставил предприятия всех сфер экономики отказаться от привычного уклада и кардинально пересмотреть стратегию своего функционирования и развития. Организации, изыскивая пути экономии бюджета, до лучших времен откладывают проекты, связанные с вложениями в вычислительные центры, считая затраты на строительство и содержание современного ЦОД в настоящий момент неподъемными. По сути, многие ИТ-службы компаний сегодня учатся не расти, а выживать, и их задача – остаться на плаву и научиться балансировать с потерей качества обслуживания бизнес-процессов и повышением его удельной стоимости. Ведь так как большинство ИТ-задач являются инфраструктурными, то нагрузка на эти подразделения слабо зависит от объемов бизнеса. Поэтому затраты на ИТ не падают пропорционально снижению доходов от основного бизнеса и этим департаментам приходится искать нестандартные методы снижения собственных расходов. Однако не будем и гипертрофировать роль ЦОД. В первую очередь он должен рассматриваться как инструмент поддержки непрерывности бизнеса, и если его модель позволяет снизить требования по этому параметру, то такой компании самое время задуматься о передаче части либо всей его ИT-нагрузки на сторону, оставив у себя необходимый минимум вычислительных ресурсов. Целесообразность основных капитальных затрат при его создании и дальнейшем развитии будут во многом определяться построением внутренних процессов самого предприятия. Без ЦОД могут прожить лишь те, чьи бизнес-процессы практически не зависят от информационных технологий. Такие компании могут безболезненно пережить простой ИТ-инфраструктуры и временно использовать ручные процессы или базовую автоматизацию на основе ПК. Оценка и резервы эффективности работы ЦОДСуществует множество различных способов классификации ЦОД в их современном и (в несколько искривленном заказчиками) украинском понимании. Их можно разделять по количеству установленного оборудования, выполняемым задачам, площади помещений и т. д. Есть и дифференциальные оценки по одному или нескольким параметрам одновременно (потребляемой мощности, средней плотности оборудования), а также по функциональному назначению, позволяющему их разделить на две большие группы: корпоративные и коммерческие. Первая используется, как правило, для внутренних нужд компании-владельца и является ответом на вызов чрезмерно «распухших» локальных сетей предприятий с разбросанными несистематизированными вычислительными мощностями. Вторые строятся в основном для предоставления услуг размещения серверов сторонних компаний или для решения клиентских задач на предлагаемом в аренду оборудовании. Известны и стандартные критерии их оценки – надежность, доступность, легкость в обслуживании, производительность. Первый состоит из таких составляющих, как правильно выбранное помещение, наличие отлаженных систем бесперебойного энергоснабжения, кондиционирования и ряда других. Однако несмотря на разницу, основные вызовы в отношении эксплуатируемых коммерческих и корпоративных ЦОД схожи: обеспечение надежности (определяемой как суммарное время недоступности или неполного предоставления сервисов) и стремление владельца снизить затраты, повысив эффективность эксплуатации. По мнению специалистов банковского сектора, компании в перспективе могут сэкономить до 40% при переходе на ПО Open Source и до 20% объема инвестиций в инфраструктуру, применяя методы централизации или виртуализации. Различные стратегии сорсинга, включая аутсорсинг, в общей сложности позволяют сберечь до 30% инвестиций в ИТ-сервисы. Централизация ИТ-процессов, в свою очередь, способствует увеличению эффективности до 40%. В структуру основных затрат входят счета за потребляемую электроэнергию, заработная плата обслуживающего персонала, стоимость аренды площадей, платежи по сервисным контрактам на ТО вычислительных и инженерных систем, расходных материалов, амортизации оборудования ЦОД (рис. 1) Оценки эффективности ИИ ЦОД

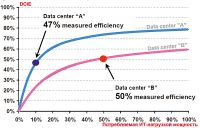

До недавнего времени владельцы центров обработки данных брали в расчет только вычислительную мощность серверов, а энергетические издержки либо вовсе игнорировались, либо им не уделялось должного внимания. Однако тенденция роста стоимости электроэнергии и необходимости снижения расходов такова, что затрачиваемая энергия все чаще рассматривается в связи с достигаемой с ее помощью производительностью. Практически вся электроэнергия, поступающая в ЦОД, в конечном счете преобразуется в тепло. Мы не беремся рекомендовать методику, позволяющую определить эффективность его работы, характеризующуюся соотношением потребляемой мощности и «просчитанных/переданных битов». С точки зрения оценки инженерной инфраструктуры ЦОД вполне достаточно будет найти соотношение между общей подаваемой электроэнергией и полезным выходом – мощностью, затраченной серверами и другим ИТ-оборудованием, называемое коэффициентом эффективности использования энергии (Power Usage Effectiveness, PUE). В последнее время в качестве общепризнанного применяют стандартизированный агентством EPA коэффициент эффективности инженерной инфраструктуры DCiE (Data Center Infrastructure Efficiency) – выраженное в процентах соотношение между той частью мощности, которая фактически потребляется ИТ-оборудованием, и всей расходуемой ЦОД. Если бы КПД ЦОД приблизился к 100%, то это означало бы, что вся подводимая к нему мощность достигает информационных систем. В реальной ситуации электроэнергию потребляет не только ИТ-оборудование, но и множество других устройств, обеспечивающих его трансформирование, электропитание, охлаждение и защиту (рис. 2). И главное – при этом до ИТ доводится менее половины всей мощности, потребляемой ЦОД: в типичном ЦОД уровень использования номинальной мощности может составлять 30%, так что более 70% стоимости расходуемой электроэнергии теряются из-за низкой энергетической эффективности систем электропитания и охлаждения. Простые советы рачительному хозяинуСпециалисты Eaton дают семь советов по снижению потребляемой ЦОД электроэнергии. 1. Отключите от питания неактивное ИТ-оборудование. Серверы обычно используются только на 5–15%, ПК – на 10–20%, локальные устройства хранения – на 20–40%, а сетевые СХД – на 60–80%. Если какие-то из них простаивают (т. е. их рабочая нагрузка гораздо ниже «штатной»), они все равно потребляют электроэнергию (типовой сервер x86 – 30–40% максимальной мощности, даже если не выполняет каких-либо вычислений). 2. Виртуализируйте серверы. Большая часть приложений может выполняться на отдельных «виртуальных машинах», которые вместе с другими приложениями совместно задействуют одни и те же аппаратные средства. Виртуализация значительно повышает уровень использования аппаратных средств и позволяет сократить число серверов и СХД. Считается, что за ее счет можно увеличить утилизацию ИТ-ресурсов x86-серверов с 10–20% до 50–60%. 3. Объедините серверы, центры хранения и обработки данных. Компактные серверы и СХД способны выполнять ту же работу, что и традиционные, монтируемые в стойку, но при этом потреблять энергии на 20–40% меньше. При актуальной для Украины стоимости электроэнергии 1 цент за кВт•ч в ЦОД с 1 тыс. серверов можно ежегодно экономить до 17,5 тыс. долл. 4. Активируйте функцию управления питанием центрального процессора. Более 50% энергии, необходимой для работы сервера, потребляет центральный процессор. Современные ЦП имеют функцию управления питанием, позволяющую без перезагрузки оптимизировать энергопотребление с помощью динамического переключения состояний производительности (комбинаций частоты и напряжения). Когда ресурсы ЦП высвобождаются, функция управления питанием минимизирует избыточный расход энергии, динамически понижая производительность ЦП. Ее использование даст не так уж много преимуществ, если ЦП в соответствии с пунктом 2 удалось загрузить до разумного максимума. Однако, как и в предыдущей рекомендации, сокращение энергопотребления процессором на 20% приведет к еще одной такой же по величине экономии. При выборе новых серверов данная функция управления ЦП должна стать одним из критериев отбора. 5. Используйте ИТ-оборудование с высокоэффективными блоками питания. Второй после ЦП крупнейший «расточитель энергии» – блок питания (БП), который преобразует переменный ток на входе в постоянный ток на выходе, поглощая 25% энергетического потенциала сервера. Третьими по уровню потребления являются регуляторы напряжения (VRM) на материнской плате: преобразующие исходные 12 В до необходимого непосредственно для самого процессора напряжения, а также обеспечивающие питание прочих микросхем. Не следует забывать, что коэффициенты полезного действия этой последовательной цепочки при подсчете суммарного КПД сервера также перемножаются. Поэтому в типовом стандартном сервере с БП (КПД 80%) и VRM (75%) конечная эффективность преобразования энергии на устройство составит примерно всего 60%. На ту же тысячу серверов в ЦОД их повышение на 10–15% дает еще около 13 тыс. долл. экономии. 6. Используйте ИБП с высоким КПД. КПД устаревших моделей источников с тиристорными преобразователями составляет всего 75–80%. В современных ИБП на базе высокочастотных IGBT-транзисторов этот параметр достигает 85–90%, дополнительные меры позволяют поднять его до 97% и обеспечить их энергоэффективность в сравнительно широком диапазоне нагрузок. Повышение КПД даже на 10% в нашем гипотетическом ЦОД означает не менее 8,5 тыс. долл. экономии на оплате счетов за электричество. Кроме того, в современных устройствах общая надежность и производительность системы бесперебойного питания увеличивается за счет удлинения ресурса аккумуляторных батарей, о чем не следует забывать, оценивая ТСО. 7. Перейдите на более прогрессивные методы охлаждения ЦОД. От 30 до 60% энергетических затрат ЦОД приходится на поддержку систем охлаждения. Цифра может быть и выше, если это оборудование неправильно размещено или работает в неоптимальном режиме. Установка шкафов в конфигурации с горячими и холодными коридорами позволяет более эффективно отводить тепло от серверов и потребует меньших энергетических затрат на охлаждение. Оптимизации будут способствовать использование более эффективных кондиционеров и охладителей, в которых применяются передовые технологии, например насосы и вентиляторы с изменяемой частотой вращения лопастей, воздушные и водяные экономайзеры и т. п. Если вернуться к нашему примеру, на 1 тыс. серверов с помощью указанных методов можно сократить годовые расходы на охлаждение на 25%, сэкономив на электроэнергии еще более 10 тыс. долл. И главное, сочетание энергоэффективного ИТ-оборудования с энергосберегающими инфраструктурой питания и стратегией охлаждения дает интегральный эффект по уменьшению потребления энергии ЦОД на 50% без снижения уровня его функциональности и надежности – что вполне реально. Не следует пренебрегать этими советами, учитывая тенденцию роста стоимости электроэнергии в Украине. Свой ЦОД или аренда ресурсов?

В условиях урезания затрат на ИТ, когда многие новые корпоративные проекты были приостановлены, стали вновь звучать оценки, что собственный ЦОД для ряда компаний различной бизнес-направленности может оказаться неоправданно дорогим. Действительно, оценочная стоимость систем только бесперебойного питания и резервного генератора составляет до $1000 за 1 кВт, на отведение тепла из помещения за каждую 1000 Вт в расчеты придется заложить еще до $1500. По мнению украинских специалистов, типовые затраты на все основные инженерные компоненты ЦОД выглядят следующим образом: бесперебойное электропитание – 13–25%, прецизионное кондиционирование и вентиляция – 22–32%, гарантированное электроснабжение и освещение – 10–12%, охранно-пожарная и система безопасности – 15–17%, пассивное оборудование – 25–30%. Впечатляющим выглядит и перечень необходимых работ, предшествующих этапу запуска центра в тестовую эксплуатацию: модернизация помещения (укрепление перекрытий, ликвидация водяных и отопительных систем и т. п.); общестроительные работы (чистовая отделка помещения, устройство фальшполов); монтажные работы (ДГУ, системы кондиционирования, ИБП, организация кабельного хозяйства электропитания, автоматики, пожаротушения, охраны, создание СКС); пусконаладочные работы; оформление соответствующей разрешительной документации. Недооценка затрат на обслуживание ЦОД – весьма распространенная ошибка, в период окупаемости проекта они составляют до 80% его стоимости и вообще могут сделать проект убыточным. В итоге цена одного стойко-места в собственном центре может достигнуть $40 000–90 000, а процесс построения растянуться на год и более. Системные преобразования для бизнеса компании могут включать решения о передаче собственных задач в крупные коммерческие ЦОД. По некоторым российским оценкам, там спрос на аутсорсинговые ЦОД уже достиг такого уровня, что предложение начинает за ним не поспевать. Базовая услуга – предоставление в аренду площади (кстати, ее цена в последнее время немного упала) под клиентское вычислительное оборудование. Можно заказать ЦОД как услугу, передав на аутсорсинг все риски, связанные с эксплуатацией ИТ-среды. Разумеется, существует целый ряд ограничений на аутсорсинг, например особые требования по защищенности данных, обеспечению непрерывности бизнес- и вычислительных процессов. Не стоит также строить иллюзий по поводу того, что отдав что-то на аутсорсинг сегодня, эффект будет получен уже завтра. Однако при определенной зрелости заказчика, имеющего четко формализованные бизнес-процессы, это может приносить выгоды обеим сторонам. К причинам, которые тормозят развитие рынка ИТ-аутсорсинга, можно отнести отсутствие общепринятых норм и стандартов по предоставлению услуг. Со стороны владельца крупного ЦОД это потребовало бы наличия адекватной собственной службы эксплуатации и обязало бы отвечать за качество услуги, предложив клиенту развернутый Service Level Agreement (SLA). Так что сравнивать, что лучше – внутренняя ИТ-служба и собственный ЦОД или передача в аутсорсинг, можно лишь сопоставив соответствие SLA и цену решения вопроса. Предмет отдельного анализа – появление тенденций, которые модно объединять термином сloud computing, а также оценка плюсов и минусов от применения модели SaaS (программное обеспечение как сервис). По мнению тех, кто пользуется последней, она позволяет сэкономить деньги и время. Хотя при ближайшем рассмотрении не все оказывается так однозначно, и имеется не меньше скептических оценок, базирующихся на том, что требуемая гибкость предлагаемых продуктов, обеспечение конфиденциальности и безопасности данных и непрерывности бизнес-процессов (а значит, и надежность такой системы в целом) далеки от идеала. Достаточно однозначным с точки зрения достижения экономии в условиях кризиса является предложение услуги аутсорсинга в качестве резервного центра обработки вместо построения собственного. О готовности к ее предоставлению на украинском рынке заявляют одновременно несколько компаний. Его использование при условии адекватной защиты клиентских данных не представляет опасности для бизнеса заказчика. Более того, ЦОД на аутсорсинге будет надежнее, чем построенный своими силами. Это обусловлено, как правило, боóльшим опытом аутсорсера и постоянным контролем за заявленными им параметрами. Кроме того, в рамках партнерских соглашений предлагается обеспечить «зеркалирование» ИТ-ресурсов – когда клиент, работающий в одном ЦОД, как дополнительный сервис может получить многократно резервируемые каналы связи и возможность на площадке другого оператора разместить свое (или взять в аренду) оборудование для резервного хранения и обработки данных. Повышение энергоэффек-тивности ЦОД

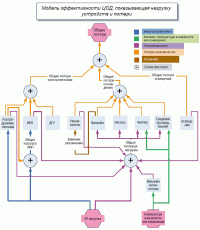

Одним из путей снижения затрат на центры обработки данных является применение современных аппаратно-программных средств, в основу которых положены концепции повышения управляемости, виртуализации и консолидации. Однако следует учитывать, что их внедрение связано с дополнительными объемами новых инвестиций и разными прогнозными темпами их возврата. Поэтому внедрение следует совмещать с анализом затрат на текущее содержание ЦОД. Если на первом месте традиционно стоят расходы на поддержку, т. е. на реструктуризацию и выделение коммерчески перспективных направлений деятельности (цели), оптимизацию бизнес-процессов, включая оплату работы персонала (пути и средства достижения), то вторую ступеньку обычно занимают расходы на электроэнергию (ее доля колеблется от 20 до 50% эксплуатационных затрат, нижнее значение характерно для нашей страны). Схожую оценку дают аналитики Gartner, полагая, что доля счетов на оплату электричества может вырасти до 60%. Подорожание электроэнергии (не обошедшее и Украину) считают причиной снижения темпов возврата инвестиций от внедрения в инфраструктуру новых серверов. Например, за время эксплуатации сервера HP ProLiant DL360 G4p, приобретенного в 2005 г., при теоретической 100%-ной загрузке на сегодняшний день потребление электроэнергии составит около 40% его первоначальной стоимости, еще столько же будет истрачено на его охлаждение. IDC утверждает, что на каждый доллар, израсходованный на новые аппаратные средства, дополнительно тратится в два раза больше, чем пять лет назад, – $0,50 на электропитание и охлаждение. Другим немаловажным аспектом, подталкивающим к снижению потребления, учитывая, что мощные ЦОД строятся у нас, как правило, в крупных городах, являются ограничения на подводимую мощность, связанные с инфраструктурой городских электросетей. Прогнозируется, что в процессе кризиса (со всеми его сопутствующими традиционными энергетическими тенденциями) цена на электроэнергию даже при сохранении ее объемов отпуска для юридических лиц за 2–3 года вырастет вчетверо, а по пессимистическим оценкам в силу евроинтеграционных процессов цифры, приводимые для западных потребителей, через 6–8 лет (жизненный цикл ЦОД составляет около 10 лет) уже станут нам родными. Так что поводов для анализа и путей последующей оптимизации расходов более чем достаточно. Решать эти задачи придется на всех уровнях – от организационного до инфраструктурного и компонентного. ВиртуализацияНаиболее очевидный первый шаг – определить, какие вычислительные системы имеют низкую степень утилизации, и выключить их (см. врезку с советами от Eaton). Разумеется, что если даже сервер используется только на 5–15% (типовой показатель, у ПК он обычно 10–20%), найдутся противники его вывода из постоянной эксплуатации – ведь им придется изыскивать пути более рентабельного исполнения приложений. Как это ни парадоксально, в качестве одной из стратегических целей могут фигурировать цифры снижения потребления на 40 и даже 70% за счет только упорядочения конечной ИТ-нагрузки, большую часть которой составляет парк серверов. Анализируя тенденции в этом секторе рынка, IDC продолжает утверждать, что доля лезвийных серверов постепенно растет, оставаясь основной платформой для трансформации вычислительной среды. С их помощью удается увеличить плотность вычислительных ресурсов, сократить затраты на администрирование, электропитание и охлаждение, а в паре с технологиями виртуализации – повысить гибкость ИТ-инфраструктуры и снизить эксплуатационные расходы. Для доказательства правдоподобности достижения вышеуказанных значений начать придется с вопроса, почему за последние годы количество используемого оборудования продолжает расти опережающими в сравнении с вычислительными потребностями бизнеса темпами? По мнению экспертов, дело в том, что при классическом построении вычислительной среды количество потребных серверов определяется не столько их производительностью, сколько необходимостью создания изолированных операционных сред для работы приложений (в идеале каждому приложению – отдельную платформу). В результате уровень утилизации ресурсов единичным устройством уменьшается, число серверов растет. Разумеется, производители платформ прилагают значительные усилия, чтобы уровень потребления сервера соответствовал текущей вычислительной сложности решаемой задачи (например, реализация технологий Demand-Based Switching (DBS), Automatic Control of Power Consumption (ACPC), Enterprise Power & Thermal Manager (EPTM) и многих других), однако их возможности не безграничны. Напротив, технологии виртуализации как ключевая тенденция в развитии сервис-ориентированнных архитектур позволяют создать для каждого из приложений отдельную виртуальную платформу, достаточную для ее комфортной работы. Несмотря на известные ограничения, учитывая важность виртуализации как способа создания управляемой и отказоустойчивой среды, он уже давно вошел и в копилку оптимизационных рецептов от Gartner www.networkworld.com/news/2008/ 101508-gartner.html). По опыту специалистов украинской De Novo на практике удается повысить степень утилизации ресурсов сервера, переместив на один высокопроизводительный сервер до 7–12 бизнес-приложений. Таким образом, можно уменьшить совокупное количество оборудования в разы с соответствующим выигрышем в энергопотреблении (после выключения лишнего оборудования или переориентации на другие задачи, вплоть до сдачи внаем). Владелец такой инфраструктуры при правильном распределении имеющихся ресурсов сможет «пропустить очередной круг» обязательного обновления своей вычислительной базы, необходимость проведения которого, как правило, возникает каждые 3–4 года. Заметим, что вышеприведенные рассуждения касались только виртуализации серверов, однако этим классом потребителей энергии область применения данной технологии не ограничивается – все большее практическое значение приобретают концепции создания единых управляемых виртуальных инфраструктур, объектами которой выступают также СХД и сетевая среда ЦОД. Зачастую виртуализация дает возможность сократить потребности на дальнейшее расширение занимаемых центрами обработки данных площадей. И затраты на обслуживающие подсистемы инженерной инфраструктуры, в том числе и на крайне «прожорливое» оборудование для кондиционирования. Ведь эффект от применения виртуализации двойной: снижение потребляемой энергии оставшимися серверами уменьшает суммарное тепловыделение на них и других отнюдь не 100%-но эффективных вспомогательных систем тракта электропитания (рис. 3). Тем самым уменьшается потребная холодопроизводительность системы кондиционирования (на 1 кВт энергопотребления оборудования планируют 1 кВт холодопроизводства). Все это (разумеется, при правильно спроектированной ИИ) снижает необходимость в объеме совокупной обеспечиваемой для ИТ-нагрузки мощности как минимум на коэффициент, полученный в результате виртуализации. Энергетическая оптимизация инженерной инфраструктуры ЦОД

При грамотном подходе инженерная инфраструктура ЦОД, включая системы электропитания и кондиционирования, рассчитывается на срок эксплуатации не менее 10 лет. За этот период, как правило, происходит два или три обновления серверов. А это значит, что за короткий срок она должна быть адаптирована к новому оборудованию с увеличенным показателем потребления электроэнергии и тепловыделения. В кризисных условиях к стандартному набору требований добавляется необходимость адекватной реакции на довольно непредсказуемые изменения потребностей. Глобальный консорциум The Green Grid рекомендует оптимизировать ИИ и избавляться от избыточных компонентов, устанавливая только то оборудование, которое требуется на сегодняшний день. Как указывается в рекомендациях по энергосберегающим ЦОД (Guidelines for Energy-Efficient Data Centers), только благодаря оптимизации инфраструктуры расходы на электроэнергию можно сократить вдвое. В совокупности излишние расходы избыточной ИИ (рис. 4) на протяжении срока эксплуатации ЦОД составят в среднем 70% стоимости инфраструктуры электропитания и кондиционирования. Противоречие данных требований выдвигает на первый план необходимость обеспечения высокой масштабируемости проектируемых и модифицируемых ЦОД, в связи с чем следует напомнить о двух концептуальных схемах организации основного «расточителя» электроэнергии – системы кондиционирования: с вертикальной циркуляцией и обменом в горизонтальной плоскости без фальшпола. Первая, унаследованная от мейфрэймовых вычислительных центров, предполагает наличие фальшпола, когда холодный воздух снизу попадает на шкаф и, проходя через него, охлаждает системы. Нагретый воздух возвращается в систему кондиционирования и, охлаждаясь, снова направляется в фальшпол. Плюсом такого способа является относительная простота, а минусом — большие энергозатраты на подъем холодного и спуск горячего воздуха. Даже при малом тепловыделении (до 5 кВт на стойку) фальшпол приходится поднимать на высоту порядка метра. При большем теплоотводе требуется еще увеличить расстояние между стойками и высоту фальшпола, что не всегда реализуемо. Для устранения локальных зон перегрева может понадобиться установка дополнительных вентиляторов, однако они сами приводят к росту энергопотребления, вынуждают наращивать мощность систем кондиционирования и требуют резервирования. Непродуманное размещение техники приводит в этом случае к неправильному распределению потоков и к проблемам с подачей холодного воздуха к стойкам, а неправильное распределение потоков под фальшполом – к перемешиванию горячего и холодного воздуха и его рециркуляции вокруг стоек. Причем в наихудшем случае возникает так называемая отсечка: вблизи кондиционеров решетки фальшпола могут не только не подавать воздух к оборудованию, но и забирать его из помещения, и размещение наиболее горячих стоек вблизи выхода кондиционера лишь усугубит проблему. Соответственно, задачу отвода горячего воздуха также приходится решать посредством совместного проектирования климатических систем и моделирования расстановки конкретного оборудования. Второй вариант в области кондиционирования, основанный на горизонтальной циркуляции воздуха, относительно молод, но, несмотря на это, уже нашел свой отклик в продуктовых рядах вендоров и положительные отзывы системных интеграторов. В этом случае стойки с серверами в рядах устанавливаются зеркально, а «горячие» и «холодные» коридоры чередуются. Кондиционеры, установленные в те же ряды, пропускают через себя воздух по направлению от тыла к фронту и благодаря отсутствию необходимости перемещать его по вертикали и на большие расстояния оказываются значительно эффективнее. Высокому КПД сопутствует их оснащение интеллектуальными системами регулирования скорости подачи теплоносителя и вращения вентиляторов, обеспечивающих оптимальный поток холодного воздуха. Рекомендации по размещению оборудования, позволяющих организовать «горячие» и «холодные» коридоры, проверены временем (их можно найти в документах ASHRAE конца 80-х) и доказали свою работоспособность, определив общепринятую практику построения современных ЦОД. Кроме того, потребляемая мощность и КПД систем охлаждения различны в зависимости от принадлежности к одному из трех определенных Uptime Institute классам, выбор которых зависит от тепловой загруженности стоек и объема помещения машинного зала. У систем класса B за счет ИБП работают только вентиляторы кондиционеров, а в классе C используется принцип традиционного электроснабжения системы охлаждения: только от гарантированного ввода электропитания с перерывом на время запуска ДГУ и ее рестартом после паузы. В системах класса A вентиляторы кондиционеров и циркуляционные водяные насосы питаются от ИБП, между чиллером и кондиционером в водяной петле установлен гидроаккумулятор. Однако при использовании фреоновых кондиционеров единственный способ в этом случае обеспечить продолжение своей работы – запитать их от ИБП, что повлечет увеличение мощности источников в полтора-два раза. Разумеется, в таком случае есть смысл сражаться за каждый процент КПД оборудования для охлаждения и обратить внимание на реализацию в нем схем интеллектуального управления производительностью. Возвращаясь к вопросу энергоэффективности ИИ центра, следует отметить, что к недооценке потерь в реальных условиях приводит использование заявленных производителем значений КПД основных компонентов. Как правило, они приводятся для определенного диапазона условий применения, и их эффективность значительно снижается при уменьшении ИТ-нагрузки (см. рис. 4). Это связано с наличием постоянных потерь «холостого хода», не зависящим от рабочей мощности. Кроме того, всегда найдется много причин, по которым компоненты электропитания и кондиционирования будут эксплуатироваться с нагрузкой ниже номинальной. Например, в силу того что ИТ-нагрузка ЦОД меньше, чем конструктивная номинальная мощность системы, или расчетный номинал производительности компонента был намеренно завышен для обеспечения избыточного запаса по мощности. При аудите или проектировании ИИ для корректного расчета потерь не следует пренебрегать тепловыделением не только ИТ-оборудования, но и самих систем электропитания и кондиционирования в подлежащем охлаждению пространстве. Как следует из приведенных рассуждений, чем глубже желание постичь тонкости энергоэффективности, отходя от простейших энергетических моделей, тем более сложным и многофакторным оказывается анализ. Для поиска резервов можно воспользоваться моделью эффективности ЦОД, где учтен мультипликативный характер потребляемых электрических и тепловых мощностей основных компонентов ИИ и их вклада в итоговые потери центра (рис. 5). Быстро увидеть практический результат от изменения инфраструктуры и оценить затраты на ЦОД и расходы на электроэнергию позволит блок калькуляторов, о котором идет речь во врезке от APC by Schneider Electric. Наименее затратный способ получения эффективного ЦОД – его тщательное проектирование с учетом интересов конкретного заказчика. Чтобы получить представление о том, что сегодня строят в Украине, мы предлагаем познакомиться с двумя новыми ЦОД, первый из которых был введен в эксплуатацию до начала кризисных проявлений, второй лишь заканчивает работу в режиме тестовой эксплуатации. Энергоэффективность ИИ ЦОД

Владимир Дохленко, В нашем понимании эффективность инженерной инфраструктуры ЦОД (ИИ ЦОД) – это способность гарантировать необходимый уровень эксплуатационной готовности при минимальных капитальных и операционных издержках (значительную часть последних составляют затраты на электроэнергию). Для компаний, чей бизнес требует непрерывного функционирования ИТ-систем, очень важно понимать вышеперечисленные показатели. В этом случае очень полезны классификация уровней эксплуатационной готовности, впервые описанная в стандарте ANSI/TIA942-2005, а также расширенные комментарии к ней от Uptime Institute, дополненные эмпирическими данными. С их помощью инвестор либо владелец ЦОД может сопоставить требуемый уровень доступности ЦОД (измеряется как ежегодное время простоя ИТ-ситемы из-за ИИ ЦОД) с уровнем необходимых капиталовложений, устройством систем инженерной инфраструктуры и другими важными характеристиками. Что примечательно, для повышения энергоэффективности и уровня отказоустойчивости ИИ ЦОД применяются одинаковые подходы. А именно: использование стандартизированных модульных компонентов, поддерживающих масштабирование; максимальное приближение теплообменников системы кондиционирования к источникам тепла (тыльной части серверных шкафов); применение системы герметизации для оборудования высокой плотности, а также автоматизированных систем управления свободными мощностями охлаждения, бесперебойного электропитания и наличием свободного места на уровне каждого шкафа ЦОД. Наша компания разработала интерактивные веб-инструменты APC TradeOff Tools (http://tools.apc.com), которые позволяют экспериментировать с различными сценариями построения инженерной инфраструктуры и понять их влияние на энергоэффективность (в виде коэффициента либо расходов на электроэнергию), уровень капитальных затрат и другие ключевые аспекты построения и эксплуатации ЦОД. ЦОД Imena.UA/MiroHost.net

Собственный ЦОД площадью более 230 м² украинский хостинг-провайдер и регистратор доменных имен – компания «Интернет Инвест» (Imena.UA, MiroHost.net) – ввел в начале октября прошлого года. Он расположен практически в центре Киева, подключен скоростными каналами к Всемирной Сети и точке обмена трафиком UA-IX и рассчитан на размещение серверов общей емкостью до 10 тыс. юнитов. На данный момент освоенная площадь ЦОД – свыше 6,5 тыс. посадочных 1U-мест. Системная интеграция выполнялась компанией самостоятельно при непосредственном взаимодействием со всеми подрядчиками под собственным авторским надзором за их ходом (за исключением общестроительных работ). По словам президента компании Александра Ольшанского, ЦОД изначально предназначался для увеличения объемов предоставления традиционных для нее услуг и был ориентирован на обслуживание интернет-проектов, в том числе и корпоративных. Основным их форматом является предложение аренды физических выделенных серверов и телекоммуникационного оборудования с возможностью его администрирования специалистами компании (Dedicated), а также, в меньших объемах, путем непосредственного размещения клиентского оборудования в 19-дюймовых стойках и аренды шкафов в ЦОД (Co-Location). Такой портфель услуг, поскольку он не предполагает существенных объемов взаимокоммутаций, позволил реализовывать облегченную внутреннюю кабельную инфраструктуру. При концептуальном проектировании инженерной инфраструктуры был выбран принцип размещения оборудования в закрытых шкафах. Это позволило, с одной стороны, облегчить поддержание необходимого локального температурного режима, а с другой – разграничить физический доступ к серверам, удовлетворяя частые требования корпоративных клиентов по обеспечению специального режима обслуживания оборудования (доступа к нему или только в присутствии клиента, или с его обязательным предварительным уведомлением). Реализация этого условия при размещении серверов в открытых стойках невозможна. Имея опыт организации системы охлаждения по принципу «горячий/холодный коридор» (что, по мнению президента компании, пригодно только для открытых стоек) и в связи с использованием шкафов, в процессе проектирования было принято решение остановиться на более подходящей в данном случае концепции вертикальной циркуляции, с подачей холодного воздуха через фальшпол непосредственно в шкаф. Это дает возможность организации отдельных гермозон, в том числе по тепловым нагрузкам, отличающихся от средней величины, и позволяет, по словам г-на Ольшанского, адекватно реагировать на самые разнообразные заказы клиентов по изоляции своего оборудования, включая и такие оригинальные, как «я хочу отгородить пять шкафов пуленепробиваемым стеклом...».

Поскольку система прецизионного кондиционирования является одним из основных внутренних потребителей электроэнергии, в ЦОД «Интернет Инвест» ее реализовали на основе оборудования с высокими показателями энергоэффективности от Emerson. Она исполнена по схеме N+1 и подключена как к резервированным городским вводам, так и к системе автономного питания (к ДГУ). Проект системы кондиционирования был разработан на базе 10 фреоновых прецизионных зальных кондиционеров тепловой мощностью по 60 кВт производства компании Emerson и соответствующих наружных блоков того же вендора. Общая проектная мощность центра 1 МВт. Данный показатель был определен как сумма мощностей, потребная для питания до 10 тыс. единиц ИТ-оборудования (0,5 МВт), системы кондиционирования (до 250 кВт электрической мощности) и дополнительного резерва, также составляющего 250 кВт. При проектировании системы бесперебойного питания исходным требованием было обеспечение работы от батарей в течение 20 мин. С учетом дополнительного резерва фактическое время, обеспечиваемое установленными ИБП, составило почти 30 мин, а этого более чем достаточно для запуска (до 2 мин) дизельной системы электропитания. В качестве ДГУ использованы два агрегата SDMO (Франция) мощностью по 410 кВ•А, штатного запаса топлива для которых хватает для обеспечения электропитания в течение 36 ч. Во входной системе распределения питания применены AVR, коммутирующие два ввода от городской энергосистемы. В ЦОД инсталлированы два ИБП производства General Electriс мощностью по 200 кВт каждый, работающие параллельно и реализующую схему 2N. По мере расширения центра будут инсталлированы еще два таких же ИБП, в результате чего система электропитания преобразуется в N+1. Такая стратегия обусловлена в первую очередь удачным сочетанием цены и качества — экономических и технических показателей оборудования General Electriс. Распределение энергопитания в шкафы производится из единой точки через систему защиты от перегрузок. Касательно вопроса энергоэффективности данного ЦОД Александр Ольшанский сообщил, что при организации dedicated-сервисов, кроме вышеизложенных требований в отношении системы охлаждения, компания прежде всего обращает свое внимание на выбор энергоэффективных серверных решений (процессоры с малым потреблением, более качественные блоки питания и т. п.). Общеприняты два принципиальных подхода к мониторингу энергопотребления: когда инструментально учитывается электроэнергия, расходуемая на каждый сервер (шкаф), и когда этот расчет производится по известным параметрам установленной мощности ИТ-оборудования. По мнению г-на Ольшанского, мониторинг энергопотребления в режиме реального времени в данном случае не имеет экономического смысла, учитывая, что, во-первых, доля затрат на электричество в стоимости dedicated-услуги составляет (для нашей страны) меньше 10%, а во-вторых, что арендодателю параметры предоставляемого им оборудования известны с высокой точностью. «Все предпринимаемое позволяет нам в общей сложности добиться до 10–15% экономии энергопотребления. Дальнейшие усилия по энергосбережению, как мне кажется, сейчас неоправданны», – заявил Александр Ольшанский. ЦОД «Топ НЕТ»О готовности к предоставлению на коммерческой основе услуги по размещению оборудования клиентов на базе своего ЦОД сообщил украинский NGN-оператор «Топ НЕТ». Его построение вызвано многочисленными пожеланиями клиентов разместить либо взять в аренду серверное и телекоммуникационное оборудование, подключенное непосредственно к высокоскоростным каналам передачи данных (протяженность оптической многократно резервируемой собственной сети только в Киеве – свыше 250 км). По заявлению компании, центр функционирует в operator-friendly режиме работы, т. е. клиент, который размещает свое оборудование, может получить доступ или обменяться услугами практически с любым оператором, провайдером или другим клиентом, размещенным здесь же, а также постоянно рассчитывать на круглосуточную поддержку профессиональной дежурной смены инженеров «Топ НЕТ». С точки зрения инженерной инфраструктуры данный центр интересен одновременно с нескольких позиций. Его сооружение начиналось с самого что ни на есть «нуля» – с проекта здания в деловой, достаточно плотно застроенной части Киева, и от этапа закладки фундамента до готовности к размещению ИТ-оборудования находилось под жесточайшим авторским надзором его будущего владельца. Все это дало возможность сформировать и применить на практике целый ряд оригинальных конструкторских решений и получить ценнейший опыт создания инфраструктурных продуктов подобного уровня. В его основу положена идеология APC InfraStruXure (как наиболее гибкая и соответствующая растущим требованиям и финансовым расчетам заказчика), ранее «обкатанная» в Украине преимущественно в проектах крупных банков и корпораций, которые возводили их на собственных площадях. Не последнюю роль в выборе оборудования инженерной инфраструктуры сыграла и возможность привлечения на всех этапах создания решения большого штата высококлассных системных и узкопрофильных специалистов APC by Schneider Electric.

Здание будущего ЦОД построено на базе несущих металлоконструкций с использованием современных теплоизолирующих материалов в два этажа с отдельными ходами. Применение концепции APC InfraStruXure позволило отказаться от фальшпола/потолка. Площадь первой очереди центра составляет 100 м², на которой будет расположено до 50 шкафов, размещенных рядами (с чередованием холодных и горячих коридоров вдоль длинной стены помещения), с клиентским оборудованием высотой 48U каждый. В каждом ряду находятся прецизионные кондиционеры APC InRow RP серии DX (APC InRow ACRP102 RP DX, 29 кВт), которые образуют интеллектуальную систему кондиционирования и поддержания оптимальной влажности с резервированием по схеме N+1. Все модули имеют отдельные наружные блоки, соединены в единую сеть и управляются специализированным программным обеспечением. Серьезные требования по допустимой шумности наружных блоков фреоновой системы охлаждения определил выбор модулей GEA KubaCan, уровень шума на расстоянии 5 м от которой составил всего 38 дБА. В случае выхода из строя одного из модулей стоечных кондиционеров или возникновения перегрева в одном из горячих коридоров остальные берут часть нагрузки на себя и начинают работать на повышенной мощности для достижения нужного уровня охлаждения на всей высоте холодного коридора. Шкафы (также производства APC by Schneider Electric) имеют перфорированные двери, способные пропустить объем воздуха, достаточный для эффективного охлаждения. Для повышения энергоэффективности системы охлаждения (чтобы не допустить смешения холодного и горячего воздуха) и для оптимизации прохождения воздушных потоков через оборудование в неиспользуемые юниты шкафов установлены специальные заглушки. Система бесперебойного электропитания включает в себя систему управления автоматическим переключением электровводов (АВР ATyS 600A), дизель-электростанцию в контейнерном исполнении FG Wilson 450 КВА; модульный источник бесперебойного питания нового поколения APC Symmetra PX мощностью 48 кВт, расширяемой до 144 кВт с резервированием по схеме N+1; систему распределения нагрузки с контролем каждого направления и возможностью опроса по IP SATEC BFM136. В каждом шкафу установлены также «нольюнитовые PDU» от APC. Средневзвешенная расчетная мощность оборудования на одну стойку определена в 10 кВт (по мере дальнейшего наполнения ЦОД будут устанавливаться дополнительные внутрирядные системы кондиционирования). Следует отметить, что ЦОД «Топ НЕТ» обеспечивает небывалую гибкость под требования заказчика, например организацию отдельной зоны (от одной до группы из нескольких стоек) с герметизацией и выделенным кондиционером APC, что позволит разместить оборудование мощностью до 30 кВт на шкаф. ВыводыНе секрет, что для рецессирующего рынка характерно изменение типовой модели поведения бизнеса предприятия: происходит переход от парадигмы «больше зарабатывать» к парадигме «меньше тратить». Сохранение уровня рентабельности на нем достигается лишь с изменением стратегии – сократить расходы, зафиксировав уровень доходов на прежнем уровне. Однако необдуманное уменьшение расходов, «затягивание ремней» может привести к негативным стратегическим последствиям и тактическим потерям. Даже проведя обширный обзор рынка ЦОД и путей повышения его эффективности, не беремся ответить на вопрос, который сегодня очень популярен среди CIO (хотя и не нов, будучи созвучным с датирующимся XVIII в. замечанием о том, что множественность одновременных тактик – лишь признак отсутствия стратегии): как можно в текущих условиях сформировать стратегию своего подразделения, если бизнес вообще не способен определить направления своей дальнейшей работы и планы чуть ли ни еженедельно меняются. Здесь кроется явное противоречие: задача ИТ-руководителя на этом этапе – не просто обеспечить четкое соответствие между ИТ-инфраструктурой и бизнес-процессами компании, но и проявить дальновидность, поддерживать и адекватно развивать ее универсальность, будучи готовым к ее последующему масштабированию. Иначе, повторимся, стоит сразу задуматься о том, не дешевле ли передать ИТ-процессы в аутсорсинг, сняв тем самым для себя актуальность рассмотренных проблем оптимизации расходов на ЦОД. В каждом конкретном случае для каждого бизнеса и режима работы инфраструктуры надо оценивать все варианты, опираясь, в частности, на достижение минимального общего TCO. Стоит также учесть, что увеличение эффективности ЦОД путем обновления оборудования ИИ – мероприятие отнюдь не бесплатное и зачастую не приносящее прибыль или снижающее расходы мгновенно. Поэтому деньги на новое энергосберегающее оборудование следует тратить тогда, когда произведен подробный аудит имеющейся инфраструктуры и исчерпаны все менее дорогостоящие структурные и системные меры.

Дополнительные материалы:

Стандартизация ЦОД по TIER: осознанная необходимость или абстракция? Сегодня в Украине действует более сотни инженерных систем, претендующих попасть под определение «Центр обработки данных», с каждым годом их число увеличивается на десятки. Если ранее вычислительным центром могли назвать любую конфигурацию серверов, систем хранения данных и т. п., то сегодня и заказчики, и интеграторы пришли к единому пониманию и пользуются одной терминологией. И если относительно предложенных градаций (классов) и наращивания сложности концептуальных требований между ЦОД внутри системы, разработанной Uptime Institute, расхождения во мнениях между специалистами невелики, то с оглядкой на отечественные реалии в вопросе их практической ценности в процессе проектирования и построения дебаты не затихают. Ниже – мнение человека, на счету которого не один построенный ЦОД.

Существуют разные принципы оценки качества ЦОД. Одни подходы основаны на истории (например, оценки по количеству отказов за предыдущие 10 лет), другие – на базе требований к инженерным решениям. Считаю, классификация ЦОД в системе параметров Uptime Institute не отражает реального состояния дел и не характеризует устойчивость работы того или иного центра, как минимум потому, что квалифицированный подсчет должен основываться на длительных сроках эксплуатации ЦОД. Если же он рассчитывается «наперед», то является лишь прогнозом. Эти требования не учитывают в полной мере человеческого фактора. По нашему опыту, более 90% случаев простоя серверов связаны не с инфраструктурой, не с перебоями в электропитании, не с проблемами в системе охлаждения, не с выходом из строя «железа», а именно с ошибками людей. Можно создать «золотую» инженерную инфраструктуру (предположим, центру присвоен статус TIER 4, что означает время простоя 5 мин в год), но если человек вынет шнур питания вашего сервера на 5 мин, то такой простой уже не будет соответствовать рейтингу TIER, хотя формально ЦОД и способен обеспечить заявленную надежность. Кроме того, если говорить об украинском рынке, то добиваться очень высоких показателей по инженерной инфраструктуре здесь тоже не совсем целесообразно, потому что серверы и другое размещаемое в ЦОД оборудование также имеют конечную надежность. С точки зрения отечественного рынка классификация TIER может представлять весомое значение для банков, применяющих кластерные решения и систему мер по контролю доступа к оборудованию. Для интернет-проекта в этом вопросе куда важнее опыт предоставляющей услуги компании, который, к сожалению, формальными параметрами оценить невозможно. Мы предлагаем клиентам целый ряд мер, направленных на повышение надежности их проектов. Например, быструю замену серверов, программные инструменты для резервирования данных и т. п. Так что надежность инженерной инфраструктуры является условием необходимым, но не достаточным, а присваиваемый класс TIER сегодня – это больше маркетинговый показатель. Поэтому для нас важны не столько формальные оценки качества инженерной инфраструктуры, сколько реальные показатели надежности размещаемых в ЦОД интернет-проектов.

Отказы и инциденты в ЦОД К сожалению, проводя опрос персонала, обслуживающего ЦОД, мы связали себя определенными обязательствами по неразглашению, в результате которых данное обобщение будет носить неполный и несколько расплывчатый характер. В итогах нашей классификации нашли свое отражение отказы центров разной величины (от продвинутых серверных, только в соответствии с украинскими реалиями именуемых ЦОД, до больших коммерческих центров), целевого предназначения (от решения конструкторских и производственных ИТ-задач на предприятии и бизнеса торговой розничной сети до предоставления телекоммуникационных услуг). Хотя по общему количеству принявших в ней участие специалистов эту выборку нельзя назвать репрезентативной. Сразу отметим, причиной половины незапланированных простоев названы изменения в инфраструктуре ИТ. За исключением коммерческих структур, программно-аппаратная среда которых была фактически реплицирована с хорошо отработанных (как правило, зарубежных) оригиналов, в большинстве недавно построенных ЦОД, основную «головную боль» у респондентов вызывали перманентные изменения в ней, а также процесс запуска и подгонки «под себя» систем комплексного мониторинга и управления центром и ИТ-структурой компании в целом. Причинами отказов на вводном оборудовании, проявляющихся в первую очередь на аварийных обходных цепях (bypass) при подключении к бесперебойным системам питания, стали неправильное проектирование щитов и игнорирование возможности привлечения профессионалов к этой, на первый взгляд, несложной подсистеме. Предпосылками послужили просчеты в оценке постоянно возрастающей мощности, потребляемой оборудованием центра. На втором месте респонденты назвали отсутствие (признавая недостаточную квалификацию собственных энергетиков) или некорректные сроки проведения регламентных работ по обслуживанию устройств защиты электрощитового оборудования. Неконтролируемый рост нагрузки сверх номинальной определил и основную причину аварий в подсистеме распределения питания. Причинами инцидентов, связанных непосредственно с системой бесперебойного питания и проявляющихся в форме аварийного отключение от питающей сети, сброса нагрузки (либо потери резервирования N+1) и непрогнозируемого снижения времени автономии, стали отсутствие контроля за потребителями электроэнергии, недостаточность мер по достоверному комплексному мониторингу состояния ИБП и, опять же, несоблюдение регламентов обслуживания (особенно в отношении батарейных подсистем). В качестве оптимального времени работы от АКБ указывалось не менее 15–20 мин при 100%-ной нагрузке. В отношении ДГУ перечень называемых проблем оказался еще короче: недостаточный учет климатических условий, их несвоевременное или не в полном объеме проводимое обслуживание, а также превышение фактической в сравнении с расчетной нагрузки на него. Интересно отметить, что проектные ошибки, связанные с несогласованностью генераторов и используемых ИБП, в ответах не фигурировали, что свидетельствует о правильном исходном расчете потребных мощностей субподрядчиками. Наиболее сложной по результатам опроса оказалась систематизация проблем, связанных с климатической системой. Среди главных претензий упоминались две основные: неточность поддержания параметров охлаждения и отказы всей системы кондиционирования, которые устранялись сервисной организацией. Количество сложностей, связанных с необходимостью поддержания единого теплового режима, возникших при доинсталляции оборудования в стойки (свыше 3–4 кВт), оказалось меньшим в тех центрах, где применяется конфигурация с холодными и горячими коридорами, и заглушек вместо неиспользуемых отсеков в открытых шкафах и стойках, предотвращающих смешение воздушных потоков и образование локальных зон перегрева оборудования. Ready, set, buy! Посібник для початківців - як придбати Copilot для Microsoft 365

Читайте также

|

Последние обсуждения

ТОП-новости

ТОП-блогиТОП-статьи |

|||||||||||||||||||||||||||

Спасибо за интересный материал. Возможно ли выложить в онлайн полную статью? На мой взгляд, доп. материалы трудно воспринимаются "в отрыве" от опубликованной статьи, тем более, хотелось бы прокомментировать эти материалы.

Полная версия статьи будет на сайте завтра.

Скажите, а откуда данные о структуре ТСО ? Это IDC или какой еще источник?