|

СПЕЦІАЛЬНІ

ПАРТНЕРИ

ПРОЕКТУ

Определение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях

Кто внес наибольший вклад в развитие украинского ИТ-рынка.

Награды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары

|

|

25 августа 2021 г., 14:52

Исследователи безопасности обеспокоены последствиями растущей популярности у производителей устройств Интернета Вещей (IoT) сторонних библиотек – готовых наборов кода, которые те могут использовать в своих устройствах, вместо того, чтобы писать код с нуля. При таком подходе любая уязвимость в часто используемых библиотеках автоматически переносится в огромную массу устройств IoT.

В исследовании, представленном на недавнем симпозиуме по безопасности USENIX, сотрудники Факультета компьютерных наук (CSD) Университета Карнеги-Мэллона (CMU) проверили 122 программных прошивки для 27 различных устройств умного дома, выпущенных за последние восемь лет. Их цель заключалась в том, чтобы узнать, насколько широко используются общие библиотеки среди поставщиков устройств, обновляются ли эти библиотеки для устранения уязвимостей и насколько быстро эти патчи попадают в конечное IoT-оборудование.

Они обнаружили, что отставание в применении общедоступных критических исправлений безопасности у ряда библиотек достигало сотен дней. Главный же вывод исследования заключается в том, что полагаться на то, что отдельные поставщики Интернета вещей будут оперативно обновлять используемые ими библиотеки, в целом, проблематично: это требует от последних слишком больших усилий, но дает им очень мало взамен.

Чтобы помочь устранить огромную угрозу для домашней среды IoT от неаккуратно обновляемых библиотек, команда CMU предложила новую систему под названием Capture. Она позволяет устройствам в локальной сети, такой как домашняя сеть Wi-Fi, использовать централизованный хаб, контролирующий их безопасность и регулярность обновления библиотек.

Чтобы гарантировать изоляцию Capture, авторы добавили новый интерфейс Virtual Device Entity (VDE), который облегчает управление доступом между устройствами с нулевым взаимным доверием, находящимися на одном хабе, создавая отдельный инстанс VDE для каждого из них.

Код для Capture с открытыми исходниками доступен на Github.

При тестировании новой системы несколько устройств IoT были успешно модифицированы для работы с Capture с минимальным ущербом для их производительности: задержка увеличилась менее, чем на 15%, а использование ресурсов – менее, чем на 10%. Было показано, что один Capture Hub со весьма скромным аппаратным обеспечением способен поддерживать сотни устройств, гарантируя актуальность их общих библиотек.

Не только пользователи умных домашних устройств получат выгоду от дополнительной защиты, которую может обеспечить Capture – в использовании системы могут быть заинтересованы и сами поставщики устройств, так как это избавляет их от необходимости самостоятельно следить за поддержанием безопасности своей продукции – дело, с которым они в любом случае часто не справляются.

Разработчики системы признают несколько существенных её недочётов, например тот факт, что Capture создает единую точку отказа. Эти ограничения – предмет дальнейшей работы.

12 августа 2021 г., 12:05

Совершенно новая концепция охлаждения изобретена в Венском техническом университете (TU Wien) в сотрудничестве со Свободным университетом Берлина (FU Berlin), Наньянским технологическим университетом Сингапура и Лиссабонским университетом (Португалия). Объединив термодинамику и квантовую физику, исследователи показали, что квантовые эффекты возможно использовать для дальнейшего охлаждения облака ультрахолодных атомов — конденсата Бозе-Эйнштейна (КБЭ).

С помощью техники, описанной в научном журнале Physical Review X-Quantum, можно ещё немного ближе подойти к абсолютному нулю. Предстоит проделать большую работу, прежде чем новую концепцию охлаждения можно будет превратить в действующий квантовый холодильник, но предварительные компьютерные симуляции уже показали, что это в принципе возможно.

Суть идеи заключается в том, что КБЭ делят на три части, изначально имеющие одинаковую температуру. «Вы можете добиться того, чтобы часть в середине действовала, если так можно сказать, подобно поршню, и позволяла передавать тепловую энергию с одной стороны на другую, — поясняет профессор Маркус Хубер (Marcus Huber) из TU Wien. — В результате одна из трёх подсистем охлаждается».

Энергия состояния, в котором КБЭ находится сначала, очень низкая, но не минимально возможная. Некоторые кванты энергии всё же присутствуют и могут изменяться от одной подсистемы к другой. Эти, так называемые «возбуждения квантового поля» и выполняют функцию хладоагента.

Пока что квантовый холодильник остаётся только теоретической концепцией, но в планах авторов уже значатся новые эксперименты. «Теперь, когда мы знаем, что идея в основном работоспособна, мы попытаемся реализовать её в лаборатории, — говорит Жоао Сабино (Joao Sabino ) из TU Wien. — Мы надеемся добиться успеха в ближайшем будущем».

Это должно стать впечатляющим шагом вперёд в криогенной физике — ведь независимо от того, какие другие методы использовались для достижения чрезвычайно низких температур, всегда можно будет добавить новый квантовый холодильник и сделать часть сверхохлаждённой системы еще холодней.

4 августа 2021 г., 11:43

У инноваций есть много определений. Apple, которую называют одной из самых инновационных компаний в мире, предпочитает руководствоваться собственной формулировкой – инновация это создание продукта или услуги, которые революционизируют отрасли и приносят огромную пользу клиентам.

Думай иначе – под этим лозунгом Apple выпустила множество продуктов, которые поставили конкурентов в положение догоняющих. В число таких переосмысленных продуктов входят: Apple II – компьютер «все в одном» с цветной графикой, расширяемой памятью и многим другим; Mac – доступный, массовый ПК с графическим пользовательским интерфейсом и мышью; ультратонкий, но при этом мощный MacBook Air; iPod и iTunes, «убившие» эру Walkmans; изящный смартфон без клавиатуры – iPhone и то же самое для персонального компьютера (iPad). Список относительно недавних нововведений Apple включает Apple Watch, Apple Pay, чипы серии A и M1.

Помимо этого (и смены Touch ID на Face ID), многое из того, что Apple сделала за последние несколько лет, трудно рассматривать как инновации. Скорее это были последовательные усовершенствования, призванные побудить потребителей покупать самые свежие модели.

В то же время Apple активно трансформируется из производителя оборудования в провайдера сервисов. Увеличивающиеся поступления средств от Apple Music, хранилища iCloud, iTunes и Apple Books, Apple Pay и Apple Pay Cash, TV и TV +, News +, Arcade, Fitness +, AppleCare +, Apple One и других новых предложений и пакетов услуг, а также увеличение базы платящих подписчиков, невзирая на участившиеся антимонопольные проблемы, могут превратить сервисы в обозримой перспективе в ведущий источник доходов компании.

Все это даёт критикам некоторые основания твердить о гибели Apple как инноватора. Насколько эти основания весомы?

Компании ставят в вину, что она не экспериментирует с телефонами, оснащёнными складывающимся экраном. Якобы отставая от конкурентов, таких как Motorola или Samsung с его Galaxy Z Flip 3 и Z Fold 3. Утверждают, что очки дополненной реальности (AR) Apple, которые могут появиться в этом или следующем году, нельзя считать инновацией, поскольку они копируют провальную технологию Google Glass.

Однако правда заключается в том, что инновации Apple возникали не на пустом месте. Свои продукты компания всегда выпускала по следам конкурентных аналогов, добиваясь несравнимо большего рыночного резонанса. Бесклавиатурный смартфон тогда мало кому известной китайской фирмы Lenovo был у меня за пять лет до выхода первого iPhone, примерно тогда же в нишевом профессиональном рынке обретались предшественники iPad – жутко дорогие планшеты Fujitsu. Дебют Apple Watch состоялся через шесть лет после выхода первых смарт-часов Fitbit, но именно он вызвал «тектонический сдвиг» мобильной отрасли, перемещением функций смартфона на запястье.

В свете вышесказанного уже не вызывает огорчения, что Apple не спешит, зажмурив глаза, нырять вместе с другими в авантюру со складными экранами. Ещё одно направление, требующее интенсивных капиталовложений при неясных перспективах успеха – разработка машин с автономным управлением. Здесь скорее стоит рассчитывать на партнёрство Apple с устоявшимися игроками – Waymo, Cruise или Tesla.

Гораздо более злободневной проблемой для Apple является не застой инноваций, а её краткосрочные финансовые перспективы. Вслед за сногсшибательным ростом доходов в мартовском квартале (54%), произошедшим на пике цикла обновления iPhone 12 и на контрасте с прошлогодним периодом начала пандемии, аналитики резонно ожидают отката, на который налагаются ослабление доллара, штамм «дельта» коронавируса, а также уже начавшаяся рыночная коррекция всплеска PE (price to earnings – показатель окупаемости акций) индекса S&P 500. Стимулированный ростом цен акций группы техногигантов, FAANGM (Facebook, Apple, Amazon, Microsoft Google), он в начале текущего года увеличился на 80% по отношению к среднему значению. Выше этой величины PE был только на пике «мыльного пузыря» доткомов.

Ожидается, что рост продаж iPad и Mac резко замедлится, примерно до 20% (по сравнению с 79 и 70% в мартовском квартале). Новые iPhone будут раскупать несколько лучше, но все равно ниже мартовского уровня (66%), поскольку у iPhone 13 почти наверняка не будет значимых преимуществ относительно iPhone 12.

Общий рост выручки может упасть с 28–32%, которые Apple в 2021 финансовом году, до 4% в 2022. Если же рост в этом году превысит ожидания, компания по итогам 2022 фискального периода даже может оказаться в убытке, считают аналитики.

27 июля 2021 г., 14:35

Приближающемуся слиянию Honeywell Quantum Solutions (HQS) и Cambridge Quantum (CQ) его участники предпослали три анонса важных свершений в технологиях квантовой информатики. В их числе процедура квантовой коррекции ошибок, новый рекорд квантового объёма и ускорение ПО для квантовой оптимизации.

Отсутствие возможности крупномасштабного исправления ошибок – сегодня одна из основных причин, по которым мы не можем создавать крупные отказоустойчивые квантовые компьютеры. Все существующие схемы коррекции требуют использования некоторого количества физических кубитов (от пяти до тысячи и более) для создания одного надёжного вычислительного кубита. При таком подходе, для реальных приложений, например, моделирования больших молекул, потребуются миллионы физических кубитов.

В квантовом компьютере Model H1 Honeywell впервые применила QCCD, усовершенствованную архитектуру ионных ловушек, обеспечивающую произвольное перемещение ионов и параллельные операции затвора в нескольких зонах.Использовав преимущества QCCD исследователи Honeywell впервые в отрасли реализовали возможность повторять циклы коррекции и определять необходимые исправления в ходе вычислений в реальном времени. Это представляет собой значительный шаг к реализации крупномасштабных квантовых вычислений.

Подтверждая ранее сделанный ею прогноз ежегодного удвоения квантового объёма, Honeywell объявила о достижении высочайшего в мире измеренного значения QV – 1024. Новый рекорд стал возможен благодаря продолжающемуся совершенствованию архитектуры и аппаратного обеспечения системы Model H1.

QV это синтетический показатель, характеризующий общую производительность квантовой системы с учётом не только количества кубитов, но и их связности, точности вентиля (gate fidelity), перекрестных помех и эффективности компилятора схем.

В системах Honeywell VQ последовательно возрастал с 64 у Model H0 в июне 2020 г. до 128 и 512 у Model H1, соответственно, в сентябре 2020 и марте 2021 гг.

Третьим анонсом стал Filtering Variational Quantum Eigensolver (F-VQE), улучшенный алгоритм для решения задач комбинаторной оптимизации. Он относится к гибридным алгоритмам машинного обучения, распределяющим работу между классическим и квантовым компьютерами.

Вариант, предложенный Cambridge Quantum, требует гораздо меньше кубитов для решения сложных задач оптимизации, чем оригинальный алгоритм VQL и Quantum Approximate Optimization Algorithm (QAOA). Фильтрующие операторы, которые были разработаны и опробованы на квантовом процессоре Model H1, позволили добиться ускорения сходимости решения на два порядка, улучшения его качества и снижения требований к аппаратным ресурсам.

HQS начала свою деятельность в 2018 году как бизнес-подразделение Honeywell International. Её приоритетная квантовая технология – это ионы иттербия в ловушках. CQ была основана четырьмя годами раньше, она занимается разработкой квантового ПО для квантовой химии, квантового машинного обучения и кибербезопасности с квантовым усилением.

Слияние HQS и CQ, которое должно состояться в третьем квартале 2021 года, станет логичным итогом их долгой истории совместной работы над квантовыми проектами, посвящёнными оптимизации, планированию и решению других задач корпоративного уровня.

9 июля 2021 г., 16:41

Исследователи из Чикагского университета (UChicago) продемонстрировали, как возросшая конкуренция беспроводных сетей в общих диапазонах рабочих частот может негативно влиять на качество интернет-услуг для обычных пользователей.

В частности, Wi-Fi работает в «нелицензируемой» полосе частот: это означает, что любое устройство или сеть могут также использовать этот спектр при условии соблюдения определенных правил передачи, установленных Федеральной комиссией по связи (FCC) США.

Для услуг сотовой связи было принято резервировать совершенно отдельную область радиочастотного спектра, которую сотовые провайдеры, такие как T-Mobile или AT&T, лицензируют в эксклюзивное использование на аукционах FCC. Сети, работающие на лицензированных диапазонах, не испытывают серьёзных помех. Это стоит миллиарды долларов, но позволяет наладить быстрый и надёжный сервис.

Тем не менее, за последние пять лет из-за роста количества пользователей и объёма трафик данных поставщиков услуг сотовой связи стали испытывать дефицит спектра. Чтобы улучшить пропускную способность при минимизации капитальных затрат, они начали использовать нелицензируемый спектр в тех же диапазонах, что и для Wi-Fi, посредством так называемого режима содействия лицензированному доступу (Licensed Assisted Access, LAA).

Чтобы изучить аспекты «сосуществования» в нелицензируемом спектре пользователей Wi-Fi и сотовой связи, команда UChicago настроила пять ноутбуков и смартфонов для доступа к локальным сетям Wi-Fi или для подключения к станции LAA, смонтированной в университетском кампусе. Каждое устройство было оснащено приложениями, которые позволяли измерять качество каждого сетевого подключения, как при низкой нагрузке (например, доступ к тексту на веб-сайте), так и при высокой (потоковая трансляция видео).

Пользуясь нескольким сетям одновременно, группа обнаружила, что конкуренция снижает производительность, уменьшая объём передаваемых данных, скорость передачи и ухудшая качество сигнала.

Особенно сильно конкуренция ударила по Wi-Fi. При активном использовании LAA, объём данных, передаваемых через Wi-Fi, уменьшался на 97%! В то же время, пропускная способность LAA демонстрировала снижение лишь на 35%.

Дело тут в разных протоколах разделения доступа. Поскольку Wi-Fi полностью базируется в нелицензируемой части спектра, то использует протокол, адаптированный к непредсказуемому спросу. Если несколько пользователей Wi-Fi пытаются получить доступ к сети одновременно, этот протокол, называемый listen-before-talk (слушай, потом говори), назначает каждому из них случайное время ожидания, что снижает вероятность конфликта интересов.

В отличие от этого, операторы сотовой связи привыкли иметь дело с прогнозируемым спросом и, поэтому, назначают каждому пользователю одинаковую длительность передачи. Таким образом, работа LAA больше похожа на выступления с жёстко запланированным регламентом, чем на неформальную вечеринку.

С приходом сотовых коммуникаций на нелицензируемые частоты, принятые в LAA политики регулирования доступа к каналу стали ущемлять интересы пользователей Wi-Fi.

Недавно в LAA тоже был реализован протокол listen-before-talk, однако, с существенными отличиями от Wi-Fi. Так, в LAA каждое устройство может удерживать полученный доступ до 10 миллисекунд, тогда как «окно» передачи в Wi-Fi закрывается уже через 4 мс.

«Сосуществование Wi-Fi/Wi-Fi выглядит не так уж и плохо благодаря процедуре listen-before-talk, поэтому мы использовали это как стандарт честности. Но у Wi-Fi/LAA всё обстоит хуже, и мы были удивлены тем, насколько хуже», — говорят исследователи.

В будущем они рассчитывают изучить, как конкурируют между собой сети LAA разных провайдеров сотовой связи.

Кроме того, на основе результатов исследований авторы выработали рекомендации для регулирующих организаций по дальнейшему улучшению согласования сетевых протоколов.

1 июля 2021 г., 12:18

Халатность одного из разработчиков Western Digital оказалась подлинной причиной массового обнуления настроек и содержимого сетевых накопителей WD My Book Live, приведшего не только к потере петабайт пользовательских данных, но и к нарушению работы преступного ботнета, построенного на этих устройствах.

Согласно анализу самого уязвимого кода, выполненному фирмой кибербезопасности Censys, предусмотренная в My Book Live проверка аутентичности пользователя (пять строк кода PHP в файле system_factory_restore) по неизвестным причинам оказалась закомментированной двойным символом ”/“ в начале каждой строки.

function post($urlPath, $queryParams = null, $ouputFormat = 'xml') {

// if(!authenticateAsOwner($queryParams))

// {

// header("HTTP/1.0 401 Unauthorized");

// return;

// }

Это открытие было сделано через пять дней после того, как владельцы My Book Live во всем мире сообщили, что их устройства были взломаны и возвращены на заводские настройки с удалением всех хранившихся данных.

Сотрудники Western Digital сначала заявили, что массовое стирание данных произошло в результате использования злоумышленниками CVE-2018-18472. Эта уязвимости удалённого выполнения команд была обнаружена в конце 2018 года, но не была исправлена, так как тремя годами ранее Western Digital прекратила поддержку My Book Live.

Позже, под давлением фактов, предоставленных фирмой Censys, WD скорректировала свою позицию: «Мы можем подтвердить, что по крайней мере в некоторых случаях злоумышленники после CVE-2018-18472 использовали уязвимость заводского сброса настроек».

И в самом деле, некоторые из пострадавших устройств My Book Live были взломаны с помощью CVE-2021-18472 после чего были заражены вредоносным ПО .nttpd,1-ppc-be-t1-z, что сделало их частью ботнета под названием Linux.Ngioweb.

Однако зачем кому-то, кто успешно скомпрометировал столько My Book Live вдруг ломать исправно функционирующий ботнет? Больше того, зачем при наличии полноценного root-доступа использовать для сброса настроек недокументированный обход аутентификации?

Готовых ответов пока не имеется, но Censys в своем недавнем блоге выдвинула вполне правдоподобную гипотезу: «… это может быть попытка конкурирующего оператора ботнета захватить эти устройства или сделать их бесполезными, либо это действия кого-то ещё, желавшего обвалить ботнет, работавший как бы не с 2015 года, когда эти уязвимости возникли».

Обнаружение второй уязвимости добавляет веса рекомендации Western Digital всем пользователям срочно отключить свои My Book Live от Интернета, но несомненно, наносит урон репутации этой компании, как производителя безопасных устройств.

Тем не менее, Censys утверждает, что серия My Cloud Live, пришедшая на смену My Book Live от Western Digital, имеет другую кодовую базу, которая не содержит ни одной из уязвимостей, задействованных в июньском массовом инциденте.

Со своей стороны, Western Digital вчера объявила, что с начала июля будет предоставлять услуги по восстановлению данных бесплатно. Кроме того, клиенты My Book Live получат право на участие в программе трейд-ин для замены своих устройств на My Cloud. Компания также предоставила дополнительные технические подробности о второй уязвимости, который получила наименование CVE-2021-35941.

18 июня 2021 г., 12:57

Подавляющее большинство услуг высокоскоростного доступа к Интернет в мире осуществляется через наземные сети — кабельные, DSL, оптоволоконные и беспроводные вышки, а меньшая часть обеспечивается через региональные спутниковые сети. С 1990-х годов предпринимались различные попытки по запуску на низкую околоземную орбиту сетей не-геостационарных спутников для предоставления услуг глобальных широкополосных коммуникаций. Однако такие проекты как Iridium и Globalstar быстро показали свою экономическую несостоятельность перед лицом стремительно расширяющейся наземной инфраструктуры.

В последние годы спутниковые аппаратные и программные технологии продвинулись вперед, и спрос на широкополосную связь вырос, так что идея глобального интернет-покрытия из космоса приобрела новую актуальность. Эскадры спутников SpaceX и OneWeb уже мешают наземным астрономам и друг другу на орбите, а Telesat и Amazon быстро нагоняют их, создавая собственные созвездия.

Исследователи с факультета аэронавтики и астронавтики Массачусетского технологического института провели исследование по сопоставлению возможностей четырех крупнейших глобальных спутниковых сетей, предложенных SpaceX, Telesat, OneWeb и Amazon. Пропускную способность каждой сети они рассчитывали на основе технических характеристик, предоставленных соответствующими компаниями в Федеральную комиссию по связи (FCC). Статья с подробным описанием методологии их исследований и сделанных выводов будет представлена на этой неделе на Международной конференции IEEE по коммуникациям.

Используя новейшие данные из петиций FCC о количестве и орбитах спутников, команда смоделировала конфигурацию каждого из них поминутно в течение одного дня. Также были использованы атмосферная модель для изменения окружающих условий в текущий момент и модель спроса, которая оценивала количество пользователей в зоне покрытия спутника.

В целом было установлено, что все четыре сети имеют сопоставимую пропускную способность: 25,4 Тб/с — Telesat , 30,3 Тб/с — OneWeb, 27,2 Тб/с — SpaceX и 53,4 Тб/с — Amazon (с межспутниковыми оптическими каналами 20 Гб/с). Однако достигается это разными способами.

Например, у Telesat меньше спутников (около 1600), однако каждый из них обладает расширенными возможностями по сравнению со спутниками сети OneWeb, которая компенсирует это гораздо большим их количеством на орбите (более 6000).

Проект Starlink ближе всего к вводу в эксплуатацию: SpaceX запустила более 1000 из запланированных 4400 спутников. В своей последней петиции компания снизила высоту орбит спутников для увеличения общей пропускной способности.

Спутниковая конфигурация Amazon способна обеспечить наивысшую скорость передачи данных из четырех сетей (теоретический предел 55,6 Тб/с) за счёт двукратного перевеса в количестве наземных шлюзовых антенн (около 4000 по всему миру).

Авторы отмечают, что эти компании постоянно пересматривают спецификации с целью получить более производительные системы. Вероятно, это может изменить относительное положение внутри рассматриваемой четвёрки, но, вообще говоря, мегасозвездия не имеют шансов составить реальную конкуренцию существующим наземным сетям, которые способны поддерживать тысячи терабит в секунду.

Их преимущество — в другом: космический флот должен заполнить пробелы нынешнего покрытия, например, в сельских районах, удаленных полярных и прибрежных регионах, в воздухе и в океанах.

«Мы не окажемся в ситуации, когда густонаселенные регионы, такие как Нью-Йорк или Лос-Анджелес, будут полностью обслуживаться спутниками, — говорит Иниго Дель Портильо (Inigo Del Portillo) из группы системной архитектуры MIT. — Но эти группировки могут обеспечить большую пропускную способность там, где прямо сейчас нет вообще никаких сервисов, нет оптоволокна. Это может действительно изменить жизнь в этих областях».

14 июня 2021 г., 18:09

Снятие грифа секретности на этой неделе позволило ФБР поведать миру об изящной, иначе не назовёшь, операции по борьбе с организованной преступностью, которую эта организация провела совместно с Австралийской федеральной полицией (AFP).

Организованный ими сервис обмена секретными сообщениями с помощью специализированных портативных устройств, получил широкое распространение в преступной среде, что позволило правоохранителям перехватывать криминальную переписку по всему миру на протяжении более трёх лет.

Операция под названиями Ironside (AFP) и Trojan Shield (ФБР, Интерпол) стартовала в октябре 2018 г., сразу после того, как ФБР прекратила деятельность платформы шифрованного чата Phantom Secure, приговорив к 9-летней отсидке и штрафу в 80 млн долл. её генерального директора, Винсента Рамоса (Vincent Ramos).

Расследование деятельности Phantom Secure впервые наглядно показало насколько важное значение устройства с усиленным шифрованием (hardened encrypted device) имеют для всевозможного нелегального бизнеса.

Устройства Phantom Secure были сугубо однозадачны и не могли использоваться для обычных телефонных звонков или для просмотра Интернета, на них нельзя было устанавливать приложения. Стоил такой недосмартфон от 1500 до 2000 долларов с шестимесячным шифровальным планом. При этом приобрести его обычном магазине или через Интернет было невозможно; потенциальные покупатели должны были быть знакомы с известными дистрибьютором, иначе с ними никто даже не начинал разговор.

В силу вышесказанного не должно удивлять, что расследование не выявило случаев приобретения устройств Phantom Secure просто зацикленными на защите своей приватности людьми – это был коммуникатор, ориентированный исключительно на преступные синдикаты.

Зная, что после исчезновения Phantom Secure преступный мир будет искать новую платформу, AFP и ФБР оперативно запустили собственный сервис на базе зашифрованной чат-платформы Anøm (или Anom). К ней ФБР тайно получила доступ через сотрудничающего с властями инсайдера.

Как и Phantom Secure, новая служба состояла из защищенных смартфонов, которые были настроены для запуска только приложения Anom и ничего больше. Устройство, распространявшееся между знакомыми, не имело телефонного номера, а обмен сообщениями осуществлялся через центральную платформу Anom.

Чтобы приспособить Anom для негласного надзора, ФБР, AFP и их контакт-инсайдер внедрили в существующую систему шифрования мастер-ключ, который тайно прикреплялся к каждому сообщению.

Все Anom за пределами США, были настроены на отправку скрытых копий (BCC) своих сообщений стороннему боту XMPP, которого ФБР назвало iBot. Этот бот расшифровывал сообщения мастер-ключом, а затем повторно зашифровывал их с помощью ключей шифрования, которыми управляла ФБР.

Такая схема позволяла ФБР перехватывать сообщения и расшифровывать тексты, отправляемые членами банды друг другу. Хотя схему разработало ФБР, из-за проблем с юрисдикцией просматривали эти сообщения в основном австралийские власти, которые передавали итоговую информацию в США три раза в неделю.

Согласно судебным документам, схема оказалась настолько успешной, что пришлось подключить к просеиванию более 26 млн зашифрованных сообщений.ещё один сервер iBot в неназванной стране (предположительно в ЕС).

Первоначально распространением устройств An0m занимались агенты под прикрытием, но впоследствии, властям удалось закрыть конкурирующие платформы, такие как EncroChat в июле 2020 г и Sky Global – в марте 2021 г., что сузило выбор для преступников. В конечном итоге сеть Anom насчитывала около 12000 пользователей из более 100 стран, которые относились примерно к трём сотням криминальных группировок – от байкерских банд в Австралии до наркокартелей Азии и Южной Америки, а также торговцев оружием и людьми в Европе.

В первую пятерку стран, где использовались устройства Anom до прекращения работы этого сервиса во вторник, вошли Австралия, Германия, Нидерланды, Испания и Сербия.

На пресс-конференции 8 июня Ironside была охарактеризована, как одна из крупнейших спецопераций в истории правоохранительных органов. По её итогам было выдано 525 ордеров на обыск, предъявлено обвинение 224 лицам, ликвидировано шесть подпольных лабораторий и предотвращена 21 угроза убийства. Попутно было изъято 3,7 тонны наркотиков, 104 единицы огнестрельного и другого оружия, а также активы на сумму более 45 млн австралийских долларов.

Однако, главной целью, преследовавшейся и успешно выполненной операцией Trojan Shield, было посеять недоверие подпольного мира ко всей отрасли коммуникационных устройств с усиленным шифрованием.

Согласно официальной информации, закрыли спецоперацию из-за истечения срока действия ордера на перехват 7 июня, но, похоже, для некоторых преступных групп уже в марте этого года перестало быть секретом, что приложение Anom передаёт их разговоры на сторонние серверы XMPP.

11 июня 2021 г., 12:31

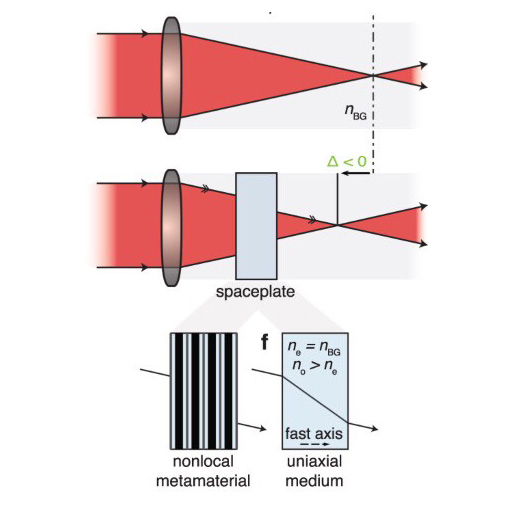

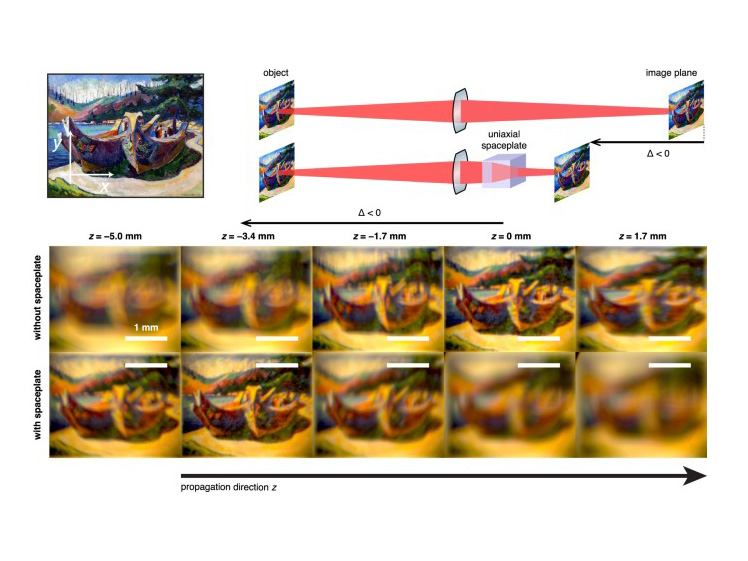

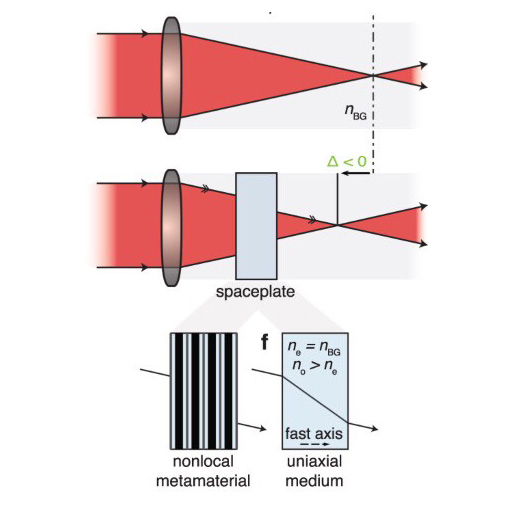

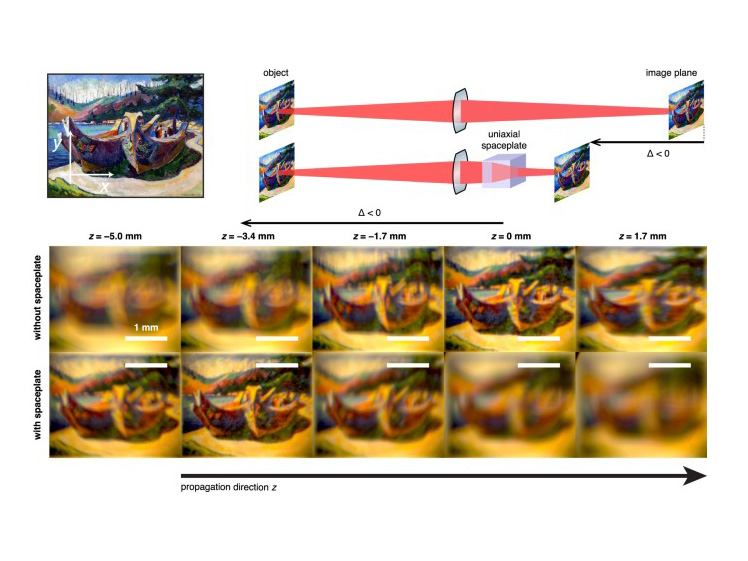

Многовековые усилия по совершенствованию оптического оборудования были сосредоточены главным образом на комбинировании линз для получения лучших оптических характеристик и новых функций. Что-то кардинально изменилось лишь с приходом нанотехнологий — появились плоские металинзы, которые обещают сделать устройства формирования изображений гораздо более компактными.

Однако 400 лет прогресса прошли мимо другой компоненты оптических систем, которая имеет такое же решающее значение для формирования изображений, как и линзы, но занимает гораздо больше места — пространство между линзами.

В работе, представленной на страницах журнала Nature Communications, канадские инженеры из Университета Оттавы (uOttava), предприняли первую попытку найти решение этой проблемы с помощью новой концепции, так называемых пространственных пластин (spaceplate). В своей основе этот подход родственен линиям задержки в коммуникационной технике, так как базируется на идее системы, в которой свет проходит существенно более длинный путь, чем её внешние габариты.

Пластинка, эффективно сжимающая внутри себя значительный отрезок траектории лучей, могла бы способствовать миниатюризации любых устройств, манипулирующих пространственным профилем света (включая солнечные концентраторы, коллиматоры источников света и спектрографы), а в комбинации с металинзами — открыть путь к сверхтонким монолитным камерам, телескопам толщиной с лист бумаги и прочим чудесам.

Помимо разработки самой концепции, её спектрального анализа и полноволновых симуляций, авторы также экспериментально изготовили две разновидности оптических пространственных пластин. Одна из них состояла из нелокального метаматериала — множества чередующихся слоёв кремния и силиката, другая — однородная — была вырезана перпендикулярно главной оси кристалла кальцита и имела анизотропию коэффициента преломления.

Из-за скромного показателя сжатия (менее 5x) оба этих варианта не имели реальной практической ценности. Тем не менее, они показали, что пространственные пластины могут быть независимы от поляризации света, работать в широком диапазоне длин волн и иметь большие цифровые апертуры. В теории, такие устройства могут совмещать в себе все эти качества.

Говоря о значении их работы, главный автор статьи, Орад Решеф (Orad Reshef) заявил: «Удивительно, что хотя оптические элементы, такие как линзы, существуют уже тысячу лет, а правила их конструирования хорошо известны уже более 400 лет, мы всё ещё открываем такие фундаментальные новые оптические элементы для создания изображений».

Сейчас группа из uOttava активно работает над следующим поколением этой технологии, в котором они рассчитывают увеличить коэффициент сжатия с 5 до болеее 100 крат и улучшить общие характеристики spaceplate.

3 июня 2021 г., 11:58

Интернет задумывался его пионерами как среда мгновенного и свободного доступа ко всей информации, накопленной человеческой цивилизацией. Реальная Сеть оказалась далека от этого идеала: содержимое, представляющее какой-либо интерес, всё труднее найти за пределами подписных сервисов, охраняемых зубастыми юристами. Но даже та информация, что вроде бы общедоступна онлайн, остаётся таковой ненадолго.

Гиперссылки это мощный инструмент в научных исследованиях и журналистике. Они позволяют бороться с недостоверной или фальсифицированной информацией, предоставляя гиперссылки на первоисточники цитируемых фактов или высказываний.

URL-адресами управляют хостинг-провайдеры. Когда они, преднамеренно или нет, удаляют содержимое веб-ресурса, читатели натыкаются на сообщение о недоступности веб-сайта. Это, обычно, необратимое разложение веб-контента и называют термином линкрот (link rot – протухание ссылок). Родственная линкроту проблема дрейфа контента (content drift) подразумевает замену, модификацию или удаление (в большинстве случаев без какого-либо предупреждения) содержимого по определённому URL-адресу.

Целью получить количественное представление о скорости, с которой «протухает» Интернет, задалась группа исследователей из Гарвардской юридической школы в совместном проекте с New York Times, этим признанным «законодателем мод» в цифровой журналистике, обладающим отлаженной процедурой архивирования контента.

Этой работой было охвачено 553 693 статей, размещённых на ресурсе nytimes.com со времени его открытия в 1996 году и по середину 2019 года. Эти статьи содержали в общей сложности 2 283 445 гиперссылок на контент за пределами nytimes.com. Семьдесят два процента из них были «глубокими ссылками», ведущими к определённой странице, например example.com/article, (в отличие от корневого адреса example.com).

Для измерения линкрота был написан скрипт, автоматизировавший посещение каждого из уникальных «глубоких» URL-адресов в анализируемом наборе данных и регистрацию кодов HTTP-ответов, перенаправлений и тайм-аутов сервера. На основе этого каждая ссылка помечалась как «испорченная» (удаленная или недоступная), либо «неповрежденная» (возвращающая нормальную страницу).

Анализ показал, что 25% массива глубоких ссылок оказались полностью недоступны. Также была продемонстрирована прямая зависимость вероятности линкрота от давности: протухло 6% ссылок за 2018, 43% за 2008 и 72% за 1998 г. Из статей с глубокими ссылками, свыше половины (53%) содержали хотя бы одну, ведущую на более не существующий контент.

Некоторые разделы Times были более подвержены линкроту, чем другие. Например, спортивные ссылки демонстрируют относительную скорость разложения (Relative Rot Rate) примерно 36%, а в разделе «Итоги» (Upshot) – всего 13%. Исследователи объясняют это в первую очередь тем, что средний возраст ссылок Upshot гораздо меньше и составляет 1450 дней, тогда как в Sport это 3196 дней.

Озабоченность авторов исследование вызвал и тот факт, что глубокие ссылки на такие домены, как .gov или .edu, показывают относительно более высокий уровень разложения. Например, ссылки на Белый Дом (whitehouse.gov) при каждой новой администрации кардинально меняются как по содержанию, так и по структуре.

Разумеется, наличие по указанному адресу работающей страницы ещё не даёт гарантии, что изначальный контент там не был заменён на информацию, не имеющую с ним ничего общего, либо вводящую в заблуждение.

Для оценки дрейфа контента исследователи вручную проверили наполнение 4500 страниц, выбранных случайным образом из массива URL, обозначенных скриптом как неповрежденные. Было установлено, что 13% URL из этой выборки существенно «сдрейфовали» с тех пор как Times опубликовал их. При этом, в статьях за 2019 г. дрейф обнаружен в 4% работающих ссылок, по сравнению с 25% в 2009 г.

Приводимые исследователями результаты, – отнюдь не камень в огород New York Times, скорее всего общая ситуация в современном онлайновом цитировании является ещё более удручающей.

Цифровая журналистика значительно выросла за последнее десятилетие, став важной частью творения истории. Подрыв доверия к ней фундаментальной нестабильностью Интернета указывает на необходимость новых практик, рабочих процессов и технологий.

Хорошим подспорьем в исправлении ущерба от линкрота и дрейфа контента могут стать службы веб-кэширования, такие как Internet Archive, хранящие впечатляющую, пусть и далеко не полную коллекцию моментальных снимков веб-сайтов. Следует улучшать видимость подобных веб-архивов как инструмента для читателей или даже автоматически перенаправлять на архивы неработающие ссылки, как это делает сообщество Википедии.

Инструментальная среда цифровой публикации должна предоставлять журналисту выбор, вставлять ли динамическую ссылку – с риском линкрота и дрейфа контента, но с возможностью расширенного изучения темы, или ограничиться замороженным фрагментом архивного материала, демонстрирующего только то, что подразумевал автор на момент публикации. Новые технические инструменты оптимизации такого усложнившегося процесса, смогут предоставить авторам максимальный контроль над тем, как их творения взаимодействуют с другим веб-контентом, сделать обеспечение сохранности ссылок интегральной частью цифровой журналистики.

По мнению авторов исследования, реализация действенной стратегии невозможна без более плотного и широкого взаимодействия библиотек, специалистов в информационной сфере и цифровых сервисов публикации новостей, и, в конечном итоге, без автоматизированных средств надёжного обнаружению линкрота и дрейфа контента.

|

|

|