|

СПЕЦІАЛЬНІ

ПАРТНЕРИ

ПРОЕКТУ

Определение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях

Кто внес наибольший вклад в развитие украинского ИТ-рынка.

Награды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары

|

|

27 апреля 2018 г., 18:31

Современные потоковые камеры перед передачей видео по Wi-Fi самостоятельно обрабатывают и сжимают его. На это тратится много энергии, особенно если речь идёт о качественном видео, и из-за этого беспроводная HD-камера, работающая без подключения к постоянному источнику энергии, до сих пор была практически неосуществима.

Метод обратного рассеяния (backscatter), при котором устройство использует энергию передаваемого ему сигнала для отсылки информации, до сих пор считался пригодным только для связи с оборудованием Интернета Вещей (IoT), таким как автономные температурные датчики, с очень низкой скоростью коммуникаций.

Распространить эту концепцию на трансляцию высококачественного потокового видео смогли инженеры Вашингтонского Университета (UW) в Сиэтле. Сконструированный ими прототип способен передавать HD-видео (720p) с частотой 10 кадров в секунду на расстоянии до 14 футов (4,3 м).

cfm.JPG)

В нём отсутствуют компоненты, отвечающие за обработку и коммуникации с традиционном смысле. Вместо этого, пиксели напрямую «завязаны» на антенну и пересылают методом обратного рассеяния свои показания интенсивности света на смартфон, находящийся поблизости. Система транслирует пиксельную информацию каждого кадра как серию импульсов: длительность каждого из них соответствует яркости соответствующего пикселя.

Смартфон не имеет жёстких ограничений на размеры и вес, свойственных миниатюрным камерам, поэтому изобретатели вполне логично переместили на его ресурсы функции обработки видео. За счёт этого прототип UW в ходе испытаний показал расход энергии в 1000-10000 раз меньше, чем у современных потоковых видеосистем.

Свои достижения команда UW представила 10 апреля на симпозиуме Ассоциации подвинутых компьютерных систем (ACSA), посвящённом проектированию и реализации сетевых систем.

Следующей задачей авторов будет убрать из беспроводного устройства даже ту небольшую батарейку, что пока используется, чтобы обеспечивать вещание в непрерывном режиме. Они также учредили стартап Jeeva Wireless, который займётся коммерциализацией этой технологии.

25 апреля 2018 г., 12:25

Четыре года назад, Amazon представила спикер Echo, открывший миллионам людей возможность говорить с компьютером. Теперь, по информации Bloomberg, компания работает над очередным аппаратным проектом, который может сделать роботов обыденным предметом домашней обстановки.

Попытки создать домашний робот восходят ещё к 1983 г., когда основатель Atari, Нолан Бушнелл (Nolan Bushnell) представил метровую модель Topo Robot. Со всеми последовавшими в дальнейшем потребительскими роботизованными устройствами Topo Robot роднили две вещи: 1) он мало что умел и 2) очень плохо продавался. Исключение составляет, разве что робот-пылесос Roomba, его уже продано более 20 млн экземпляров. Но это узкоспециализированное устройство было бы некорректно считать полноценным домашним роботом, чьё главное достоинство — универсальность.

О проекте Amazon под кодовым именем Vesta (римская богиня дома и семьи), известно очень мало. Работа над ним ведётся под руководством Грегга Зера (Gregg Zehr) в недрах секретной лаборатории Lab126 в Саннивейле (штат Калифорния). В Lab126 родились многие, получившие широкую популярность продукты Amazon, такие как планшеты Fire, телеприставки Fire TV и вышеупомянутые спикеры Echo.

Проект Vesta стартовал несколько лет назад, но начиная с этого года Amazon активизировала поиск квалифицированного персонала для него. Для работы в Lab 126 набираются десятки специалистов, среди вакансий на веб-странице лаборатории имеются такие, как «программный инженер-робототехник» и «главный инженер по сенсорам».

Цитируемые Bloomberg инсайдеры сообщили о планах Amazon приступить к «полевым» испытаниям новых роботов в домах своих сотрудников уже в 2018 г. Потребительский дебют Vesta пока отнесён на 2019 г., однако источники предупредили, что график подготовки продукта может быть подвержен изменениям, вплоть до отмены проекта.

Официальная Amazon отказалась от комментариев. Остаётся только предполагать будет ли Vesta, чем-то бóльшим, чем спикер Echo на самодвижущейся тележке. По крайней мере, информаторы внутри компании однозначно заявляют, что Vesta не имеет ничего общего с Amazon Robotics (бывшая Kiva Systems), дочерним предприятием, производящим роботы для сортировки и перемещения товаров на складах Amazon.

Bloomberg указывает, что масштабы бизнеса Amazon и её массивная экосистема клиентов способны послужить хорошим «трамплином» для удачного старта роботов, как новой категории домашних устройств. Гигант розничной торговли имеет возможность даже частично субсидировать цены на Vesta, сделав робота более доступной покупкой для 90 млн подписчиков Amazon Prime.

Research and Markets оценивает нынешний рынок потребительских роботов в 5,4 млрд долл. с перспективой роста до 15 млрд долл. к 2023 г.

19 апреля 2018 г., 19:46

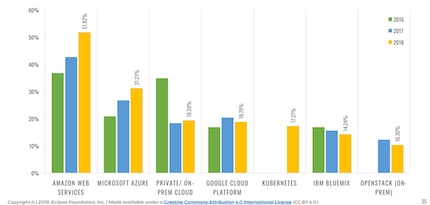

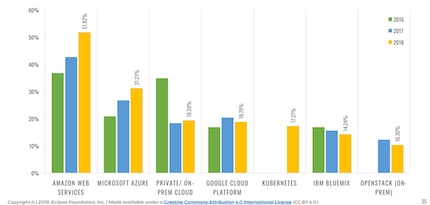

Ключевые сегодняшние тренды индустрии Интернета Вещей (IoT) выявил новый отчёт, опубликованный Eclipse Foundation. За последние четыре года IoT Developer Survey стал признанным ориентиром для профессионалов и организаций, стремящихся уяснить какие стандарты и технологии лучше использовать для реализации своих IoT-проектов. Нынешняя редакция подготовлена Eclipse IoT Working Group вместе с Agile-IoT H2020 Project, IEEE и Open Mobile Alliance (OMA SpecWorks) на основании опроса 504 профессионалов, проводившегося с января по март текущего года.

Самым интересным наблюдением, пожалуй, стала изменившаяся динамика внутри тройки ведущих провайдеров публичных облачных платформ. Согласно другому недавнему опросу Stack Overflow Developer Survey, AWS уверенно лидирует среди публичных облачных платформ по популярности у разработчиков. Её предпочли 24,1% респондентов, тогда как Azure отдали свои голоса 11%, а Google Cloud – всего 8%.

(изображение кликабельно)

Поэтому нет ничего удивительного в том, что, по данным IoT Developer Survey, использование AWS во всем мире за последние годы растёт, причём увеличивающимися темпами. В нынешнем году её приверженцев оказалось 51,8%, на 21% больше, чем в прошлом году.

Для Azure, на продвижение которой в IoT компания Microsoft заложила в 4-летний бюджет 5 млрд долл., также характерна восходящая тенденция с долей 31,21% и ростом за последний год на 17%. А вот в IoT-динамике Google Cloud рост сменился спадом, доля этой платформы уменьшилась на 8% до 18,8%. На продолжающую терять позиции IBM Bluemix ныне приходится 14,24%. Таким образом, можно констатировать факт, что в сегменте облачных сервисов для IoT набирает силу процесс консолидации с вытеснением менее значительных игроков.

Будет интересно, сможет ли Google, по которой проходит линия раздела на победителей и проигравших, обратить для себя вспять эту тенденцию, например, путём укрепления своих IoT-активов поглощениями, подобными февральской покупке Xively.

Среди других знаковых выводов обзора можно отметить изменение приоритетов разработчиков IoT. На первом месте у них традиционно остаются вопросы безопасности создаваемых решений, однако проблемы подключения устройств и аппаратной интеграции в этом году впервые оказались оттеснены на задний план углубившимся пониманием важности сбора данных и их анализа. За приоритетность Data Collection & Analytics проголосовали 18% респондентов, на 50% больше, чем год назад. Занимавшее же второе место в 2015 г. обеспечение взаимосовместимости, за прошедшие годы сдрейфовало на дальнее пятое место.

В области коммуникационных протоколов для IoT неожиданностей не произошло, статус-кво лидера с 62% подтвердил MQTT, за ним с 54,1% следует HTTP. Все реже используются закрытые протоколы, что лишний раз указывает на движение индустрии к открытым стандартам.

В обеспечении безопасности IoT наиболее популярными практиками остаются защита на уровне коммуникаций (например, с помощью TLS или DTLS) и шифрование данных, на их доли приходится 57,3 и 45,1 процентов голосов опрошенных разработчиков.

Участникам нынешнего исследования впервые был задан вопрос об использовании блокчейн в их IoT-решениях. Положительно ответили сразу 11% респондентов, что свидетельствует о быстром взрослении технологии распределённых регистров (DLT). Также из ниоткуда и сразу на 12% в рейтинг «впрыгнула» платформа контейнерной оркестровки Kubernetes.

В полтора раза с прошлого года выросло применение беспроводных (over-the-air) обновлений IoT-приложений. Наиболее часто собираемым типом данных признаны (61,9%) временные ряды, то есть информация с периодически опрашиваемых датчиков. Тем не менее, самыми распространёнными СУБД остаются реляционные, в частности, MySQL с долей 44%. Из NoSQL и специализированных решений для хранения временных рядов самые популярные это MongoDB (29,8%) и InfluxDB (15,7%).

Подавляющее большинство (93%) баз данных в IoT это продукты с открытым кодом. Продолжая эту тенденцию, безусловным лидером из операционных систем здесь является Linux (71.8%) с самыми популярными дистрибутивами – Raspbian (43,3%) и Ubuntu (40,2%). На первое место среди встраиваемых в IoT-устройства систем реального времени вышла FreeRTOS. Её рейтинг за год вырос с 13 до 20%, на что, без сомнения, повлияло поглощение FreeRTOS компанией Amazon.

13 апреля 2018 г., 18:09

Коллектив исследователей из Университета Бен Гурион (Израиль) продолжает открывать новые грани уязвимости компьютеров, физически изолированных от внешних коммуникаций.

Некоторые из продемонстрированных ими ранее атак весьма изобретательны, например, утечка данных через мигающий светодиодный индикатор ПК на зависший за окном дрон или дистанционная запись низкочастотного магнитного излучения процессора – от неё не спасает даже клетка Фарадея.

В новой статье, размещённой на сервере Arxiv.org, группа Мордехая Гури (Mordechai Guri) показала, что при достаточной настойчивости и терпении изолированный «air-gapped» ПК можно взломать также через электросеть.

bez.JPG)

Как и многие продемонстрированные до этого методы – электрические, магнитные, оптические, тепловые и акустические – эта атака, получившая название PowerHammer, требует наличия на изолированном компьютере шпионской программы. Такая программа регулирует степень использования центрального процессора и благодаря этому может управлять моментальным энергопотреблением всей системы.

«Данные модулируются, кодируются и передаются, наложенные на флуктуации тока, распространяясь по линиям энергоснабжения», – пишет Гури. Он подчеркнул, что электропроводка сегодня используется для коммуникаций в умных домах и в промышленных приложениях. Авторам потребовалось лишь адаптировать эту технологию для скрытых коммуникаций посредством «паразитных сигналов», генерируемых вредоносным кодом.

Взломщик может подключить свой датчик, измеряющий это кондуктивное излучение, к проводам питания, идущим к компьютеру (уровень линии) или разместить его в распределительном щите всего этажа (уровень фазы).

Авторы провели натурные испытания метода, в них целями атаки PowerHammer были сервер, настольный ПК и маломощное устройство IoT. Они показали, что извлекать данные из шума энергосети и преобразовывать их в двоичный вид можно со скоростью 1000 бит в секунду при подключении на уровне линии и 10 бит в секунду – на уровне фазы.

В качестве мер противодействия атаке PowerHammer авторы рекомендуют мониторинг отклонений от стандартного рисунка помех в энергосети, а также использование фильтров электромагнитного излучения и аппаратных подавителей сигналов.

11 апреля 2018 г., 10:45

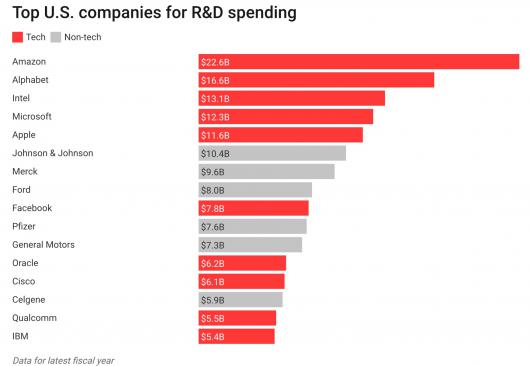

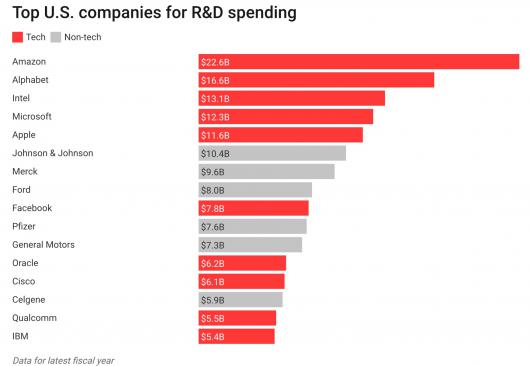

В прошлом году технологические компании снова заняли пять верхних мест в США по ассигнованиям на исследования и разработку (R&D), инвестировав суммарно 76 млрд долл. Возглавила список Amazon, которая в 2017 г. израсходовала 22,6 млрд долл., на 41% больше, чем в 2016 г. (когда тоже лидировала в рейтинге).

Amazon закачивает финансовые ресурсы в AWS, Alexa и в такие технологии, как компьютерное зрение, поддерживая амбициозные проекты наподобие Amazon Go – магазина будущего, работающего без кассиров. Компания недавно стала объектом Twitter-атак президента Трампа, обвинившего её в уклонении от выплаты положенных налогов и в злоупотреблении услугами национального почтового сервиса USPS.

Расходы на R&D важны не только потому, что вносят вклад в инновации и доминирование самой этой компании, но также поскольку повышают национальную продуктивность, составляя примерно 3% валового внутреннего продукта (ВВП).

Темпы роста продуктивности, которая, наряду с R&D, учитывает такие показатели, как заработную плату и отработанные часы, оставались непостижимо медленными в последние несколько лет несмотря на низкий уровень безработицы и более высокую прибыль ведущих компаний США.

За Amazon в рейтинге R&D в порядке убывания следуют Alphabet, Intel, Microsoft и Apple.

Стоит отметить, что Facebook поднялась с 13-го места в 2016 г. на девятое в 2017 благодаря увеличению R&D-расходов на 32% до 7,8 млрд долл. Частично за рост трат вероятно ответственна Building 8, секретная лаборатория аппаратных исследований Facebook.

6 апреля 2018 г., 13:13

Четвёртого апреля Amazon провела в Сан-Франциско очередное в серии мероприятий AWS Summit, имеющих подчёркнуто некоммерческий характер, предназначенных для общения и сотрудничества разработчиков и пользователей облачных технологий.

AWS приурочила к нему ряд интересных анонсов, с которыми в своей вступительной речи ознакомил собравшихся технический директор компании, Вернер Фогельс (Werner Vogels).

О тех из них, которые связаны с искусственным интеллектом, мы уже писали отдельно. Это ставшие общедоступными службы преобразования текста в речь – AWS Transcribe, и машинного перевода – AWS Translate, а также добавившаяся AWS Sagemaker поддержка режима локальной тренировки и экземпляров контейнеров Tensorflow 1.6.0 и Apache MXNet 1.1.0.

Учётные данные, такие как пароли к внешним службам, которые часто приходится вводить вручную, являются слабым местом даже в лучших стратегиях обеспечения информационной безопасности. Новая консоль AWS Secrets Manager сводит вместе ряд имевшихся и новых функций защиты AWS, помогая администраторам централизованно и безопасно управлять учётными данными. AWS Secrets Manager с помощью сервиса AWS Lambda обеспечивает клиентам больше контроля за тем, кому разрешён доступ к конкретным учётным данным.

Ещё один анонсированный сервис, AWS Firewall Manager, позволяет использовать другие службы безопасности AWS с единой центральной панели, это упрощает унификацию политик безопасности для множества разрозненных облачных приложений.

Те клиенты, которым нужны частные сертификаты для защиты веб-приложений, теперь могут получать их через AWS благодаря добавлению опции Private Security Certificate в AWS Certificate Manager.

Одним из главных достоинств облачных вычислений является то, что на их провайдера можно переложить многие задачи технического обеспечения, такие как аппаратное масштабирование или обновление ПО. AWS пошла ещё дальше в этом направлении, уже доступный во многих регионах сервис Amazon DynamoDB Continuous Backups с Point-In-Time Recovery (PITR) освобождает пользователей от проблем резервного копирования. Выбор соответствующей опции запускает автоматический и непрерывный бэкап баз данных DynamoDB.

Помимо записи регулярных резервных копий, которые хранятся столько, сколько надо клиенту, сервис может отменить любые изменения, внесённые в данные за последние 35 дней. «Откат» с посекундной точностью можно осуществить через AWS Management Console, запросом к API или из интерфейса командной строки AWS Command Line Interface (CLI). При этом, как отметил Фогельс, объём данных не имеет значения: функция работает даже с терабайтными БД.

Для тех, кто переносит в облако большие объёмы редко используемой информации предназначена новая лоукост-опция, базирующаяся на службе облачного хранения AWS Simple Storage Service (S3).

Класс S3 One Zone Infrequent Access (Z-IA) позволяет хранить данные в одной зоне доступности облака AWS. Это менее надёжно, так как при масштабной аварии в рамках географического региона информация становится временно недоступной, а при совсем уж маловероятном стечении обстоятельств данные могут быть потеряны. Этот небольшой риск уравновешивается 20%-й скидкой: к примеру, S3 Z-IA в регионе AWS Oregon стоит 1 цент за гигабайт в месяц, тогда как за многозонный Standard Infrequent Access взимается 1,25 цента, а за S3 Standard – 2,3 цента (без учёта оптовых дисконтов).

Для S3 Z-IA AWS гарантирует готовность 99%, для S3 Infrequent Access готовность составляет 99,9% и для S3 Standard – 99,99%. В то же время гарантия сохранности данных для всех трёх предложений одинакова и составляет 99,999999999%.

Amazon также объявила о выходе S3 Select из статуса бета-версии. Это предложение позволяет разработчикам опрашивать информацию, записанную с использованием SQL, и извлекать только требующиеся данные.

29 марта 2018 г., 19:33

И снова апелляционная тройка Федерального Округа своим постановлением вызвала разлив жёлчи у всех адептов открытого кода и добавила новый виток в и без того чрезмерно запутанный узел конфликта Oracle с Google.

Этот конфликт сложно анализировать в силу его разноплановости, преследуемые обвинением цели эволюционировали со временем. Я постараюсь тут объяснить суть его «на пальцах», жертвуя строгостью формулировок в пользу краткости и наглядности.

С Sun Microsystems, настаивавшей на полной совместимости сторонних реализаций Java с её открытой платформой, Google пыталась договориться, вплоть до лицензирования. С Oracle же шёл жёсткий позиционный бой за многомиллиардный приз, хотя и прикрываемый идейными аргументами.

Купив Sun в 2010 г., Oracle через 8 месяцев выдвинула патентные претензии к Google, но на её беду дело попало к судье, проявившему интерес к техническим деталям. Он установил, что краеугольным камнем, на котором строилось обвинение Oracle, были девять строк кода. Из 15 млн строк кода Android, проанализированных специалистами Oracle, только эти девять оказались идеальной копией соответствующего кода Java.

Выступавший от обвинения Дэвид Буайе (David Boies) пытался убедить жюри, что именно копирование этого абзаца помогло Google быстрее вывести Android на рынок и получить баснословные дивиденды.

В данном случае решающим для дела стало хобби Уильяма Олсопа (William H. Alsup) – окружной судья Северной Калифорнии на досуге занимался программированием на QuickBASIC. Полученных навыков ему оказалось достаточно, чтобы понять, что якобы ключевой для коммерческого успеха Google фрагмент кода всего лишь описывает функцию (rangeCheck), которая проверяет попадает ли вводимое число в некий диапазон значений.

Oracle тогда проиграла (я всё ещё намеренно упрощаю), но сразу же направила апелляцию в Федеральный округ, который принял благоприятное для неё решение. Google, в свою очередь, попыталась апеллировать к вышестоящей инстанции, однако Верховный Суд направил дело на пересмотр, оно вернулось в окружной суд – к Олсопу.

Во вторник мы стали свидетелями того, как описанный цикл в точности повторился, шестеренки судейской машины в очередной раз провернулись вхолостую. Решение в пользу Google, принятое в 2016 г. на этой неделе оказалось перечёркнуто вердиктом Суда Федерального Округа.

Впрочем, что-то всё-таки изменилось. Если вначале претензии Oracle воспринимались сообществом Open Source больше как курьёз, то теперь обвинение действительно нащупало уязвимую точку. Не в защите Google. Главным оружием Oracle стала неадекватность существующих законов об авторском праве.

Программное обеспечение было добавлено в позднюю редакцию Закона об авторском праве от 1976 г. в раздел 102(a), где проходит как «литературное произведение». Между тем, ПО фундаментально отличается от литературы, музыки, фильмов, картин. Авторское право (копирайт) служит для защиты креативных работ, но не функциональных элементов чего бы то ни было – их можно патентовать. Программный код воплощает творческую идею разработчика, то есть вроде-бы подлежит копирайту, но имеет и функциональное назначение, является инструментом.

В этой серой зоне и действует Oracle. Исход процесса зависит от ответа на вопрос: является ли нарушением авторских прав Oracle использование Google 37 программных интерфейсов, функционально идентичных API Java SE? Ещё в первом процессе, Олсоп, основываясь на имеющихся прецедентах, постановил, что API не подлежат копирайту.

Переписывание этого правила может вызвать тектонические сдвиги во всей программной индустрии. «Оставшийся вопрос в этом процессе – является ли допустимым (fair use) пользование API-интерфейсами – это последняя попытка спасти общую отраслевую практику: создание независимых реализаций существующих API», – пишет Сара Джонг (Sarah Jeong) в Motherboard.

Как, в частности, отмечает Wired, победа Oracle позволит нынешнему владельцу Unix, Micro Focus, требовать возмещение убытков с каждого разработчика коммерческих ОС, основанных на наборе API POSIX.

Точка в конфликте Oracle-Google ещё не поставлена. По всей видимости, дело опять будет направлено в Верховный суд. Но нет сомнения, что возросшая с новым витком неопределенность исхода, сама по себе послужит стимулом к миграции с Java на действительно открытые языки разработки.

23 марта 2018 г., 18:14

Мы прочно вступили в эру Больших Данных. Каждый день человечество генерирует 2,5 квинтиллиона данных. Цифровые носители делают возможным хранение таких неимоверных объёмов информации, но они способны обеспечить целостность данных, в лучшем случае, на несколько десятков лет. Подавляющее же большинство датацентров, потребляющих 3% вырабатываемого в мире электричества, используют в качестве накопителей жёсткие диски ёмкостью до 2 ТБ с гарантийным сроком эксплуатации до двух лет.

Ключевым для перехода от Больших к Долгим Данным может стать информационный носитель, который был разработан учёными Университета RMIT в Мельбурне (Австралия) и Уханьского технологического института (Китай). В статье для журнала Nature Communications они описали гибридный наноплазмонный диск, который вполне способен пережить не только компьютер, в котором он установлен, но и своего владельца и его дом.

В отличие от пластика современных лазерных дисков, стекло может сохранять свою форму и целостность до 1000 лет, но информационная ёмкость его невелика. Поэтому китайские и австралийские инженеры скомбинировали стекло с органическим материалом и использовали золь-гелевый процесс, позволивший добиться высоких уровней прозрачности и однородности синтезируемого стеклокерамического композита.

Интегрированные сверхпрочную органически модифицированную керамику плазмонные элементы — наностержни — состоят из золота, выбранного из-за его высокой стойкости. Золотые наночастицы позволяют записывать информацию в пяти измерениях (три пространственных, цвет и поляризация).

Эта технология разрабатывалась в течение пяти лет, в основе её лежит более раннее открытие участников проекта, которые смогли преодолеть оптический предел плотности хранения данных на дисках blu-ray и обеспечить запись во всем диапазоне видимого спектра.

Новые диски могут вмещать до 10 ТБ, а прогнозируемый срок службы для них достигает 600 лет. Переоснащение ими датацентров может улучшить энергоэффективность последних в 1000 раз за счёт отказа от замены всех жёстких дисков каждые два года и снижения потребности в охлаждении. Помимо того, оптические диски по своей природе лучше защищены от взлома, чем HDD.

Перспективы коммерческого внедрения, по мнению авторов, весьма высоки благодаря совместимости их разработки с технологиями массового производства. Однако насколько сам рынок готов к появлению практически вечного и никогда не ломающегося продукта? В конце концов, где была бы сегодня Apple, если бы мы все ещё носили трубки Nokia первого поколения и собирались оставить их внукам?

20 марта 2018 г., 18:05

Виртуальную валюту биткойн, создававшуюся как универсальное средство цифровых платежей, сейчас предпочитают использовать как инструмент инвестиций. Из-за роста стоимости транзакций (в пике до $50) и крайне медленного подтверждения сделок (его можно ждать неделями).

Возродить первоначальный смысл биткойн обещает стартап Lightning Labs, выпустивший вчера рабочую версию ПО Lightning Network Daemon (бета lnd 0.4 впервые способна работать с основной сетью биткойн).

«Мы называем этот релиз lnd бетой, так как он, по нашему мнению, достаточно безопасен и отказоустойчив, чтобы ранние пользователи могли начать экспериментировать с небольшими количествами реальных биткойн и лайткойн», — отметил в интервью Bitcoin Magazine технический директор Lightning Labs Олаолува Осунтокун (Olaoluwa Osuntokun).

Эта технология, действующая как программный слой децентрализованного учёта операций над сетью биткойн, более года тестировалась тысячами разработчиков. Она совместима с сетями, разработанными другими группами, например Blockstream и Acinq, и может быть использована для осуществления моментальных транзакций с биткойн, себестоимость которых будет исчисляться долями цента.

Lightning Network делает возможным открытие платёжных каналов между пользователями биткойн. Для минимизации задержки и сопряжённых расходов, сделки заключаются без регистрации в блокчейн: информация об итоговом изменении баланса на счетах записывается в распределённых регистрах уже после закрытия канала, и только тогда платится взнос. Новая технология не накладывает никаких ограничений на количество совершаемых транзакций и на длительность работы каналов, то есть, в принципе, каналы могут оставаться открытыми месяцы и годы.

Основатель и гендиректор Lightning Labs, Элизабет Старк (Elizabeth Stark), считает, что это решение облегчит жизнь в первую очередь торговцам с большими объёмами онлайновых продаж, при этом практически нулевые процессинговые отчисления создают предпосылки для широкого распространения микроплатежей. Криптовалютные биржи с помощью Lightning Network смогут ускорить создание депозитов и вывод средств.

По информации Старк, новая сеть её нынешнем виде способна обрабатывать по несколько тысяч транзакций в секунду (TPS). Это все ещё далеко от максимальной пропускной способности компании Visa — 56 тыс. TPS, но представляет огромный шаг вперед, если сравнивать с пятью транзакциями в секунду сети биткойн.

С января 2017 г. было открыто более 4 тыс платёжных каналов Lightning Network. Некоторые торговцы, не дожидаясь окончания тестирования начали использовать эту технологию в своём бизнесе. Один из них это онлайновый магазин Block & Jerry, продающий мороженое марки Block & Jerry’s.

Инвестиционный аналитик Дэн Чиотоли (Dan Ciotoli) из Bespoke Investment Group в январском прогнозе на этот год назвал интеграцию Lightning одним из необходимых условий для выхода биткойн на уровень 20-30 тыс. долл.

Комментируя общий энтузиазм, с которым бизнес и пользователи встретили выход Lightning Network, Старк заявила: «Есть такое чувство, что мы находимся накануне массового внедрения криптовалюты».

Lightning Labs также анонсировала получение 2,5 млн долл. от ряда инвесторов, в том числе таких известных, как CEO Twitter и Square Джек Дорси (Jack Dorsey), глава Square Capital Жаклин Резес (Jacqueline Reses), бывший операционный директор PayPal Дэвид Сакс (David Sacks), создатель лайткойн Чарли Ли (Charlie Lee), а также Билл Ли (Bill Lee), «ангел-инвестор» Tesla и SpaceX.

12 марта 2018 г., 15:12

Во вчерашнем блоге, Google анонсировала формальное начало проекта, цель которого — убедить группу W3C внедрить в качестве веб-стандарта технологии, аналогичные используемым в Accelerated Mobile Pages (AMP).

AMP это разработанный Google фреймворк с открытыми исходниками, предоставляющий возможность создания мгновенно загружающихся и совместимых со многими платформами и браузерами веб-страниц. Он позволяет использовать имеющиеся навыки и инструментарий разработчиков и имеет три составляющие: AMP HTML, AMP JS и Google AMP Cache. Экосистема AMP включает 25 млн доменов и более 100 провайдеров технологий в областях веб-публикации, рекламы, электронной коммерции, малого и локального бизнеса.

Фреймворк AMP представляет альтернативу закрытым решениям Facebook Instant Articles и Apple News. Общая идея — при нажатии на ссылку не нужно ждать пока страница загрузится: это уже проделано в фоновом режиме. Теперь, Google намерена сделать мгновенным весь Веб.

«В общем, мы берём то, чему научились с AMP, и работаем над веб-стандартами мгновенной загрузки любого (не AMP) веб-содержимого, — подытожил в блоге Мальт Убл (Malte Ubl), отвечающий за технологическую часть AMP Project со стороны Google. — Это будет лишь одна из возможностей выбора, но та, которую мы рекомендуем. Мы продолжим активно инвестировать и в AMP».

Google предстоит развеять сомнения разработчиков и издателей, обеспокоенных попаданием в зависимость от технологических гигантов. Примером такой озабоченности является открытое письмо, опубликованное два месяца назад. В нём представители общественности подвергли критике ряд особенностей реализации формата AMP: страницы, размещённые у Google получали повышенный рейтинг в результатах поиска, и нажимая на рекомендуемые ссылки пользователи оставались в экосистеме Google. «Веб это не только Google и должен оставаться таким» — постулировалось там.

Дэвида Бесбриса (David Besbris), вице-президента поисковых технологий в Google, вся эта ситуация немного огорчает. «Мы придумали AMP вовсе не для того, чтобы контролировать всё», — подчеркнул он в интервью для Verge, добавив, что Google рассматривает это как вполне альтруистический проект.

Google не предлагает переключить на AMP весь Интернет, но лишь позаимствовать у AMP основные удачные решения и превратить их в универсальный стандарт, не имеющий ничего общего с Google. Таким способом почти все веб-страницы смогут загружаться не менее быстро, чем поддерживающие AMP.

Но предлагать имеет смысл только те решения, польза которых уже поверена и очевидна всем. «Если бы мы начали всё с запуска процессов стандартизации, то и сейчас не продвинулись бы дальше разговоров», — считает Бесбис. Поэтому, более двух лет назад, Google решила вместо того, чтобы пытаться убедить разработчиков веб-стандартов и браузеров, просто начать воплощать в жизнь AMP, как свой проект, реализуемый на собственных продуктах Google, в первую очередь, на её поисковом сервисе.

Accelerated Mobile Pages способны работать без участия серверов Google и без её рекламы, публиковать и распространять их можно также полностью независимо от Google. Но, тем не менее, AMP прочно ассоциируются не с Интернетом, а именно с Google, несмотря на то, что их уже используют Bing, Twitter, Baidu и другие.

Новые стандарты сделают мобильный Веб лучшим местом, чем сейчас, но, что более важно, конкурирующие компании будут воспринимать их как фундаментальные веб-технологии, а не как проект Google.

В то же время, Google готова и собирается оказывать процессу стандартизации то же содействие, которому обязаны быстрым ростом технологии AMP. Она, в частности обещает, что любая стандартная веб-страница, соответствующая по быстродействию странице AMP, получит равные с той преференции у поискового движка Google.

Новый формат ещё не имеет названия — по понятным причинам, Google не хочет давать ему имя сама. Не утверждён и перечень охватываемых им новых и существующих технологий: предложения включают Feature Policy, Web Packaging, iFrames, Performance Timeline и Paint Timing. На вопрос об сроках финализации стандарта, Убл не смог предоставить никаких ориентиров, кроме того, что это будет нескоро.

|

|

|