|

СПЕЦІАЛЬНІ

ПАРТНЕРИ

ПРОЕКТУ

Определение наиболее профессиональных ИТ-управленцев, лидеров и экспертов в своих отраслях

Кто внес наибольший вклад в развитие украинского ИТ-рынка.

Награды «Продукт года» еженедельника «Компьютерное обозрение» за наиболее выдающиеся ИТ-товары

|

|

16 июля 2019 г., 10:55

В возрасте 93 лет скончался Фернандо Корбато (Fernando Corbató), почётный профессор на пенсии Массачусетского технологического института (MIT). Печальное событие это дало повод напомнить об одном из многих, кто внёс свой важный вклад в создание суммы технологий сегодняшней информатики, – тех, кто всё больше из наших современников переходит в разряд великих учёных и инженеров прошлого.

Доктор Корбато, известный среди сослуживцев как Корби, пришёл в MIT аспирантом осенью 1950 г., а в 60-х годах возглавил там проект «совместимой системы разделения времени» (Compatible Time-Sharing System, C.T.S.S.). Она впервые позволила нескольким пользователям получать одновременный доступ к общему компьютеру по телефонным линиям.

В то время обычной была практика, когда задания подавались для исполнения в компьютер большими пакетами, и пользователям нужно было приходить за результатами на следующий день. В телевизионном интервью 1963 года, через год после первой демонстрации C.T.S.S., доктор Корбато сказал, что такая пакетная обработка приводит его в ярость своей неэффективностью.

Концепция разделения времени позволяла компьютеру переключаться между задачами незаметно для пользователей, создавая ощущение, будто каждый из них работает с машиной единолично. Она же помогла свести к минимуму простои с потерями тогда весьма дорогостоящего компьютерного времени.

Изобретение системы разделения времени приблизило людей к пониманию, что с компьютером можно работать интерактивно – печатая на модифицированной электронной пишущей машинке и мгновенно получая ответы. Эта идея определила развитие информатики на десятилетия вперёд.

Из C.T.S.S. вырос совместный с Bell Laboratories и General Electric проект Multics, которым также руководил Корбато. Multics потерпел коммерческую неудачу, однако послужил вдохновением для инженеров Bell Labs, создавших операционную систему Unix.

С созданием систем разделения времени возникла необходимость в разграничении доступа к информации, что естественным образом привело Корбато к изобретению компьютерного пароля. Пароли в C.T.S.S., открывающие доступ к приватным наборам файлов пользователей, по праву считаются одним из первых известных механизмов компьютерной безопасности.

За заслуги в развитии компьютерных технологий доктор Корбато был в 1990 г. удостоен «компьютерного Нобеля» – Премии Тьюринга.

11 июля 2019 г., 11:41

Искусственный интеллект уже доказал, что способен играть в шахматы на уровне гроссмейстеров, но под силу ли ему делать научные открытия? На этот вопрос ответили исследователи из Национальной лаборатории им. Лоуренса Беркли (Berkeley Lab): они показали, что алгоритм машинного обучения, практически без тренировки, может извлекать новые знания из просканированных текстовых аннотаций миллионов научных статей.

Коллектив, который возглавлял Анубхав Джайн (Anubhav Jain), ученый из подразделения Berkeley Lab по хранению энергии и распределённым ресурсам, собрал 3,3 млн. тезисов материаловедческих научных публикаций из 1000 журналов, вышедших с 1922 по 2018 гг., и «скормил» их алгоритму под названием Word2vec.

Анализируя взаимосвязи между словами, алгоритм смог предсказать открытие новых термоэлектрических материалов на годы вперед и предложить в качестве перспективных термоэлектриков еще неизвестные материалы. Об этом сообщает статья, вышедшая 3 июля в журнале Nature.

«Не обладая какими-либо предварительными сведениями о материаловедении, он (алгоритм) усвоил такие понятия, как периодическая таблица и кристаллическая структура металлов, — рассказал Джайн. — Это говорит о потенциале метода. Но, наверное, самое интересное, выяснилось, что этот алгоритм можно применять для устранения пробелов в исследованиях материалов, вещей, которые давно следовало изучить».

Главной мотивацией проекта стала растущая сложность ориентирования в массе опубликованных исследований. В каждой области науки накопилось публикаций за сотни лет, и каждую неделю выходят десятки новых статей. Учёный может ознакомиться лишь с малой долей этих залежей знаний, поэтому напрашивалась попытка переложить задачу их освоения на системы машинного обучения, действующие без вмешательства человека (обучение без наставника).

Каждое из приблизительно 500 тысяч отдельных слов, встречавшихся в анализируемых аннотациях, Word2vec превращал в 200-мерный вектор — массив из 200 чисел. Это позволило исследовать взаимоотношения между словами и усваивать понятия материаловедения, используя стандартные операции векторной арифметики. Действуя по такой схеме Word2vec смог изучить даже связи между элементами периодической таблицы Менделеева, спроецировав вектор каждого химического элемента на два измерения.

Но главное открытие ждало исследователей когда они ознакомились со списком химических соединений, который был составлен алгоритмом Word2vec по принципу наилучшего соответствия слову «термоэлектрик». Этот термин определял материал, способный наиболее эффективно преобразовывать тепло в электричество, а также дешёвый в производстве и состоящий из распространённых и безопасных компонентов.

Для предложенных кандидатов в темоэлектрики учёные провели компьютерные симуляции в результате которых выяснилось, что первая десятка материалов имеет КПД преобразования энергии немного выше среднего значения по известным термоэлектрикам. Зато тройка лидеров прогноза по эффективности вошла в 5 процентов лучших термоэлектрических материалов.

Авторы также провели эксперимент по ретроспективному прогнозированию — пытались открыть уже открытые термоэлектрики на основании аннотаций, ограниченных сверху, например 2000-м годом публикации. Было установлено, что количество удачных «попаданий» оказалось в четыре раза больше, чем если бы алгоритм выбирал материалы случайным образом.

«Я был очень удивлен, увидев не только предсказания, но и их обоснование, такие понятия, как полуметаллические сплавы Гейслера, кристаллическая структура которых в наши дни является действительно «горячим» трендом для термоэлектриков», — пишет Джайн.

Помимо статьи, учёные опубликовали перечень 50 лучших термоэлектрических материалов, предсказанных их алгоритмом. Они также планируют предоставить инструкции, необходимые для создания других приложений, например, для поиска новых топологических изоляторов, и работают над созданием более мощного движка поиска в текстовых аннотациях.

25 июня 2019 г., 19:32

В начале 2019 г., софтверная фирма JetBrains провела опрос программистов, итоги которого, включающие анализ ответов примерно 7000 респондентов, были опубликованы ею в отчёте State of Developer Ecosystem.

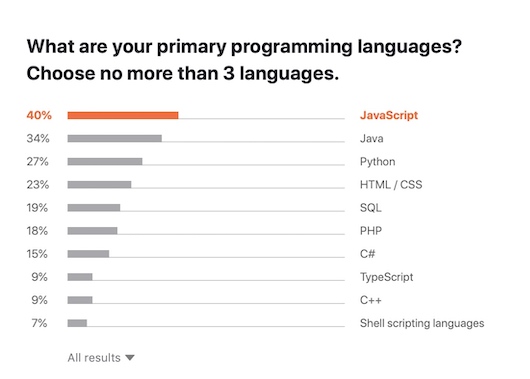

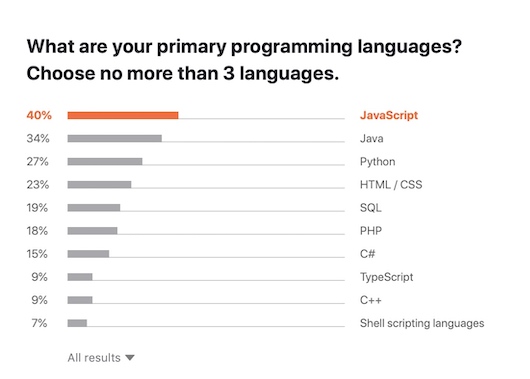

Здесь приведу несколько ключевых выводов из данного, довольно обширного исследования. Согласно им, среди языков программирования Java все ещё является самым популярным основным языком, JavaScript – самым частоиспользуемым, Go – наиболее перспективным, а Python, как вполне можно догадаться, – самым изучаемым.

В течение последних 12 месяцев с JavaScript имели дело 69% разработчиков. Далее, в порядке убывания, следуют HTML/CSS (61%), SQL (56%), Java (50%), Python (49%) и языки сценариев Shell (40%).

«Самые излюбленные языки программирования это Java и Python. Второе место делят между собой C# и JavaScript. Но если результаты нормализовать по размеру выборки, то на первое место выйдет C#», – не очень понятно поясняет JetBrains.

Среди самых популярных основных языков программирования места в первой пятёрке распределились следующим образом: JavaScript (40%), Java (34%), Python (27%), HTML/CSS (23%) и SQL (19%).

В качестве вспомогательных языков лидируют HTML, SQL и Shell-скрипты. Многие разработчики ПО время от времени используют их, но лишь единицы – в качестве основного рабочего инструмента. Например, 56% респондентов имеют опыт работы с SQL, но только 19% назвали его своим главным, и лишь 1,5% – первым языком.

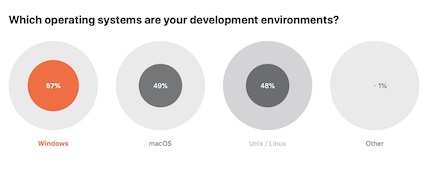

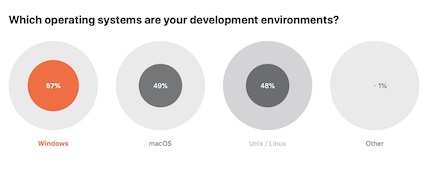

Самой популярной операционной средой оказалась Windows, её используют 57% разлаботчиков. На втором месте находится macOS (49%) и на третьем – Unix/Linux (48%).

Несколько неожиданным стало преобладание Google Cloud Platform над Microsoft Azure. Лидерство AWS на вызывало сомнений, этой облачной платформе отдают предпочтение 67% кодировщиков, однако доля любителей GCP составила 28% по сравнению со всего 21% для облака Microsoft.

Такой относительной популярностью GCP, возможно, обязана средству контейнерной оркестровки Kubernetes; 41% разработчиков Kubernetes используют облако Google.

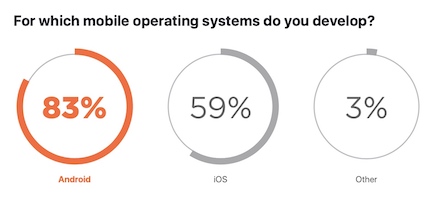

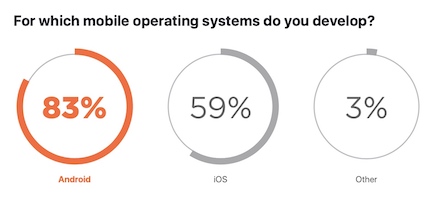

По типам приложений чаще всего разрабатывают back-end (60%) и front-end (46%) решения для web-сервисов, мобильное ПО (23%), библиотеки и фреймворки (14%), программы для десктопов (12%).

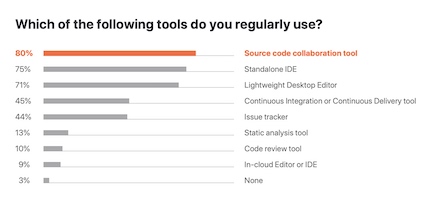

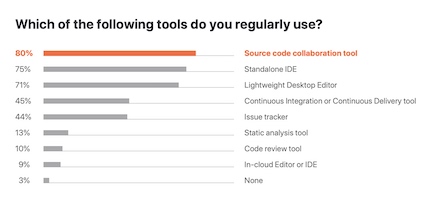

Приблизительно 80% разработчиков используют средства групповой работы над исходным кодом; 75% предпочитают отдельные среды IDE; 71% – легковесные редакторы на десктопах; 45% применяют инструмент непрерывной интеграции или непрерывной доставки, вроде GitLabCI; а 44% используют систему отслеживания ошибок.

Основными источниками данных для последнего отчёта JetBrains стали опросы, проведённые среди программистов Аргентины, Бразилии, Канады, Китая, Франции, Германии, Индии, Японии, Мексики, Польши, России, Южной Кореи, Испании, Турции, Украины, Великобритании и США – стран, на которые приходится примерно 70% глобальной экосистемы разработки ПО.

11 июня 2019 г., 17:46

Компания Google предоставила клиентам полный технический анализ «катастрофической» как она её охарактеризовала, аварии, нарушившей 2 июня работу ключевых веб-сервисов на четыре с половиной часа. Пострадали службы на только самой Google, но и пользователей Google Cloud, включая Snapchat, Vimeo, Shopify, Discord и Pokemon GO.

Вице-президент Google по инженерным вопросам, Бенджамин Трейнор Слосс (Benjamin Treynor Sloss), на прошлой неделе принёс извинения, признав, что нормализация ситуации после происшествия заняла гораздо больше времени, чем предполагала компания. Он заявил, что ошибка конфигурации привела к падению трафика YouTube на 10% и Google Cloud Storage — на 30%. Также инцидент затронул один процент из более миллиарда пользователей Gmail.

«Клиенты, возможно, столкнулись с увеличенной задержкой, периодическими ошибками и потерей подключения к экземплярам (инстансам) в регионах us-central1, us-east1, us-east4, us-west2, northamerica-northeast1 и southamerica-east1. Экземпляры Google Cloud в us-west1 и во всех европейских и азиатских регионах не испытывали перегрузки в региональных сетях», – говорится в техническом отчете Google. Самыми худшими оказались последствия для Google Cloud Storage в регионе us-west2, там доля ошибок для корзин достигала 96,2%, и southamerica-east1 – 79,3%. Потери пакетов в Google Cloud Interconnect составляли от 10 до 100 процентов.

Среди попавших под удар служб Google Cloud Platform названы Google Compute Engine, App Engine, Cloud Endpoints, Cloud Interconnect, Cloud VPN, Cloud Console, Stackdriver Metrics, Cloud Pub/Sub, Bigquery, G Suite, региональные инстансы Cloud Spanner и региональные корзины Cloud Storage.

Сильно упрощенное объяснение того, что произошло, звучит так: изменения конфигурации, предназначенные для небольшой группы серверов в одном регионе были ошибочно применены к большему количеству серверов в нескольких соседствующих регионах. Из-за этого данные регионы работали на половине доступных им ресурсов.

Во следующем приближении Google трактует ситуацию таким образом: «Две обычно безобидные ошибки конфигурации и особый программный баг, наложившись, вызвали сбой».

Во-первых, задания плоскости управления сетью и поддерживающая их инфраструктура в затронутых регионах были сконфигурированы так, чтобы останавливаться на время технического обслуживания. Во-вторых, инстансы кластерного ПО, поддерживающего функционирование плоскости управления сетью, были помечены как подходящие для включения в конкретный, относительно редкий тип события обслуживания. В-третьих, в программе, инициирующей события обслуживания, оказалась ошибка, позволяющая одновременно выводить из эксплуатации несколько независимых программных кластеров, в том числе находящихся в разных физических локациях.

Вдобавок, методы поддержания готовности инфраструктуры Google отреагировали на непредвиденную ситуацию парадоксальным образом, вызвав дополнительное снижение производительности работы сети. В отчёте Слосса говорится, что инженеры Google обнаружили сбой уже через две минуты после того, как он произошёл, однако нахождению и устранению причин аварии «существенно мешал отказ инструментов, конкурирующих за использование перегруженной сети».

Свой вклад в разразившийся хаос внесли неполадки в коммуникационных средствах Google, не давая инженерам связаться с пострадавшими клиентами и оценить масштабы инцидента.

В настоящее время Google приостановила свое ПО автоматизации датацентров, отвечающее за перераспределение работ на время техобслуживания. Оно будет вновь запущено после того, как Google убедится, что проблема, вызывающая одновременные отключения в нескольких физических локациях, гарантированно устранена.

«Инструменты и процедуры реагирования на чрезвычайные ситуации Google будут пересмотрены, обновлены и протестированы, чтобы гарантировать их устойчивость к подобным сбоям в сети, включая наши средства для связи с клиентской базой. Кроме того, мы расширим режим непрерывного тестирования аварийного восстановления, включив в него этот и другие аналогичные катастрофические сбои», – подытожила свой отчёт Google. Компания не исключает, что после дальнейшего расследования обстоятельств инцидента будут определены дополнительные действия по повышению устойчивости её инфраструктуры.

17 мая 2019 г., 18:15

Системы устного машинного перевода, призванные упростить общение между людьми, говорящими на разных языках, разрабатываются уже несколько десятилетий. Обычно их создают из трёх отдельных компонентов, которые последовательно выполняют автоматическое распознавание речи с преобразованием её в текстовый вид; машинный перевод текста в текст на нужном языке; синтезирование речи на основании переведённого теста. Такие каскадные системы, доведённые до совершенства, с успехом используются во многих коммерческих технологиях устного перевода, включая Google Translate.

С 2016 года в сервисе Google Translate вместо прежних статистических систем начали применять нейронный перевод с использованием моделей глубокого обучения. Теперь же группа исследователей, включающая в себя участников проектов Google Brain, Google Translate и Google Speech, пошла дальше и разработала экспериментальную нейросеть, осуществляющую полный устный перевод фраз без промежуточного текстового этапа.

Если сравнивать с каскадными системами, новая разработка под названием Translatotron имеет ряд очевидных преимуществ. Отсутствие разделения на этапы увеличивает скорость генерирования «умозаключений» (inference), позволяет избежать накопления промежуточных ошибок распознавания и перевода, улучшает обработку слов, которые не нуждаются в переводе, например, имён собственных.

Translatotron основана на нейросети, которая получает на входе исходные спектрограммы и генерирует спектрограммы переведённого содержания на целевом языке. В нем также применяется отдельно обученный нейронный вокодер, преобразующий на выходе спектрограмму в волновой сигнал.

Опционально возможно использование дополнительной нейросети кодировщика голоса с целью сохранения при переводе звуковых характеристик говорящего.

В ходе обучения модель фразового перевода параллельно с генерированием целевых спектрограмм предсказывает транскрипцию входящей и исходящей речи, однако никакие текстовые представления не используются для построения логических выводов.

Авторы проверили качество работы Translatotron с помощью эталонного алгоритма Bilingual Evaluation Understudy (BLEU) Score. По шкале BLEU Translatotron лишь незначительно уступила традиционной каскадной системе, демонстрируя действенность концепции прямого машинного перевода речи в речь.

В испытаниях с использованием дополнительного голосового кодировщика Translatotron превзошла по точности перевода базовую каскадную систему. Перевод, озвученный голосом говорящего, воспринимается более естественно и несколько отличается от перевода с каноническим голосом, так как сеть обучалась на меньшем количестве примеров. Ознакомиться с качеством перевода можно здесь ( https://google-research.github.io/lingvo-lab/translatotron/#conversation...)

Авторы надеются, что их работа послужит отправной точкой для для дальнейших исследований машинных технологий прямого устного перевода.

13 мая 2019 г., 15:05

Провайдер онлайнового сервиса по заказу такси вышел на публичные торги с достаточно скромной ценой 45 долларов за акцию. Она давала компании начальную капитализацию всего 75,5 млрд долл., что существенно ниже, чем те 120 млрд долл., на которые банки-инвесторы рассчитывали прошлой осенью.

Причин такого непритязательного начала было много, включая неудовлетворительный опыт IPO конкурента Uber Technologies, фирмы Lyft — она вышла на биржу 28 марта.

Кроме того, время для дебюта оказалось крайне неудачным, неделя оказалась худшей для фондовых рынков за 2019 год. Индекс Dow перед началом торгов Uber упал на 300 пунктов из-за увеличения президентом Трампом пошлин на китайские товары. Перспективы новой торговой войны обрушили также индексы S&P 500 и Nasdaq, создав на рынке неопределённость. Не способствовали удачному IPO и стачки водителей Uber, недовольных размерами оплаты их труда.

Открытие акций на Нью-йоркской фондовой бирже в пятницу состоялось даже ниже заявленной цены IPO, а финишировали торги на отметке $41,57. Тем не менее, с финансовой точки зрения, назвать это IPO неудачным нельзя. Компания всё же получила 8,6 млрд долл., которые окажутся не лишними, учитывая убыточность её бизнеса.

Основные потери Uber — репутационные, они скажутся позднее и вероятно будут иметь более серьёзные последствия. Институциональные инвесторы, которые приобрели акции Uber в четверг, заплатили компании больше, чем могли бы, если бы купили акции на день позже на общих основаниях.

В такой переплате нет ничего необычного, она может служить знаком уверенности вкладчиков в перспективах компании. Первые дни или даже недели публичных продаж тоже не всегда показательны: примером может быть хотя бы неубедительное IPO Facebook, которая затем стала лидером индустрии.

Однако Uber теряет больше денег, чем любая другая компания, дебютировавшая на бирже до сих пор, и этот факт вряд-ли смогут игнорировать как инвесторы, так и инсайдеры. Многие из сотрудников, пришедших в компанию с надеждами на IPO, могут счесть свои ожидания обманутыми.

Uber часто сравнивает себя с Amazon, которая многие годы работала в убыток, прежде чем стала доходной, но инвесторы предпочитают руководствоваться не обещаниями, а цифры таковы: 1,1 млрд долл. потерь только за I квартал нынешнего года. Для Amazon путём к процветанию стали Amazon Web Services, а что станет спасательным кругом для Uber — летающие такси?

Хотя IPO Uber и уникально по масштабам, его прохладный приём не сулит ничего хорошего технологическим фирмам, готовящим собственные IPO в этом году. Начиная с января, многие, от Lyft до Pinterest, уже прошли это испытание, но ещё больше ждут своей очереди, с надеждой следя за настроениями на рынке.

25 апреля 2019 г., 12:21

На прошедшем в её штаб-квартире в Пало-Альто мероприятии Autonomy Investor Day, компания Tesla представила миру разработанный самостоятельно специализированный процессор для самоуправляемых автомобилей. Чип, анонсированный в конце 2017 года, появился точно в обещанный срок, и даже с некоторым его опережением.

Глава Tesla сообщил, что этот чип, а точнее одноплатный компьютер Full Self Driving (FSD) на его базе, уже месяц, как устанавливается на моделях S и X. Самая массовая Tesla – Model 3 – была полностью переведена на FSD с использовавшихся до этого GPU Nvidia примерно за 10 дней до Autonomy Investor Day.

Это позволило Маску сделать перед инвесторами громкое заявление, что все выпускаемые его предприятием машины в аппаратном отношении полностью готовы к переходу на автономное управление – дело остаётся только за совершенствованием программного обеспечения. По его прогнозам, уже летом 2020 г. водители Tesla получат возможность превратиться в пассажиров, а их машины с 5-м уровнем автономности смогут приносить до 30 тыс долл. чистого дохода в год, если вместо того, чтобы простаивать в гараже станут работать самостоятельно в качестве роботакси.

Краеугольный камень будущего успеха – новый процессор, выпускаемый Samsung по 14-миллиметровой КМОП-технологии FinFET. По заверениям Маска, он справляется с обработкой данных от всего комплекса автомобильных сенсоров намного быстрее самых лучших ИИ-чипов, которые можно купить за деньги. При габаритах микросхемы 37,5 х 37,5 мм она содержит 6 млн транзисторов, обеспечивающих работу двух нейронных сетей глубокого обучения с производительностью 36 трлн операций в секунду (TOPS) каждая, блоков DSP, GPU и центрального процессора (12 ядер ARM А72 2,2 ГГц).

Такое решение обходится Tesla на 20% дешевле, чем она платила раньше. Хотя потребляемся мощность несколько возросла (72 Вт вместо 57 Вт), она не превысила максимального проектного значения, 100 Вт. При этом достигаемое FSD быстродействие оказалось в 21 раз больше, чем у применявшегося в машинах Tesla прежде решения от Nvidia.

По словам Маска, было бы финансовым безумием покупать что-либо кроме нового чипа Tesla, а между тем компания уже находится на полпути к созданию второго поколения этого процессора с быстродействием, улучшенным ещё в три раза.

На плате смонтированы два чипа FSD, причём дублирование всех систем на случай отказа охватывает и вычисления: оба процессора работают независимо, а результаты расчётов сравниваются и проверяются. «Любая часть может отказать, но машина будет управляема, – заверил Маск. – Вероятность поломки этого компьютера намного ниже, как минимум, на порядок величины, вероятности того, что водитель потеряет сознание за рулём».

Nvidia не замедлила с реакцией и в своём блоге обратила внимание на «неточности», допущенные Максом при сравнении FSD и её GPU. В частности, производительность DRIVE AGX Xavier составляет 30, а не 21 TOPS, как указано в презентации Tesla.

Кроме того, утверждает Nvidia: «Бесполезно сравнивать производительность двухчипового компьютера FSD Tesla с одночиповой системой помощи при вождении от Nvidia… Система с одиночным процессором Xavier сконструирована для поддержки ассистирующих функций автопилота, а не полностью автономного управления. Последнее, как правильно говорит Tesla, требует значительно больших объёмов вычислений».

В качестве варианта для сравнения с FSD компания предлагает свой компьютер DRIVE AGX Pegasus с быстродействием 320 TOPS, а также напоминает о разрабатываемом на смену Xavier 7-нанометровом процессоре следующего поколения, Orin.

Многих не только в Nvidia озадачивает, что имеет в виду Tesla, заявляя о превосходстве в 21 раз по частоте кадров. Майк Демлер (Mike Demler) из Linley Group, в частности рассуждает: «Это не имеет смысла, даже если вы разделите на два, чтобы устранить избыточность. Неясно, какую часть чипа Xavier Tesla использует [для сравнения]».

Wired, в свою очередь, припоминает, что Маск уже один раз заявлял, что его автомобили имеют все необходимое оборудование для самостоятельного вождения – это было в октябре 2016 г.

Среди скептиков и Филип Пекневски (Filip Piekniewski), специалист по восприятию роботами окружающей среды из стартапа Accel Robotics. «Я не думаю, что кто-нибудь сегодня понимает какое оборудование для этого требуется», – заявил он. Особые сомнения экспертов вызывает радикальное решение Маска полностью отказаться от применения лазерных радаров – лидаров.

Гендиректор Ford, Джим Хакетт (Jim Hackett) в этом месяце посоветовал не питать надежд на скорое появление автономных машин.

Маска традиционно критикуют за отрыв от реальности в его обещаниях, но анонсированный им прорыв в проектировании чипов, по крайней мере, стал индикатором того, что Tesla, следуя по пути Apple и Google, решительно работает над снижением зависимости от сторонних поставщиков полупроводниковых компонентов для своей продукции.

17 апреля 2019 г., 15:42

С февраля 2002 года, когда Google выпустила своё первое устройство Search Appliance, компания медленно, но неуклонно укрепляла свои позиции в области информационных технологий уровня предприятия. Её успехи очевидны, но для компании, ставшей лидером рынка поисковых сервисов всего за 5 лет, ключевое слово тут «медленно».

Последняя ежегодная конференция для корпоративных клиентов Google, Cloud Next 2019, привлекла в Сан-Франциско более 30 тыс. профессионалов, на семь тысяч больше, чем год назад. Это впечатляющее достижение, однако, меркнет в сравнении с другими аналогичными мероприятиями. Salesforce Dreamforce собирает аудиторию в 170 тыс. человек, Oracle OpenWorld — 60 тысяч, Amazon re:Invent — 50 тысяч.

Но конкретно эта конференция знаменательна несколькими историческими анонсами, которые, наконец, продемонстрировали твёрдую приверженность Google корпоративному сектору облачного бизнеса.

На Cloud Next 2019 состоялся большой дебют Томаса Куриана (Thomas Kurian), как CEO Google Cloud. За плечами Куриана, в ноябре прошлого года сменившего на посту «облачного босса» Google Дайану Грин (Diane Greene), два десятка лет карьеры в Oracle — больше чем вся история «любительских» экспериментов Google на корпоративном рынке.

В свой вступительной речи в прошлый вторник Куриан сделал акцент на расширении партнёрских связей и на новой многооблачной стратегии. Он также заявил о намерении значительно увеличить штат отделов корпоративных продаж и поддержки крупного бизнеса.

Список стратегических партнёров Google пополнился семью фирмами из сообщества Open Source, включая MongDB и Confluent. Это позволит лучше интегрировать их открытые технологии в решения Google. Клиенты получат централизованную поддержку через консоль Google, а доходы будут распределяться между самой компанией и всеми её партнёрами.

Облачное подразделение Google важно для будущего компании, которая пытается диверсифицировать свои источники доходов за пределы цифровой рекламы в условиях высокой конкуренции. Главным козырем Куриана в этой борьбе с более сильными конкурентами станет то, что он называет «первым истинно многооблачным подходом», получившим воплощение в платформе Anthos.

Это облачное средство построения приложений CEO Google Сундар Пичай (Sundar Pichai) сравнил с Android в том смысле, что код, написанный один раз, можно будет безопасно запускать где угодно. В данном случае, контейнерные приложения Anthos смогут работать в локальных датацентрах и с ведущими публичными облачными сервисами, включая Amazon Web Services и Microsoft Azure, а не только с Google Cloud Platform.

Такое предложение, адресованное 88 процентам всех предприятий, планирующим переход на многооблачную модель, пока что является уникальным на корпоративном облачном рынке, где Google до сих пор довольствовалось малозначительным третьим местом (6,4%) за спиной лидеров — Amazon и Microsoft с долями 31,5% и 13,5%, соответственно (данные Canalys).

От существующих гибридных решений оно выгодно отличается тем, что не требует от клиента привязки к одному облачному провайдеру и позволяет ему свободно перемещать свои рабочие нагрузки из одного облака в другое и на свои собственные серверы. Кроме того, Google обещает, что с Anthos компаниям можно будет начинать многооблачную работу буквально сходу, без неизбежного до сих пор отвлечения на это ресурсов собственных программистов.

Аналитик из Gartner Дэвид Смит (David Smith), специализирующийся на облачных стратегиях, назвал многооблачный ход Куриана «дерзким». Google не только не претендует на то, чтобы стать для своих клиентов единственным облачным провайдером, но и хочет отнять это право у конкурентов.

«Мы верим в подход, основанный на сотрудничестве, а не на противоборстве», — заявил журналистам глава Google по вопросам инфраструктуры Манвиндер Сингх (Manvinder Singh).

Только время покажет, успеет ли Google облечь своё новое видение в понятные инвесторам цифры доходов и роста, прежде чем в многооблачную игру включатся Amazon и Microsoft, но одно ясно: компания пришла на корпоративный облачный рынок всерьёз и намерена тут остаться надолго.

10 апреля 2019 г., 10:46

Что нужно, чтобы очистить Всемирную Сеть от зла и ненависти? Всё просто — зло нужно запретить! Руководствуясь такой логикой, британские чиновники подготовили проект пакета законов, регулирующих все аспекты онлайновой деятельности — социальные сети, чат-сервисы и даже файлообменные платформы. Для крамолы предлагается расплывчатое определение: контент, признанный наносящим «онлайновый вред». Этот зонтичный термин включает в себя материалы, относящиеся к сексуальному насилию, жестокости, разжиганию ненависти и терроризму, самоповреждению и сексуально-ориентированному общению несовершеннолетних.

Новые предложения, названные первыми в мире «законами онлайновой безопасности», изложены в официальном документе Министерства по цифровым технологиям, культуре, СМИ и спорту Великобритании. Они призывают к созданию независимого регулятора для мониторинга вредоносного контента в онлайновых платформах.

Эта организация будет наделена полномочиями налагать штрафы и даже привлекать к ответственности руководителей компаний за несоблюдение новых законов. Министр культуры Великобритании, Марго Джеймс (Margot James), в февральском интервью заявила, что размер штрафа для крупнейших компаний может достигать миллиардов долларов.

Кроме того, согласно этим предложениям:

-

Технологические фирмы будут обязаны предпринимать шаги по обеспечению безопасности пользователей и устранению незаконного или вредоносного контента.

-

Владельцы соцсетей должны будут публиковать отчёты о контенте в их сервисах, который считается вредным, и о меры, предпринимаемых для борьбы с ним.

-

От компаний будут требовать оперативно реагировать на жалобы пользователей (возможно, это будет аналог неоднозначно принятого в Германии закона NetzDG).

-

Обязательным к исполнению для технологических фирм станет свод правил по минимизации распространения дезинформации во время выборов.

-

Будет предложен инструментарий для создания мобильных приложений с изначально интегрированными в них функциями безопасности.

-

Для того, чтобы помочь людям своевременно распознавать дезинформацию и вредоносное поведение, предполагается воплотить в жизнь стратегию медийной грамотности.

«Интернет может великолепно соединенять людей по всему миру — но слишком долго компании не уделяли достаточного внимания защите пользователей и особенно детей и молодёжи от вредоносного контента, — заявила премьер-министр Великобритании Тереза Мэй.— Онлайновые компании должны научиться нести ответственность за свои платформы и помогать восстановить общественное доверие к этой технологии».

Говоря об «онлайновых компаниях» министр, в частности, имеет в виду Facebook, YouTube, Snapchat и более нишевого игрока, 8chan. Онлайновые гиганты стали объектом суровой критики в прошлом месяце, когда организаторы терактов в г. Крайстчёрч (Новая Зеландия) использовали публичные платформы для трансляции расстрела посетителей двух мечетей.

В феврале, Instagram запретил «экстремальные изображения самоувечения», поводом для этого послужило самоубийство (как полагают произошедшее, частично под влиянием депрессивного контента) британской школьницы Молли Рассел (Molly Russell) в ноябре 2017 г., которое усугубило репутационный кризис как самого бренда, так и его родительской компании Facebook.

На пути пенитенциарного облагораживания онлайновой среды сделан лишь первый шаг. Скорее всего, после дальнейших консультаций с представителями индустрии и общественности, окончательный свод правил будет выглядеть совсем по-другому.

Internet Association, объединяющая Facebook, Google, Snap, Reddit, Twitter и других, полагает, что эти требования следует ужесточить. Её исполнительный директор в Великобритании, Дэниель Дайболл (Daniel Dyball), отметил в заявлении: «Интернет-индустрия стремится сотрудничать с правительством и с гражданским обществом, в деле обеспечения онлайновой безопасности Великобритании. Но для этого нам нужны конкретные предложения, практичные для реализации как на больших, так и на маленьких платформах. Кроме того необходимо защитить свободу речи и сервисы, популярные у пользователей. Спектр рекомендаций необычайно широк, и решения о том, что можно и чего нельзя делать онлайн, должны быть приняты Парламентом».

Группа Coadec, лоббирующая интересы стартапов, уверена, что избыточно жёсткие требования станут особенно тяжёлым грузом для небольших фирм, не имеющих денег и юридических ресурсов Facebook или Google.

Пока ещё онлайновый пессимизм не запрещён законодательно, рискну предположить, что реморализация Интернета требуют чего-то большего, чем принятый «комплекс мер». Эффектом же от последнего станут разросшийся бюрократический аппарат и новые поступления в бюджет от штрафов. И умиротворившаяся «возмущённая общественность» ... до следующего крупного происшествия.

5 апреля 2019 г., 14:43

Ближний космос уже давно стал довольно оживлённым и замусоренным местом, в ближайшие же годы на низких орбитах станет не продохнуть от десятков тысяч ретрансляторов, принадлежащих конкурирующим проектам спутникового Интернета.

Размещение коммуникационного оборудования на низких орбитах от 150 до 2000 км имеет ряд бесспорных преимуществ. Для начала это обеспечивает меньшую задержку сигнала, чем в случаев традиционных спутников связи, висящих на высоких геостационарных орбитах (~ 35 тыс. км). Доставка спутников на ближнюю орбиту обходится гораздо дешевле, и от их проще избавляться после завершения срока эксплуатации, благодаря трению об остаточную атмосферу.

Кроме того, спутниковый Интернет имеет вполне определённую и немалую целевую аудиторию. Устремившиеся на этот рынок десяток известных и не очень компаний ориентируются на почти четыре миллиарда людей, которые, по оценкам ООН, недостаточно обеспечены доступом к Сети.

Вчера стало известно, что к когорте, включающей SpaceX Илона Маска (Starlink), OneWeb группы Softbank, Telesat/Alphabet, Facebook, Boeing, люксембургскую LeoSat, примкнула Amazon. Такой шаг электронного ритэйлера «за облака» вполне можно было предвидеть, учитывая космические амбиции Джеффа Безоса, и демонстрируемую Amazon готовность к выдвижению на новые перспективные рынки. Компания официально подтвердила, что Kuiper, о котором сообщил сайт Geekwire, это действительно её проект, а точнее, её дочерней фирмы Kuiper Systems.

Сведения о проекте стали достоянием общественности благодаря сделанному им первому публичному шагу: в прошлом месяце Федеральная Комиссия по связи (FCC) от лица Kuiper Systems подала три комплекта заявок в Международный союз электросвязи (ITU) — организацию, регулирующую вопросы использования коммуникационных спутников.

Заявки описывают трехэтапный план, который предусматривает размещение на низких околоземных орбитах 3236 спутников: 784 на высоте 590 км над уровнем моря, 1296 — 610 км, 1156 — 630 км. Этот орбитальный флот позволит Amazon охватить своим сервисом полосу от 56 градусов северной до 56 градусов южной широты: в ней проживает примерно 95% всего населения Земли.

Сообщается, что Amazon расширяет штат разработчиков Kuiper в своей штаб-квартире в Сиэттле. О бюджете и дорожной карте этого проекта, названного в честь пояса астероидов за орбитой Нептуна, пока ничего не известно, вероятно потому, что он находится на начальной стадии реализации.

|

|

|